在本论文中,我们提出了若干贡献,以提高超越最大似然方法的可操作性。

传统的机器学习方法通常依赖于最大似然估计(MLE),因为其实现简单且等价于最小化KL散度。然而,仅通过最大化似然进行训练的模型往往缺乏在实际应用中所期望的某些特性,如不确定性的量化、对分布外输入的鲁棒性,或遵守隐私约束。随着机器学习模型被越来越广泛地部署,这些重要特性变得比以往任何时候都更加必要。不幸的是,能够提供这些特性的方法在当今的大模型和大数据集下通常难以实现。在本论文中,我们提出了若干贡献,以提高超越最大似然方法的可操作性。首先,我们在多个领域改进了贝叶斯机器学习。这使得我们能够恢复感兴趣参数的完整后验分布,而不是最大似然方法所给出的点估计。其次,我们在顺序任务中实现了新颖的训练方案,包括强化学习和序列建模。在强化学习的案例中,这使我们能够开发不会泄露私人信息的奖励最大化策略。在序列建模的案例中,我们实现了新的散度函数,从而改进了文本生成。我们的贡献使得分布感知方法能够扩展到多个领域,取得了最新的研究成果,包括恢复因果图的后验分布、在模拟机器人任务中开发隐私保护算法,以及使用数十亿参数的语言模型生成类似人类的文本。在我的博士学习期间,机器学习领域取得了巨大的进展。然而,随着这些模型在越来越广泛和重要的应用中部署,越来越多的关注点集中在它们的局限性上。尽管许多当前的模型在某些领域可以实现超越人类的表现 [SHM+16],它们仍然存在一些人类不会表现出的缺陷。这些问题包括缺乏对分布外数据的鲁棒性 [SZS+14]、缺乏对不确定性的考虑 [GPSW17],以及私人信息的泄露 [KR19]。在本论文中,我们的目标是开发解决这些缺陷的方法,涵盖多种机器学习问题和应用领域。特别是,我们首先专注于改进贝叶斯机器学习,这是一种在参数估计中超越最大似然估计的传统方法。在后续部分中,我们在强化学习和序列建模中引入了替代的训练方法。正如下文所讨论的,这些方法也可以看作是超越最大似然的训练方法。1.1 最大似然目标

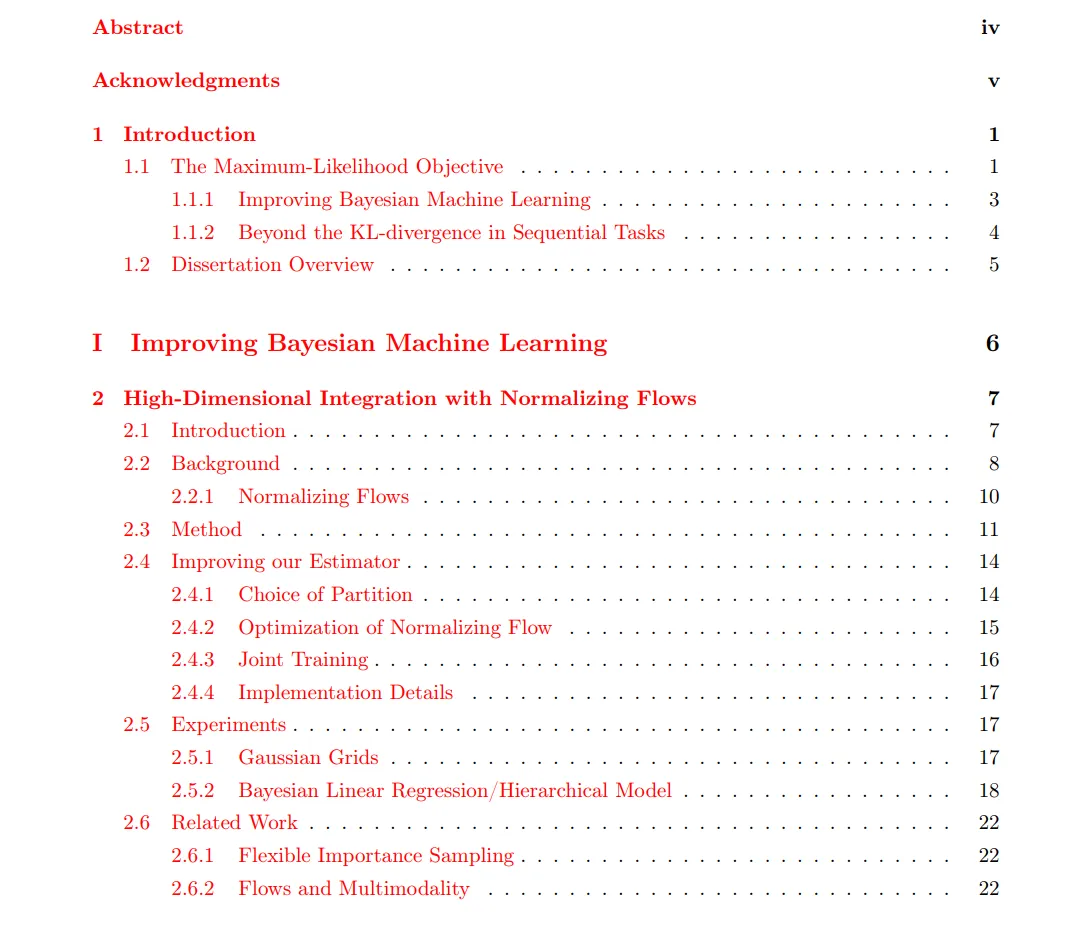

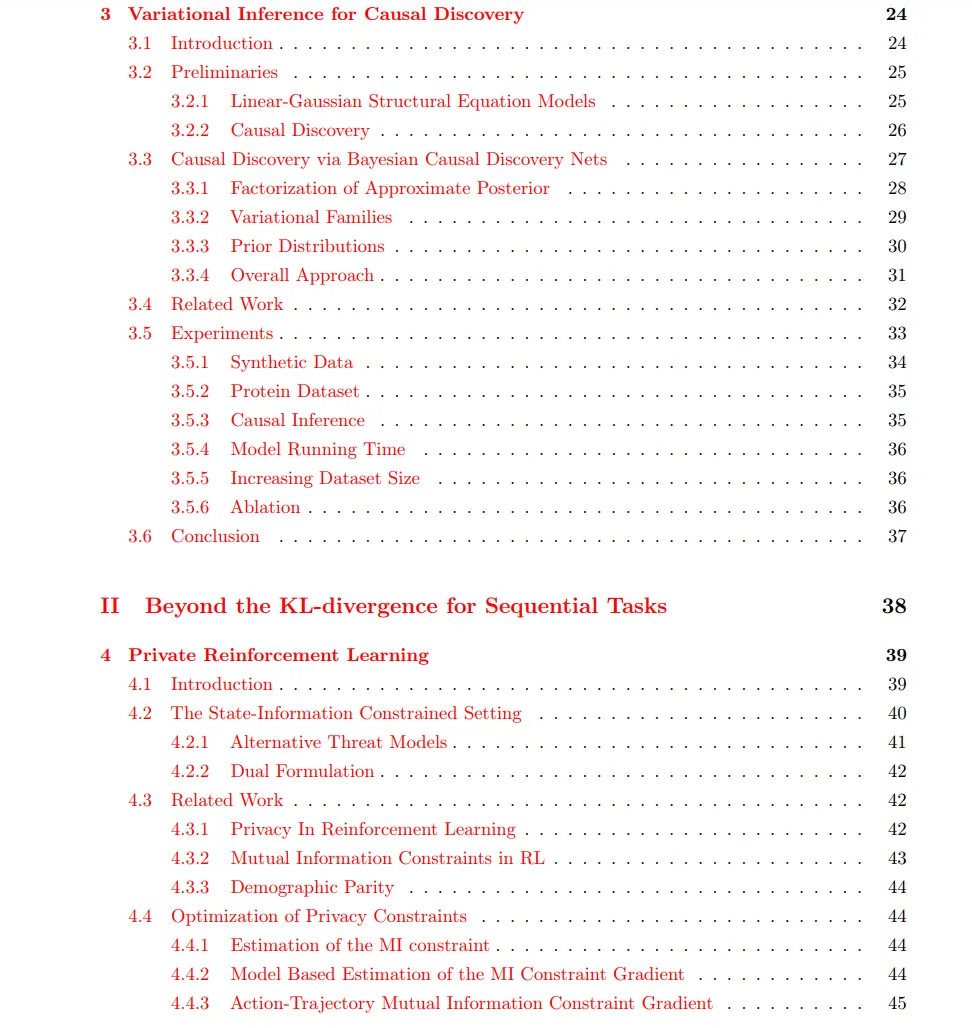

最大似然目标无疑是今天机器学习中最常用的目标函数,是分类、参数估计和生成建模中占主导地位的方法。简单来说,给定一个数据集 DDD 和一个由参数 θ\thetaθ 参数化的概率模型 PθP_\thetaPθ,为数据集中的元素分配概率,最大似然目标寻找:θ∗=argmaxθEx∼D[logPθ(x)].然而,最大似然目标并不总是机器学习从业者的显而易见的选择。在早期的分类研究中 [LeBB+98],非基于似然的目标函数常常被使用。在早期关于神经网络机器学习的教材中 [Bis95],提出了几种损失函数,包括平方和目标。实际上,在2010年代中期,生成对抗网络 [GPM+14] 开始采用非似然损失。然而,最大似然目标逐渐成为今天机器学习中的主要目标函数。其原因有很多。首先,MLE方法在概率论上非常有依据,因为它与最小化KL散度是等价的。DKL(PD∥Pθ) = Ex∼D [log PD(x) − log Pθ(x)] = −Ex∼D [log Pθ(x)] + C, 其中PD是数据集D的经验分布函数(或基础的群体分布),C是一个不依赖于θ的常数。因此,最大化似然等价于最小化数据分布与由θ参数化的分布之间的KL散度。其次,MLE方法通常非常容易优化。最大化似然只需要从数据集中采样并计算对数似然的梯度,而这通常可以通过现代自动微分工具包轻松实现 [BFH+20, PGM+19]。相比之下,最小化数据分布与参数化分布之间的其他散度(例如χ²散度)通常要求对数据分布的密度有详细了解。这种情况通常是未知的,而通过学习分类器近似这种密度的方法(如生成对抗网络)则需要与θ一起对分类器参数进行对抗性训练,导致训练不稳定。最后,最大似然通常与下游任务目标高度一致。例如,在ImageNet发布后变得流行的分类任务中 [DDS+09],最大化正确标签的概率正是训练分类模型的目标。然而,最大似然目标并不总是最合适的选择。不幸的是,采用非基于似然的目标通常是具有挑战性的。在现代机器学习中,方法的可扩展性和优化的便捷性是所有方法的重要考虑因素。我们面临的挑战是:找到超越最大似然方法的技术,同时保持数据效率、易于通过梯度下降优化,并具备计算扩展性。为了解决这个问题,我们利用了一些在本论文中提出的关键技术:变分推理用于神经函数逼近下的贝叶斯推断,连续松弛和路径梯度估计器用于减少优化中的方差,以及将问题重新参数化为更易处理的等价形式。本论文分为两部分,但有一个共同的目标:开发超越典型MLE方法的技术。在第一部分中,我们研究了贝叶斯机器学习的改进,尤其在数据较少的情况下,由于数据集的有限性,关于θ的值可能存在相当大的不确定性。首先,我们开发了一种使用正则化流计算高维积分的新方法,并将其应用于计算贝叶斯定理中的归一化函数。然后,我们将变分推理应用于因果发现问题,解决了在复杂有向无环因果图集中构建后验分布的挑战。在第二部分中,我们研究了在序列任务中超越最大似然的替代训练方法。首先,我们研究了在强化学习中执行隐私约束的问题。这需要控制策略生成的轨迹分布,以确保它们不会泄露有关私有状态变量的信息。最后,我们解决了基于序列数据的自回归模型训练问题。我们将任务重新表述为模仿学习任务,从而可以有效地最小化与数据分布的不同散度。超越MLE方法还为生成过程提供了额外的灵活性,我们通过允许回溯来增强生成过程。1.1.1 改进贝叶斯机器学习

在参数估计的设定中,我们有一个数据集D,并希望推断感兴趣的参数θ。例如,我们可能有一组(x, y)对,并希望推断可能的线性关系的斜率,在假设数据生成y = θx + ϵ(其中ϵ ∼ N(0, σ))的情况下。最大似然估计给出了使Ex∼D [Pθ(x)]最大的θ值,也可以写作P(D|θ)。实际上,我们通常想要得到的是P(θ|D),即在给定数据集的情况下θ的后验概率。根据贝叶斯定理,我们知道P(θ|D) = P(D|θ)P(θ)/P(D),其中P(θ)是θ的先验分布,P(D)是归一化常数。只要θ可以从数据中识别,并且先验分布对θ的真实值有密度,那么在足够的数据情况下,最大似然解将收敛于后验分布的众数。然而,在数据有限的情况下,得到完整的后验分布通常非常重要,而不仅仅是最大似然值。后验分布可以指示对θ估计的不确定性,这在做出最优决策时非常有用。然而,精确计算后验分布通常是不可行的,因为它需要计算归一化常数P(D) = ∫ΘP(D|θ)P(θ)dθ。当θ的维度超出适度范围时,由于维度诅咒,进行这种积分变得极其困难。在论文的第一个贡献中,我们通过随机采样域的子集并估计每个子集的积分值来解决这个问题。虽然这是无偏的,但这种方法在典型目标函数下具有极高的方差,因为它们集中在域的一个小体积内。我们通过使用正则化流解决这个问题,正则化流是一种灵活的变换家族,可以在保持体积的同时在空间之间映射。这使我们能够学习一个可逆映射,将[0, 1]d映射到积分域上,构造该映射,使得在[0, 1]d上的均匀分区通过正则化流映射后在积分域上生成具有大致相等积分量的(非均匀)分区。这大大降低了估计器的方差。通过改变分区的数量,我们可以在重要性采样估计器(在无限多的小分区的极限下)和变分下界(在单个分区的极限下)之间平滑插值。在这一部分的第二个重点中,我们将变分推理应用于从数据中推断线性高斯结构方程模型(SEM)的问题。结构方程模型是一种特定类型的因果图,配备了因果解释的有向边。在线性高斯SEM中,条件概率分布是高斯分布,均值由图中变量的父节点的线性函数给出。尽管这个设定受到了限制,但在这种设定中进行变分推理仍然具有挑战性。主要问题是网络必须是一个有向无环图(DAG),这是在邻接矩阵空间中的一个复杂约束。我们通过将DAG权重矩阵重新参数化为P LP⊤来解决这个问题,其中L是下三角矩阵,P是置换矩阵。这使我们能够应用关于置换的松弛的最新研究 [MBLS18]。我们发现我们的方法能够恢复与真实数据生成图非常相似的图,并且表现优于基线方法。1.1.2 在序列任务中超越KL散度

在论文的第二部分中,我们从序列建模和强化学习(RL)设定的角度,探索了超越最大似然的训练方法。如上所述,最大似然等价于KL散度最小化。实际上,正如 [Lev18] 中所描述的,我们可以将传统的强化学习目标视为在熵奖励的条件下最大化回报的过程,这等价于最小化由策略引发的分布与按轨迹奖励加权的分布之间的KL散度。在这一部分的第一个章节中,我们研究了在满足信息披露约束的情况下最大化回报的任务。例如,参与管理CEO日程的算法可能拥有私人信息,在安排会议时不应泄露这些信息,或者游戏策略可能包含一些应该保密的有用信息。这表现为对对手从策略行动中推断私有信息的能力的约束——为了隐藏私有信息,可能有必要采取次优行动(从减少回报的角度)。我们将其表述为对私有状态变量与策略行动之间互信息的约束,并使用对抗训练的批评者来试图发现这些私有信息。我们进一步通过引入可微分模拟器扩展了这一方法,使我们首次能够将私有强化学习扩展到高维模拟机器人任务。在这一部分的最后一章中,我们解决了自回归序列建模的传统问题。通常这被表述为最大似然问题:对于由一系列标记构建的序列x1

数据派THU作为数据科学类公众号,背靠清华大学大数据研究中心,分享前沿数据科学与大数据技术创新研究动态、持续传播数据科学知识,努力建设数据人才聚集平台、打造中国大数据最强集团军。

新浪微博:@数据派THU

微信视频号:数据派THU

今日头条:数据派THU