众 所周知,机器学习的模型与统计有着千丝万缕的联系。阅读本文后,你才恍然发现,鼎鼎大名的Lasso算法思想锤炼的背后,蕴藏着学生氏分布关于酿酒的小秘密,还可以窥视过去百余年统计的兴衰起落,统计学重镇如何从繁盛时期的英国逐步转移到了奋起直追的美国,以及圈儿里牛叉闪闪的大人物们那些看起来与常人无异、令人忍俊不禁的闲散轶事。

作者:史春奇

罗纳德,费希尔(Ronald Fisher)是英国的搞农业出生的, 这家伙视力却很差,特别喜欢生物统计, 由于不小心读了卡尔皮尔逊(Karl pearson)的论文而中毒。

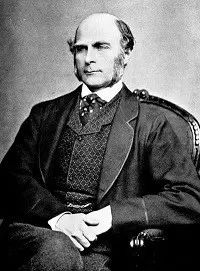

皮尔逊这个家伙的确有点魅力,他是剑桥学数学出生的, 他提出了矩估计, 发展了卡方检验,主成分分析(PCA), 创立了概率函数簇和世界上第一个大学统计学:英国伦敦大学学院(University College London)统计学。 就是他和高尔顿(Francis Galton)一起办了统计的第一份杂志《生物统计学》,之后英国的统计就领先全球了。

高尔顿要比皮尔逊大40岁, 这家伙是个全才,指纹就是他搞出来的, 他开始研究人类学的,热衷并提出了优生学(eugenics)后,不仅仅吸引了皮尔逊,也深深的吸引了费希尔。

费希尔就和凯恩斯, 也就是达尔文的儿子一起搞了剑桥的优生学会。 他是个天才,对实验很有理解,提出了统计方法的一系列优化判断标准, 例如最大似然估计, 费希尔线性判定,充分性。

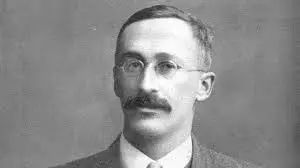

比皮尔逊小十几岁而又比费希尔大十几岁的还有一位大师是酿啤酒的搞化学的,他叫威廉戈塞(William Sealy Gosset), 他就是大名鼎鼎的学生氏, 因为他的老板不让他把酿酒的秘密发表出来, 所以他只能用笔名学生氏(Student)来发表。 他在选酒过程研究了学生分布。据说费希尔特别爱读他的论文。

费希尔有个印度的学生叫拉奥Calyampudi Radhakrishna Rao, 他和另外一个研究素数的克拉梅尔Harald Cramer提出了最优无偏估算的下界(Cramer-Rao Lower Bound CRLB), 和利用期望估算来优化估算器的RB定理(Rao-Blackwell theorem)。 其中Blackwell是布莱克韦尔(David Harold Blackwell)是伯克利的名誉教授,是美国第一位黑人院士。 也正是从拉奥开始统计的重心从英国移到了美国。其中有个叫Jerzy Neyman (1894-1981)的波兰人,在前面提到的英国伦敦大学学院当老师, 当着不爽,跑到美国,学着伦敦大学学院建立起美国第一统计系,伯克利统计学。 Neyman的导师很牛,是俄罗斯搞不等式的Sergei Natanovich Bernstein(1880-1968), 其实Bernstein的导师更牛,就是David Hilbert(1862-1943),希尔伯特。

Calyampudi Radhakrishna Rao

Jerzy Neyman (1894-1981)

Maurice H. Quenouille是美国的研究统计推理的一位学者,他写过美

国早期的《统计介绍》(Introductory Statistics) 他提出了Jackknife的核心思想(1949), 后来John W. Tukey(1915-2000)后来把Jackknife正式发表出来了(1958)。Tukey是FFT的发明者, 也是钟开莱Kai Lai Chung的导师。钟开莱写了好多概率的经典教材,好多美国概率教授自称看着他的教材长大的,为美国概率教育事业做出无与伦比的贡献, 但是他本人最讨厌统计学家了。

John W. Tukey

Tukey的工作影响了Jerome H. Friedman,这个伯克利毕业的学物理的家伙,几经周折谋取到了斯坦福的统计教授(1982-)。当时Trevor Hastie正在那里读PHD, 后来1994年Trevor 他又从南非回到斯坦福和Friedman,还有他的斯坦福同学Rob Tibshirani,一起写了The Elementary of Statistics Learning。

Jerome H. Friedman

Trevor Hastie

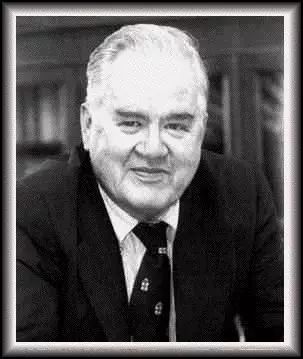

Rob Tibshirani发明了LASSO算法, 他的老板是Bradley Efron, Efron这个家伙提出了 bootstrap方法(1979, 1981(Bayesian extension)),也正是受到了Tukey工作的影响。Efron就是斯坦福自己培养的统计博士(1964), 就这样标志着斯坦福的统计学习就自己培养起来了。后来Efron受他学生Tibshirani的LASSO影响发明了LAR算法。

Rob Tibshirani

Bradley Efron

另外伯克利的Leo Breiman受到bootstrap的启发,把分类回归树

(classification and regression trees )应用到bootstrap样本上,提出了

Bootstrap聚合 (Bootstrap aggregation)(1994)。 Breiman是分类器的大牛, 提出了决策树的CART(1984), 随机森林(Random forest)(2001)。

Leo Breiman

而boosting的思想是 Robert Schapire回答(1990)Michael Kearns提出的(1988)的关于一组弱学习器能否生成强学习器的时候提出的思想。 但是一直找不到实现, 直到 AdaBoost的提出(1995),也许也受到了Bagging方法的影响。 Robert Schapire 是普林斯顿的教授。 他的合作者Yoav Freund是加州大学的教授。

Robert Schapire

本文首发于:ML2AI。