这个目标检测神器简直香炸了!

它不仅连续登录Github全球趋势榜,拥有的全球尖端算法论文也接连登录全球技术趋势榜PaperWithCode。

这个神器就是刚刚全面升级的PaddleDetection2.0!它全面兼顾高性能算法、便捷开发、高效训练及完备部署,不论是通用目标检测,还是行人、车辆检测,不论是超高精度,还是超轻量超快速;不论是学术科研大神,还是入门萌新;全都满足你!

传送门:

https://github.com/PaddlePaddle/PaddleDetection

小编在此强烈号召小伙伴们

Star收藏

一下,以防走丢。

下面,让我们直接用数据和事实来带大家看看这款开源项目具体有什么过人之处吧!

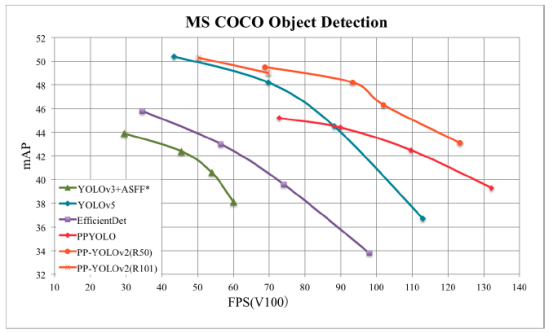

1. 比YOLOv4、YOLOv5 更强的PP-YOLOv2

无需再纠结YOLOv3、YOLOv4、Scaled YOLOv4、YOLOv5到底选哪个了,

选PPYOLOv2就对了

!

最高mAP 50.3%,最高FPS106.5FPS,超越YOLOv4甚至YOLOv5!

又快又好,他不香么?

论文:

https://arxiv.org/abs/2104.10419

2. 1.3M 超超超轻量目标检测算法PP-YOLO Tiny

需要在AIoT边缘轻量化芯片部署?

1.3M够不够小?!比YOLO-Fastest、 NanoDet更强的PPYOLO-Tiny

,AI走向产业无需再等,赶紧用起来!

3. 全面领先同类框架的RCNN系列算法

什么?还在用mmdetection和Detectron2?你Out了!

RCNN系列模型(Faster RCNN, Mask RCNN, Cascade RCNN等)在PaddleDetection进行训练

,

比mmDetection和Detectron2在更短的时间获得更高的精度!

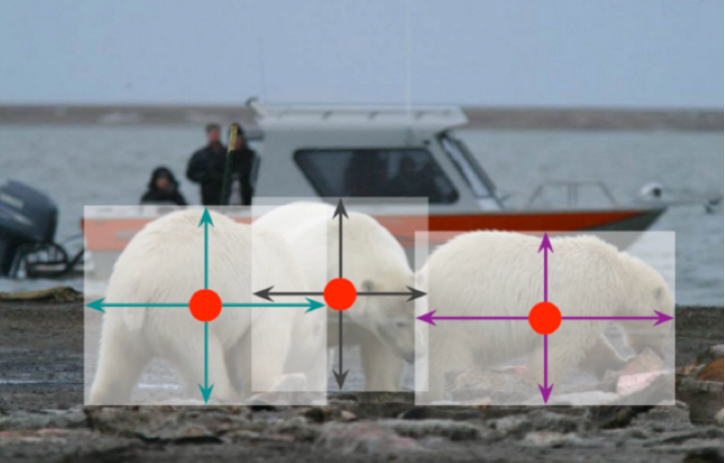

4. SOTA 的Anchor Free算法:PAFNet & PAFNet-Lite

连检测框都不要了?莫慌,PaddleDetection2.0带你紧跟全球科研动向。SOTA(最先进)的Anchor Free算法:PAFNet(Paddle Anchor Free)& PAFNet-Lite,从理论到直接使用,保证把你安排的明明白白!

论文:

https://arxiv.org/abs/2104.13534

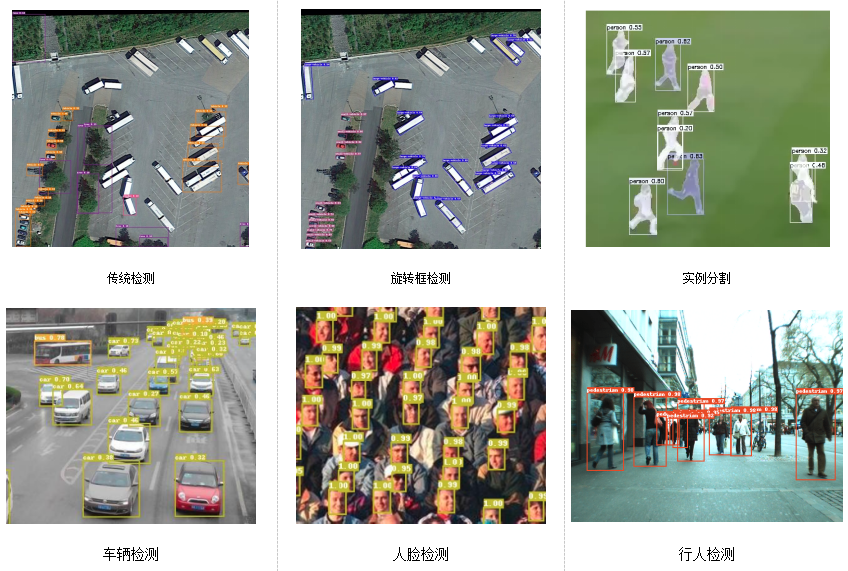

除了以上全系列通用目标检测算法外,PaddleDetection2.0还额外覆盖旋转框检测、实例分割、行人检测、人脸检测、车辆检测等垂类任务。

还经过工业质检、安防巡检、卫星遥感、能源电力等等数十个真实行业场景深度打磨验证,直接加速各产业智能化升级!

全面支持pip安装,动态图开发,压缩、部署等全流程方案打通,极大程度的提升了用户开发的易用性,加速了算法产业应用落地的速度。

1. 超强的算法压缩能力:

以YOLOv3-MobileNetv1模型为例,

量化策略为模型带来1.7%的精度提升,同时体积压缩3.71倍,速度提升1.46倍

!而采用蒸馏+裁剪的联合策略,

在精度几乎无损的情况下,体积压缩了3.05倍,加速1.58倍!

|

YOLOv3-MobileNetV1

|

输入尺寸

|

精度(mAP)

|

模型体积(MB)

|

体积压缩比

|

延迟(骁龙855 4线程)

|

加速比

|

|

Baseline

|

608

|

28.8

|

94.2

|

-

|

411ms

|

-

|

|

在线量化

|

608

|

30.5

|

25.4

|

3.71x

|

281ms

|

1.46x

|

|

蒸馏

|

608

|

31.0

|

94.2

|

-

|

411ms

|

-

|

|

蒸馏+剪裁联合策略

|

608

|

28.7

|

30.9

|

3.05x

|

260ms

|

1.58x

|

2. 超完善的推理部署能力

适配Linux、Windows、NV Jetson等多系统多平台,同时提供Python预测和C++预测,额外适配TensorRT,支持TensorRT动态尺寸输入及TensorRT INT8量化预测, 模型预测加速性能满分!

|

模型

|

输入尺寸

|

Paddle Inference

|

TensorRT FP32

|

TensorRT FP16

|

|

SSD_MobileNet_v1

|

300

|

5.17

|

4.43

|

4.29

|