专栏名称: 金融五道口

| 有用、有趣、有深度。专业团队追踪全球财经热点,精选影响您财富的资讯。优质阅读体验,投资必备神器。Read less, know more! |

目录

相关文章推荐

|

北京市商务局 · 北京市属公园元宵传统游园活动预报来了,附赏“ ... · 17 小时前 |

|

北京市商务局 · 北京市属公园元宵传统游园活动预报来了,附赏“ ... · 17 小时前 |

|

物道 · 五粮液,这次的瓜太大了! · 昨天 |

|

无时尚中文网 · 加拿大鹅三季度稳健发展 新年表现积极 ... · 3 天前 |

|

内蒙古自治区文化和旅游厅 · 过大年 闹元宵 | ... · 2 天前 |

|

内蒙古自治区文化和旅游厅 · 过大年 闹元宵 | ... · 2 天前 |

|

消费日报官方平台 · “食”“游”同欢 消费者爱上首个非遗春节 · 2 天前 |

推荐文章

|

北京市商务局 · 北京市属公园元宵传统游园活动预报来了,附赏“梅”攻略—— 17 小时前 |

|

北京市商务局 · 北京市属公园元宵传统游园活动预报来了,附赏“梅”攻略—— 17 小时前 |

|

物道 · 五粮液,这次的瓜太大了! 昨天 |

|

无时尚中文网 · 加拿大鹅三季度稳健发展 新年表现积极 创意总监首个胶囊系列受追捧 3 天前 |

|

内蒙古自治区文化和旅游厅 · 过大年 闹元宵 | 春节文博游,呼和浩特博物院带你穿越千年,感受北疆文化魅力! 2 天前 |

|

内蒙古自治区文化和旅游厅 · 过大年 闹元宵 | 春节文博游,呼和浩特博物院带你穿越千年,感受北疆文化魅力! 2 天前 |

|

消费日报官方平台 · “食”“游”同欢 消费者爱上首个非遗春节 2 天前 |

|

FM93交通之声 · 昨晚朋友圈热传:杭州灵溪隧道里黑乎乎的东西撞上了奔驰车!蹊跷的是… 8 年前 |

|

ONE一个 · 爱情不是套套,不能用完就扔掉 8 年前 |

|

墨香中华 · “我有一壶酒,足以慰风尘",然后呢(寻找最佳续写手) 7 年前 |

|

文玩汇 · 投稿 | 唐卡中的那些形象,你都了解吗? 7 年前 |

|

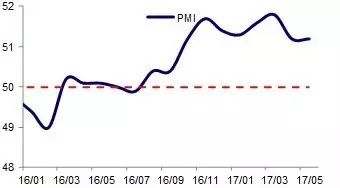

海通研究 · 【宏观】姜超:高基数效应显现,经济刺激后遗症 7 年前 |