极客公园微信号:geekpark

Antonio Torralba

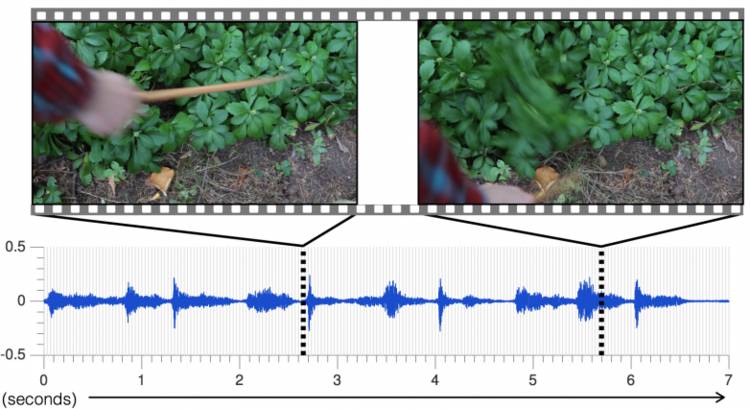

用鼓槌搅动池塘里的水、敲击坚硬的岩石或木板、戳一下柔软的海绵、扫过野生草丛……不同的物体碰击,产生不同的声音纹路,这些纹路暴露了交互双方的信息。

我们的一部分感官,是依靠声响来辨别物体、感知世界的。当老朋友远远走近,独特的呼吸和脚步声,你可能一听便知。

Antonio Torralba 教授的团队在想,是否可以让机器模拟人类这样的感官本能,提高它与周围环境的交互能力。

今年 6 月,Torralba 团队发布了一套「声音算法」。「这套声音算法可以分辨并模拟鼓槌与不同物质交互所发出的声响(用鼓槌是因为它提供了一种始终如一地生产声音的方式)。它使用周期性神经网络预测视频中的声音特征,再根据声音库中相似的例子输出声波。」他们在研究论文《Visually Indicated Sounds》里写道。

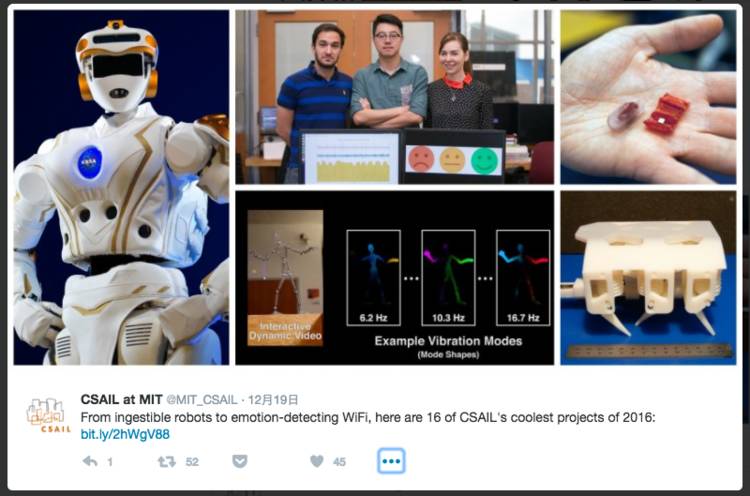

这项创新成果来自麻省理工计算机科学和人工智能实验室(MIT Computer Science and Artificial Intelligence Laboratory,简称 MIT CSAIL)。

在这个全球最大的校园实验室里,汇聚着 CS 和 AI 领域最出色的一群极客们。在 2016 年,他们发明了用猪大肠做的可食用折叠机器人、与 NASA 合作进行太空作业的 Valkyrie 机器人、固液混合的 3D 打印机、预判人类交互行为的深度学习算法、免戴眼镜的 3D 电影院……

根据受试者所言,研究成果已经达到以假乱真的效果,MIT 在新闻稿中声称它通过了「声音图灵测试」。看过电影《机械姬》的你一定知道,「当人类分辨不出某个行为来自机器还是真实的物理世界,图灵测试就算通过。」

他们使用深度学习技术,让机器在大量的数据中摸索行为模式。这让科学家们从大量的「手动设计算法」和「监督处理过程」的工作中解放出来。团队花费数月的时间,用鼓槌与不同的物体敲击、交互,并为此录制了约 46000 种声音。

研究者认为,这套声音算法有助于机器人更好地「理解」周围的环境,也可以应用于为电影电视自动合成声效。

「机器可以凭『直觉』感觉到水泥地是硬的、草地是软的,然后预测踩上去会发出什么声音。而声音是理解物理交互的第一步。」论文的第一作者 Andrew Owens 说。

当然它也有局限,比如机器只能模仿视觉上能「看见」的交互声。「风吹开窗户,操场上传来同学们嬉闹的声音」,画面中若没有「操场」,机器理解起来就很困难。

这项研究将声音和视觉研究融合起来,将声音转化为波纹图像,从而进入目前机器更为擅长的图像识别领域。今年 9 月,Antonio Torralba 团队在这两者的结合中有了突破性进展。他们的模型可以根据静态图像预测未来 1-2 秒的场景,并生成动态视频。

比如说,首先我们喂给机器大量美剧、视频,诸如《绝望主妇》、《生活大爆炸》等等,通过深度学习算法,机器将能够预测人类的行为。某个银行顾客可能将实施抢劫、下一秒这对夫妇将会接吻、六成观众将对正在观看的电影情节产生愤怒情绪……这套模型的应用,将在生产效率、消费者洞察等方面具备革命性优势。

机器通过掌握这样的能力,或许也可以取代一部分电影导演。理想状态下,未来我们坐在影院里看的电影,就可能完全是由电脑生成的,机器通过分析你的情绪反馈,还可以即时调整故事情节的走向。

也就是说,在更聪明的人工智能面前,「主动交互」好像也不是必须的了。未来,机器会变得越来越「狡黠」,它将不知疲倦地接管人类的动物本能。

2016 年是通用领域的一年。量子计算取得突破性进展、Alpha Go「人机大战」家喻户晓,但在看起来离普通大众很遥远的前沿科技实验室里,也依然活跃着这一批很酷的研究者们。2017 年 1 月 13-15 日,MIT CSAIL 的 Antonio Torralba 教授将来到极客公园创新大会的舞台,近距离与你分享「机器视觉领域的独特路径」的奥秘,不要错过这个和顶级科学家交流的好机会。

* 参考资料:

Artificial Intelligence Produces Realistic Sounds; http://news.mit.edu/2016/artificial-intelligence-produces-realistic-sounds-0613

Creating Videos Of The Future; https://www.csail.mit.edu/creating_videos_of_the_future

![]()