欢迎来到第一届“讯飞杯”中文机器阅读理解评测(The 1st Evaluation Workshop on Chinese Machine Reading Comprehension)!

“第十六届全国计算语言学学术会议”(The Sixteenth China National Conference on Computational Linguistics, CCL 2017)将于 2017 年 10 月 13 日—15 日在南京师范大学举行。作为国内最大的自然语言处理专家学者的社团组织——中国中文信息学会(CIPS)的旗舰会议,全国计算语言学会议从 1991 年开始每两年举办一次,从 2013 年开始每年举办一次,经过 20 余年的发展历程,已形成了十分广泛的学术影响,成为国内自然语言处理领域权威性最高、口碑最好、规模最大(2016 年注册参会人数超过 600 人)的学术会议。CCL 着重于中国境内各类语言的计算处理,为研讨和传播计算语言学最新的学术和技术成果提供了高水平的深入交流平台。

从今年的 CCL 会议开始,我们计划同步举办评测活动。本次我们聚焦的任务是机器阅读理解(Machine Reading Comprehension)。让机器能听会说,能理解会思考是人工智能的长远目标。机器阅读理解作为目前自然语言处理领域中的热门研究内容受到了广泛关注。与传统的问答系统不同的是阅读理解任务更注重于对于篇章的理解,而不是利用世界知识、常识来回答问题,所以更具有挑战性。因此阅读理解受到了各大研究机构的高度重视,并且纷纷投入到相关研究当中,其中包括 Google DeepMind, Facebook AI Lab, IBM Watson, 斯坦福大学(Stanford), 卡内基梅隆大学(CMU)等。

本届中文机器阅读理解评测由中国中文信息学会计算语言学专委会主办,哈工大讯飞联合实验室(HFL)承办,旨在促进中文阅读理解研究及发展并且为相关领域学者提供一个良好的沟通平台。在此,评测会务组诚邀各个单位参加本次评测活动!

评测内容

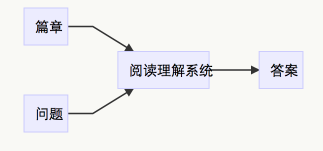

任务概述

本次阅读理解评测的任务是“填空型阅读理解”(Cloze-style Reading Comprehension),参赛者需要对给定的篇章进行分析并回答与篇章相关的填空型问题。

具体形式如下:

评测方向

本届阅读理解方向主要面向“儿童读物”领域。

与传统的新闻领域不同的是儿童读物领域的内容与新闻领域相差较大,篇章中包含较多拟人化的动植物且文本之间的风格相差较大,更具有挑战性。

同时根据问题的形式,又分为如下两个方向(Track),参赛者可以任选其一或者同时参加。

但需要注意:两个 Track 共用一个训练集(填空型问题),所以参加用户提问型问题的参赛者需要考虑填空型问题到用户提问型问题如何进行迁移学习。

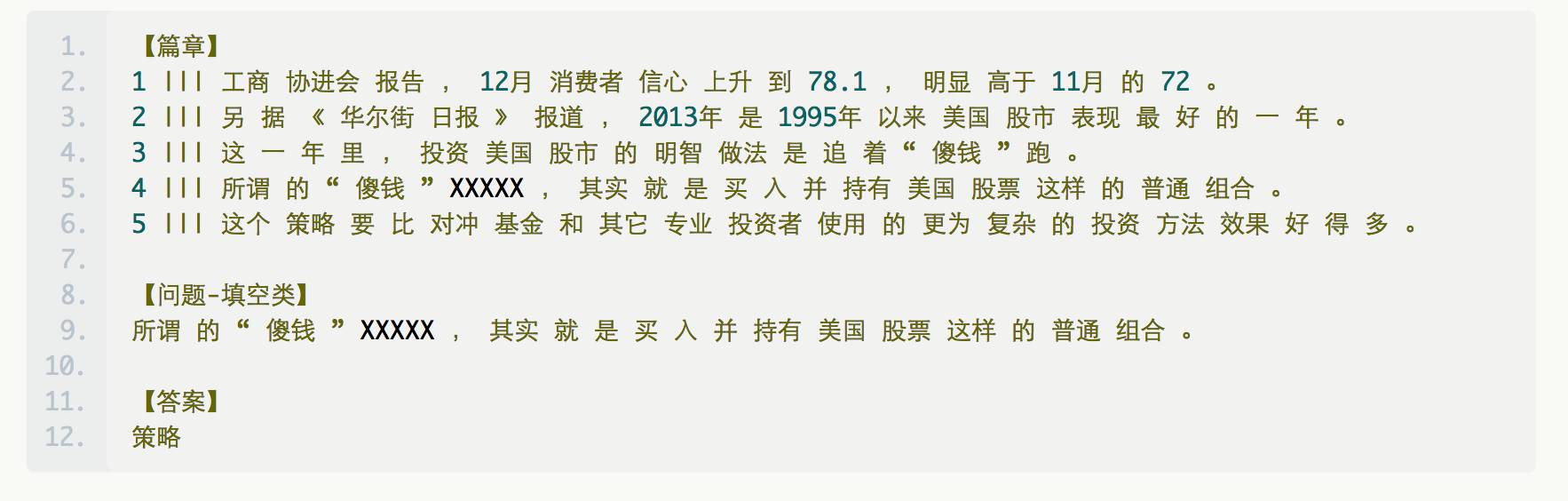

1)填空型问题

篇章:由若干个连续的句子组成的一个文本段落,但文中缺少某一个词 XXXXX

问题:缺少的词 XXXXX 所在的句子

答案:缺少的词 XXXXX

【举例】

三竖线之前的数字表示的是句子号,XXXXX 表示文中缺少的某一个词(仅做举例,并非实际的测试样例)。

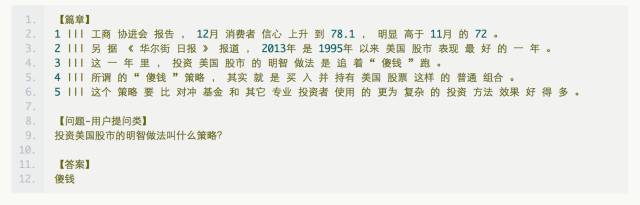

2)用户提问型问题

篇章:由若干个连续的句子组成的一个文本段落

问题:由人工提问的问题

答案:问题对应的答案

【举例】

注意:与填空型不同的地方是,用户提问型问题的篇章是完整的

奖项设置

本次评测对于上述两个 Track 分别进行比赛,分别排名,并根据每个 Track 的最终评测结果分别取前三名进行奖励。

奖项包括:

1)由CCL2017主办方中国中文信息学会(CIPS)为参评队伍提供成绩证书认证。

2)奖金奖励:

金奖:¥10,000 + 荣誉证书

银奖:¥5,000 + 荣誉证书

铜奖:¥3,000 + 荣誉证书

感谢科大讯飞及全国计算语言学学术会议(CCL)为本次评测的前三名提供奖金奖励。

更详细的评测信息会陆续更新,请密切关注。

重要时间点

以下所有时间点为北京时间(GMT+8)11:59 PM。

(除报名时间以外,其他时间点可能会有变动,请注册参加者密切关注本网站以及邮件通知。)

| 事件 | 时间 |

预报名 | 2017年4月5日 ~ 2017年4月17日 |

正式报名 | 2017年4月18日 ~ 2017年4月25日 |

发布训练集和开发集 | 2017年5月3日 |

系统搭建及调整 | 2017年5月3日 ~ 2017年7月31日 |

提交系统验证开发集 | 2017年7月1日 ~ 2017年7月31日 |

提交系统验证测试集 | 2017年8月1日 ~ 2017年8月3日 |

撰写系统描述 | 2017年8月18日 |

召开 CMRC2017 大会 | 2017年10月13日 |

【说明】

1、预报名:参赛队伍填写报名表,填报初步的参赛意向。

2、正式报名:正式注册参加本次评测。

3、发布训练集和开发集:向参赛者发布本次评测的训练集、开发集用于训练和调整系统。

4、系统搭建及调整:参赛者利用训练集、开发集搭建系统并调整。

5、提交系统验证开发集:为了避免最终提交系统时出现问题,参赛者可在上述时段提供一个可运行的系统提交给组委会,组委会在开发集上验证结果并与参赛者进行比对,保证结果的一致性。

6、提交系统验证测试集:参赛者正式提交最终系统,组委会在隐藏测试集上验证结果。

7、撰写系统描述文章:参赛者需要对参赛系统进行描述,提交评测汇报PPT的初稿(在此时间点之后仍可以继续修改);

8、召开 CMRC2017 大会:与 CCL2017 同步举办本次 CMRC2017 评测总结会,公布最终的排名,各个参赛者汇报评测时应用的系统和技术,以及最终的颁奖表彰环节。

注册报名

有意向参加的单位机构请直接填写报名表后发给评测会务组。

报名表格下载:

http://www.hfl-tek.com/cmrc2017/cmrc2017_application_forms.docx

评测会务组邮箱:[email protected]

评测委员会

Evaluation Co-Chairs

刘挺(哈尔滨工业大学)

王士进(科大讯飞)

Evaluation Members

崔一鸣(科大讯飞)

刘铭(哈尔滨工业大学)

联系我们

如果有任何与本次评测相关的问题,请随时联系会务组。

评测会务组邮箱:[email protected]

致谢

主办方:中国中文信息学会计算语言学专委会

承办方:哈工大讯飞联合实验室(HFL)

冠名商:科大讯飞

关于PaperWeekly

PaperWeekly 是一个分享知识和交流学问的学术组织,关注的领域是 NLP 的各个方向。如果你也经常读 paper,喜欢分享知识,喜欢和大家一起讨论和学习的话,请速速来加入我们吧。

关注微博: @PaperWeekly

微信交流群: 后台回复“加群”