AI PM认知系列第三篇,字数:2300+,速读需4分钟

从早期苹果的Siri,到最近国内的智能音箱大战,越来越多AI语音产品走入了大家的生活。

近几天我也在思考,相比已有更落地方案的计算机视觉,

AI的语音技术

在产品应用中的本质是什么?这个思考我也跟一些语音领域的专家探讨过,而其中我个人的理解是:

AI语音技术的本质,通过效率的提升,场景的便捷,重新定义了用户体验。

为什么我这么理解?那我们先来看看语音有哪些天然属性:

-

提升效率

:一分钟400字的速度靠打字是无法超越的,所以特定行业,语音的技术可以大大的提升人机的效率。

-

操作便捷:

解放了你的双手,除了一些基本的操作,无需要每个字都操作键盘或点击屏幕了。

-

学习成本:

对于不认字的老人和小孩,可以用语音来进行检索和进行操作,对于不会拼音的人,也可以使用语音识别。

-

语音技术:语音识别和语音合成

-

语音技术应用和未来思考

语音识别(Automatic Speech Recognition)是以语音为研究对象,通过语音信号处理和模式识别让计算机自动识别人类口述语言。

简单来说,就是让机器可以听得懂人话。

其中比较核心的部分是

语音听写

:就是将语音信息转化为文字信息。

中文语音听写的技术原理,如下:

-

说出一段话,比如:「产品经理」,机器收到只是一段声波信号。

-

进行信号的预处理,如:降噪,消除回音…等。

-

特征提取,如:说了几个字,音调是什么…等。

-

通过声学模型匹配,输出“音”:chan2,pin3,jing1,li3。(拼音举例)

-

通过语言模型处理,最终得到文字:产品经理。

而这里的

特征提取,声学模型

和

语言模型

在技术实现上,有两种方法:

-

传统:隐马尔可夫模型(HMM)

-

端到端:深度神经网络(DNN)

目前语音识别技术主要是通过DNN实现的,特定场景下最高可以达到

97%的识别率

。

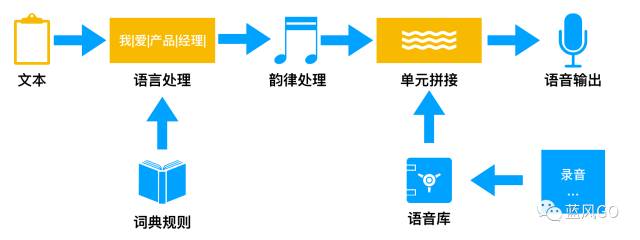

语音合成(Text-To-Speech)是计算机将自己产生的、或外部输入的文字信息转变为可以听得懂的、流利的汉语口语输出的技术。

简单来说,就是机器讲文字朗读出来。

-

先通过规则把一段文字分词,如:我|爱|产品|经理。

-

把这段文字进行韵律的处理,标出是发什么音。

-

根据语音库的发音,进行单元的拼接。

-

最后就可以播放出这段语音了。

-

拼接法:把录音的句子切碎成基本单元存储起来,再根据需要拼接起来。

-

参数法:通过录音提取波形的参数存储起来,早根据参数转化为波形。

拼接法

的优点就是更自然,但是缺点是需要大量的录音,和存储。

参数法

的优点就是存储小,但是缺点就是不够自然,听起来就是怪怪的机器发音。

另外

谷歌发布的

WaveNet

是基于语音网络使用生成算法制作而成的,相对于以前的拼接法、参数法,在声音表现力上更具优势。

目前的语音合成技术相对比较成熟,进一步优化的同时,大家的重点都放在了

表现力

上,以符合更多的场景应用,满足不同人对个性化的需求。

举个例子:

前一段时间,我打车时候看到司机师傅使用高德的语音导航,语音合成用的是一个

小朋友的声音

,我们就聊了起来,司机师傅说他才刚开始拉活,路不熟,用过郭德纲的声音,但是话忒多,他用小朋友的声音,一个是

语速慢

,另外一个是

吐字清晰

,不会因为听不清楚走错路。

这个例子说明在不同场景下用户对于表现力的

个性化需求

。

目前我们用微信语音或者是Siri时,都属于近场的识别,而智能音箱,车载设备,机器人的语音都属于

远场识别

,远场识别会受到,距离,噪音,混响…等问题,需要有其他的相关技术来配合完成,提高识别率。

麦克风阵列:

由一定数量的麦克风组成,用来对声场的空间特性进行采样并处理的系统。用于在会议室、户外、商场等各种复杂环境下,解决噪音、混响、人声干扰、回声等各种问题。

麦克风阵列

又分为:2麦克风阵列,4麦克风阵列,6麦克风阵列,6+1麦克风阵列。

随着麦克风数量的增多

,

拾音的距离

,

噪声抑制

,

声源定位的角度

,以及价

格

,都会上升,所如如何选择要贴合实际应用的场景,找到最佳的方案。

比如:

猎豹小雅AI音箱,用的就是

6+1麦克风阵列

,因为要针对360度的3-5米的场景中使用。而很多家电,比如电视机都是贴墙放置的,

2麦克风阵列

的180度,就足够使用了。

而两者麦克风阵列

技术要求和价格相差数倍

。所以对于产品落地来讲,在提供解决方案的时候,选择最优的方案。

语音激活检测:

在用微信时候,你会点击语音的按钮,来让语音开始识别。而在远场的时候,没有办法进行相关的操作,所以需要判断什么时候有语音,什么时候没有语音。

语音唤醒:

通过关键词来唤醒你的语音设备,比如:嘿~Siri,这时候语音识别才开始工作。

语音唤醒

难点

在于,唤醒的

响应时间

,

功耗要低

,唤醒的

漏报和误报率

……等。