专栏名称: 极市平台

| 极市平台是由深圳极视角推出的专业的视觉算法开发与分发平台,为视觉开发者提供多领域实景训练数据库等开发工具和规模化销售渠道。本公众号将会分享视觉相关的技术资讯,行业动态,在线分享信息,线下活动等。 网站: http://cvmart.net/ |

目录

相关文章推荐

|

北京经信局 · 事关人形机器人关键技术!这项新标准,已立项! · 6 小时前 |

|

北京经信局 · 事关人形机器人关键技术!这项新标准,已立项! · 6 小时前 |

|

调研纪要 · 机器人破圈 · 23 小时前 |

|

调研纪要 · 机器人破圈 · 23 小时前 |

|

财联社AI daily · 宇树人形机器人,下架! · 昨天 |

|

财联社AI daily · 宇树人形机器人,下架! · 昨天 |

|

ChatAI42技术与产品 · 估计KL散度的艺术:平衡偏差与方差的实用指南 · 昨天 |

推荐文章

|

北京经信局 · 事关人形机器人关键技术!这项新标准,已立项! 6 小时前 |

|

北京经信局 · 事关人形机器人关键技术!这项新标准,已立项! 6 小时前 |

|

调研纪要 · 机器人破圈 23 小时前 |

|

调研纪要 · 机器人破圈 23 小时前 |

|

财联社AI daily · 宇树人形机器人,下架! 昨天 |

|

财联社AI daily · 宇树人形机器人,下架! 昨天 |

|

ChatAI42技术与产品 · 估计KL散度的艺术:平衡偏差与方差的实用指南 昨天 |

|

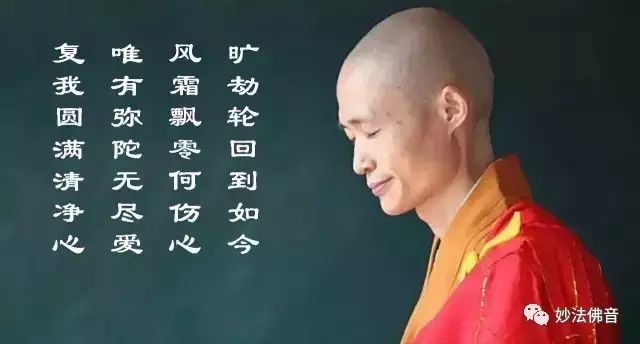

妙法佛音 · 【法师开示】念佛和做人要循序渐进 7 年前 |

|

钱皓频道 · ofo战上海:免押金成新杀手锏 7 年前 |

|

老子道德经 · 当太极与《梁祝》齐飞,太赏心悦目了! 7 年前 |

|

机器学习研究会 · 机器学习六步曲——“小马医生”养成记 7 年前 |

|

反派影评 · 真空中的尖叫——《异形》系列惊回首! | 下半场节目 7 年前 |