4月26日早上,我来到2017云栖大会·南京峰会的主会场门外,想先去阿里云“飞天·麒麟”浸没式液冷服务器的展台看上一眼。然而,展台前的热度更胜服务器的工作温度,一时半会挤不进去。正要举起手机拍下这热闹的景象,突然间,屏幕上弹出一条消息:第一艘国产航母在大连造船厂下水!

真是由南到北皆液冷啊!为什么这样说呢?因为新航母装备的相控阵雷达,由之前辽宁号的346型,升级为346A型:346型采用风冷/液冷混合系统,风冷系统的弧形外罩成为其外观上最明显的特征;346A型回归平板结构则得益于改用全液冷系统,配备了更多的收发单元,阵列面积也有所扩大。

用346A型取代346型的工作,已经受过国产航母的贴身保镖——052D型驱逐舰的验证。半个月之后,我去参观升级为非易失性存储技术制造基地的英特尔大连工厂(Fab68),正好路经大连造船厂,远观了几艘建造中的052D型驱逐舰。只可惜这么隔水相望,不可能了解到346A型雷达的液冷技术细节。

图中下方为大连造船厂建造中的两艘052D型驱逐舰,右上为其346A型雷达;左上为346型雷达,标志性的弧形外罩形成静压箱,如果战损会影响雷达的正常工作

看起来,如同其他被IT行业宣传为“黑科技”的技术,浸没式液冷具备如下要素:

-

修炼:在一些专业领域经过较长时间应用,相对成熟;

-

世外:距大众生活过远,新鲜感强;

-

伯乐:被具有足够大众吸引力的知名企业引入,宣传推广。

曙光在2015年6月展示的浸没式液冷方案,使用与“飞天·麒麟”同厂牌不同系列(注意键盘上方小字)的冷却液。经过高性能计算市场的积累,曙光在浸没式液冷方面的经验够丰富,至于展示水平就……

得到阿里云的强力加成,液冷这“旧时王谢堂前燕”,能否顺利“飞入寻常百姓家”?业内人士没有这么乐观,在某互联网巨头负责服务器设计的朋友就点评道:

这个泡“水”的主意从七八年前开始隔两年看见一次。还没有中、大规模应用的例子。运维、保修是大问题。热量还是需要被转移走,数据中心需要从头特制。液冷还有很多别的玩法,整个泡上只能在这种场合吸引一下眼球了。斗胆估计后续还是不了了之

。

没错,难点就在“规模”二字。扩大应用规模带给行业新的挑战和机遇,而背后一定要有需求驱动,否则最终难免沦为噱头,很难真正从小众走向大众。接下来,本文试图通过回答几个大家关心的问题,由浅入深的探讨浸没式液冷的中、大规模应用前景。

不同背景的人,对浸没式液冷提出的问题能有多不同?“飞天·麒麟”的展台前摆放的是一套专门为现场展示而搭建的小型系统,连POC(Proof Of Concept,概念验证)都算不上——窃以为,以阿里的体量,西溪园区的那几套或许还可以。负责展台的工作人员很担心大家以为阿里云“飞天·麒麟”浸没式液冷服务器就是这个样子,但没想到九成以上的观众过来第一句话就是——

这里面(的液体)是水吗?

对此,有人笑言,应该在醒目处贴上“这里不是水!"免去一遍遍的解释。不过呢,这个问题却也有过滤器的作用,可以快速排除来者是业内人士的可能性。

但是,“是不是水”也并非全无讨论价值。水的比热容(表示物体吸热或散热的能力)可以说是常见液体和固体中最大的,比所有的有机溶剂(包括油)都高,低黏度、无毒害、不可燃……还有清洁环保、易于获得(再列举下去估计要抽自己了)等无可比拟的优点……但是,再多的优点也比不上一个足以致命的缺点——水具有一定的溶解能力,溶解了一些离子之后就会导电。所以,作为冷却剂,水主要被用于间接冷却系统,通过冷板与冷却对象交换热量,避免直接接触。

水在冷却管道中流动,以及通过冷板换热,都会产生能量损失,影响PUE(Power Usage Effectiveness,能源使用效率)也是难以完全避免的,尽量降低而已。冷板的主要缺点是与主板形状耦合较紧,定制化程度高,通用化程度低,会拉高采购成本。

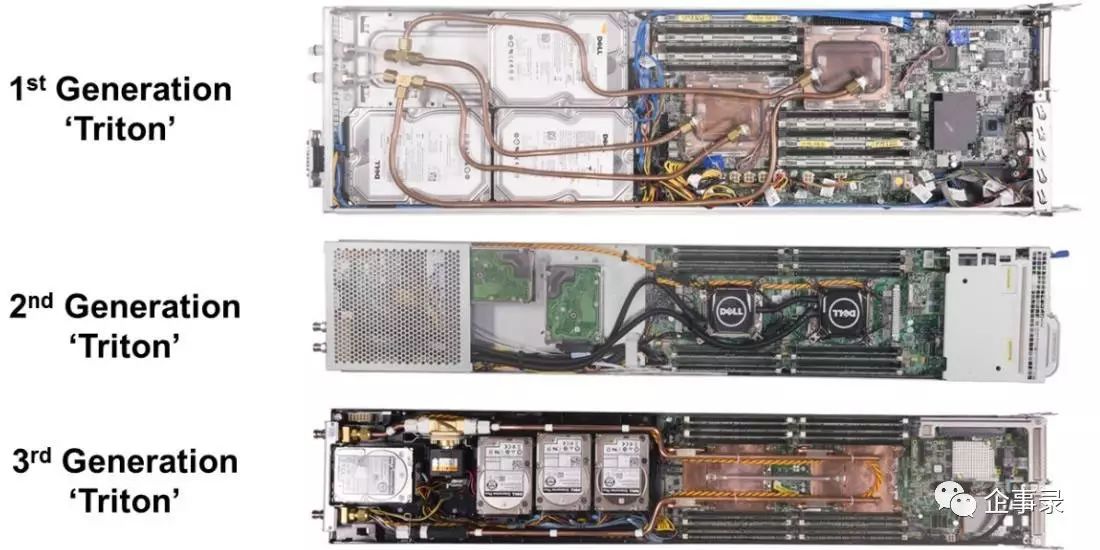

Dell为eBay设计的某冷板方案演变

水显然不能用于浸没式液冷,那么,第二个问题来了——

这是油吗?

矿物油在高性能计算(HPC)领域用作浸没式液冷是不乏先例的。举例来说,在2012年底Top500榜单上有3套系统进入前100名、最高列第7位的TACC(Texas Advanced Computing Center,德州先进计算中心),从2010年4月开始安装Green Revolution Cooling(GRC)的浸没式液冷方案。小范围使用之后,TACC的评价是:即使在100度(注:应为华氏度,约38摄氏度)的夏天,系统依然正常运行。

矿物油的优点和缺点都在于沾个“油”。如前所述,矿物油的比热容也不如水,但要做到绝缘可不要太容易。以GRC的ElectroSafe冷却剂为例,一种无毒、透明、无味的绝缘矿物油混合物,能够满足浸没式液冷的基本要求。

作为冷却剂,常温下的液体和气体,比热容相差不是很大(通常在十倍以内),气体可以达到较高的流速,但更多的吃亏在密度上——如GRC声称ElectroSafe冷却剂按体积算的热容是空气的1200倍(比热容是按质量算的,考虑到流速上的劣势,按体积算有夸大效果的嫌疑)。不过,在直接接触的情况下,液体还要考虑残留等问题。

所以,作为一种直接液体冷却(直接液冷)技术,

浸没式液冷的冷却能力比直接风冷强,效率又比间接液冷高

。至于冷却能力能有多强,效率能有多高,是否便于维护,则很大程度上取决于冷却剂的具体特性。

矿物油可以归入可燃物范围,需要经过额外的防爆处理。譬如,ElectroSafe冷却剂被美国国家防火协会(NFPA)评为0-1-0物质:无人体健康风险,但也只能说是“不易燃”,可以接受包括水在内的任何灭火物质。

2012年10月的TACC矿物油浸没式液冷机柜,可以看到系统在运行中,矿物油透明而不够清澈

更重要的是,油的黏性给日常运维带来不便:

GRC的官网显示,其CarnotJet系统的mPUE (mechanical PUE) 低于1.05,可达1.03,并有TACC的证言加持——“冷却10千瓦的功率只消耗大约300瓦。”如果这个数字没有夸大,“飞天·麒麟”浸没式液冷服务器的(局部)PUE是不是会更低呢?

既不是水,也不是油,那“飞天·麒麟”用的冷却剂——

究竟是什么?

先说答案:3M的电子氟化液。

再说特性:兼具水和矿物油的优点,以及少数水所没有的……缺点。

电子氟化液清亮、透明,流动性好,看起来很像水,近观完全没有矿物油那种油乎乎的感觉,也难怪很多不明就里的人误以为它是水。

与水相比,电子氟化液最大的优势当然是绝缘。所以,有时会被用在需要它是水(看起来像水)但又不能是水(不导电)的场合,而不是出于散热的诉求。

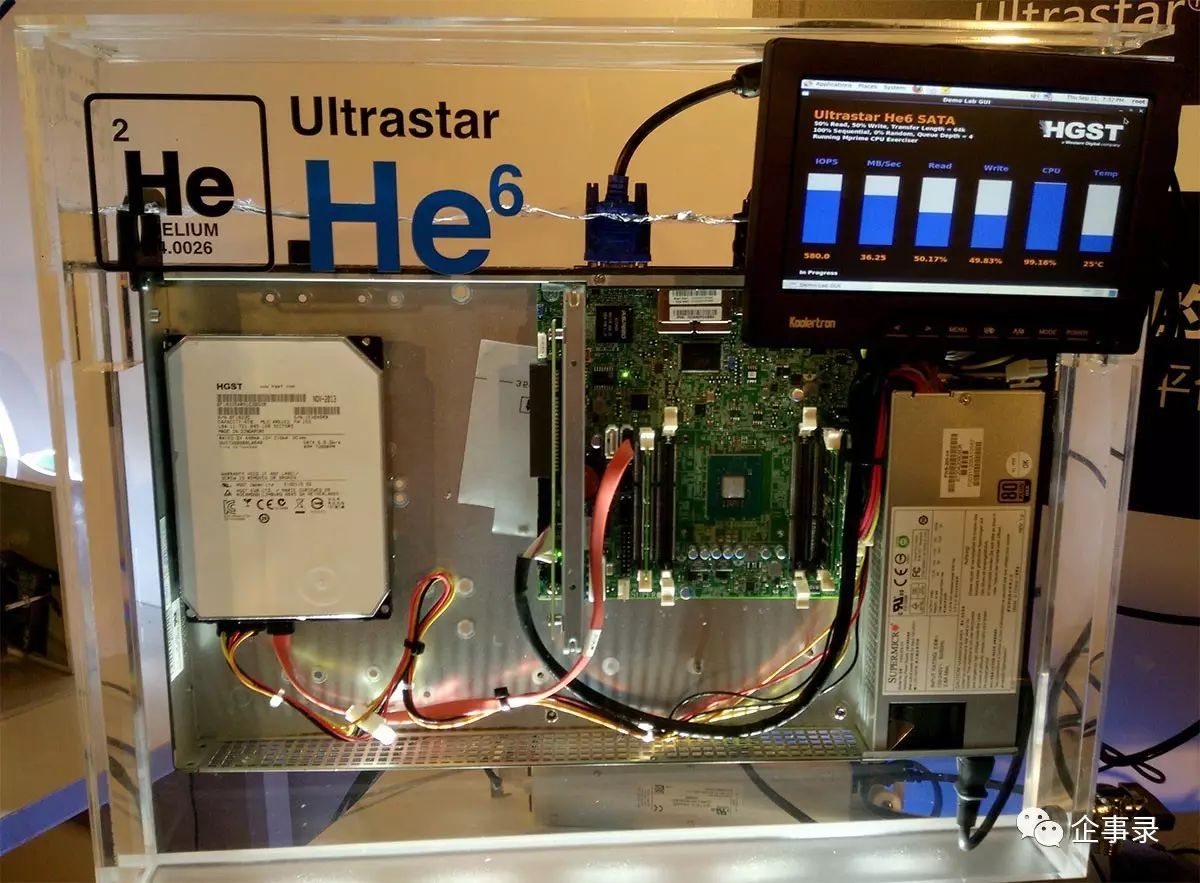

没看明白?容咱举个栗子先:2013年日立(HGST,现属于WD)推出了氦气密封硬盘——顾名思义,内部填充氦气(Helium),外壳密封(传统空气硬盘有透气孔及过滤器,维持内外气压平衡)。为了更直观的展示这一与众不同之处,日立多次在展会上把氦气硬盘泡“水”来突出其密封性,从最初的He6(6TB)到He8、He10和现在的He12,照片就不全列出了,以免喧宾夺主。

泡在电子氟化液中的Ultrastar He6充氦硬盘,注意容器上还标注了氦的分子量(4.0026)。7200RPM的硬盘远没到需要浸没式液冷散热的程度,当然右边的CPU受益于此,没有装散热片。后来在He8的展示中,CPU是加装了散热片的,氦分子量也标注为更精确的4.002602

前面提到的曙光展示和“飞天·麒麟”,则把氟化液用作浸没式液冷的冷却剂,也是本文要重点探讨的内容。

这就是真“相”?

目前“飞天·麒麟”使用的冷却剂,是Fluorinert电子液FC-72。Fluorinert是3M公司电子冷却液产品线的商标品牌名称,稳定的碳氟化合物液体,FC-72是其中的一种,学名全氟己烷(perfluorohexane),分子式C6F14,平均分子量338。FC-72具有良好的热稳定性和化学稳定性,而且可以和一些敏感材料相容、不燃、无毒无残留。由于“惰性十足”,FC-72还可以用作一些化学反应的介质。

不同的特性决定了,FC-72的用法与矿物油有着根本的区别。

基于矿物油的浸没式液冷方案,矿物油吸收热量后温度升高,但仍然是液体,并没有发生相变,属于“单相”液冷;而FC-72的沸点只有56℃,很容易沸腾,在汽化过程中带走热量,由于发生了相变,所以属于“两相”液冷。

水的常识告诉我们,汽化过程吸收的热量可比升温大得多。单相液冷完全靠比热容,FC-72当然也支持这种方式,但是氟化液和矿物油的比热容都比水低不少,有各自的极限。两相液冷的换热系数就要高得多,大约能达到单相循环式的10倍,单相不循环的100倍,空气循环的1000倍,是数量级的差异。

注意上面提到“循环”,两相液冷的冷却剂并不需要借助外力在管道中流动,而是在封闭容器内部通过“汽化-冷凝-再汽化”的过程形成自发循环,这个过程本身并不消耗机械能量。具体说来,CPU、内存等电子器件发出的热量被冷却剂吸收,达到沸点后汽化,蒸汽上升,到容器顶端遇到冷凝盘管,释放热量后凝结为液滴,再落下来完成循环过程。

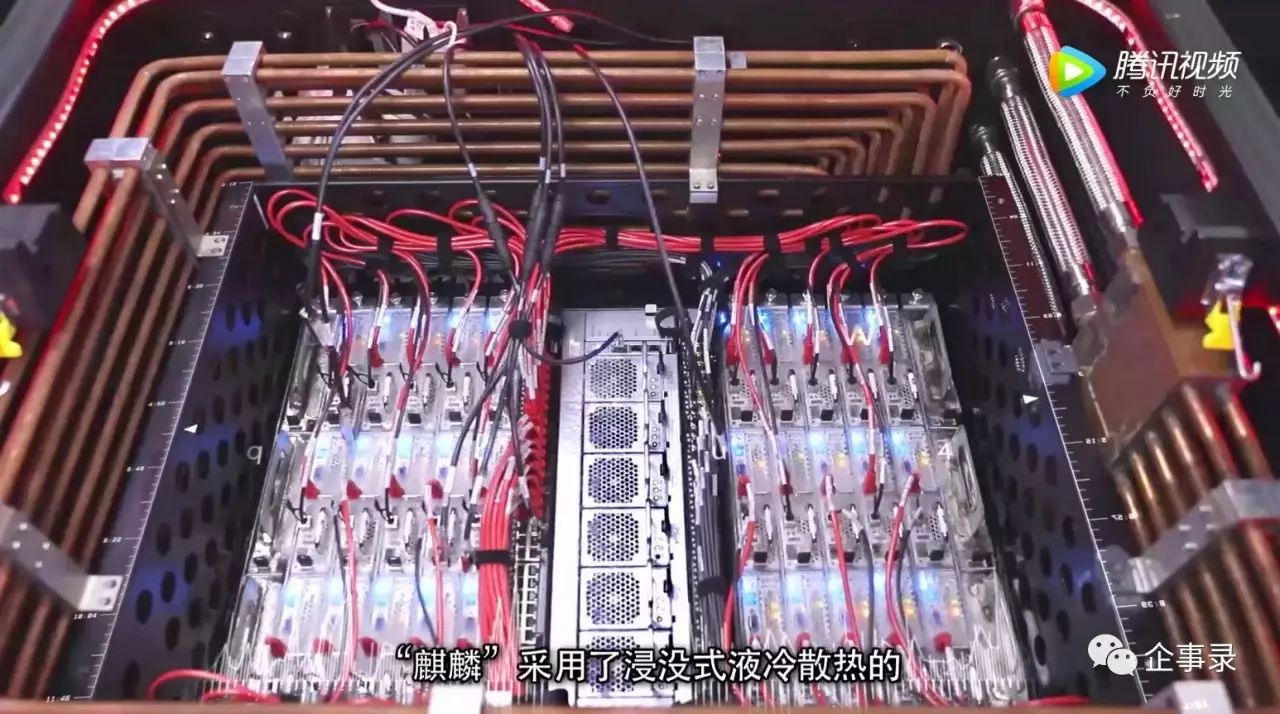

阿里云宣传片中的“麒麟”浸没式液冷系统特写,可以看到(运行中的)服务器面板附近的冷却液沸腾现象,以及容器上方四周环绕的冷凝盘管

由于FC-72的沸点有50多度,冷凝盘管中的水温度不需要太低,室温(如30多度,无需空调冷机或低温的自然环境)就可以满足换热的要求,把热量带走,流到冷却塔等设施中降温,再返回到冷凝盘管。水侧的循环流动过程是要消耗机械能量的,但是水的流动阻力明显小于矿物油。3M方面认为,(基于氟化液的)两相液冷可以将PUE降至1.01~1.02,GRC的方案实际上要到1.08,因为矿物油流动阻力比较大,降温后回流还要过滤,所以1.1~1.2比较正常,而且换热系数也远低于两相液冷。