来源:sinews.siam.org

作者:Michael Elad,以色列理工学院计算机科学系教授

编译:闻菲

【新智元导读】

本文作者 Michael Elad 是以色列理工学院计算机科学系教授,也是成像科学期刊 SIAM 的主编。他对当前图像领域使用深度学习的矛盾做了深刻的反思:一方面效果绝佳,另一方面却缺乏数学上的优雅,对领域基础知识没有很大贡献。是该坚守传统严谨的方法,但在最终结果上落后于人,还是该拥抱深度学习?Elad 选择后者,但同时坚守寻求数学上的优雅,弄清方法的原理。所有人工智能从业者都需要考虑如何对待深度学习。欢迎留下你的看法和评论。

(文/

Michael Elad

)我真的很迷茫,每天都在改变自己的看法,似乎对这个难题就是拿不出一个坚定的主意。不不不,我不是在说国际政治或现任美国总统,我说的是对全人类更重要的一件事,具体说,是事关我们这些工程师和研究人员生死存亡的事。我说的……是深度学习。

虽然你可能觉得上面的话说得过于夸张,但深度学习确实带来了一些我们不得不去解决的重要问题。下面我将具体讲一下这个跟这个领域相关的一个关键问题,与图像处理领域的研究人员相关。

首先,让我们先简单对深度学习做个定义。神经网络已经存在了数十年,提出了一种通用的学习机制,原则上可以适用于任何能够被学习的数据源。在神经网络的前馈架构中,感知机层(也被称为神经元)首先对输入进行加权平均,接下来非线性的运算,例如 sigmoid 或整流线性曲线(rectified-linear curves)。你可以训练这个简单到令人惊讶的系统,将给定输入数据集和期望的输出匹配起来,从而解决各种监督的回归和分类问题。

所有这一切听起来都很棒,但不幸的是,神经网络这个概念在 20 世纪 80 年代和 90 年代没有火起来——在当时,神经网络的性能根本没有什么竞争力。另外,用于学习任务的支持向量机(SVM)的出现,伴随着坚实的理论基础和凸优化方法,似乎为“神经网络无用”一说盖棺定论。最终,神经网络进入了很长的冬眠期。只有少数坚持不懈的研究人员——Yann LeCun(纽约大学和 Facebook)、Geoffrey Hinton(多伦多大学)、Yoshua Bengio(蒙特利尔大学)和 Jürgen Schmidhuber(Dalle Molle 人工智能研究所)——还留在这个舞台上,持续不断地试图说服众人这个看似注定失败的方法实际上能做得更好。他们的努力产生了一些重要的结果,比如卷积神经网络(CNN)和长短期记忆网络(LSTM)架构。但是,他们还是少数派。然后,神经网络突然杀了个回马枪,为这些人出了一口大气。

21 世纪初期的一系列论文表明了神经网络这种架构的成功应用,并在几乎所有任务中都取得了最好的结果。这些贡献的关键内容包括:使用许多层网络,这也是“深度学习”这个术语的由来;大量的训练数据;大规模的计算,通常在计算机集群或 GPU 上运行;以及采用有效初始化和随机梯度下降学习这些明智的优化算法。但不幸的是,所有这些伟大的实际成就都几乎没有理论或基本范式的理解。此外,从理论上看,在学习过程中所采用的优化方法是高度非凸(highly non-convex)和难解的(intractable)。

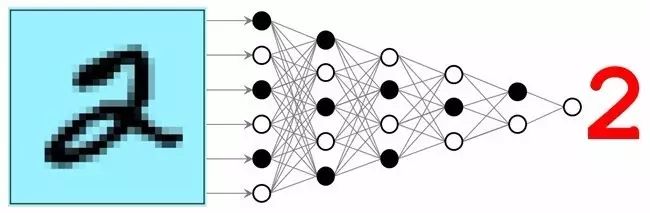

神经网络的成功应用始于手写数字的识别(参见图1),慢慢地但十分谨慎地转向更具挑战性的视觉、语音识别和自然语言处理任务,自此以后,几乎所有可以作为监督学习的任务都见得到神经网络的身影。像谷歌、Facebook 和微软这样的公司很快就意识到了这一领域的潜力,投入了大量的人力和财力去掌握这些工具并探索其在产品中的应用潜力。在学术方面,信号处理、图像处理和计算机视觉相关会议已经成为深度学习的主场,使用这种方法的工作越来越多。

图1:神经网络表现出了巨大的潜力,首先是在人物识别领域,随后还有许多其他任务上也表现优异。图片来源:Michael Elad。

深度学习在图像处理领域大放异彩,但我们该感到高兴吗?

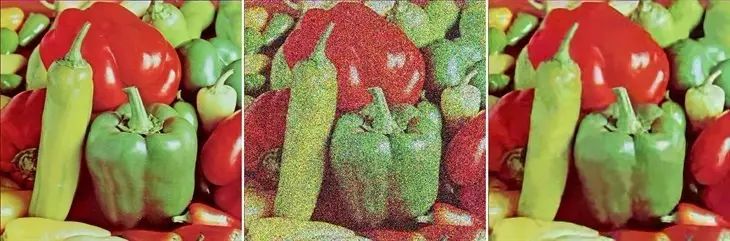

好,到了今天。为了简洁起见,我用经典图像处理任务 ——图像去噪(参见图2)为例。这些年来,关于这个基本任务,研究人员撰写了数千篇论文。其中,有利用偏微分方程,比如各向异性扩散(anisotropic diffusion)和全变差(total variation)的,有用能量最小化观点(energy minimization viewpoint)的,有从几何学出发将图像看做多维度空间的,还有使用 Beltrami 流等,开发出了各种美丽而深刻的数学思想。谐波分析和近似理论也被用于去噪任务,带来了小波理论(wavelet theory)和稀疏表征(sparse representation)的重大突破。其他绝妙的想法还包括低阶近似、非局部均值(non-local means)、贝叶斯估计和稳健统计(robust statistics)。也正是由此,我们在过去 30 年中获得了丰富的图像处理知识,影响了许多其他图像处理任务,并且在有切实数学依据的前提下有效推进了这一领域的发展。

图2.图像去噪示例。左边是原始图像。中间是图像增加了 STD=100 的高斯噪声污染。右边由最领先的一种算法——BM3D [1] 实现的去噪结果。来源:Michael Elad

2012 年, Harold Burger、Christian Schuler 和Stefan Harmeling 决定用深度学习处理这个问题。这个想法在概念上非常简单:拿一个大规模干净的图像数据集,添加合成噪声,然后将它们馈送到学习过程中,目的是将有噪音的图像转换为无噪的版本。虽然过程乏味,无奈又冗长——调参让性能提高可能花去了很长的时间——最终的结果却是一个在当时比任何已知的图像去噪算法性能都好的网络。

这样的例子不止一个。今天,深度学习可以处理许多其他图像处理任务,而且都能实现无与伦比的效果,包括单一图像超分辨率、去马赛克、去模糊、分割、生成图说和人脸识别等等。

我们应该对这个趋势感到高兴吗?如果我们是做商业应用的,要解决诸如图像去噪等实际问题,答案当然是肯定的。对吧?因此,寻求这样一个解决方案的公司应该满意了。但是,科学家呢?我们投身于解决图像去噪问题的巨大努力背后的真正目标是什么?是的,我们是要找到有效的去噪算法,但这是我们动机的一小部分,因为我们有更多更深入的事情要做。图像领域的研究人员旨在了解我们处理的数据的本质。这是通过对信息建模实现的,而建模是为了破解图像数据真正的维度和其呈现的现象(true dimensionality and manifested phenomena)。这样的模型可以用于图像降噪,也可以用于其他的图像处理任务。但最重要的是,这样的模型能够让我们发现从数据中提取知识的新方法,并拓展我们的视野。

To 深度学习 or Not to 深度学习,这是一个问题