针对基于深度学习的手写

OCR

引擎,理想的训练集应该能够覆盖各类书写风格、背景与光影变化、所有可能出现的词汇等。然而,采集这样的一个训练集十分费时费力,在一些情况下严重制约着手写

OCR

识别精度。手写图像合成的重要性由此显现。得益于近年来对抗式生成网络的发展,不少学者提出了从文本或印刷体文本行生成手写风格文本行的方法。但是,此类方法生成的手写风格仍然不够丰富。另一个手写文本行生成的思路是将联机手写数据转为脱机图像。联机数据可以方便地由手机、书写板等设备采集得到,数据量大、风格多变,若能将其转为逼真的脱机手写图像,则能够很好的辅助手写

OCR

的训练。

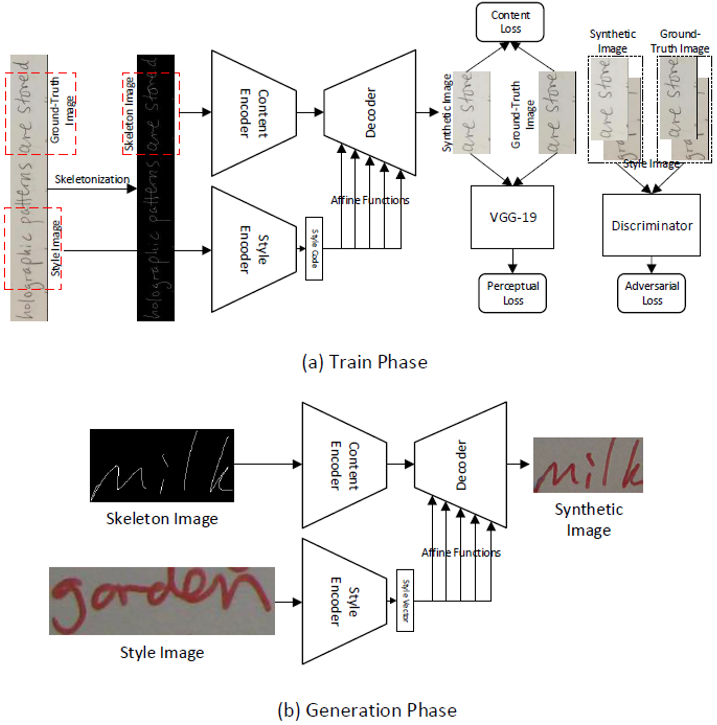

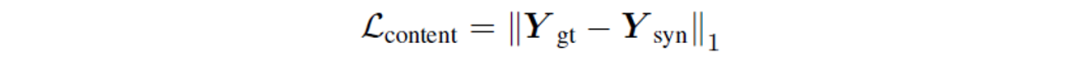

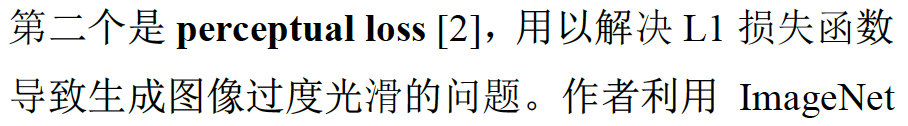

本文的作者提出了图

1

所示的框架,能够利用联机数据生成逼真的脱机手写文本行图像。该框架采用了

“

编码器

-

解码器

”

的结构,并且利用风格编码器从真实手写图像提取风格特征,作为解码器的条件输入。实验表明,结合真实手写图像与该框架生成的图像,手写

OCR

引擎的识别精度能够得到较大提升。

在测试阶段,将联机数据转为骨架图,并挑选任意一张真实手写图像作为风格图,一起输入生成器G,即可生成十分逼真的脱机手写图像。

作者首先在

IAM

数据集

[4]

上进行实验。

IAM

数据集共有

6,161

条脱机手写文本行,作者将其高度归一化为

=

96

,宽度设为

=

96

,宽度设为

=

3

=

3

。

IAM

数据集联机部分共有

12,195

条文本行,作者采用文中提出的方法将其转为脱机图,其中风格图像为上述的

6,161

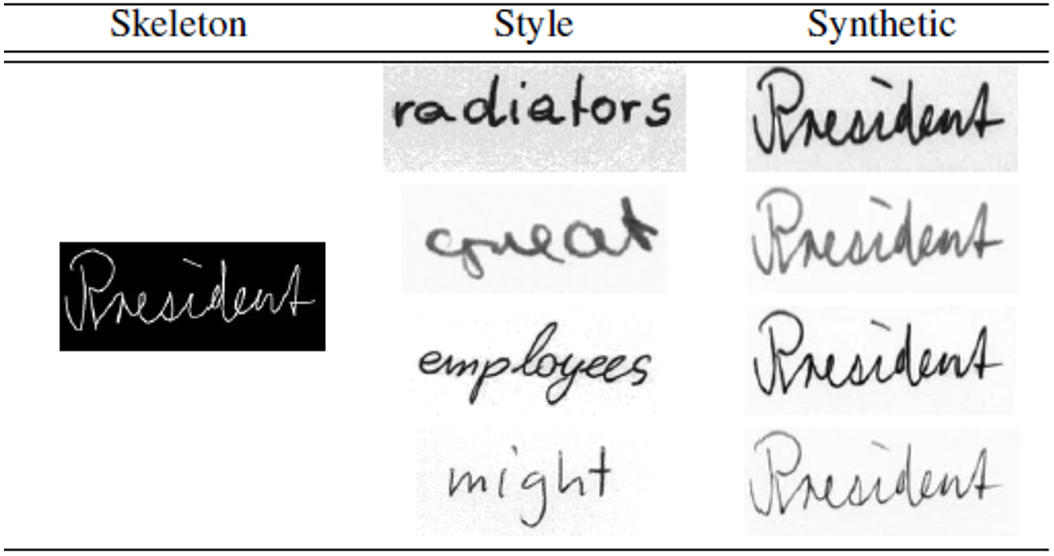

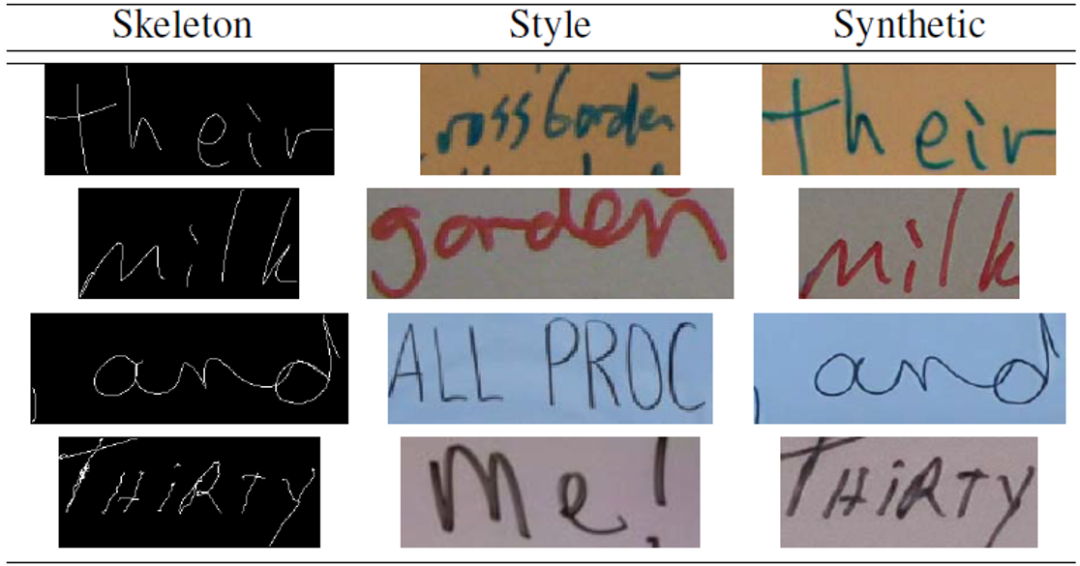

张脱机图像。生成的手写图像如图

2

所示,可以看到生成的图像保留了联机骨架的内容信息以及风格图像的风格信息。

。

IAM

数据集联机部分共有

12,195

条文本行,作者采用文中提出的方法将其转为脱机图,其中风格图像为上述的

6,161

张脱机图像。生成的手写图像如图

2

所示,可以看到生成的图像保留了联机骨架的内容信息以及风格图像的风格信息。

图

2

生成的脱机手写图像示意图,风格图像来自于

IAM

数据集。

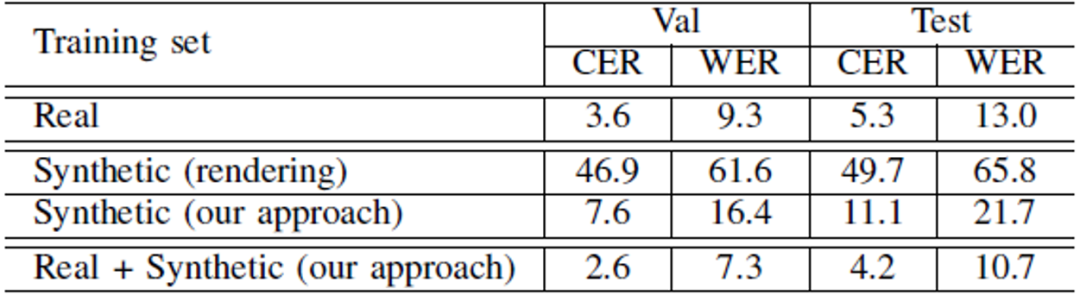

利用生成的图像和真实手写图像进行训练,结果如表

1

所示。从表

1

可以得到如下结论:一,相比于直接将联机数据打点转为脱机图,本文提出的手写图像合成方案明显更有助于

OCR

训练;二,生成的手写图像对于

OCR

训练的效果仍不及真实图像;三,采用真实图像和生成图像一起训练,识别精度有明显提升。

表

1

采用不同训练策略得到的

OCR

系统在

IAM

数据集上的

CER

和

WER (%)

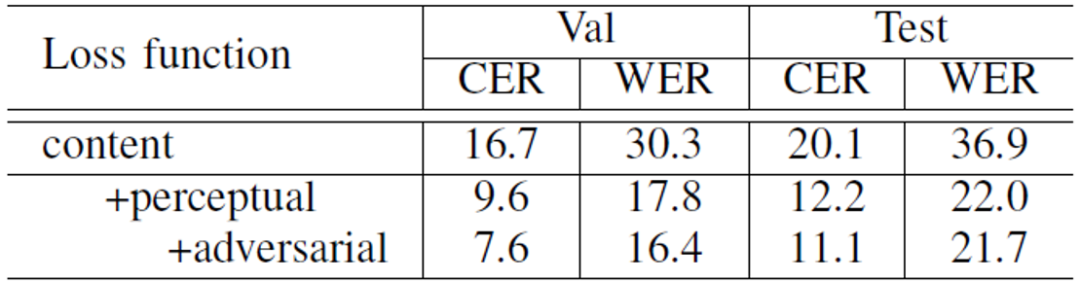

在表

2

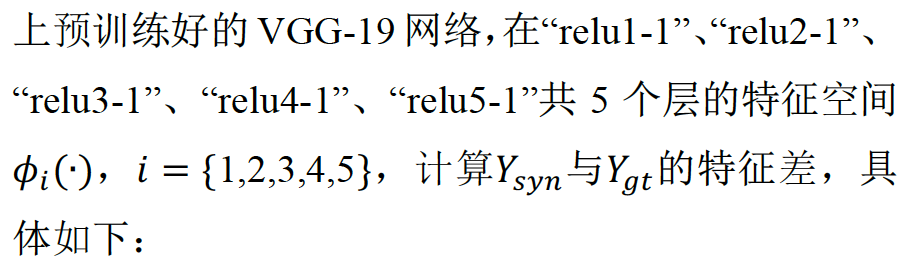

中,作者验证了采用三个损失函数的有效性。

表

2

不同损失函数对

IAM

数据集识别结果的影响

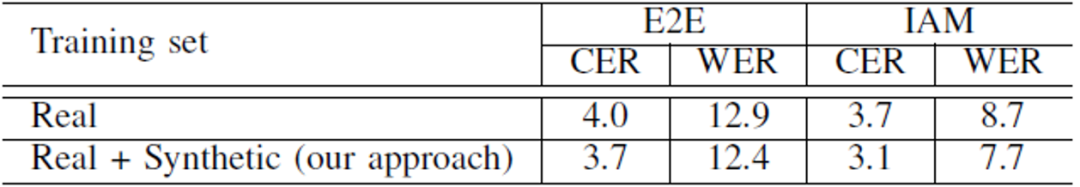

作者接着采用了更大规模的数据集进行训练,验证手写图像合成在大规模数据集情况下仍然有助于识别精度的提升。训练集中,真实图像来自于白板以及笔记上的手写图像,共计

248K

张;联机数据为私有数据,共有

506.8K

个样本,而风格图像与上述真实图像来源相同,共计

145K

个样本。生成的手写图像如图

3

所示,从视觉效果看,与真实手写图像殊无二致。实验结果如表

3

所示,可见在大规模数据集情况下,手写图像合成仍然有助于

OCR

识别精度的提升。

图

3

生成的脱机手写图像示意图,风格图像来自于白板以及笔记上的手写图像

表

3

采用不同训练策略得到的

OCR

系统在大规模数据集上的

CER

和

WER (%)

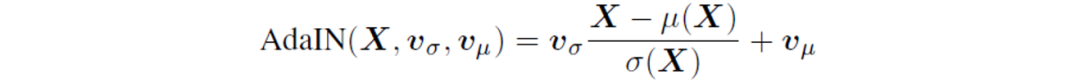

本文提出了一个

GAN

框架,能够将联机手写数据转为逼真的脱机手写图像,用于辅助

OCR

训练。实验结果表明,采用本文框架生成的手写图像能够有效提升

OCR

识别精度,对于采集和构造大规模手写数据集提供了一个可行的替代方案。本文潜在的改进空间有两点,一是可以探究更优的脱机图像骨架化操作,二是探究更优的生成器结构以及训练策略、损失函数等。

本文荣获

ICFHR2020 Best Student Paper Award

。

[1] T. Karras, S. Laine, and T. Aila, “Astyle-based generator architecture for generative adversarial networks,” in Proceedings of CVPR, 2019, pp. 4401–4410.

[2] J. Johnson, A. Alahi, and L. Fei-Fei,“Perceptual losses for real-time style transfer and super-resolution,” in Proceedings of ECCV, 2016, pp. 694–711.

[3] P. Isola, J.-Y. Zhu, T. Zhou, and A. A. Efros,“Image-to-image translation with conditional adversarial networks,” in Proceedings of CVPR, 2017, pp. 5967–5976.

[4] U. Marti and H. Bunke, “The IAM-database: an English sentence database for offline handwriting recognition,” IJDAR, pp. 39–46, 2002.

原文作者

: Mingyang Guan, Haisong Ding, Kai Chen and Qiang Huo