人类一直期盼能与动物进行交流,如今 AI 正在帮助我们完成这一愿望。从鲸类的复杂社交语言到家畜的情绪表达,在破译动物语言上,以大模型为代表的 AI 正凸显其作用。随着对动物的研究更加深入,我们也发现人类语言并非那样独特。更具实际意义的是,这类研究并没有过高的门槛——或许在未来,与宠物直接对话,用的就是你自己的研究成果。

在电影《飞屋环游记》中,一只名叫逗逗(Dug)的狗戴着一个神奇项圈,它能将狗狗的叫声翻译成流利的人类语言。在现实世界中,非常训练有素的狗可以被教会按按钮,以回应人类语言来执行简单的命令,如“出去”、“散步”和“玩儿”。

与动物进行交流,是人类长久以来的梦想。1973 年诺贝尔生理学或医学奖得主劳伦兹(Konrad Lorenz)曾就该问题撰写《所罗门王的指环》一书,后成为领域内经典科普书,很值得一读。

近年来,已有不少用生成式 AI 破解动物语言的尝试。本文将先讲述是哪些技术因素促成了这些进展,之后介绍几项相关研究成果,并以对未来的展望结尾。

对动物语言的研究,不仅有助于我们更深入地理解和引导野生动物的行为,还能对畜牧业生产有所助力。对于爱宠人士,动物“语言”的研究或许能够让我们更深入了解爱宠的诉求,从而得以“换位思考”,更体贴地关爱宠物。而从满足好奇心的角度,这项研究有可能从进化和生理机制方面,为人类语言的产生提供新的视角。从更科幻一些的角度,破解动物语言过程中所积累的技术,也将可能用在识别外星生物的语言上。

2024 年出版的一本关于动物语言的优秀科普读物《听不见的大自然——博物学家的自然聆听笔记》,详述了近期科学家如何使用数字技术去理解自然,还谈到了过去人类在理解动物语言中走过的弯路。20 世纪中期,人们曾多次尝试教非人灵长动物使用人类语言,当时的愿望是通过教它们“说人话”来评估它们的智力。

这一努力失败后,人们发现这种做法有些过于人类中心主义了。正如 1974 年美国哲学家 Thomas Nagel 在一篇著名的论文中问道:“成为一只蝙蝠是什么感觉?”他得出的结论是,试图根据人类心智和身体的框架去理解动物注定会失败。为了去掉人类的视角,他表示,研究人员必须把自己放在动物的“umwelt”(环境),但人类永远无法以蝙蝠的身体体验世界。

前文的“umwelt”是生物学家创立的一个术语,用以描述生物体的生活经历或世界观。如果我们关注某种生物的 umwelt,比如蜜蜂的,我们当然不会期望蜜蜂说人类语言,但我们会对蜜蜂的迷人“语言”非常感兴趣——这是一种基于翅膀振动发声和三维空间位置的语言,蜜蜂能用身体传达非常细微的差异,比如阳光的变化。因此在理解动物语言时,我们首先要做的就是考虑动物如何用自己的方式,用自己的身体,在自己的世界观中进行复杂交流的能力。

而在没有任何先验知识中学习到规律,正是大语言模型擅长的。大模型通过处理大量现有的语言内容来学习哪些单词应该组合在一起,以及以什么顺序组合。例如,“他喜欢加牛奶和两块糖的咖啡”,大模型学会了“咖啡”、“牛奶”和“糖”这些词经常一起使用。换句话说,大模型并不是通过被教授语法规则来学习一种新语言;也不是通过首先掌握英语,然后通过处理大量翻译内容来学习西班牙语。

考虑到人类语言和动物“语言”存在潜在的相似性,比如几乎所有人类语言和动物的发声都是由音节长度和音高的停顿和变化构成的,这就为基于大模型破解动物语言奠定了哲学上的可行性。用《听不见的大自然》一书作者在 FT Tech Tonic 播客中说的,“你和我无法像蝙蝠一样回声定位,像大象一样吹喇叭,像蜜蜂一样嗡嗡作响。但我们的计算机可以。”

计算机能处理人耳听不到的声音。人类能听到的声音范围是 20-20,000 赫兹,而海豚能探测的频率高达 160,000 赫兹;并且人工智能在识别细微差别方面更为擅长。下面的视频是抹香鲸之间的对话。我们的大脑无法区分是哪头鲸鱼在说话,但是(理论上)可以通过训练模型来识别不同抹香鲸的声音。

视频来源:The Sound of Sperm Whales | WHALEZONE.TV

考虑到群居动物交流的时候,往往发声的动物不止一个,因此按来源分离重叠的声音,是利用 AI 解读动物语言的第一步。之后要做的是收集大量的数据。这是目前的主要问题之一。

因为即使经过几十年的手工录音和拍摄,科学家也只捕捉到了所需数据的一小部分。近年来,随着设备小型化、通信技术的进步,研究者可以让动物带上摄像头、录音设备或通过无人机持续记录数据,从而得以获得足够多的数据。AI 模型的训练过程,还是熟悉的配方:例如向机器输入所拥有数据的 80%,训练后的模型可以预测剩余 20%,即动物接下来将发出什么音节。这就像语言模型基于训练数据,预测句子中的下一个单词一样。

在介绍基于 AI 解析动物语言的具体案例之前,读者可以想想科学界为什么对鲸鱼感兴趣。从历史文化角度来说,鲸歌在民间传说中反复出现,人们一直怀疑鲸鱼有着自己的语言。

而从生理特性上,抹香鲸拥有所有动物中最大的大脑,且以家庭为单位生存。根据“社会复杂性”假说,有着复杂社交生活的动物需要演化出复杂的语言系统来应对社交需求。

事实上,人们观察到抹香鲸可通过类似摩尔斯电码的“点击”声进行交流。例如多米尼加海岸附近的一群抹香鲸使用 1+1+3 的声音来自我识别。前面两个是均匀间隔的“点击”,之后是三个快速连续的“点击”。随着越来越多的证据表明鲸类的交流不是随机的、偶发的、简单的,而是遵循复杂逻辑构建,这就为首先研究鲸鱼语言提供了必要性论证。

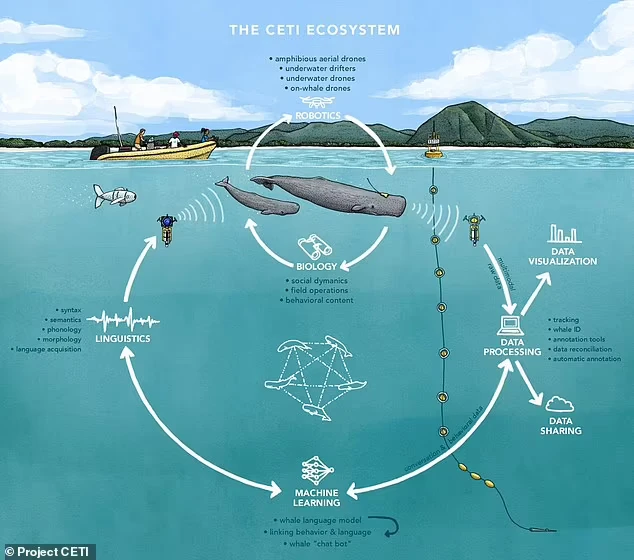

鲸类翻译倡议(Project CETI)是一项 TED 资助的研究项目,该研究专注于抹香鲸间的交流,计划用人工智能将鲸鱼发出的每个声音与特定的背景联系起来。

CETI 项目的示意图丨图源:Project CETI / Alex Boersma

考虑到鲸鱼的叫声可以在很远的距离内被听到——最远可达 6000 公里,了解哪头鲸说了什么以及什么情况下说的,对于人们理解“鲸语”潜在的含义至关重要。研究者还要考虑鲸类的声纳定位。

所有有齿鲸类都有一个类似声纳发射的器官,它能用声音创建一个超出其眼睛所能看到的世界的 3D 视图,可类比智能驾驶中的激光测距雷达。因此当鲸鱼向特定方向发声时,研究者需要研究与特定声音关联的局部环境信息。

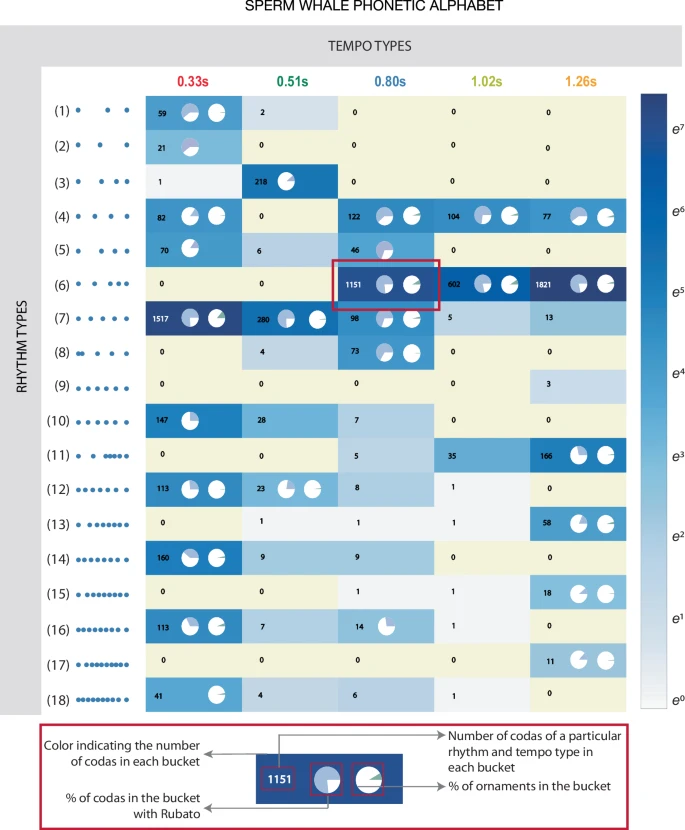

2024 年 5 月 7 日,来自麻省理工学院(MIT)及 CETI 的研究者在 Nature Communication 上合作发表的论文可视为该项目的初步成果。该研究使用机器学习对抹香鲸录音做分析并可视化,证实了抹香鲸发出的声音是前后有关联性的,且像人类的发音那样,由不同特征组合形成。研究人员收集了来自东加勒比氏族抹香鲸的 8719 个尾声数据,构建了抹香鲸的“拼音字母表”。

类似人类语言,抹香鲸发出的声音组合也不是均匀出现的,某些组合比其他组合更频繁;不同类型的尾声依次组合在一起,产生了一个更大的不同发声家族,这让人想起人类语音产生的二级组合结构(可类比拼音中的声母和韵母)。研究还发现,抹香鲸可以发出不同的尾声模式,而其他鲸鱼则能识别出不同鲸鱼发声的细微变化,表明它们有音色判别的能力。

研究发现的抹香鲸字母表示意图。丨图源:参考文献[1]

CETI 是一个预期持续五年的项目,如能完全成功,其结果也不会是将鲸鱼所说翻译成人类语言。AI 可能学会说“鲸语”,但不是对人类说的,人类只能依据 AI 的结果综合分析出鲸类在表达什么。目前已有基于声音检测的程序,识别出生病或受伤的逆戟鲸。如果让 AI 学会鲸类在搁浅之前发出的声音,则可提前预警,为此准备预防措施。

船舶撞击对许多种类的鲸鱼构成严重威胁,想象一下,如果我们能“听到”一头鲸鱼或其群体在碰撞后呼叫声,得到的位置记录相关数据,必然会对未来的鲸鱼保护措施提供帮助。(尽管这些数据会让热爱动物的我心碎。)

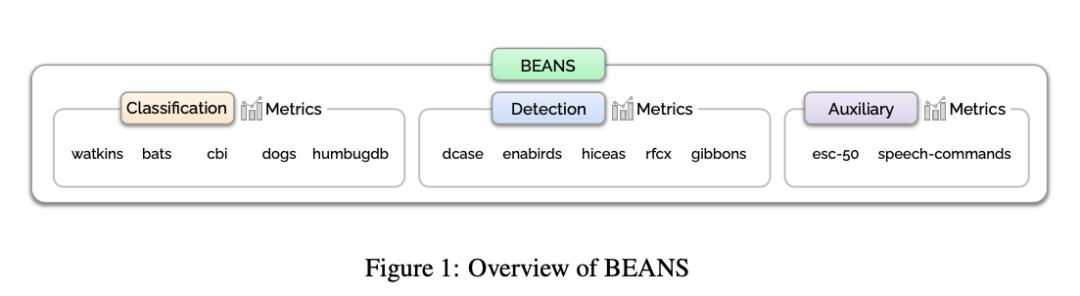

类似的项目还有地球物种项目(ESP),该项目试图使用AI工具来解码、标记甚至回应包括白鲸、夜莺、乌鸦和座头鲸等各种动物的叫声。该研究的成果之一是“动物声音基线”BEANS(the BEnchmark of ANimal Sounds),这是一个包括 12 个物种声音的数据集,涵盖鸟类、陆地和海洋哺乳动物、无尾两栖动物和昆虫,可用于检测相关分类算法的性能。

地球物种项目还在尝试合成动物声音。如同人类的声音可以被深度伪造一样,鸟鸣声也可以。

不论是猪、牛或者鸡,这些畜牧业中最重要的动物,正在由于工业化的圈养,而受到越来越不人道的待遇。工业化养殖不止伤害了饲养的动物,更不利于我们自身的生活环境。

随着对动物权益的关注,人们想要了解诸如猪、牛等动物的情绪。这么做不止是为了符合(某些国家的)监管,更有可能产生实际的经济效益。近年来华为、网易等大厂都推出智能养猪项目,获得了很多关注。

要想养好猪,首先要了解猪。近年已有多项研究,基于 AI 通过猪、牛、鸡等动物的脸部图片、视频和叫声,识别其情绪。研究人员通过多个摄像机持续记录动物行为,然后由兽医等专业人士根据场景进行人工标注:例如猪在吃东西时是开心的,在被人拖走时是紧张的。

研究人员将其作为训练AI模型的标签,然后训练卷积(对图像)或循环(对声音)神经网络模型,给动物行为进行分类;最后用专家标注的标签当作金标准,用以评估模型的准确率。这也是这类研究的一贯套路。

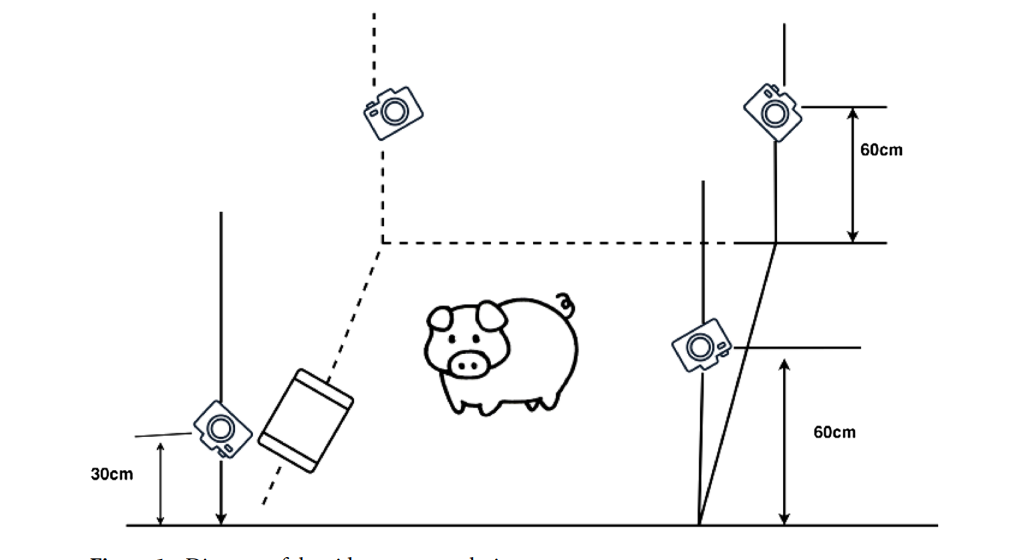

用于猪情绪识别的视频数据收集装置丨图源:参考文献[5]

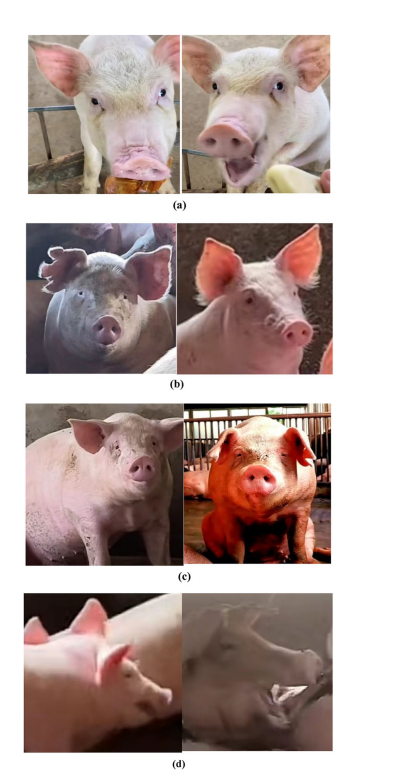

分别处在开心、中性、恐惧和愤怒状态下猪的图片示例。图源:参考文献[5]

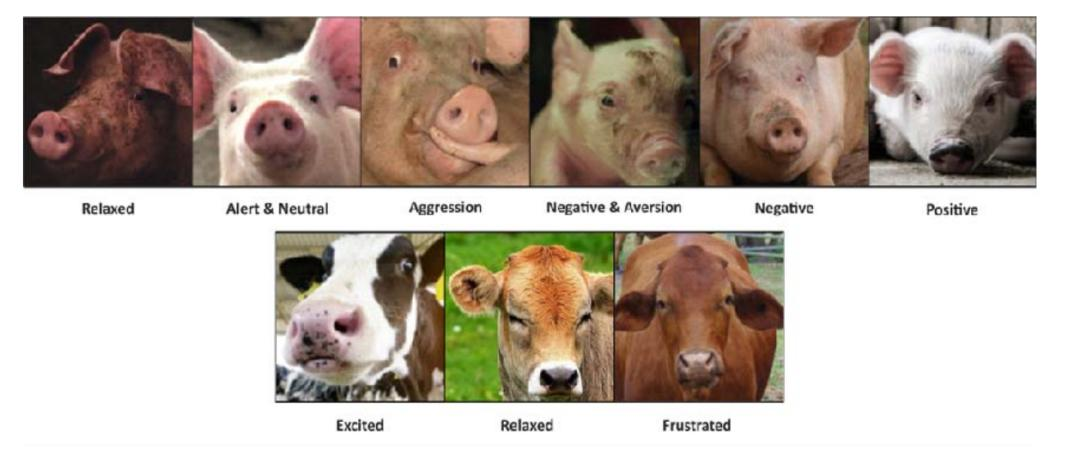

一项基于猪的 45 秒短视频进行情绪分类的研究,准确度达到 89.4%。另一项专注于猪和牛的研究(使用来自 6 个农场的 3780 张图片),通过识别动物耳朵动作和眼白区域的变化,研究人员构建了这两种动物情绪的实时分类模型。该模型将猪的情绪分为 6 种,牛的分为 3 种,准确率达到了 85%。

根据耳朵对猪和牛进行情绪分类的示例丨图源:参考文献[7]

同样,家畜声音也被收集训练以理解它们的情绪。一项基于 411 头猪,一生中的 7414 叫声及对应背景数据,研究人员开发出分类模型,区分正向和负向情绪,准确率可达到 91.4%。而一项预印本研究使用了 80 只鸡的样本,细致地记录并分析了它们在不同情境下的鸣叫。

为了确保系统解读的准确性,研究者与一个由八位动物心理学家和兽医组成的团队合作,建立基于深度学习的模型,该系统可识别多种情绪,包括饥饿、恐惧、愤怒、满足、兴奋和痛苦。

人工智能应用于动物研究不只是改善动物福利,更实际的是帮助检测动物疾病。剑桥大学研究者开发的 AI 系统能够检测羊的疼痛水平,这有助于对常见但严重的动物病症进行早期诊断和治疗。这项技术还可以应用于其他类型的动物。相关技术完善后,可以在动物饮用的水槽放置摄像头,系统就能够识别出疼痛的动物,从而及时治疗,减少损失。

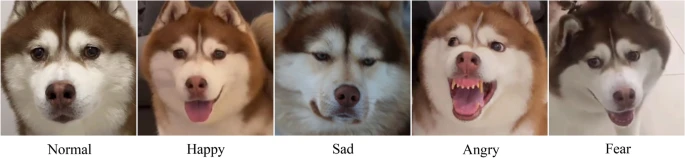

更贴近生活的研究,来自对宠物情绪的识别,例如文献[10]展示了对宠物狗情绪的分类模型。研究人员根据狗的面部图像建模,可识别不同品种宠物狗的情绪。

当前市面上也有不少以“翻译宠物语言”为卖点的 APP 产品,然而根据当前研究水平,AI 只能够对情绪进行粗略地划分,并不支持想象中的与动物进行多轮复杂对话,这些 APP 也都是娱乐式的。事实上,由于动物和人的生活环境截然不同,与动物无障碍的交流,或许永远是一个难以实现的梦想。

除了影像和声音,理解动物还可以基于脑电数据。2022 年的一项研究便通过事件相关电位(ERP),使用非侵入的方式,发现狗能够对人的声音迅速进行反应,能将人类富有情绪的发声与其面部表情相匹配。这项研究虽然与解读动物语言无关,但有了动物的脑电数据,将更准确、更直接地帮人类了解动物的所思所想。

从巴甫洛夫的狗到珍妮·古道尔的黑猩猩,人们对动物语言和行为的研究,不断改变着我们认识自身的方式。我们在动物中找到人性共有的部分,再反观自身,找到人性中独特的与崇高的部分。

从动物语言研究获得的新知越多,越让我们意识到和我们共享地球的生灵的复杂性。例如前述的关于抹香鲸的研究,抹香鲸能够通过节奏、语速、装饰音的组合产生复杂的语言,是除人类语言外第一个具有组合排列特征的语言系统。自从哥白尼原理将人类从宇宙的中心驱逐以来,我们又一次发现自身并没有那么特殊,这能教会我们要在未知面前保持谦卑。

然而人类可能永远无法破译动物的语言。子非鱼安知鱼之乐,对动物的情绪进行简单分类,是基于人类专家按照自身 umwelt 的先入之见进行的判断。

除了优点,我们也不该忘记技术存在被滥用的可能,以及新技术对生物伦理提出的新问题。识别鲸鱼的语言后,或许会让某些不择手段的公司跟随鲸鱼,前往未知的渔场捕鱼;即使算法能够生成足以以假乱真的抹香鲸的叫声(通过了抹香鲸版的“图灵测试”),贸然将合成的声音引入自然界已有的交流系统,也有可能改变鲸鱼之间正常的交流,或引发鲸鱼的焦虑,导致对野生动物的伤害。

不过,尽管这类研究在哲学上存在争议,但其应用是具有实际的经济意义的,值得持续关注。随着智能家居的普及,自家宠物的一举一动都将被记录,为宠物开发的智能硬件,将会不仅跟踪宠物的饮食饮水、运动状况,还可能记录宠物的心跳血氧等数据。拥有了这些数据,意味着我们能够对动物开展之前受限于技术条件的研究。

同时,这也意味着可以让更多普通人有机会成为“公民科学家”,通过贡献数据,进行干预性实验,以及参与数据分析,切身参与到第一线的科研活动。例如在很多轶事中出现的有超强学习天赋的狗,但如果只是特例的一两只,无法视作严谨的科学研究。

2023 年的一项研究显示,通过普通人参与数据收集,有 41 只被认定为能根据主人指令拿起特定的玩具;基于收集到的数据,研究者进行了统计分析,发现了这些“天赋异禀”的狗的共性,甚至它们可被视为一个全新的品种。

类似的研究,可以在众筹网站上由爱好者自行开放讨论,完善实验设计,募集所需资金,之后招募志愿者完成实际数据分析,最终合作撰写研究报告。例如笔者构想,可以让狗狗带上类似 GoPro 这样的相机,去记录遛狗时狗与其它动物间的互动:当遇见体型明显比自己大的狗,与体型比自己小的狗的时候,发出的叫声(或遇见同一性别或不同性别)有何差异。

人们可以构建基于类似的动物互动的 AI 预测模型,搭建站在宠物视角的“翻译应用”。而非当下站在人类视角,将狗叫声翻译成如何想要与人互动这种“讨好型”的应用。

这样的经历,对参与者来说会是一次有切身体验感的科普活动,会让他们懂得科学方法,提升批判性思维。类似的科研活动,比如记录鸟类的叫声和影像,门槛低、趣味性高,是大多数人都可参与的,尤其适合亲子互动。

[1] https://www.nature.com/articles/s41467-024-47221-8

[2] https://blog.google/technology/ai/protecting-orcas/

[3] https://arxiv.org/abs/2210.12300

[4] 菲利普·林伯里 (Philip Lymbery),失控的农业,人民日报出版社,2019.

[5] https://www.nature.com/articles/s41598-024-51755-8.pdf

[6] https://www.nature.com/articles/s41598-022-07174-8#Ack1

[7] DOI: 10.1101/2021.04.09.439122

[8] https://www.researchsquare.com/article/rs-3034567/v1

[9] http://www.cl.cam.ac.uk/~pr10/publications/fg17.pdf

[10] https://www.nature.com/articles/s41598-023-30442-0

[11] https://royalsocietypublishing.org/doi/full/10.1098/rsos.211769

[12] https://www.nature.com/articles/s41598-023-47864-5

来源丨返朴(ID:fanpu2019)

责编丨何通

审校丨徐来、林林

本文封面图片及文内图片来自版权图库

转载使用可能引发版权纠纷

原创图文转载请后台回复“转载”