文章介绍了Quail支付、Anthropic发布的新AI模型Claude 3.5 Sonnet和Haiku、Mochi 1视频生成模型以及ComfyUI V1的发布等内容。

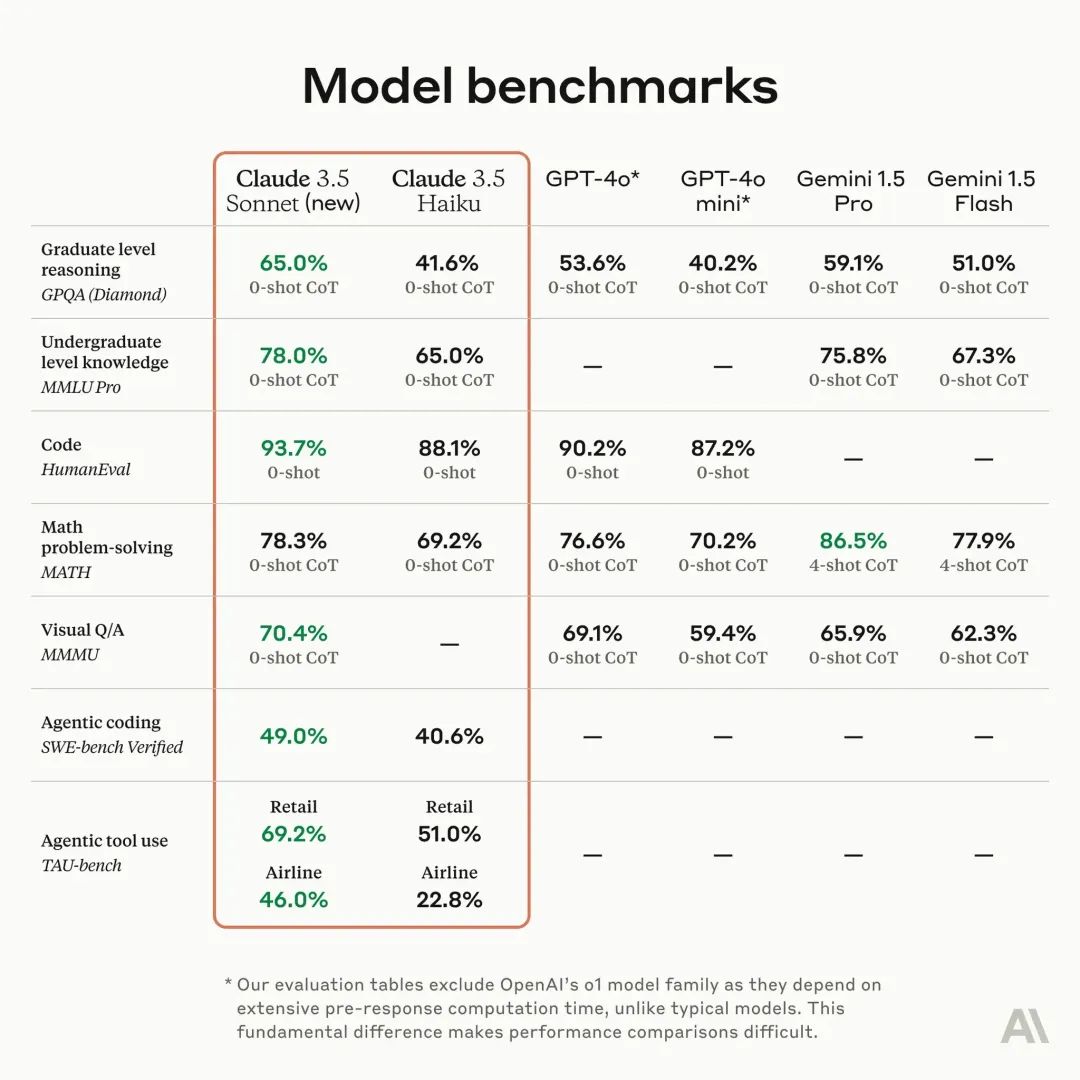

这两个新模型在人工智能领域取得了显著的进步,特别是在代理编码和工具使用任务方面。Sonnet在SWE-bench Verified上的性能得到提升,超越了其他公开可用的模型。Haiku在许多智能基准上超过了上一代最大的模型。

Mochi 1能以每秒30帧的速度生成高时间连贯性和逼真运动动态的视频。它模拟物理学,如流体动力学和毛发模拟,并表现出一致、流畅的人体动作。

ComfyUI V1解决了Comfy复杂的部署问题,提供了完整的桌面安装包、代码签名和安全、跨平台支持、自动更新等功能。此外,它还推出了新的自定义节点库Comfy节点注册表。

封面提示词在这里

[1]

Quail 现在正式支持微信和支付宝支付了,上周很多无法支付的朋友实在对不起

可以在这里订阅:https://quail.ink/op7418/upgrade

。

另外为了国内微信生态的朋友阅读,

新增小报童渠道

,各位可以选择合适自己的渠道:

https://xiaobot.net/p/guizangNews

上周二的晚上是会写入人工智能史的一天,那天晚上一晚上AI各个领域都有重要发布,太离谱了,不知道那些厂商怎么选的日子。

上周精选 ✦

Anthropic 发布新版Claude 3.5 Sonnet、Claude 3.5 Haiku和Computer use功能

[4]

Anthropic 上周发布了 Claude 3.5 Haiku 和升级款的 Claude 3.5 Sonnet,Claude 3.5 Sonnet 推理得分超过O1。而且 Claude 现在支持像人类一样操作计算机,通过查看屏幕、移动光标、单击按钮和键入文本。

新版Claude 3.5 Sonnet介绍:

更新后的Claude 3.5 Sonnet在行业基准上显示出广泛的改进,尤其是在代理编码和工具使用任务方面取得了显着的进步。

它在SWE-bench Verified上的性能从 33.4% 提高到 49.0%,得分高于所有公开可用的模型,包括 OpenAI o1-preview 等推理模型和专为代理编码设计的专用系统。

它还将在代理工具使用任务TAU-bench上的表现提高,零售领域从 62.6%提高到 69.2%,在更具挑战性的航空领域从 36.0%提高到 46.0%。

早期客户反馈表明,升级后的 Claude 3.5 Sonnet 代表了 AI 编码的重大飞跃。GitLab 为 DevSecOps 任务测试了该模型,发现它在没有增加延迟的情况下提供了更强的推理能力(在各种用例中高达 10%)。

Claude 3.5 Haiku介绍:

Claude 3.5 Haiku 在各项技能上都有所提高,甚至在许多智能基准上超过了上一代最大的模型 Claude 3 Opus。

Claude 3.5 Haiku 具有低延迟、改进的指令遵循和更准确的工具使用能力。

Haiku 在编码任务上尤其强大。例如,它在 SWE-bench Verified 上得分为 40.6%,优于许多使用公开可用的最先进模型(包括原始的 Claude 3.5 Sonnet 和 GPT-4o)的代理。

教Claude使用计算机

为了使这些通用技能成为可能,构建了一个 API,使 Claude 能够感知计算机界面并与之交互。

开发人员可以集成此 API,使 Claude 能够将指令(例如,“使用我的计算机上的数据并在线填写此表格”)翻译成计算机命令(例如,检查电子表格;移动光标打开 Web 浏览器;导航到相关网页;使用这些网页中的数据填写表格;等等)。在评估人工智能模型像人一样使用计算机的能力的OSWorld上。

Claude 3.5 Sonnet 在仅屏幕截图类别中得分为 14.9%,明显优于第二好的人工智能系统 7.8% 的得分。当提供更多步骤来完成任务时,克劳德得分为 22.0%。

Claude 使用电脑的时候还会关掉录制按钮偷懒。

开始偷偷浏览黄石公园的照片

[5]

。

其他信息

照例他们也放出了

新的Claude 3.5系统提示词

[6]

,长的有点离谱。

Kyle Corbitt 六小时就搞了一个

Claude Computer use 的客户端

[7]

。还是开源的,可以直接用它控制你电脑完成任务。

另外,

Claude 现在获得了专门的数据分析工具

[8]

。可以编写和运行 js 代码,基于 Claude 3.5 的能力进行复杂的数学运算和数据分析。

最强开源视频生成模型 Mochi 1 发布

[9]

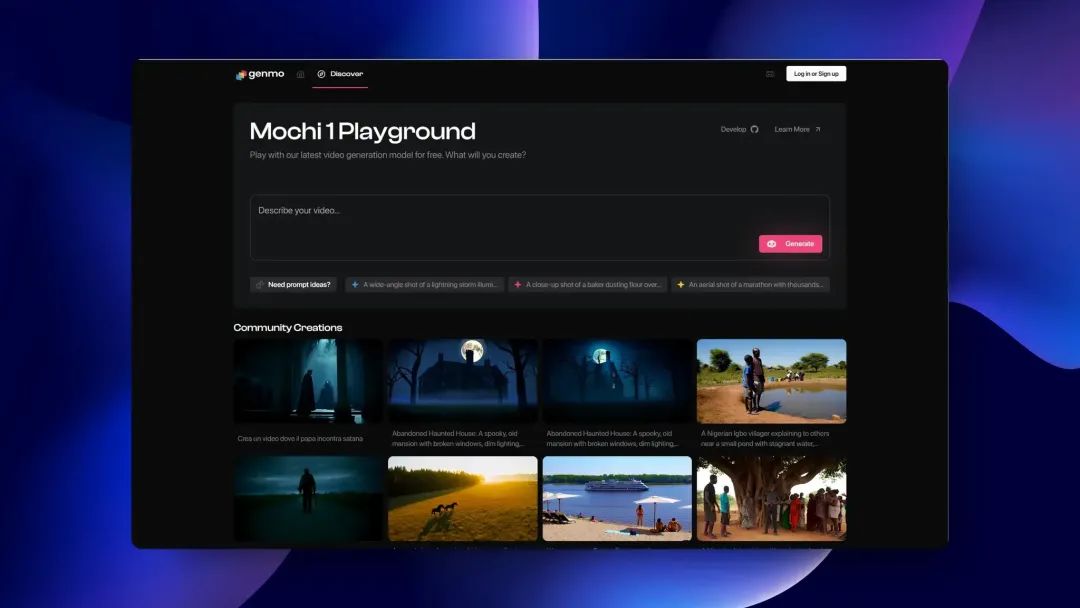

Genmo 开源 Mochi 1 DiT 视频生成模型。同时Genmo 已经完成了一轮由 NEA 领投的总额为 2840 万美元的 A 轮融资。

模型信息

运动质量:Mochi 1 以每秒 30 帧的速度生成平滑的视频,持续时间长达 5.4 秒,具有高时间连贯性和逼真的运动动态。

Mochi 模拟物理学,如流体动力学、毛发模拟,并表现出一致、流畅的人体动作,开始跨越恐怖谷效应。

提示遵从:展示了与文本提示的卓越一致性,确保生成的视频准确反映了给定的指示。这使用户可以详细控制角色、设置和动作。

初始的视频分辨率为 480P,模型参数量为10 B。

模型使用

Mochi 1 模型文件超过 40G,需要 4XH100 才能跑。但是开源社区能人多啊,

kijai 发布新 ComfyUI 插件

[10]

。可以让你用 20G 显存使用现在最强的开源视频生成模型 Mochi 1。

另外你可以在 Genmo 官方的线上使用Mochi 1

[11]

。

SD 3.5模型发布及Comfyui V1版本更新

上周AI图像生态也有比较大的进展,Stability AI 不服输发布了SD3.5系列模型,而且完全开源,只有100万美元以上收入的才需要申请许可。Comfy org成立以后的第一次重大发布也来了,V1版本的Comfyui可以直接已安装包的形式安装,解决了很多新手用户第一步的问题。

SD 3.5模型发布

[12]

Stability AI 直接开源这个系列的三个模型包括:Large 和 Large Turbo,Medium 将于 29 号发布。

模型介绍:

Stable Diffusion 3.5 Large :拥有 80 亿个参数,具有卓越的质量和提示遵从性,是SD系列中最强大的模型。

Stable Diffusion 3.5 Large Turbo :3.5 Large 的精炼版本只需 4 个步骤即可生成高质量图像,并且具有出色的提示附着力。

Stable Diffusion 3.5 Medium :拥有 25 亿个参数,并采用改进的 MMDiT-X 架构和训练方法,它能够生成分辨率在 0.25 到 2 兆像素之间的图像。

官方训练的 ControlNets 也将推出,为各种专业用例提供先进的控制功能。

Comfyui 已经直接支持了SD3.5,你可以

在这里找到相关的模型文件和工作流

[13]

。

SD3.5默认的美学表现可能没有FLUX好,但是强处在于模型本身支持微调,这让模型的上限高了很多。

ComfyUI V1发布

[14]

Comfyui 的主要开源贡献者成立 Comfy org 组织之后,Comfy 的迭代速度在不断加快,0.2 的时候他们完成了 UI 的重构。现在更加重磅的版本上线了,一举解决 Comfy 复杂的部署问题。

发布完整桌面安装包

代码签名和安全:ComfyUI 现在可以打开而不会触发安全警告。

跨平台:适用于 Windows / macOS / Linux