2016年3月9日,韩国首尔的一场棋赛反响空前。此战不仅吸引了全球记者的长枪短炮,也成了人们茶余饭后的谈资。

这不是一场普通的围棋赛事,而是被称为“世纪大战”的人机智慧对决。对弈的一方是人类顶级棋手李世石,另一方则是诞生于英国的人工智能程序——。五盘大战最终以李世石1比4投子认负结束。此役过后,人们记住了这个叫“阿尔法狗”的人工智能,也记住了它背后的“新”技术:强化学习(Reinforcement

Learning)。

AlphaGo:强化学习的空前成功

AlphaGo的出现,让人联想起当年的“深蓝”——1997年,这台IBM超级计算机就曾击败人类国际象棋冠军加里·卡斯帕罗夫。那么,为什么时至今日人工智能界还会为一场棋赛的胜利而大肆狂欢?

这还要从围棋和国际象棋这两种棋说起。20年前,虽然国际象棋程序已能逼平甚至战胜人类冠军,但当时在围棋上尚不及业余棋手。这是因为,对于计算机来说,后者的复杂程度远高于前者:国际象棋的棋盘为8行8列,而围棋盘的纵横则各有19路——361个可供落子的交叉点。也就是说从空间的复杂度来看,国际象棋约为1047,而围棋则高达10170。

复杂度的天壤之别,也意味着“深蓝”的制胜套路无法复制到围棋赛场。当年有人质疑“深蓝”所谓的“智能”,不过是依靠每秒可运算2亿步的“蛮力”,穷举出棋盘的可能性而已。而在围棋中难以测算某些走棋的优劣,即便将“深蓝”所采用的全部优化算法放到如今最高性能的计算设备上,人们也无法将围棋比赛中机器的决策用时修剪到合理的时间内。

那么,AlphaGo究竟是靠什么赢得比赛的呢?

2016年1月,《自然》杂志详细解析了AlphaGo背后的技术:AlphaGo将“价值网络”及“策略网络”结合,并通过人类职业棋手的比赛数据对网络进行监督学习训练。通俗地说,就是先让AlphaGo学会评价棋路的优劣,然后再通过不断与自己对弈进行强化学习,让AlphaGo“参悟”下棋的感觉。而在实际的比赛现场,AlphaGo则根据积累的经验,动态地寻找最优方法,如此才缔造了AlphaGo

最终的“压倒性”胜利。

Mel Bochner泡泡(Babble),2011年计算机和人工智能系统难以理解语言的其中一个原因在于,词语的意思往往与语境甚至字母形态有关系。上图中,几位艺术家展示了如何通过不同的视觉线索来传达文字背后的意义。

强化学习的发展和原理

如果说人工智能的研究发展史是全球一众学者辛勤攻克的马拉松,那么强化学习就是希望实现人工智能的一个技术手段。

听起来工业味十足的人工智能,与心理学等其他社会学科、科学学科都颇有渊源,强化学习因此无法免俗。实际上,现代强化学习的教父理查德·萨顿最早就来自斯坦福大学的心理系。他曾表示,心理学就像是个秘密武器,让他在计算机研究中汲取了无数的灵感。

在心理学实验的基础上,萨顿为强化学习的发展史梳理出了3条主流脉络。

第一条发展线是源自心理学动物实验的“试错”流派。简单来讲,就是通过不断尝试、犯错、再尝试,“偶然”完成目标,然后加强“成功”经验,不断靠近解决方案。

强化学习的第二条发展线主要采用“最优控制”理论及“动态规划”。举个例子,当司机驾驶汽车行驶在翻山越岭的公路上时,在什么时机踩下油门加速、加速多久,都会对最终到达目的地的时长带来影响。在这一过程中,又可能存在诸多限制条件,“最优控制”要做的,就是在限定条件下寻求最优结果。

发展线则是时序差分法。时序差分与过往的经验和状态有关,它根据一些策略对环境进行随机取样学习。时序差分法又汲取了动态规划的精髓,在过去习得的估测结果的基础上,对未来状态进行尽可能的“拟合”。

在20世纪80年代末,这3条分支逐渐汇集一处,形成了现代的强化学习。

总的来说,强化学习是通过与环境交互获得最优解的过程。在强化学习中,机器代理会与环境进行交互,根据当前的环境状态权衡“即时奖励”以及“延迟奖励”,然后采取行动,依此不断地往复、试错,寻找能够最大化累积奖励的策略。最终,获得较高的奖励后,得到这一奖励的过程中的所有行动均会得到加强。

强化学习的应用

强化学习技术该如何落地,在现实生活中找到用武之地,这是人们比较关心的话题。如今的强化学习技术已经迈出了游戏竞技的小赛场,在我们的生活中找到了更多“接地气”的应用场景。

提到机器人,首先映入脑海的可能是电影《星球大战》中外形呆萌人形机器人。但我们都忽略了机器人圈中两个非常重要的成员——自动驾驶汽车和工业机器人。相比那些外形惹眼的拟生机器人,貌不惊人的自动驾驶汽车和工业机械手臂却与我们的生活有着更紧密的联系,它们也正是强化学习技术的主战场。

1.自动驾驶汽车:学会应对复杂的路况

2016

年年末,在巴塞罗那的一次人工智能会议上,播放了一段令人热血沸腾的驾驶模拟视频。在实时计算机模拟的画面上,几辆自动驾驶汽车在一条四车道虚拟高速公路上展开了一场疯狂至极的演习。这几辆车一半在尝试从右侧车道移向中间,而另一半则希望从左侧向中间并线。即便对于人类老司机来说,遇上这样的情况也会乱了阵脚,不过这些自动驾驶汽车却能够在混乱的情况中做到精确控制,成功地完成了这个棘手的任务。

这些自动驾驶汽车的出色表现,来自于反反复复的练习,它们在练习中自己学会了如何流畅、安全地并线。每一次并线成功后,系统都会加强对这些动作的偏好。没错,这里所应用的技术便是强化学习。

强化学习正在越来越多的领域中得到应用。这一方法尤其适合自动驾驶汽车,因为驾驶的过程是一种“良好的决策序列”。未来,宝马和英特尔将合作测试自动驾驶的软件。谷歌、优步等公司也会有研究团队用强化学习的方法训练自动驾驶汽车。

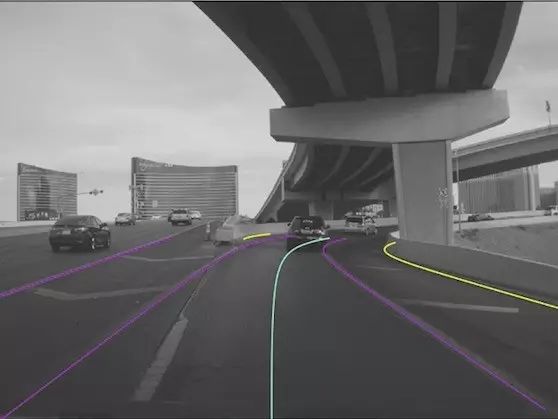

图像来自Mobileye的强化学习汽车的视觉系统

图像来自Mobileye的强化学习汽车的视觉系统

2.智能工业机器人:机械臂被装上了“大脑”

20世纪50年代,美国人乔治 · 戴沃尔提出了工业机器人的概念并申请专利。后来这些机械手臂得到了长足进步。它们的出现大幅提升了工厂的自动化程度,并降低了人力成本,已经被大量采用。但对于机械手臂,即便是抓起物品这样看似简单的小动作,往往也需要程序员投入大量的时间,反复修改、实验。当工厂的生产任务发生改变时,修改、调整机械手臂的预设程序的成本也同样不容小觑。

不过随着强化学习技术的到来,这些隐藏在“无人”工厂背后的程序员的工作负荷也可以被大幅降低。

2015年年底的东京国际机器人展览会上,出现了一种新型智能机械臂。只需给这些工业机器人布置简单的小任务(如从盒中挑拣物品等),然后等上一晚的时间,第二天清晨它就基本可以“摸索”出一套自己的解决方案。令人惊奇的是,它的背后并没有强大的专家系统,也没有一群加班熬夜、精通机械的程序员。这些新型工业机器人正是通过深度强化学习技术训练自己学会执行新的任务。拣拾物品的过程,这些机械手臂会录制视频,每次拣拾完成,根据效果它们会得到不同的奖励值,这些知识不断积累,强化那些更接近最终目标的动作(如拾起物品)也得到了强化。在深度强化学习的帮助下,这些工业机器人仿佛拥有了属于自己的“大脑”。

3.互联网营销及推广

网络营销与推广,是强化学习的另一个舞台。搜索引擎广告常采用竞价排名机制,广告主需要购置关键字并根据点击等进行付费。由于广告界的竞争,整个广告环境的竞争状况构成一个复杂网络。广告竞价也变得复杂起来。

强化学习技术正好可以满足广告竞价的需求。为了实现更高投资回报率,强化学习根据当前的各种环境状态,来训练对应的神经网络,最终通过比对,求得最优的结果。

借助强化学习所建立的模型,所有状态都可以被反映出来,并能根据实时数据、状态做出对应的预测和调整。这一点与自动驾驶汽车有异曲同工之妙。

逃不出的“维数诅咒”

强化学习虽然已经有了一些成功的案例,但是这一方法也遇到了一定的阻力。

这些阻力中,最严重的当属

“维数灾难”。在现实世界中,走出了实验室的机器人需要面对更多的未知情况,因此在进行强化学习的过程中就要将几十甚至上百个变量纳入考虑,这会导致问题的困难程度呈指数级增长。

《科技之巅2》

作者:麻省理工科技评论

版本:人民邮电出版社 2017年6月

另外一个问题则是机器人制造及维修的成本。强化学习的本质是不断试错的过程,因此在机器人进行实践的过程中,很有可能在训练中受损甚至报废;即便设备还能继续使用,也有可能因为损伤而影响训练中策略的准确性。

现在,强化学习的研究人员们仍然在努力探索、找寻那些能够让强化学习应用于复杂场景的方法。也许在2017年的晚些时候,在你身边的某一条高速公路上,强化学习会经历诞生以来最戏剧性也是最重要的测试。

知道了人工智能的工作原理,是不是更想亲自体验一下TA的威力?今日头条的内容可以让你一试身手,让你猜猜,哪首诗是机器人小冰写的,哪首是著名诗人写的。扫下方海报二维码,即刻开始哦~