数据挖掘入门与实战 公众号: datadw

最近在看数据分析的书籍,想着自己分析一点东西来,本人比较喜欢NBA,自然就先拿NBA作为分析的对象了,首先要获得最全的NBA数据,根据搜索的结果对比发现,stat-nba.com该网站的数据非常全面详细,真是业界良心。

数据源找到后第一件事情自然就是获取数据,这里用python的原生代码直接爬取的,个人觉的,beautifulSoup还是比较好的,只是一开始没有用,也就后来没用了,废话少叙,直接上代码。

本文代码可以通过回复公众号“NBA”获取。

#coding=utf-8

import urllib

import re

import csv

import sys

#计数,初始化

count = 0

#以下定义的与之对应的是球员姓名、赛季、胜负、比赛、首发、时间、投篮命中率、投篮命中数、投篮出手数、三分命中率、三分命中数、三分出手数、罚球命中率、罚球命中数、罚球次数、总篮板数、前场篮板数、后场篮板数、助攻数、抢断数、盖帽数、失误数、犯规数、得分

list0 = []

list1 = []

list2 = []

list3 = []

list4 = []

list5 = []

list6 = []

list7 = []

list8 = []

list9 = []

list10 = []

list11 = []

list12 = []

list13 = []

list14 = []

list15 = []

list16 = []

list17 = []

list18 = []

list19 = []

list20 = []

list21 = []

list22 = []

list23 = []

list24 = []

list25 = []

list26 = []

#定义获取页面函数

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

#获取数据并存入数据库中

for k in range(0,51):

#获取当前页面,该页面只有LBJ的职业生涯常规赛的数据,截止到2016.12.26

html = getHtml(

"http://www.stat-nba.com/query.php?QueryType=game&GameType=season&Player_id=1862&crtcol=season&order=1&page=" + str(

k))

# 获取球员姓名、赛季、胜负、比赛、首发、时间、投篮命中率、投篮命中数、投篮出手数、三分命中率、三分命中数、三分出手数、罚球命中率、罚球命中数、罚球次数、总篮板数、前场篮板数、后场篮板数、助攻数、抢断数、盖帽数、失误数、犯规数、得分

#正则得到相对应的数值

playerdata = re.findall(r'

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(\D*|76人)(\d+)-(\d+)(\D*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*%|\s*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*%|\s*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*%|\s*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | '

r'\s*

(.*) | ', html)

#获取每条数据,

for data in playerdata:

#将元组数据复制给列表,进行修改,数据中有空值,和含有%号的值,进行处理,得到数值

data1 = [data[0], data[1], data[2], data[3], int(data[4]), data[5], data[6], data[7], data[8], data[9],

data[10], data[11], data[12], data[13], data[14], data[15], data[16], data[17], data[18], data[19],

data[20], data[21], data[22], data[23], data[24], data[25], data[26]]

#将百分号去掉,只保留数值部分

if (data1[15] == ' '):

data1[15] = 0

else:

data1[15] = float("".join(re.findall(r'(.*)%', data1[15])))

if (data1[9] == ' '):

data1[9] = 0

else:

data1[9] = float("".join(re.findall(r'(.*)%', data1[9])))

if (data1[12] == ' '):

data1[12] = 0

else:

data1[12] = float("".join(re.findall(r'(.*)%', data1[12])))

list0.append(data1[0])

list1.append(data1[1])

list2.append(data1[2])

list3.append(data1[3])

list4.append(data1[4])

list5.append(data1[5])

list6.append(data1[6])

list7.append(data1[7])

list8.append(data1[8])

list9.append(data1[9])

list10.append(data1[10])

list11.append(data1[11])

list12.append(data1[12])

list13.append(data1[13])

list14.append(data1[14])

list15.append(data1[15])

list16.append(data1[16])

list17.append(data1[17])

list18.append(data1[18])

list19.append(data1[19])

list20.append(data1[20])

list21.append(data1[21])

list22.append(data1[22])

list23.append(data1[23])

list24.append(data1[24])

list25.append(data1[25])

list26.append(data1[26])

# 记录数据数量

count += 1

#建立csv存储文件,wb写 a+追加模式

csvfile = file('nbadata.csv', 'ab+')

writer = csv.writer(csvfile)

#将提取的数据合并

data2 = []

for i in range(0,count):

data2.append((list0[i],list1[i],list2[i],list3[i],list4[i],list5[i],list6[i],list7[i],list8[i]

,list9[i],list10[i],list11[i],list12[i],list13[i],list14[i],list15[i],list16[i]

,list17[i],list18[i],list19[i],list20[i],list21[i],list22[i],list23[i],list24[i]

, list25[i],list26[i]))

#将合并的数据存入csv

writer.writerows(data2)

csvfile.close()

经过爬取数据后得到了nbadata.csv文件,数据到手,下面就是分析了。

数据分析及可视化

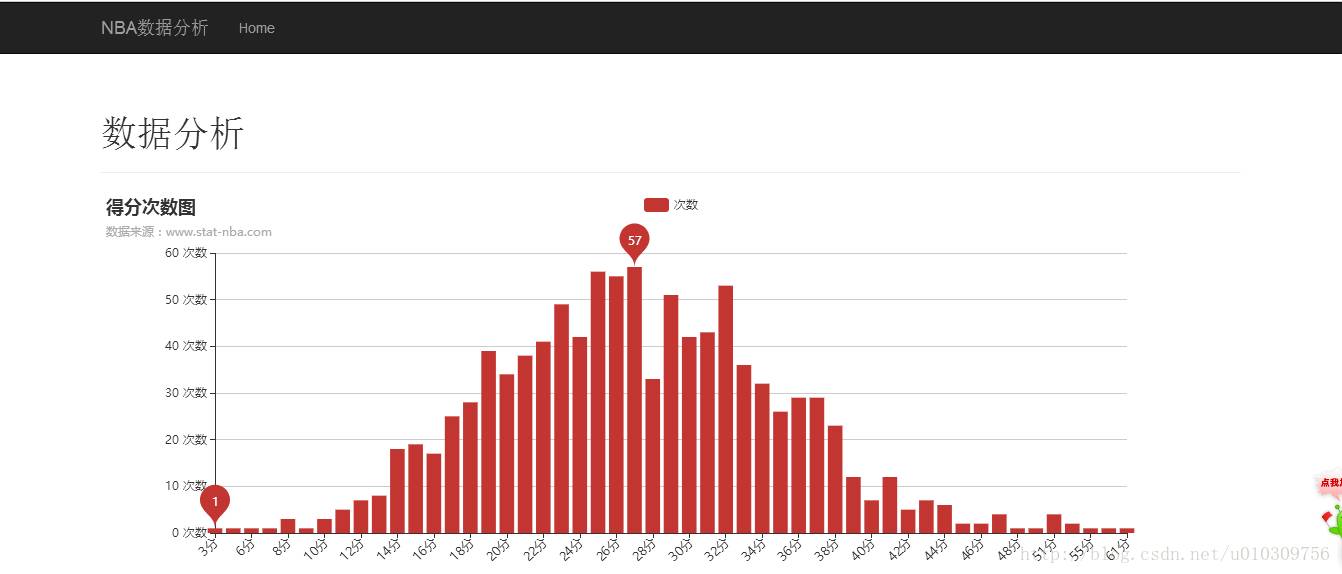

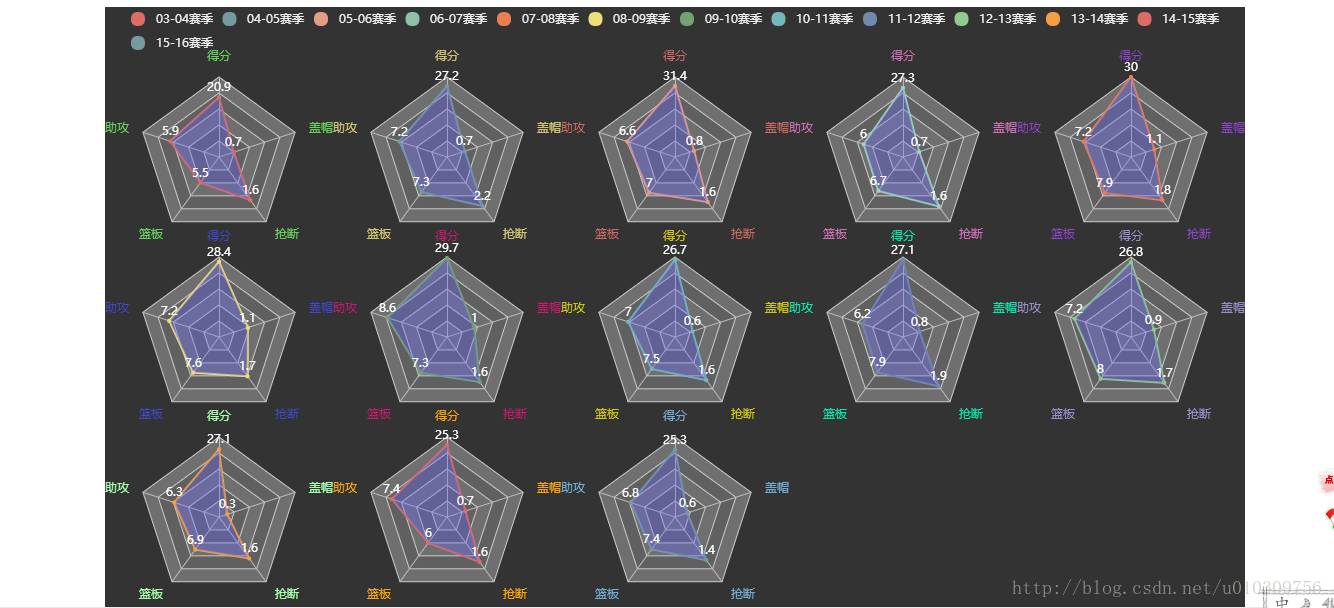

这里只是简单的对LBJ职业生涯常规赛数据进行了分析,时间有限,就做了两个分析,一个是对常规赛的得分相同的次数进行统计。得出每个的分段的得分总次数;另一个是对过去13个赛季的五项能力(包括得分、篮板、助攻、盖帽、抢断)进行分析得出13个能力值图。

可视化部分应用的是flask框架搭建的web网站,前端用百度echart.js进行图像的搭建。

#coding:utf-8

import sys

reload(sys)

sys.setdefaultencoding("utf-8")

from flask import Flask,render_template

from flask_bootstrap import Bootstrap

from pandas import DataFrame,Series

import pandas as pd

import numpy as np

import csv

#文件路径

srcFilePath = "c:/myflask/nbadata.csv"

#读取cvs格式的数据文件

reader = csv.reader(file(srcFilePath,'rb'))

#csv中各列属性代表的含义(1)代表第一列

# 球员姓名(1)、赛季(2)、胜负(3)、对手球队名称(4)、对手球队总得分(5)、己方球队总得分(6)

# 、己方球队名称(7)、首发(8)【1为首发,0为替补】、上场时间(9)、投篮命中率(10)、投篮命中数(11)

# 、投篮出手数(12)、三分命中率(13)、三分命中数(14)、三分出手数(15)、罚球命中率(16)

# 、罚球命中数(17)、罚球次数(18)、总篮板数(19)、前场篮板数(20)、后场篮板数(21)、助攻数(22)

# 、抢断数(23)、盖帽数(24)、失误数(25)、犯规数(26)、得分(27)

records = [line for line in reader]

frame = DataFrame(records)

#获取得分数对应的场次数目

pts_count = frame[26].value_counts()

a = []

b = []

for i in pts_count.keys():

a.append(i)

for i in pts_count:

b.append(i)

c = {}

for i in range(0,len(a)):

c[int(a[i])] = int(b[i])

d = sorted(c.items(), key=lambda c:c[0])

#存储得分分数

e = []

#存储相应分数的次数

f = []

for i in d:

e.append(i[0])

f.append(i[1])

#15-16赛季球员得分助攻篮板抢断盖帽平均值

records_p1 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '03-04']

records_p2 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '04-05']

records_p3 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '05-06']

records_p4 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '06-07']

records_p5 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '07-08']

records_p6 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '08-09']

records_p7 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '09-10']

records_p8 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '10-11']

records_p9 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '11-12']

records_p10 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '12-13']

records_p11 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '13-14']

records_p12 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '14-15']

records_p13 = [(int(line[26]),int(line[21]),int(line[18]),int(line[22]),int(line[23])) for line in records if line[1] == '15-16']

g1 = [float('%0.1f' % i) for i in DataFrame(records_p1).mean()]

g2 = [float('%0.1f' % i) for i in DataFrame(records_p2).mean()]

g3 = [float('%0.1f' % i) for i in DataFrame(records_p3).mean()]

g4 = [float('%0.1f' % i) for i in DataFrame(records_p4).mean()]

g5 = [float('%0.1f' % i) for i in DataFrame(records_p5).mean()]

g6 = [float('%0.1f' % i) for i in DataFrame(records_p6).mean()]

g7 = [float('%0.1f' % i) for i in DataFrame(records_p7).mean()]

g8 = [float('%0.1f' % i) for i in DataFrame(records_p8).mean()]

g9 = [float('%0.1f' % i) for i in DataFrame(records_p9).mean()]

g10 = [float('%0.1f' % i) for i in DataFrame(records_p10).mean()]

g11 = [float('%0.1f' % i) for i in DataFrame(records_p11).mean()]

g12 = [float('%0.1f' % i) for i in DataFrame(records_p12).mean()]

g13 = [float('%0.1f' % i) for i in DataFrame(records_p13).mean()]

app = Flask(__name__)

#引入bootstrap前端框架

bootstrap = Bootstrap(app)

@app.route('/')

def hello_world():

return render_template('index.html', a=e, b=f, c1=g1,c2=g2,c3=g3,c4=g4,c5=g5,c6=g6,c7=g7,c8=g8,c9=g9,c10=g10,c11=g11,c12=g12,c13=g13)

if __name__ == '__main__':

app.run(debug=True)

显示效果:

分类作为一种监督学习方法,要求必须事先明确知道各个类别的信息,并且断言所有待分类项都有一个类别与之对应。但是很多时候上述条件得不到满足,尤其是在处理海量数据的时候,如果通过预处理使得数据满足分类算法的要求,则代价非常大,这时候可以考虑使用聚类算法。

聚类属于无监督学习,相比于分类,聚类不依赖预定义的类和类标号的训练实例。本文首先介绍聚类的基础——距离与相异度,然后介绍一种常见的聚类算法——k-means算法,并利用k-means算法分析NBA近四年球队实力。因为本人比较喜欢观看NBA比赛,所以用这个当做例子了,通过这个例子大家可以用到各种实际的生活和生产环境中。

在正式讨论聚类前,我们要先弄清楚一个问题:如何定量计算两个可比较元素间的相异度。

用通俗的话说,相异度就是两个东西差别有多大,例如人类与章鱼的相异度明显大于人类与黑猩猩的相异度,这是能我们直观感受到的。但是,计算机没有这种直观感受能力,我们必须对相异度在数学上进行定量定义。设

其中X,Y是两个元素项,各自具有n个可度量特征属性,那么X和Y的相异度定义为:

其中R为实数域。也就是说相异度是两个元素对实数域的一个映射,所映射的实数定量表示两个元素的相异度。下面介绍不同类型变量相异度计算方法:

1.标量

标量也就是无方向意义的数字,也叫标度变量。现在先考虑元素的所有特征属性都是标量的情况。例如,计算X={2,1,102}和Y={1,3,2}的相异度。一种很自然的想法是用两者的欧几里得距离来作为相异度,欧几里得距离的定义如下:

其意义就是两个元素在欧氏空间中的集合距离,因为其直观易懂且可解释性强,被广泛用于标识两个标量元素的相异度。将上面两个示例数据代入公式,可得两者的欧氏距离为:

除欧氏距离外,常用作度量标量相异度的还有曼哈顿距离和闵可夫斯基距离,两者定义如下:

曼哈顿距离:

闵可夫斯基距离:

欧氏距离和曼哈顿距离可以看做是闵可夫斯基距离在p=2和p=1下的特例。另外这三种距离都可以加权,这个很容易理解,不再赘述。

下面要说一下标量的规格化问题。上面这样计算相异度的方式有一点问题,就是取值范围大的属性对距离的影响高于取值范围小的属性。例如上述例子中第三个属性的取值跨度远大于前两个,这样不利于真实反映真实的相异度,为了解决这个问题,一般要对属性值进行规格化。所谓规格化就是将各个属性值按比例映射到相同的取值区间,这样是为了平衡各个属性对距离的影响。通常将各个属性均映射到[0,1]区间,映射公式为:

其中max(ai)和min(ai)表示所有元素项中第i个属性的最大值和最小值。例如,将示例中的元素规格化到[0,1]区间后,就变成了X’={1,0,1},Y’={0,1,0},重新计算欧氏距离约为1.732。

2.二次变量

所谓二元变量是只能取0和1两种值变量,有点类似布尔值,通常用来标识是或不是这种二值属性。对于二元变量,上一节提到的距离不能很好标识其相异度,我们需要一种更适合的标识。一种常用的方法是用元素相同序位同值属性的比例来标识其相异度。

设有X={1,0,0,0,1,0,1,1},Y={0,0,0,1,1,1,1,1},可以看到,两个元素第2、3、5、7和8个属性取值相同,而第1、4和6个取值不同,那么相异度可以标识为3/8=0.375。一般的,对于二元变量,相异度可用“取值不同的同位属性数/单个元素的属性位数”标识。

上面所说的相异度应该叫做对称二元相异度。现实中还有一种情况,就是我们只关心两者都取1的情况,而认为两者都取0的属性并不意味着两者更相似。例如在根据病情对病人聚类时,如果两个人都患有肺癌,我们认为两个人增强了相似度,但如果两个人都没患肺癌,并不觉得这加强了两人的相似性,在这种情况下,改用“取值不同的同位属性数/(单个元素的属性位数-同取0的位数)”来标识相异度,这叫做非对称二元相异度。如果用1减去非对称二元相异度,则得到非对称二元相似度,也叫Jaccard系数,是一个非常重要的概念。

3.分类变量

分类变量是二元变量的推广,类似于程序中的枚举变量,但各个值没有数字或序数意义,如颜色、民族等等,对于分类变量,用“取值不同的同位属性数/单个元素的全部属性数”来标识其相异度。

4.序数变量

序数变量是具有序数意义的分类变量,通常可以按照一定顺序意义排列,如冠军、亚军和季军。对于序数变量,一般为每个值分配一个数,叫做这个值的秩,然后以秩代替原值当做标量属性计算相异度。

5.向量

对于向量,由于它不仅有大小而且有方向,所以闵可夫斯基距离不是度量其相异度的好办法,一种流行的做法是用两个向量的余弦度量,其度量公式为:

其中||X||表示X的欧几里得范数。要注意,余弦度量度量的不是两者的相异度,而是相似度!

讨论完相异度,我们可以正式定义聚类问题,所谓聚类问题,就是给定一个元素集合D,其中每个元素具有n个可观察属性,使用某种算法将D划分成k个子集,要求每个子集内部的元素之间相异度尽可能低,而不同子集的元素相异度尽可能高。其中每个子集叫做一个簇。与分类不同,分类是示例式学习,要求分类前明确各个类别,并断言每个元素映射到一个类别,而聚类是观察式学习,在聚类前可以不知道类别甚至不给定类别数量,是无监督学习的一种。目前聚类广泛应用于统计学、生物学、数据库技术和市场营销等领域,相应的算法也非常的多。本文仅介绍一种最简单的聚类算法——k均值(k-means)算法。

本文代码可以通过回复公众号“NBA”获取。

我们先弄清楚 k-means 的计算过程:

1. 从集合 D 中随机选取 k 个元素,作为 k 个簇的各自的中心;

2. 分别计算剩下的元素到 k 个簇中心的相异度,将这些元素分别划归到相异度最低的簇;

3. 根据聚类结果,重新计算 k 个簇各自的中心,计算方法是取簇中所有的元素各自维度的算术平均数;

4. 将 D 中全部元素按照新的中心重新聚类;

5. 重复第 4 步,直到聚类结果不再变化;

6. 将结果输出。

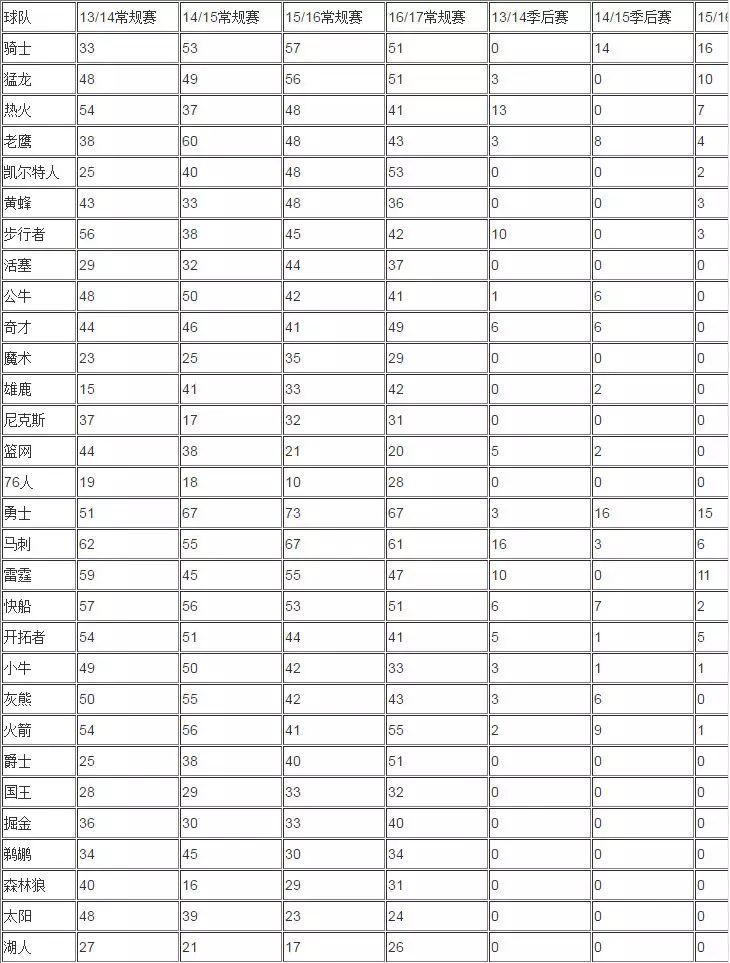

下面列表是 NBA 近四年的常规赛和季后赛战绩(因为16/17季后赛还没打完,所以该数据暂不收录):

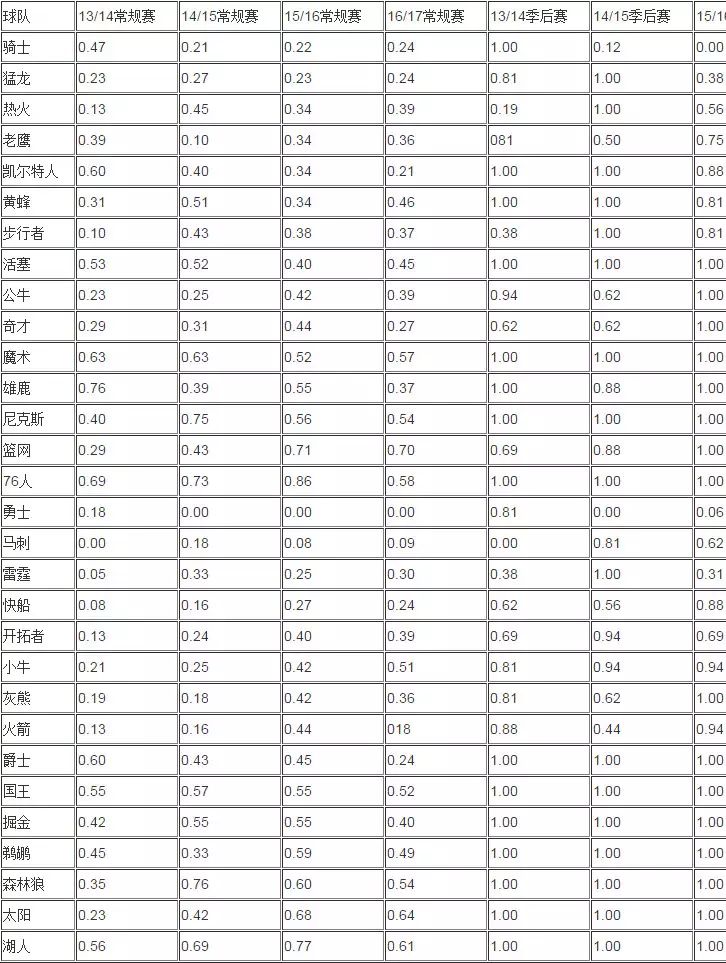

下面对数据进行 [0,1] 规范化,下面是规范化后的数据:

接着用 k-means 算法进行聚类,设k = 5,即将30支球队分成5个集团。现抽取勇士、快船、掘金、国王、76人的值作为五个簇的种子,即初始化五个簇的中心为:A{0.18,0.00,0.00,0.00,0.81,0.00,0.06},B{0.08,0.16,0.27,0.24,0.62,0.56,0.88},C{0.42,0.55,0.55,0.40,1.00,1.00,1.00},D{0.55,0.57,0.55,0.52,1.00,1.00,1.00},E{0.69,0.73,0.86,0.58,1.00,1.00,1.00},下面分别计算所有球队分别对五个中心点的相异度,这里以欧几里得距离作为相异度,以下为我求得的结果:

从聚类得到结果可以看出,近四年实力最强的球队为骑士和勇士队,或者很多球迷会有其他的意见,但至少从数据层面来讲,骑士和勇士队是近四年实力最强的球队,为第一集团;接下来的球队基本上为每年必进季后赛的球队,包括马刺、雷霆、快船、公牛等球队,为第二集团;第三集团则凯尔特人、黄蜂、小牛等着偶尔进入季后赛的球队;接下来就是基本无缘季后赛和每年基本垫底的第四集团和第五集团了。

本文只是讲述关于聚类小案例的应用,其实聚类有着非常广泛的应用,包括图像分割,生物种群分类,其实早期移动公司也是根据聚类推出适合不同人群使用的电话卡(动感地带、全球通、神州行等)。

本文代码可以通过回复公众号“NBA”获取。

数据挖掘入门与实战

搜索添加微信公众号:datadw

教你机器学习,教你数据挖掘

长按图片,识别二维码,点关注

公众号: weic2c

据分析入门与实战

长按图片,识别二维码,点关注