分享来源:知乎

分享来源:知乎

平时对苹果的摄像功能总是表示淡定,因为底大一级压死人,无论怎么吹捧,它能做的,相机都能做得更好。

但今天无意瞄到iPhoneX的新特性Portrait lighting时,我心脏骤然停了一瞬——我仿佛听到它用一种颇具说服力的姿态告诉我们:

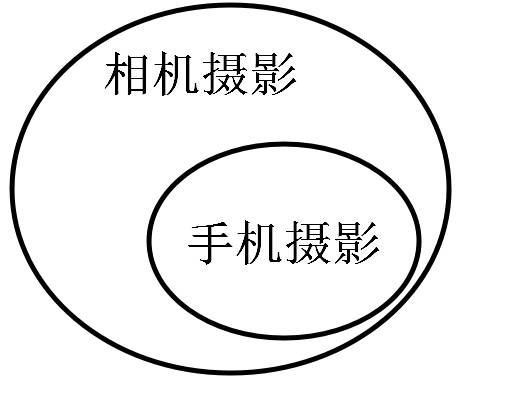

手机的摄像头不再是相机的附庸:从前,它能的,相机一定更好。而现在,它能的,相机几乎不能。

此后在拍照同时,手机将前所未有地记录人脸的精细三维结构,因此新iPhone不再像过去那样只是比较方便而已,至少在自拍方面,它是一个真·摄影棚。

原因一言以蔽之:多了一个维度的信息,产生高维碾压。

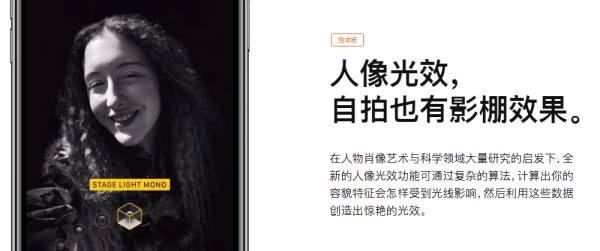

Portrait lighting中文名叫

“人像光效”

,听起来就像美图秀秀里的”一键美白“:

若真当它是美图秀秀或者某种滤镜,你根本无法意识到它会产生多大的威力。它目前还是beta版,我今天说的,是它四五年后的一点小小可能。

本文谈的,是它新硬件带来的未来。

它的作用是给你打光,假装你处在不同布光的环境下,比如摄影棚、舞台灯。

光永远是最重要的,

这前所未有的效果让美图一众在它面前都成了名副其实的垃圾。

因为它结合了面部结构信息。

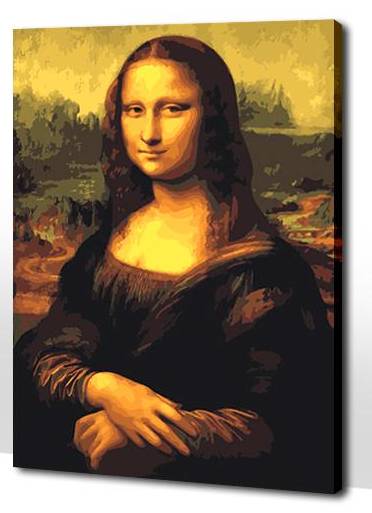

在未来,你完全可以随意拍摄一张自拍,然后拖出“经典三盏灯”,把自己照得跟蒙娜丽莎一样古典,发给男神:

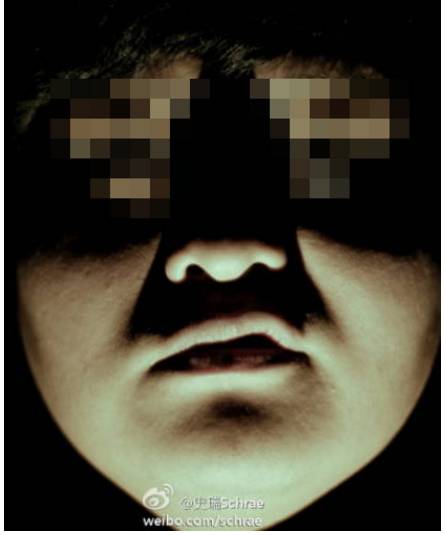

然后转头换出一盏底灯,发给胆小的闺蜜。

在未来,你修自拍时,首先做的不是瘦脸磨皮,而是仔仔细细调节手机里虚拟灯光的参数,免得被人说不专业。

利用它,网红还能在直播中由手机自动后期,效果极其自然,再也不怕见光死。

至于画质?

对自拍狂而言,光线好的叫画质,不好的叫贴图。

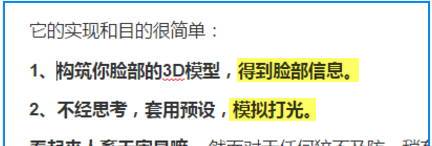

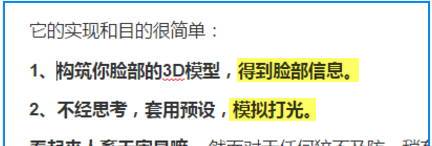

回到Portrait lighting,它的实现原理特别明确,

它产生区分度的核心在构筑脸部3D模型。

1、构筑你脸部的3D模型,得到脸部信息。

2、套用预设,模拟打光。

基于此,光线的模拟对自拍的提升几乎是工业革命般的,甚至能将近景的广角人像提升到专业摄影都不一定望其项背的程度。

对于任何

猝不及防

的“人像摄影师”而言,都必会震撼于这个新生儿前途无限的未来。而如果他们还能联想到一点

人工智能的伟力

,他们一定会肃穆,敬畏,乃至恐惧。

一、

不知者无畏,若想一窥摄影师这种恐惧,需要从棚拍这件事情说起。

棚拍是自拍的极致

——灯光师给你布置最佳的光源,去掉干扰物,构成不再业余的照片。

棚拍和日常拍

无非光线

的区别而已。对人像而言,摄影棚下的光线都是为了更强地塑造模特的面容而存在的,

与日常唯一的不同在于

,

它的每一根光线都是带着目的

,

你的下巴会更瘦削,鼻梁会更加高耸,双颊细腻的影子有着迷人的过渡。

拍摄后,在后期处理中调整不够整齐的光线:

美丑之间只是光线的区别而已,

这些对光线的改动形成了调整层,让图片看起来更加均匀,可以灰色图片的形式记录:(灰色对应无改、深色对应变暗、亮色的部位变亮↓)

这个增减光线的过程

非常耗费时间

——甚至可能持续24个小时。

还需修图师对妆面和灯光效果能充分理解。

在后期工作时,你必会需要弥补人脸的种种不足——比如下图,为了弥补姑娘过宽的面颊,将箭头处光线减弱,营造出影子(此处并非液化)。

(图片仅作案例,转载请打钱。 @三月你不语 )

后期整理结束,摄影师的主干工作就算完成了。

二、摄影师的作用

我们再一琢磨,哟,这个给我拍照的师傅最大的功能无非就是排个光罢嘛:

——前期摆灯看起来高大上,目的是为了脸上的光;

——后面PS看起来费力,目的还是为了脸上的光。

比如上图脸颊的宽度,模特的皮肤的整齐度,

实际上仅仅是光线的区别

——过暗的地方如唇部要补光,过亮的地方减光。

既然只需增减,为何不能让电脑一步调整到位呢?

因为电脑只看到你的平面图——

它不知道你鼻子多高眼睛多深,自然也不知道该怎么给你打光。如果它看到的是立体的,自然就知道了。

现在,新iPhone就知道了

。

我们会发现,摄影师除了打出“

真实灯光”和“审美思考"之外,剩下的工作已经可以被手机接管了。

手机终于知道你的眉眼多深,自然能帮你完成大体的调整工作。

这种因为智能产生的接管,

在我看来正是传统摄影和手机自拍之间真正开始产生区分度的地方。

专业拍脸的核心流程无非如此:

1、肉眼识别,得到脸部信息(深浅)。

2、经过师傅的思考,用灯光打光,再用PS对瑕疵模拟打光。

将其与Portrait lighting的流程进行一番比较,会发现流程核心一致:

——过往无论”柔光双摄“还是”美颜神器“,无非是后期流程的粗糙归纳。

传统自拍中,因为计算机无法感知立体信息,精细活需要手工处理。而现在计算机感知到了,便自然地将计算机澎湃的生产力正式引入手动工序——这正是工业革命。

这样的改变对整个手机的影响仅次于电容屏的出现,本文仅谈论自和摄影层面:

手机现在能干相机不能干的事情了。

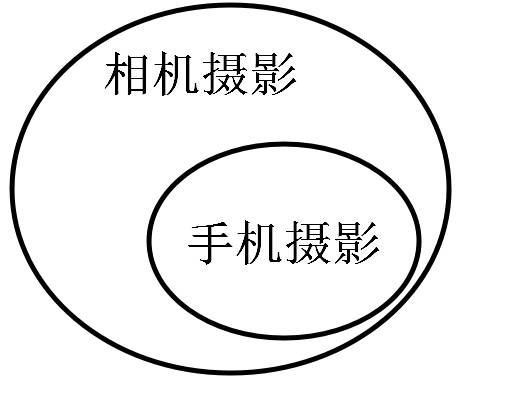

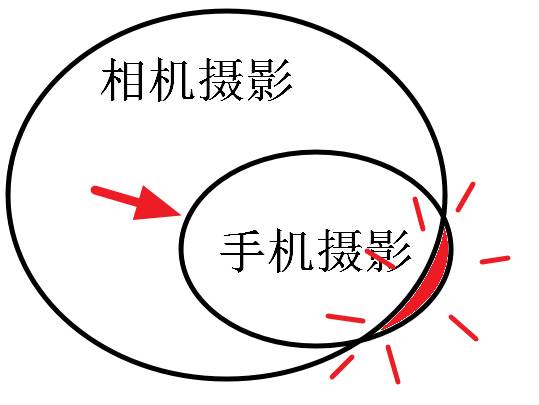

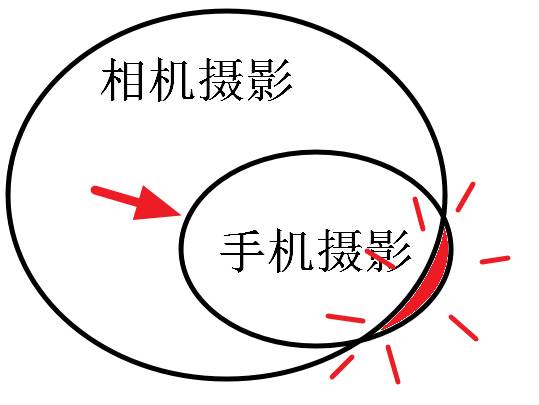

如果过往手机摄影和相机摄影的关系是这样的话:

那么今晚的iPhone,成功地将他们之间的关系稍微移动了一点点。

然而这样的一点是多么颠覆,多么具有开创性,是突破了

”手机能干的事情小相机也能干

“的魔咒的一点。

现在新的传感器已经能直接获得脸部的立体造型了,便能粗糙取代修图师手动的加深减淡,

我们要做的,就是调整自己喜欢的光线,

无论美食还是微距还是自拍,我们都能像拿手电筒打光那么简单地照射出好的效果!!

理论上,我们能想象到的任何光线,都能在iPhone上转眼得到实现!

三、

当然,有人肯定嗤之以鼻,会认为前期布光是无法代替的。

然而前期布光当然可以代替啊,

不然3D动画怎么来的

?只是精度问题罢了。

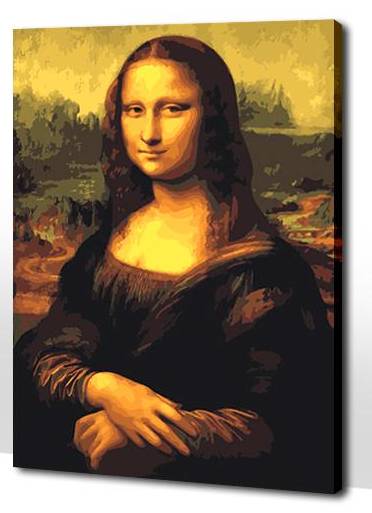

举个例子,如果我把下图这张jpg发给修图师,为了提升此时的光影,对方需要用PS一点点修饰明暗。

但如果由我发了原3D文件给他,他只调整模拟灯光的位置,便能得到远超之前修图师的理想的效果。这就是布光可被取代理由,有深度信息,就可以计算。

(上图并

非实拍

)

它就像像一个在灯光和光影之间的函数,代入左边,就能得到右边。

综上,新的iPhone却在自拍时保存了三维的”模型“信息,那么只要IOS允许,自然就能随意打光。而且远比人工来得自然。

(←此处留个喷点)

一次不太成功的人肉补光

四

、

硬件基础

新的机器并非双摄那种简单的深度感知,而是精细的结构光和点投影。

左侧红外结构光,获取相位信息,右侧点投影,获取更加精细的信息。

过往双摄的概念出来时,更大的意义还是通过双CMOS得到5倍的进光量,从而提升信噪比,而非3d的深度感知。

因为双摄这个结构本身就不够精确。以环境感知独步天下的大疆为例,目前凭双摄也只能在10米距离上分辨

1m

的阻碍,*而苹果的点投影

如果能

投上10m,60°的视角下,它能分辨出

0.06m

的障碍*

(仅以点数和60°视角估算)。

这种精度,相当于对你的皮肤都有了一次比人眼还密集的立体结构普查,能精确到每一块肌肉。