探索 9 个开源项目,它们正在改变 AI 的未来,从强大的 AI 助手和 LLM 推理框架到训练后 Transformer 模型和 PDF 转换工具。

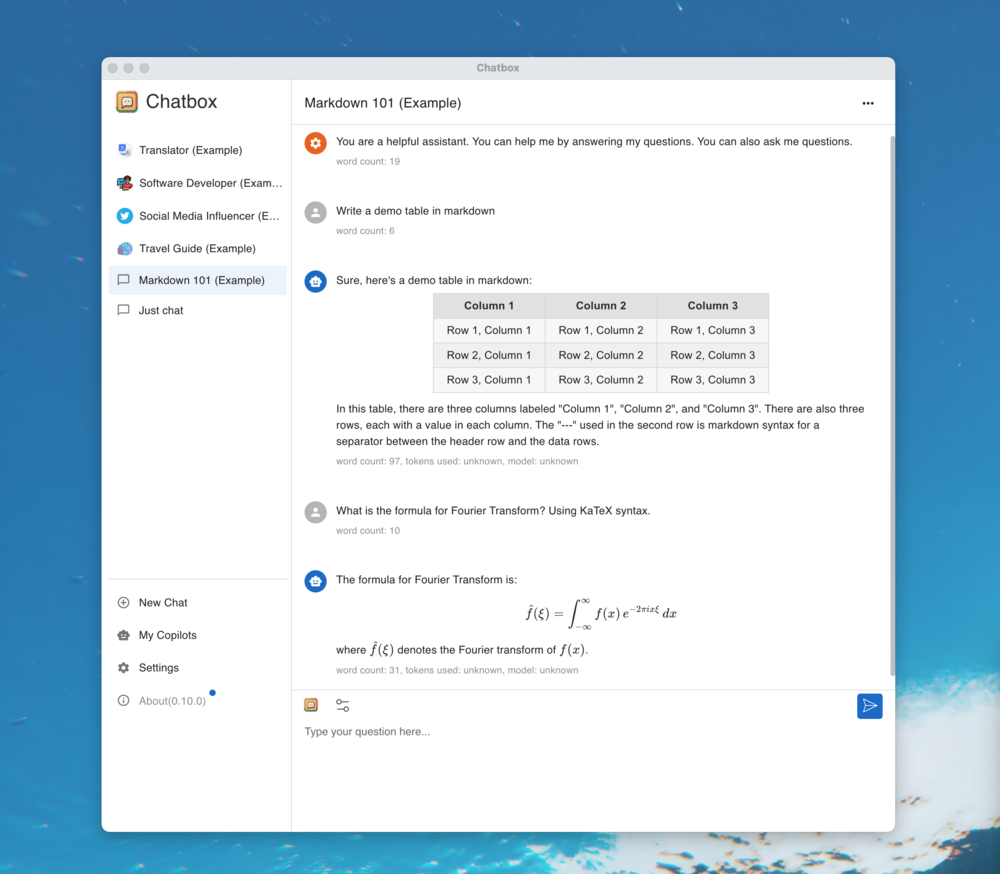

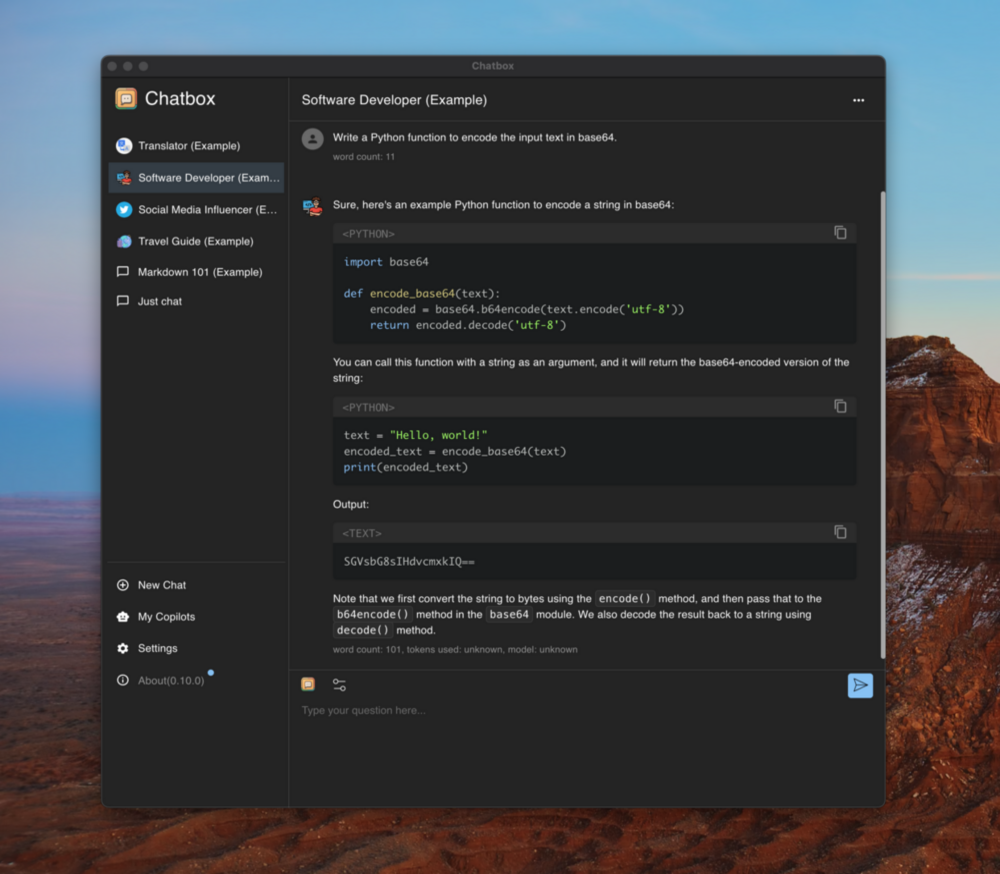

1.Chatbox:AI 桌面助手

🏷️仓库名称:

Bin-Huang/chatbox

🌟截止发稿星数:

26263

(近一周新增:1130)

🇨🇳仓库语言:

TypeScript

🤝仓库开源协议:

GNU General Public License v3.0

🔗仓库地址:

https://github.com/Bin-Huang/chatbox

引言

了解 Chatbox,这是一款功能强大的 AI 桌面应用程序,可以释放人工智能的强大功能。

结论

Chatbox 是释放 AI 潜力的必备工具。它为 AI 模型提供了无缝的访问,使其成为各种任务的理想助手,从代码开发到内容创作,甚至更具创造性的事业。

2.llama.cpp:深入剖析 LLM 推理框架

🏷️仓库名称:

ggerganov/llama.cpp

🌟截止发稿星数:

72016

(近一周新增:783)

🇨🇳仓库语言:

C++

🤝仓库开源协议:

MIT License

🔗仓库地址:

https://github.com/ggerganov/llama.cpp

引言

本文旨在对 GitHub 仓库 llama.cpp 进行深入分析,重点介绍其作用、技术解析、使用方法和相关案例。

项目作用

llama.cpp 拥有以下技术特性:

-

纯 C/C++ 实现,无任何依赖项

-

为 Apple 硅设备进行了优化,采用 ARM NEON、Accelerate 和 Metal 框架

-

支持 x86 架构的 AVX、AVX2、AVX512 和 AMX 指令集

-

提供 1.5 位、2 位、3 位、4 位、5 位、6 位和 8 位整型量化,以加快推断速度并减少内存使用

-

针对 NVIDIA GPU 提供了自定义 CUDA 内核,并支持 AMD GPU(通过 HIP)和 Moore Threads MTT GPU(通过 MUSA)

-

支持 Vulkan 和 SYCL 后端

-

支持 CPU+GPU 混合推理,以局部加速模型,其大小超过了总 VRAM 容量

仓库描述

llama.cpp 项目是开发 ggml 库新功能的主要试验场。

案例

llama.cpp 支持各种 LLM 模型,包括 LLaMA 🦙、LLaMA 2 🦙🦙、LLaMA 3 🦙🦙🦙、Mistral 7B、Mixtral MoE、DBRX、Falcon、Vigogne 等。

客观评测或分析

llama.cpp 凭借其跨平台支持、高性能和易于使用的优势,成为 LLM 推断开发人员的首选工具。

使用建议

结论

llama.cpp 是一个功能强大且易于使用的 LLM 推断框架,为开发人员提供了在各种硬件上实现先进 LLM 性能所需的工具和资源。

3.Bun:适用于 JavaScript 和 TypeScript 的工具集

🏷️仓库名称:

oven-sh/bun

🌟截止发稿星数:

75805

(近一周新增:389)

🇨🇳仓库语言:

Zig

🤝仓库开源协议:

Other

🔗仓库地址:

https://github.com/oven-sh/bun

引言

Bun 是一款全功能 JavaScript 和 TypeScript 应用程序工具包,包含 JavaScript 运行时、包管理器、测试运行器和脚本运行器。它旨在成为 Node.js 的替代品,提供更快的速度和更低的资源消耗。

项目作用

Bun 的核心是一个用 Zig 编写的快速 JavaScript 运行时。它利用 JavaScriptCore 的强大功能,在大幅减少启动时间和内存使用量方面表现出色。

仓库描述

Bun 存储库包含用于安装和使用 Bun 项目的详细文档、示例代码片段和贡献指南。

案例

Bun 用于各种应用程序和项目中,包括:

-

高性能 Web 服务器

-

桌面和移动应用程序

-

机器学习模型

-

数据处理脚本

客观评测或分析

Bun 以其以下特点而闻名:

-

快速:

得益于其 Zig 运行时,Bun 的启动时间和内存使用量都非常低。

-

兼容性:

Bun 与 Node.js 兼容,使现有项目可以轻松迁移。

-

全栈:

它提供了一个全面的工具集,涵盖应用程序开发的各个方面。

-

易用:

凭借其简单的语法和清晰的文档,Bun 易于学习和使用。

使用建议

对于正在寻找以下功能的开发者,Bun 是一个不错的选择:

-

一个快速的 JavaScript 运行时

-

一个易于使用且兼容 Node.js 的包管理器

-

一个强大的测试运行器,可以生成代码覆盖率报告

-

一个用于运行脚本和 Shell 命令的方便工具

结论

Bun 是一个强大且多功能的 JavaScript 和 TypeScript 工具包,为开发人员提供了全面的解决方案。它快速、兼容、易于使用,使其成为构建和管理应用程序的理想选择。

4.DeepSeek-Coder-V2

🏷️仓库名称:

deepseek-ai/DeepSeek-Coder-V2

🌟截止发稿星数:

4037

(近一周新增:953)

🇨🇳仓库语言:

🤝仓库开源协议:

MIT License

🔗仓库地址:

https://github.com/deepseek-ai/DeepSeek-Coder-V2

引言

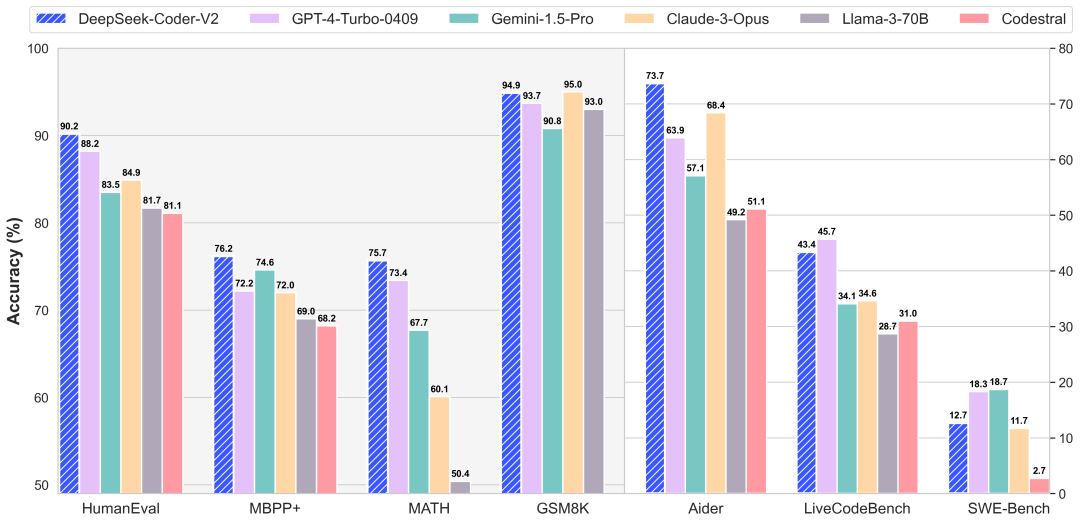

DeepSeek-Coder-V2 是一个开源的混合专家 (MoE) 代码语言模型,在代码特定任务上实现了与 GPT4-Turbo 相媲美的性能。

仓库描述

基于 DeepSeekMoE 框架,发布了 16B 和 236B 参数的 DeepSeek-Coder-V2 模型 具有 2.4B 和 21B 的活动参数(包括基础模型和指令模型) 在代码生成、代码完成、代码修复、数学推理和一般自然语言处理方面取得了卓越的性能

客观评测或分析

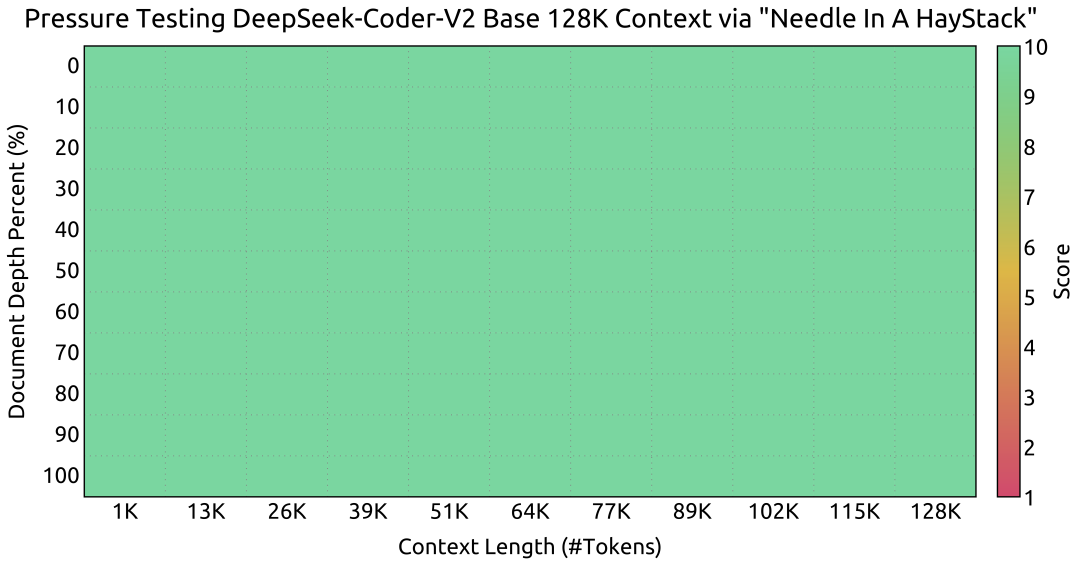

在代码和数学基准测试中,DeepSeek-Coder-V2 的性能优于 GPT4-Turbo、Claude 3 Opus 和 Gemini 1.5 Pro 等闭源模型 在 Needle In A Haystack (NIAH) 测试中,在长达 128K 的上下文窗口中表现良好

使用建议

可直接使用 Huggingface 的 Transformers 进行模型推理 建议使用 SGLang 或 vLLM 进行推理以获得最佳性能

结论

DeepSeek-Coder-V2 是一款功能强大的开源代码语言模型,在各种代码相关任务中提供了出色的性能,并支持广泛的编程语言和上下文长度。它为代码智能领域的进一步研究和应用开辟了新的可能性。

5.Ollama Python 库:与 Ollama 集成的 Python 工具

🏷️仓库名称:

ollama/ollama-python

🌟截止发稿星数:

6021

(近一周新增:169)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

MIT License

🔗仓库地址:

https://github.com/ollama/ollama-python

引言

本文章将介绍 Ollama Python 库,这是一个用于轻松将 Python 项目与 Ollama 集成的工具。本文将介绍库的作用、技术解析、使用案例、分析以及建议。

项目作用

该库基于 HTTPX 的 HTTP 客户端构建,用于与 Ollama REST API 交互。它提供了一种简单的 API,用于处理常见任务,如发送聊天消息和生成文本。

仓库描述

该存储库包括 Ollama Python 库的源代码、文档和示例脚本。

案例

客观评测或分析

Ollama Python 库易于使用,并提供了与 Ollama API 交互的强大方法。它支持流式响应,使您可以实时接收消息和文本生成,并处理大型数据集。

使用建议

结论

Ollama Python 库为 Python 开发人员提供了与 Ollama 集成的强大工具。它易于使用、功能丰富,并为与 Ollama 模型的交互提供了灵活的选择。

6.MLC LLM:统一的LLM部署引擎

🏷️仓库名称:

mlc-ai/mlc-llm

🌟截止发稿星数:

19782

(近一周新增:103)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

Apache License 2.0

🔗仓库地址:

https://github.com/mlc-ai/mlc-llm

引言

本文将深入探讨 MLC LLM,一个功能强大的 LLM 部署引擎,旨在实现跨平台的 AI 模型开发和部署。

项目作用

MLC LLM 编译代码并在 MLCEngine(一个跨平台的统一、高性能 LLM 推理引擎)上运行代码。MLCEngine 提供了 OpenAI 兼容的 API,可通过 REST 服务器、Python、JavaScript、iOS、Android 访问,这些API 均由不断改进的同款引擎和编译器提供支持。

仓库描述

本仓库包含 MLC LLM 项目的源代码、文档和示例。

案例

MLC LLM 已被用于各种应用程序,包括:

-

自然语言处理任务,如文本生成和翻译

-

计算机视觉任务,如图像分类和对象检测

-

对话式 AI

客观评测或分析

MLC LLM 因其以下优点而受到赞誉:

使用建议

要开始使用 MLC LLM,请访问其官方文档。该文档提供了有关安装、快速入门和使用引擎的综合指南。

结论

MLC LLM 是一个强大的工具,使开发人员能够解锁大语言模型的潜力。它提供了跨平台支持、高性能和易用性,使其成为想要在不同平台上部署 LLM 的开发人员的理想选择。

7.TRL:Transformer 强化学习

🏷️仓库名称:

huggingface/trl

🌟截止发稿星数:

10839

(近一周新增:177)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

Apache License 2.0

🔗仓库地址:

https://github.com/huggingface/trl

引言

TRL 是一个开源库,它通过使用高级强化学习技术提供了训练后基础模型的综合工具。

项目作用

TRL 充分利用了 Hugging Face Transformers 生态系统和各种硬件设置来支持广泛的模型架构。它包括一个命令行界面 (CLI),用于轻松启动和与模型进行交互。

仓库描述

-

以 Apache-2.0 许可证提供。

-

提供 Python 包和源安装选项。

-

强调高效且可扩展的培训能力。

-

包括教练员的文档和使用建议。

使用建议