专栏名称: 数盟

| 数盟(数据科学家联盟)隶属于北京数盟科技有限公司,数盟致力于成为培养与发现“数据科学家”的黄埔军校。 数盟服务包括:线下活动、大数据培训。 官网:http://dataunion.org,合作:[email protected] |

目录

相关文章推荐

|

大数据分析和人工智能 · 20个很强的DeepSeek提问公式 · 昨天 |

|

软件定义世界(SDX) · 与孙正义对话,Sam ... · 3 天前 |

|

数据派THU · 【ICLR2025】AdaWM:基于自适应世 ... · 3 天前 |

|

数据派THU · 【博士论文】迈向值得信赖的视觉生成模型:扩散 ... · 2 天前 |

|

玉树芝兰 · 对科研工作者来说,OpenAI Deep ... · 4 天前 |

推荐文章

|

大数据分析和人工智能 · 20个很强的DeepSeek提问公式 昨天 |

|

软件定义世界(SDX) · 与孙正义对话,Sam Altman正面回应DeepSeek:"OpenAI投入多少,AI智能就有多强" 3 天前 |

|

数据派THU · 【ICLR2025】AdaWM:基于自适应世界模型的自动驾驶规划 3 天前 |

|

数据派THU · 【博士论文】迈向值得信赖的视觉生成模型:扩散模型的可靠且可控生成 2 天前 |

|

玉树芝兰 · 对科研工作者来说,OpenAI Deep Research 功能意味着什么? 4 天前 |

|

参考消息 · 视界 | 如果道歉有用,还要警察干什么? 日本警察对中国人做的这件事,我们没法忍! 8 年前 |

|

穷游网 · 去法国,买哪些伴手礼既有面子又不破费 8 年前 |

|

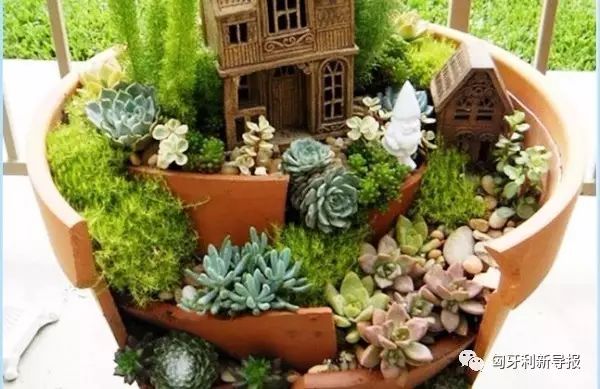

匈牙利新导报 · 【2017布达佩斯园艺展览】园艺爱好者不可错过的盛会! 7 年前 |

|

FashionWeek · 快时尚品牌不好好卖衣服都开始卖彩妆了(内附值得买清单) 7 年前 |

|

米内网 · 【市场】全球最贵药物因有价无市终撤市,天价药TOP5命运将如何? 7 年前 |