本月探索了 8 个出色的 GitHub 仓库,涵盖了开源个人理财操作系统、电子书转有声读物工具、基于 RAG 的文档聊天工具、高吞吐量 LLM 推理和服务引擎、基于 LLVM 的大语言模型服务框架、轻量级 Mastodon 网页客户端、功能丰富的 Vue UI 组件库和用于控制和显示 Android 设备的图形化工具。这些项目提供了强大的功能、用户友好的界面和广泛的用例。

1.开源的个人理财操作系统

🏷️仓库名称:

maybe-finance/maybe

🌟截止发稿星数:

38051

(近一个月新增:3345)

🇨🇳仓库语言:

Ruby

🤝仓库开源协议:

GNU Affero General Public License v3.0

🔗仓库地址:

https://github.com/maybe-finance/maybe

引言

本文探讨了 Maybe,一个开源的个人理财操作系统,旨在为个人提供专业的理财工具和管理解决方案。

项目作用

Maybe旨在为个人提供一个全面的财务管理平台,帮助他们改善财务状况并做出明智的金融决策。它采用热加载和涡轮技术,提供快速且响应的应用程序体验。

仓库描述

此仓库包含 Maybe 应用程序的源代码、文档和配置。用户可以克隆此仓库并根据自己的需要进行开发和部署。

使用建议

结论

Maybe 是一个强大的开源项目,为个人提供了管理其财务的全面且用户友好的解决方案。它允许用户控制自己的财务数据,并根据自己的需要定制应用程序。随着项目的持续开发,Maybe 有望成为个人财务管理领域的主要参与者。

2.电子书转有声读物:ebook2audiobook

🏷️仓库名称:

DrewThomasson/ebook2audiobook

🌟截止发稿星数:

7870

(近一个月新增:5903)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

Apache License 2.0

🔗仓库地址:

https://github.com/DrewThomasson/ebook2audiobook

引言

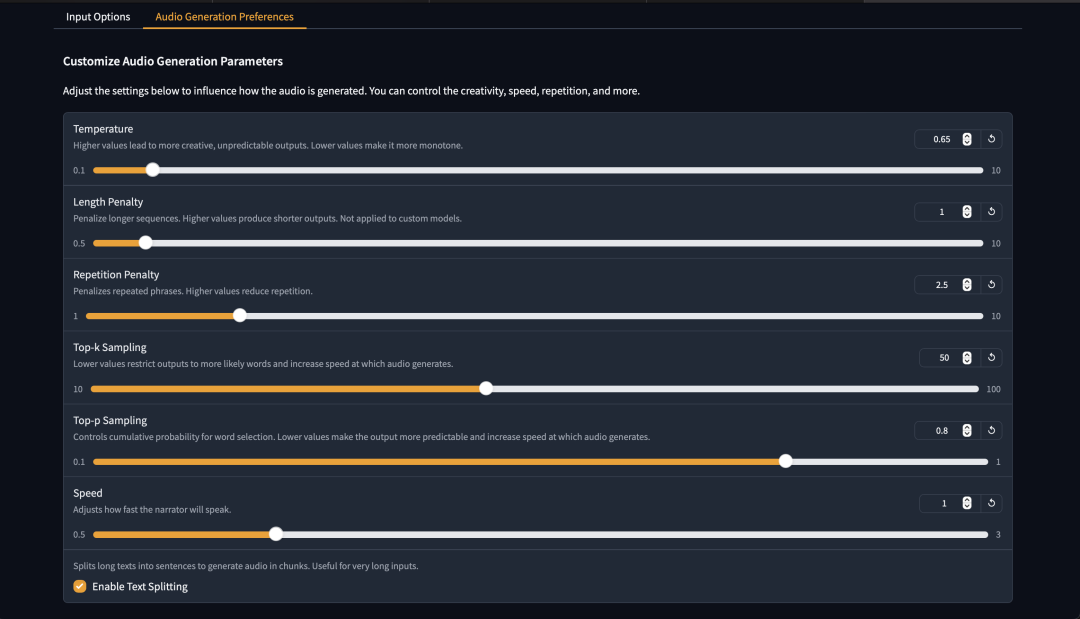

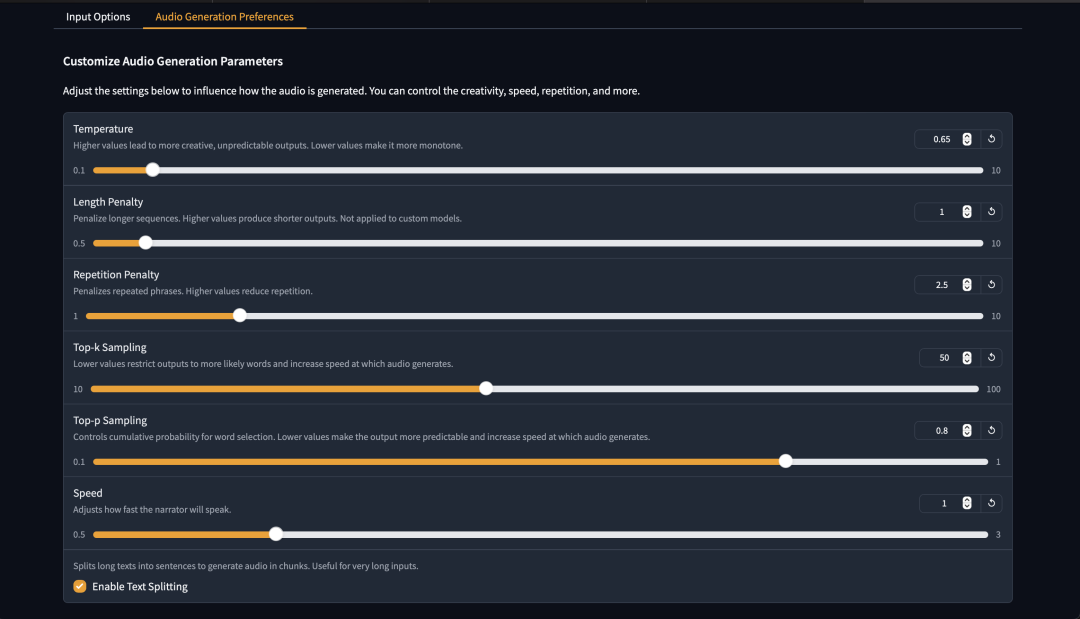

ebook2audiobook是一款开源工具,能够将电子书转换成带章节和元数据的有声读物。它采用人工智能模型和语音克隆技术,支持1107+种语言,并针对4GB内存的机器进行了优化。

项目作用

ebook2audiobook利用Calibre提取电子书文本,使用ffmpeg分割章节,并使用XTTSv2和Fairseq进行文本转语音。它还提供可选的语音克隆功能,允许用户使用自己的声音文件。

仓库描述

GitHub仓库包含ebook2audiobook的源代码、安装说明和使用指南。它还包括一个README文件,提供了关于该项目的详细概述。

案例

用户可以使用ebook2audiobook将各种电子书文件(如epub和mobi)转换成有声读物。项目中提供了预制音频演示,展示了不同语言和声音模型的输出示例。

客观评测或分析

ebook2audiobook是一款功能强大的工具,能够轻松地将电子书转换成高质量的有声读物。它支持多种语言、语音克隆和自定义XTTS模型。然而,在CPU上运行时,它可能有些慢,并且在分割句子时可能会遇到问题,具体取决于所使用的语言。

使用建议

有兴趣使用ebook2audiobook的用户可以按照仓库中的说明进行安装。建议使用Docker以获得最佳性能和一致性。该项目还可以通过免费的Google Colab和Hugging Face Space访问。

结论

ebook2audiobook是一个有价值的开源工具,它为将电子书转换成有声读物提供了一个简单且功能强大的平台。它支持多种语言、语音克隆和自定义TTS模型,并针对4GB内存的机器进行了优化。虽然在某些情况下可能有些慢,但总体而言,ebook2audiobook是任何希望创建自己的高质量有声读物的用户的绝佳选择。

3.Kotaemon:基于 RAG 的文档聊天工具

🏷️仓库名称:

Cinnamon/kotaemon

🌟截止发稿星数:

20643

(近一个月新增:2548)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

Apache License 2.0

🔗仓库地址:

https://github.com/Cinnamon/kotaemon

引言

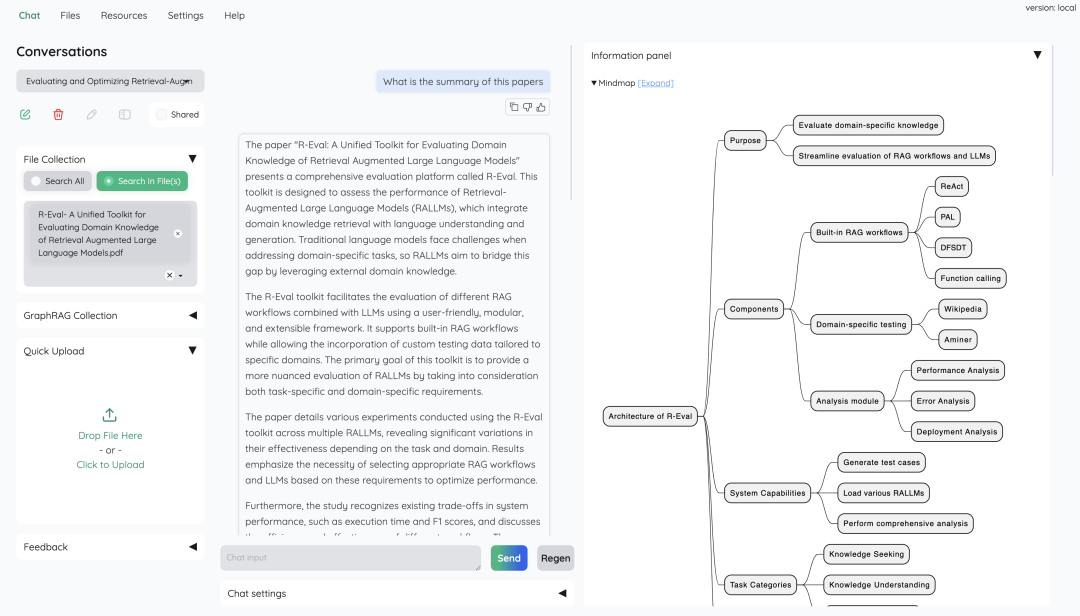

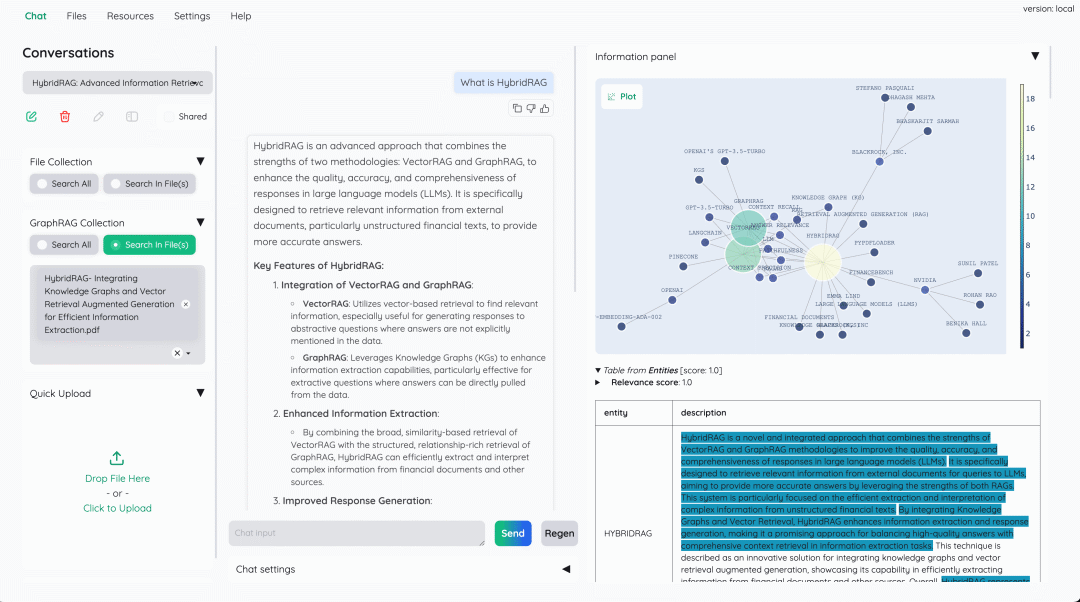

本文介绍了 Kotaemon,这是一个开源且可定制的 RAG 界面,旨在方便用户与文档进行交流。

结论

Kotaemon 是一款功能强大的基于 RAG 的文档 QA 工具,为用户和开发人员提供了广泛的功能。其简洁易用的界面、多模式支持和可自定义性使其成为文档交流的有力工具。

4.vLLM:高吞吐量且内存高效的 LLM 推理和服务引擎

🏷️仓库名称:

vllm-project/vllm

🌟截止发稿星数:

35392

(近一个月新增:2689)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

Apache License 2.0

🔗仓库地址:

https://github.com/vllm-project/vllm

引言

vLLM 是一个功能强大的 LLM 推理和服务引擎,旨在以经济高效的方式满足不断增长的 LLM 需求。

项目作用

vLLM 利用以下技术来优化性能和效率:

-

PagedAttention

:一种创新的注意机制管理方法,可节省内存消耗。

-

连续批处理

:自动将请求分组到批处理中,以最大化利用。

-

CUDA/HIP 图

:利用 GPU 并行性加速模型执行。

-

量化

:支持多种量化技术,例如 GPTQ、AWQ 和 FP8。

仓库描述

vLLM 仓库包含:

案例

vLLM 已被用于各种成功的项目中,包括:

客观评测或分析

vLLM 在以下方面表现出色:

使用建议

-

安装 vLLM

-

加载所需的 LLM 模型

-

配置服务器设置

-

部署和监控服务

结论

vLLM 是一个功能强大且易于使用的 LLM 推理和服务引擎,为各种应用程序提供了高效和经济高效的 LLM 解决方案。其先进的技术、社区支持和广泛的用例使其成为 LLM 开发人员和用户的理想选择。

5.SGLang:语言模型服务框架

🏷️仓库名称:

sgl-project/sglang

🌟截止发稿星数:

8138

(近一个月新增:1214)

🇨🇳仓库语言:

Python

🤝仓库开源协议:

Apache License 2.0

🔗仓库地址:

https://github.com/sgl-project/sglang

引言

SGLang是一款快速服务大型语言模型(LLM)和视觉语言模型(VLM)的框架,它通过共同设计后端运行时和前端语言来让用户与模型进行更快速、更可控的交互。

项目作用

核心功能包括:

-

快速后端运行时:

支持多种优化技术,如前缀缓存、跳跃式约束解码、无开销CPU调度等。

-

灵活的前端语言:

提供直观界面,支持链式生成调用、高级提示、控制流和多模态输入。

-

广泛的模型支持:

支持各种生成模型(Llama、Gemma等)、嵌入模型(e5-mistral、gte等)和奖励模型(Skywork)。

仓库描述

GitHub仓库包含:

案例

已在以下场景中得到应用:

-

加速LLaVA模型的推理

-

构建多轮对话生成应用程序

-

集成各种LLM和VLM模型以创建多模态系统

客观评测或分析

使用建议

结论

SGLang是一款功能强大且易于使用的LLM和VLM服务框架,它通过其快速的后端运行时、灵活的前端语言和广泛的模型支持使LLM和VLM应用程序的开发和部署变得更加容易。

6.Elk:轻量级 Mastodon 网页客户端

🏷️仓库名称:

elk-zone/elk

🌟截止发稿星数:

5621

(近一个月新增:69)

🇨🇳仓库语言:

Vue

🤝仓库开源协议:

MIT License

🔗仓库地址:

https://github.com/elk-zone/elk

引言

本文旨在介绍 Elk,一个轻量且易于使用的 Mastodon 网页客户端,并探讨其功能、技术实现和使用建议。

项目作用

Elk 基于 Vue.js、Nuxt.js 和 Vite 等现代技术构建,提供了许多功能,包括:

-

浏览 Mastodon 时间线和个人资料

-

发布和回复帖子

-

发送和接收私信

-

自适应主题和黑暗模式

仓库描述

该仓库包含 Elk 的源代码、文档和构建脚本。

案例

Elk 已被广泛部署于各种 Mastodon 实例,包括 elk.zone、h4.io 和 universeodon.com。

客观评测或分析

Elk 是一款易于使用且响应迅速的 Mastodon 客户端,提供了一系列有用的功能。其基于现代网络技术构建,并积极维护和更新。

使用建议

-

作为 Mastodon 的主要网页客户端使用

-

探索 Mastodon 社交网络的替代方式

-

为 Mastodon 服务器提供替代网页客户端

结论

Elk 是 Mastodon 爱好者的绝佳选择,它提供了轻量、易用且功能丰富的网页客户端体验。

7.PrimeVue 单体仓库

🏷️仓库名称:

primefaces/primevue

🌟截止发稿星数:

11562

(近一个月新增:405)

🇨🇳仓库语言:

Vue

🤝仓库开源协议:

MIT License

🔗仓库地址:

https://github.com/primefaces/primevue

引言

PrimeVue 是 Vue 的一系列丰富的开源 UI 组件。

项目作用

遵循 Material Design 准则,使用 TypeScript 编写,并提供对 TypeScript 和 JavaScript 的支持。