去年夏天,NBA马刺队当家球星、全明星大前锋邓肯宣告退役。因为面框背打样样精通,大鲨鱼奥尼尔给他起过一个外号,叫“大基本功”。

一年之后,中国IT行业流行起基本功,譬如10天前召开的百度云智峰会(ABC Summit)。

A代表AI即人工智能(Artificial Intelligence),B代表Big Data即大数据,C代表Cloud Computing即云计算。B和C拱卫A,为AI提供(大)数据和可借鉴的(云计算)模式。

类似的概念还有曙光的ABC²——多出来的一个C代表HPC即高性能计算。抛开曙光夹带私货的小九九,从技术渊源上来看,说HPC为AI、大数据和云计算打下了基础,并不为过。

聊回百度云在大会上推出的ABC一体机:将百度AI应用能力及模型内置于浪潮提供的硬件中,以软硬一体的形式,供不同行业的用户私有部署。

在上午的主题演讲环节,百度云现场演示了利用ABC一体机识别缺陷钢板的应用,准确率超出预期,也让我对其硬件平台产生了兴趣。

百度是天蝎整机柜的最大用户,浪潮是天蝎整机柜的主要供应商,二者联手,大概率是基于天蝎整机柜的方案——虽然ABC一体机不是给百度自家用的(注意,这是关键)。

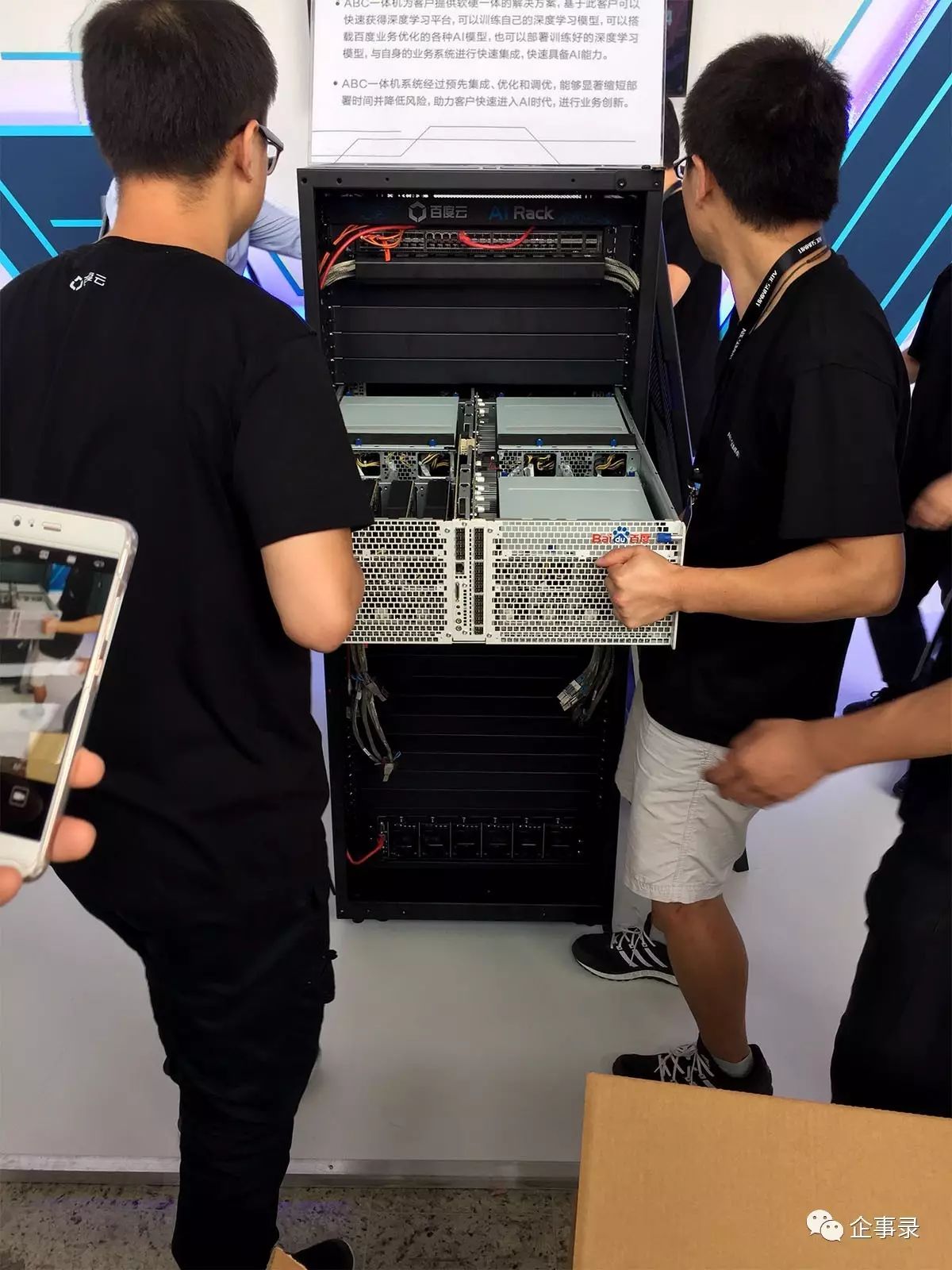

会场昏暗的灯光下遥望台上显然看不清楚,于是出到展厅里,在ABC一体机的展位前等。不一会儿,ABC一体机果然在众人簇拥下过来了。

(本文所有图片均可点击放大)

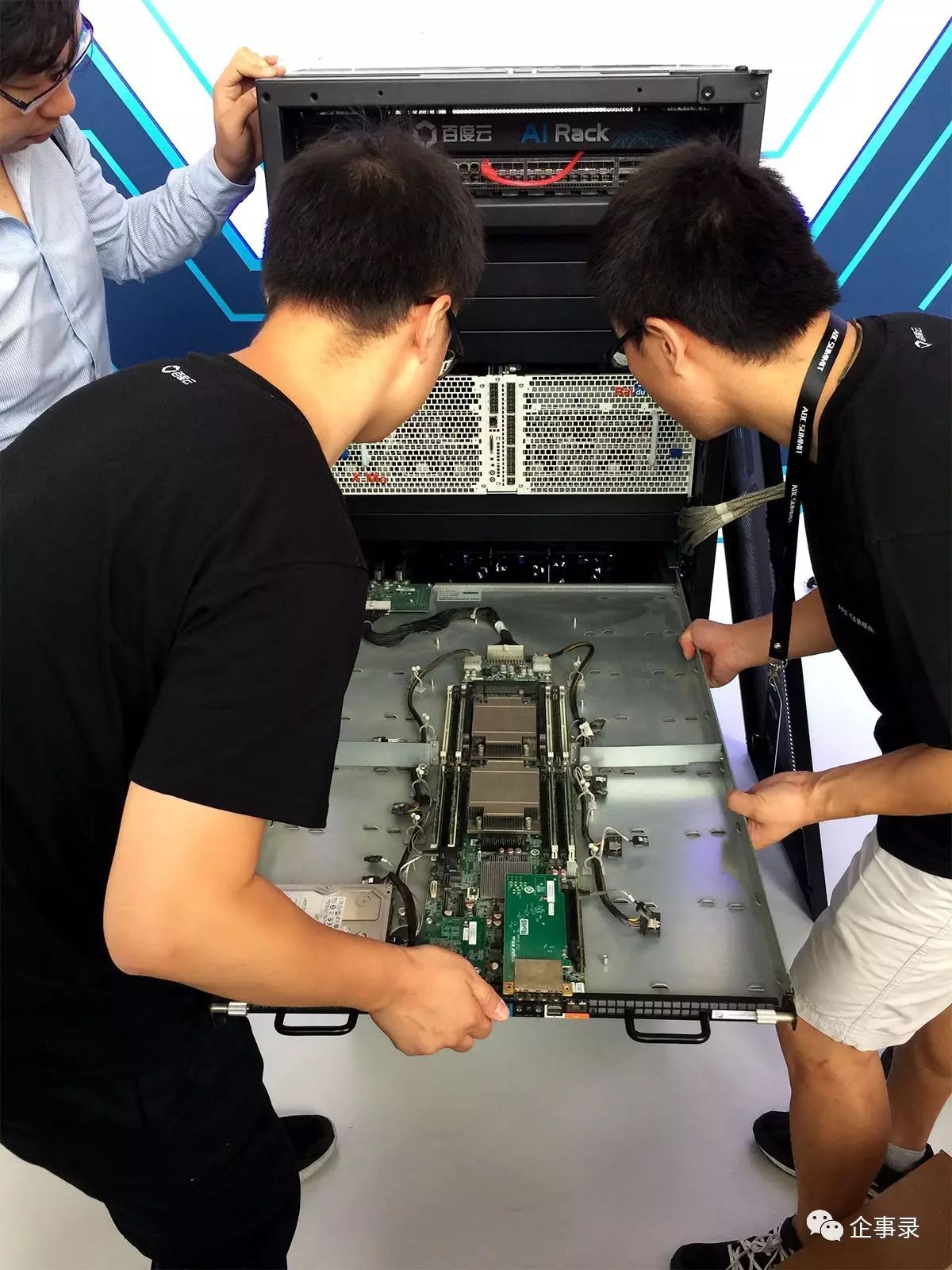

被挪到底部的3U集中供电区(PSU池),后部集中的风扇墙,都是天蝎整机柜的典型特征。

从天蝎2.0起,统一了风扇墙的规格,每行3个140×38的风扇,对应4SU(Scorpio U=46.5mm,略高于标准RU)的机架空间。从后面看6行风扇,对应24(S)U的IT设备空间。还有上面3U交换机空间,以及下面3U的集中PSU,加一起30U的高度,不至于像标准天蝎整机柜那样,进不去一些机房门高度不够的数据中心。

没几天前,企事录实验室收到了一个本应是42U的47U机柜,就遇到进不了门的尴尬,只好退回重发

当然,这个30(S)U的ABC一体机是展示系统,实际供应客户的产品可以根据需求调整机柜的高度。

不过,较真的说,以国内绝大多数私有云用户的机房条件来看,这套30U的展示系统里面装的IT设备,密度已经足够了。

甚至,这套演示系统的配置,就能让机房管理员喝一壶了。

机柜摆放到展位,正面留出6(S)U的IT设备安装位置,随后分批运来了3台设备。

X-Man 1.0带来供电挑战

4U的设备是ABC一体机的核心——百度去年发布的X-Man 1.0,内置16个PCIe插卡式GPU,通过PCIe交换芯片互连,由Intel Atom处理器管理。由于里面都是GPU,还需要配合带CPU(如Intel Xeon)的服务器才能使用。所以,套用JBOD的概念,这种(纯)GPU服务器也被称为JBOG(Just a Bunch of GPUs)。

X-Man 1.0内部分为4个基本均等的区域,每个区域有4个全高全长(FHFL)的双宽PCIe插槽,可容纳所有PCIe规格的GPU。PCIe交换芯片和管理CPU等元件位于机箱中间的电路板上

该演示系统配置的GPU是nVIDIA的Tesla K40,总体上处于中低端,最大功耗235W。以每个GPU的功耗为250W计,整台GPU服务器的功耗可达4kW(千瓦)或更高。

X-Man 1.0通过外部PCIe线缆(规格与mini SAS HD相同)连接到服务器,该演示系统包括2个1(S)U的双路至强服务器节点。以每个节点500W的功耗计,这6U的组合就需要5kW,已经达到了国内多数托管机房的单机柜平均供电水平。

如果用户会觉得每机柜只放一台X-Man 1.0太浪费空间,而要放置两台的话,那么,不需要再放其他设备,整个机柜的功耗即可达8kW,这在任何一个国内的托管数据中心,都可以算高功率机柜啦。