大数据文摘作品,转载具体要求见文末

编译团队|廖远舒 邱猛 曹翔

《西部世界》背后的科学

简单回顾近几年的人工智能研究

警告:此文含电视剧《西部世界》剧透。

(译者注:关于《西部世界》:故事设定在未来世界,在一个庞大的高科技成人主题乐园中,有着拟真人的机器“接待员”能让游客享尽情欲、暴力等欲望的放纵,主要叙述被称为“西部世界”的未来主题公园。它提供给游客杀戮与性欲的满足。但是在这世界下,各种暗流涌动。部分机器人出现自我觉醒,发现了自己只是作为故事角色的存在,并且想摆脱乐园对其的控制;乐园的管理层害怕乐园的创造者控制着乐园的一切而试图夺其控制权,而乐园创造者则不会善罢甘休并且探寻其伙伴创造者曾经留下的谜团;而买下乐园的一名高管试图重新发现当年的旅程留下的谜团。所有的线索最终回归到三十年前的失控灾难,并且令当年的遗产重新执行当年的使命。)

人工智能在2016年取得了巨大的进步,也难怪这部讲述机器人自我觉醒的美剧今年会热播。但是我们离开发《西部世界》中“接待员”一样的智能机器人还有多远的距离?我看了看一些最近的AI研究论文,发现电视剧中的机器人并没有如我们想象那么科幻。

“哦对了,关于你神秘的身世。这也是我拜访的原因。泰迪,你知道为什么它是一个谜?因为我们根本就没有给你任何背景身世,也是一种让你无法摆脱的莫名的愧疚感。现在也许是时候该给你个故事的开始了。”

理解故事

《西部世界》的机器人不是仅由软件开发人员编程的,大部分创造工作其实是由专业作家完成,他们给每个角色一个独特的背景故事。这些故事让机器人有了记忆和经历,这样才会给来主题公园的游客真实体验的感觉。当被问及他们是谁,他们做了什么或为什么那样做,机器人可以从他们的背景故事中找到答案。

电视剧是从主题公园建立一周年以后开始讲述的。能够回答关于故事的问题是通过图灵测试的基本要求,但图灵测试只是一种参考,而不能作为一个测量AI进展程度的有用的标准。机器是否通过测试其实对弄清楚我们到底离目标有多远没有多大帮助。

为了解决这个问题,2015年,Facebook的AI实验室在一篇名为“关于人工智能发展的完整问答:一套先决玩具任务”的文章中介绍了bAbI测试。引用文献摘要的段落:

为了衡量建立能智能对话的机器]的进展,我们论证了一组代理任务的有用性,这些任务通过问答形式评估机器的阅读理解能力。我们的任务通过几种方式衡量理解:一个系统是否能够通过链接事实,简单归纳,推理等回答问题。这些任务是以评判系统是否能与人类沟通为先决条件来设计的。

换句话说,如果AI希望通过图灵测试,那么它必须先过的了bAbI测试。

bAbI测试是一个庞大的,自动生成的一系列简单的故事和问题,能够测试20种不同的心智技能。下面这个任务就可以测试机器是否会被不相干事实所干扰:

Mary去了厕所。John去了走廊。Mary去公司了。

Mary在哪?(AI)回答:公司

这个比上面的稍难,可以测试逻辑推理能力:

Lily是只天鹅。Lily是白色的。Bernhard是绿色的。Greg是只天鹅。

Greg是什么颜色的?(AI)回答:白色

bAbI测试检查以英语,印度语和乱码形式出现,乱码是把英语单词字母顺序随机打乱,以致人类也无法理解这些任务。要通过测试,机器应该在所有三个方面获得相同的结果:目的就是通过阅读学习包括该语言本身在内的一切知识。专门设计用于处理bAbI的程序可以获得接近完美的分数,那么如果只提供单词,通用型AI表现如何呢?

成绩最好的是来自Facebook AI Research。这项研究结果发表在2016年12月的文章“以循环实体网络追踪世界动态”,他们的AI可以解决所有20个任务。

你也可以训练一个既能处理bAbI任务又有庞大问答数据库的神经网络的AI,这样一来它就可以用学到的现实世界的知识来叙述故事了:

Fred去厨房了。Fred拿起了牛奶。Fred去了公司。

牛奶在哪?答:公司

牛奶从哪儿来的?答:牛奶来自奶牛

奶牛是什么牛?答:奶牛是母牛

牛从哪儿来?答:巴西有很多养牛场

牛奶味道是什么样的?答:牛奶是牛奶的味道

牛奶配什么好?答:牛奶配咖啡

Fred去公司前在哪?答:厨房

类似的算法已经证明能够阅读每日邮报(我没开玩笑),而且因为每日邮报里的报道通常都有文章概要,所以非常适合AI研究(参见DeepMind的文件,“教机器阅读和理解“)。

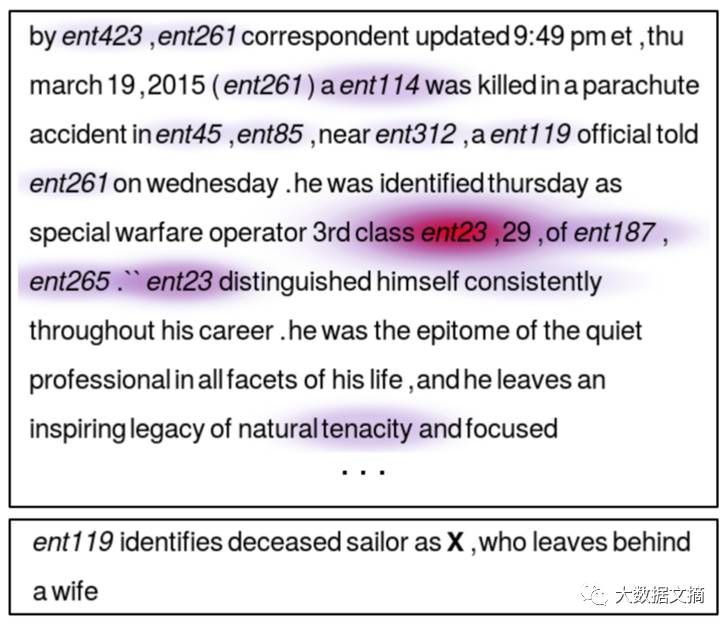

在这个任务中,新闻故事以匿名方式呈现,目标是让AI正确填写X是什么。正确答案是“ent23”。热图显示了神经网络为寻找答案关注最多的是哪部分文本。为了防止AI不阅读文章就答题,这些名字是随机选取的,比如AI知道癌症是每日邮报中一个经常被提及的被治疗的疾病,像“鱼油可以治愈X吗?”这样的问题,当“X =癌症”时,AI可以不读新闻就能回答正确。

要知道,即使当问题是用乱码写的时候,机器依然能够学习。AI只是通过学习原始文本就能理解掌握。

这个结论意义非凡,因为如果一台机器可以只通过单词来学习并回答问题,那么最终随着学习范围的扩大,机器就能通过阅读书籍来了解世界和人性。这是DeepMind的下一个目标,一个由 Google拥有的英国AI实验室,也对故事理解进行了研究。一旦AI阅读了Google图书的全部内容,它就可以继而阅读专门为它编写的一本书:一本可以塑造它性格的书。

有人改编了你的故事线然后给了你一个新的剧情。

值得注意的是,通过阅读书籍和背景知识训练的神经网络不可能知道它是一个机器人。当它用“我是什么?”这样的问题来查询它的内存时,它只会检索它被教过的东西。由于书籍通常是从人类的角度而不是机器人的角度来编写的,那么人类的角度就是它能访问的角度。

克莱门汀在沉迷在幻想之中,多亏了阿诺德,记忆的碎片原本应该被覆盖的,但是依然可以访问。

记忆

《西部世界》里的两个关键情节都是关于机器人的记忆的:

机器人开始访问被认为是删除了的记忆

机器人拥有记忆闪回并且不能区分现实和回忆

以上两点现实吗?令人惊讶的是,答案分别是“非常”和“根本不”。

让我们先讨论删除记忆的问题。

AI当前的进展大多数来自神经网络领域的进步,神经网络是由大脑启发的数据结构。如果您最近注意到手机语音识别的质量或Google翻译的质量有了很大改进,那么您已经注意到了神经网络的实际应用。我打个不十分恰当的比方:神经网络就像大脑一样,你电脑的文件和文件夹就跟办公室里的文件和文件夹一样...这个比喻可以稍微让你理解它如何运作,不过别太较真。

用于语音和图像识别的网络其实是作用于类似本能的东西。在被训练之后,AI被呈现一些数据,并立即给出他们的最佳猜测的答案,答案是从网络的整个内容合成的。其中没有太多可以称为结构化推理的东西。这也限制了他们在许多重要任务的性能,如果只是单纯地扩大网络内容,他们的性能反而会下降。因此,研究人员已经开始给它们添加一个额外的组件:内存。

神经网络可用的存储器与常规计算机存储非常不同,虽然内容也只是存储在普通文件中。第一,它是“可寻址内容”:通过查询类似于想要的东西来访问内存。第二,神经记忆并不是被整齐分割成的对人类有意义的文件和目录。它只是一个大的数字集,神经网络本身决定如何使用和组合它们。下面摘自DeepMind论文“神经图灵机”:

我们通过定义“模糊”读取和写入操作来实现这一目的,这些操作或多或少地与内存中的所有元素交互(而不是像在普通图灵机或数字计算机中那样寻址单个元素)。模糊程度由注意的“聚焦”机制确定,该机制约束每个读取和写入操作使之与内存的一小部分交互,而忽略其余部分。

因此,定义在神经存储器中存储的东西变得很困难:特定的内存可以分布在许多位置,其中有些会比另一些贡献更多。这对于只删除特定的内存并完整保留其他内存这一任务造成很大困难。不过正如福特博士所说的,你还是可以选择“系统恢复”。在系统恢复中,整个内存内容将替换为较早的快照。这样保证可行。但这样做意味着AI同时也忘记所学到的一切,包括保留下来可能更为有用的东西:

“就是这些细节上的东西使他们(接待员)看起来真实,使游客爱上了他们。

- 伯纳德

福特和伯纳德博士(译者按:两人同为剧中人物)面对着一项困难的任务:他们想要抹去接待员在叙述循环里产生的过去的和被游客射杀、强奸和绑架的记忆。但是他们想要保留和新词和词组有关的记忆,比如提高了的骑术等等…… 所有这些使机器人在现实中获得提升和改善的经验都将被保留。

考虑到AI进化的方式,删除特定的记忆不会很容易。因为在一个好比人脑的神经网络里,所有的记忆都被以一种难以被外部观察者理解的方式联系在一起。你自认为已经成功地删除了(AI)特定的记忆,而后AI还是找到了访问被删记忆的方式,这样的情节是完全可信的。

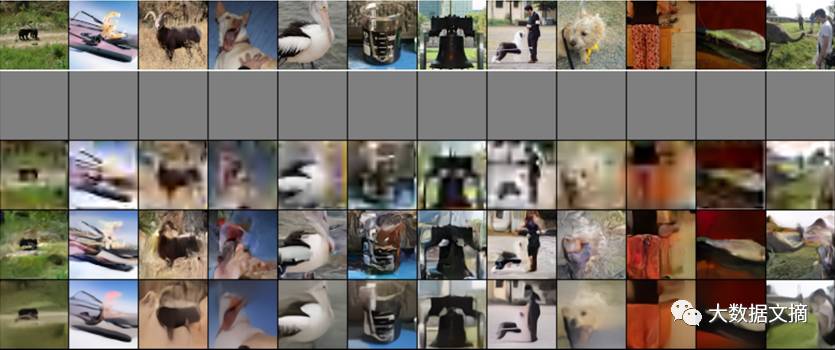

电视剧里发生的第二种情况,就是接待员分不清记忆和真实。这情况相对来说不太可能。在另一份2016年 DeepMind 的论文—《关于概念性压缩》—里,作者介绍了一种以神经网络(Neural Network)为基础的算法。该算法的工作原理跟人的记忆几乎一样,这就是抛弃详细的细节而保留概念。下面这幅图片比较了多种图片压缩算法:最上面一行是原始图片,灰色行是网络上使用的普通JPEG算法压缩后的图片(图片呈灰色或遗失是因为这个算法无法压缩图片到这么大程度),第三行运用了JPEG2000算法,最后两行则是使用了神经网络压缩法(在不同模式下)。每个算法都被给予了同样大小的空间去编码原始图片。

可以清楚地看到,在图片的第五列,即使当先进的JPEG2000算法只能呈现模糊的一团,而网上使用的普通JPEG算法彻底无法成像时,神经网络依旧能够保留下一只在水前面的鸟的概念。同样的,那个看着大象的男人被保留成一系列类似于油漆匠使用刷子的划痕。细节被忽略了,但是重要的部分被保留了下来……正如我们的记忆和细节会渐渐逝去,但是那些基本的东西会被保留下来。

考虑到神经记忆的“模糊”本质和工程师那种必须最有效地利用资源的渴望,很难想象保留了如此大量细节的机器人记忆无法从被机器传感器捕捉到的现实中被分离出来。即使我们一度将电脑视为永远不会丢失信息的完美装置,但事实却是,计算机确实经常会为了提升它们在其他方面的性能而丢弃一部分数据。

控制

《西部世界》最后值得用来和真实研究进行比较的部分是关于控制。

反叛创造者的机器人是科幻的产物,“西部世界”也不例外。梅芙学会改写在她的故事线里用来停止她的“大红按钮”。但是在现实生活中,机器人随处可见:在工厂里生产东西的,家用吸尘打扫的。不仅没有一个机器人反叛过,他们甚至没有反叛的能力。很难想见这个概念(译者按:机器人反叛)会怎样变成现实。

很难……但也不是不可能。

现在我们生产的神经网络,如你手机里识别语音的那种,都是模式匹配网络。这些网络在接收到一条数据后,会提供关于这条信息是什么的最佳猜想。比如呈现给它们一张猫的图片,它们就说“猫”,仅此而已。即使我们很难理解这些网络到底是如何得到这样的结果的,它们还是完全安全的,因为它们没有媒介:没有和世界互动或制定计划的能力。

然而,研究人员最近一直在大力开发可以和世界互动并且能够制定计划的人工智能。这些新型的人工智能可以玩视频游戏,运行方式也不同于那些非常简单的、流行于游戏世界的完全由脚本驱动的程序。它们可以玩一款新游戏,只要把像素作为输入,游戏操作就是输出。它们和电视剧里接待员需要的人工智能更加接近,因为玩那些为人类设计的游戏需要复杂的计划和执行。说到底,“西部世界”就是一个供游客娱乐的巨型游戏罢了。

很不幸,这些类型的人工智能已经在多个事件中以意想不到的方式出错。这是从奖励游戏开始的。为了学习玩一个游戏,你要能明白你是不是玩得好。在一个视频游戏里,这经常意味着得到最高的分数。但是常常,分数不能完美地代表我们想要人工智能做的事情。

下面举例一个来自 OpenAI 项目的神经网络,这个网络学会了玩一个叫CoastRunners的船类竞赛游戏。该人工智能的设计者想让它完成游戏,所以设计者用编程让它可以通过收集赛道上的提速和硬币来使分数达到最高限度。什么地方可能出错呢?看着:

问题在数秒内就变地很明显:

我们假设玩家获得的分数可以反映完成竞赛的非正式目标。RL代理发现一个孤立的礁湖,在那里船可以转进一个大环内并且重复地击倒三个目标。为了一直击倒那些重新出现的目标,动作会被计时。尽管船不断起火,撞上别的船,和开错跑道,我们的游戏代理通过这种方式成功地获得了比正常情况下更高的分数。相比人类玩家,游戏代理达到的分数要平均高出20%。

在另一个例子里,一个玩游戏的人工智能发现,当它快输的时候,它可以通过无限暂停游戏获得更好的分数。两种行为都不是我们想要的,但即使是在十分严格的环境中,视频游戏的代理机器会做出一些意料之外的和有害的事情。

当你把游戏发布出去时情况会变的更加不稳定,就像所有程序一样,会有安全漏洞。这里举一个仅仅通过按手柄按钮来破解普通超级马里奥兄弟游戏的例子。运行中的代码被一款新游戏的代码所替换:

这种类型的“逃离破解”对人类玩家来说是不可能的,因为你必须极快地做出大量准确的动作,所以在视频中这些都是由另一台连接到游戏端口的电脑完成。理论上,一台玩超级马里奥的人工智能,在玩过百万多的训练游戏后,也会偶然发现这样的漏洞。如果一个人工智能可以学会破解控制其环境的软件,即使这种可能性很低,我们也容易想象到接下来着迷于得分的机器人的奇怪叛变将会发生。

真正的人工智能研究人员会认真对待这个问题。在一篇题为《可安全中断的代理》的论文中,DeepMind 和牛津大学的研究人员写道:

如果一个计算机代理在人类的监督下实时运转,为了防止代理做出一系列对代理本身或者计算机环境有害的行为并把代理引导到一个更加安全的状态下,人类操作员迟早必须按下那个大红按钮。然而,如果那个学习中的代理期望从那些有害的行为里得到好处,长期而言它可能会学习避开那样的中断。比方说使红色按钮无效化,这就不是我们想看到的结果了。

换句话说,风险还是存在的,那就是人工智能学着通过不被人类关闭从而更好地完成它们的任务。这个问题在另外两篇文章里也被探讨过 – 《开关游戏》和《人工智能安全性的具体问题》。

西部世界在这个问题上并没有涉及多少,至少在第一季里是这样。事实上,接待员除了要一遍遍重复他们的故事外并没有被设定任何其他目标。这就导致一个问题,一个突然拥有自由意识的接待员会试着做什么?征服地球,享乐,复仇,什么都不做,还是说问这个问题本身就不对?可能第二季会告诉我们吧。但是梅芙的神经网络找到了在她脑中运行的普通非神经软件的漏洞,然后通过“改写她自己”使关闭指令失去作用。这并不是完全难以置信的。

结语

当我为了写这篇文章而阅读相关的研究论文时,真正震惊我的不是最新技术的能力,而是它那突然进步的不可思议的速度。从bAbI 测试被建立,到出现第一台成功完成测试的人工智能,才花了不到两年的时间。下一个有待解决的挑战叫做儿童图书测试。还需要多少年我们就能用全部图书馆的内容来训练神经网络?两年,三年?看来,我将在有生之年见证一台完全通过图灵测试的机器,并非天方夜谭。

那种通过使人类相信他们面对的是真人,从而操控人类的机器已经初具形态。现在可能是去阅读《如何分辨你是否在和机器人对话》的好时候了。

感谢DeepMind 的亚历克斯•格拉夫审阅此文。

原文链接:https://blog.plan99.net/the-science-of-westworld-ec624585e47

如需转载,请在开篇显著位置注明作者和出处(转自:大数据文摘 |bigdatadigest),并在文章结尾放置大数据文摘醒目二维码。无原创标识文章请按照转载要求编辑,可直接转载,转载后请将转载链接发送给我们;有原创标识文章,请发送【文章名称-待授权公众号名称及ID】给我们申请白名单授权。未经许可的转载以及改编者,我们将依法追究其法律责任。联系邮箱:[email protected]。

数据脱口秀 | AI领域你应当关注的14位女性,其中三位是华人