本文内容非商业用途可无需授权转载,请务必注明作者及本微信公众号、微博 @唐僧_huangliang,以便更好地与读者互动。

如何选择一款测试软件,或者评估方法?我试着给出

3

种解释:

1、

它来自权威机构

/

组织,或者被业界广泛认可;

2、

它运行在有代表性的典型应用中,测出结果有较大参考价值;

3、

通过分析了解到具体的测试机制,包括对系统产生的压力模型,并证明其意义。

记得在《

存储极客:

SPC-1

负载分析与

AFA

寿命评估

》一文中,我曾经以类似方式分析过企业存储领域公认的

SPC-1

测试。

SPC

不是免费开放的

Benchmark

,参与其测试需要花不少钱,而我在本文中使用的测试软件没有这些限制,每个人都可以跑下试试:)

继上一篇《

Optane 900P SSD

评测

(1)

:当热插拔工作站遇上

CAS

缓存软件

》之后,本文开始性能测试部分,其中包括使用

3D XPoint Memory

的

900P

、传统闪存

NVMe SSD

(单盘

&RAID0

)以及

Optane

缓存加速机械硬盘的对比。

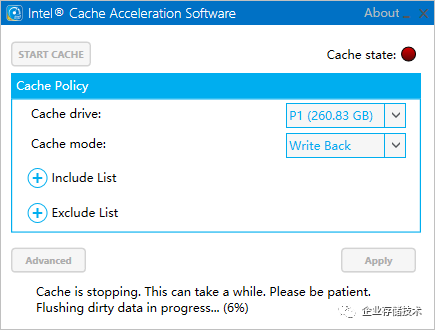

注:本文中使用

Intel Cache Acceleration Software

配置为

Write-Back

,也就是读写都加速的缓存模式

。

测试软件、应用结合原理分析

上图我在以前文章中给大家出示过,

Dell Precision

Ultra-Speed Drives

是一块

PCIe x16

的

1

转

4

M.2 NVMe SSD

扩展卡(还有个

1

转

2

的型号)。工作站用户更喜欢在有限空间内获得更大的存储带宽。

Optane 900P

比单个闪存

M.2 SSD

快很正常,但在工作站的应用中具体能快多少?如果把

4

个普通

NVMe SSD

性能绑在一起,

Optane 900P

还有胜算吗?

在具体的测试方法上,我首先想到了影视后期制作中的

4K/8K

高清视频编辑,这将是下一篇评测的主题。我们还需要一个面向工作站更全面的评估手段,同时保持对实际应用的参考价值。

测试样机为一台

Precision 5820 Tower

工作站,

Xeon W-2133 CPU

只有

4

核,

QuadroP4000

显卡也不算太高端,因此本次测试我们暂时不关注存储以外的表现。在《

双

Xeon SP

工作站,我却没找到第二个

CPU

插槽?

》一文中,我曾经介绍过这一代的

Xeon W

工作站

CPU

提供最高

18

核

/36

线程的规格。

对

SPECviewperf

、

SPECapc

系列测试不能再熟悉的我,决定写一次

SPECwpc

工作站综合性能

BenchMark

。

SPECwpc

测试软件也不是今年刚推出,为什么我以前没有讨论过呢?简单来说是因为

其综合成绩受磁盘

I/O

子系统性能影响较大

,因此看

www.spec.org

网站公布的测试结果,有点像拿

SSD

来辅助

“

跑分

”

的比赛,看谁的盘快、看谁盘配的更多:)

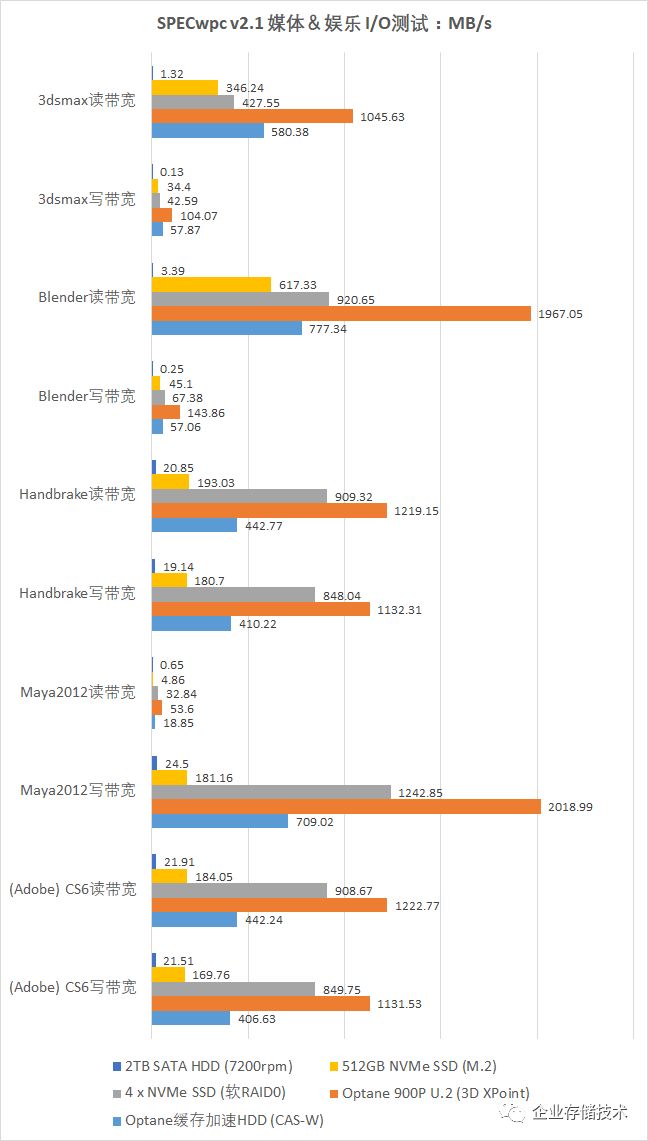

用

Optane SSD 900P

测得上面这几项

I/O

成绩,几乎属于

“

前无古人

”

了。

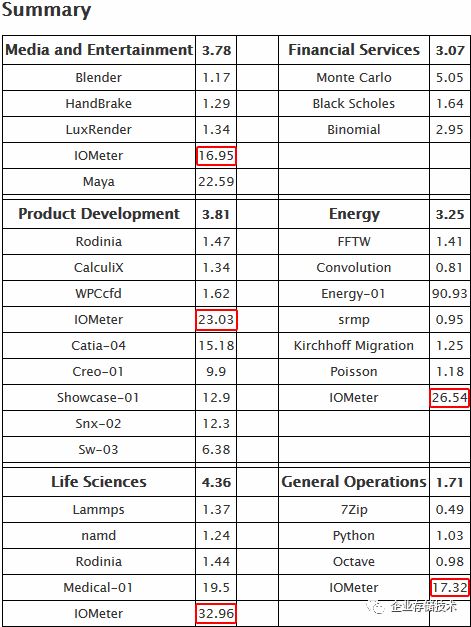

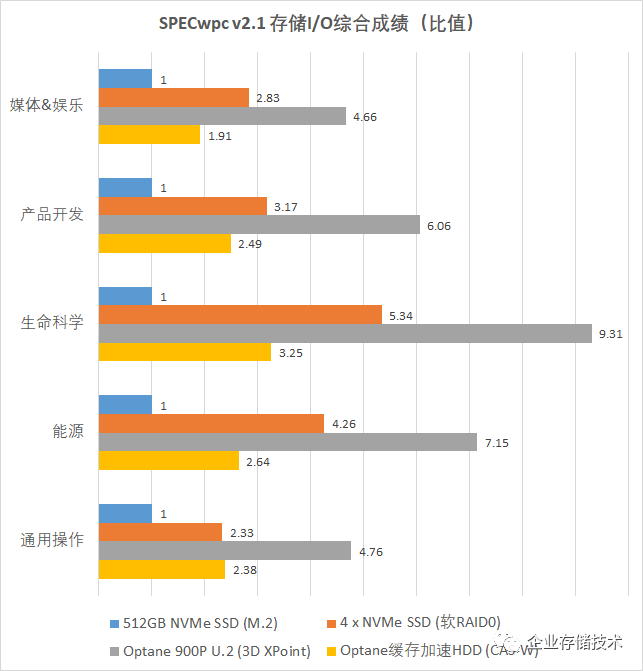

SPECwpc

测试结果按照工作站应用的行业来划分,包括:

媒体和娱乐、产品开发(制造业)、生命科学、金融服务、能源和通用操作

这几大项。

具体到存储性能评估,看来用的都是

Iometer

工具来压测,不过具体的访问模型肯定不同。为了鉴定其说服力,下文中我除了会对比详细的测试结果,还会

对测试方法进行剖析

。

SPECwpc

使用

Iometer

测试的项目,除了这些之外还有个

预热的脚本

,包括先写入一个

100GB

左右的文件,然后再持续一段时间的写入准备测试。这

对于反应

SSD

的真实能力还是非常重要的

。

Optane 900P

锋芒显露、

SSD RAID

的局限

注:组成软

RAID 0

的

4

个

M.2 SSD

,与

Dell 5820 Tower

工作站自带的

512GB SSD

并非同一型号,虽同为

NVMe

,但性能有一些差距。

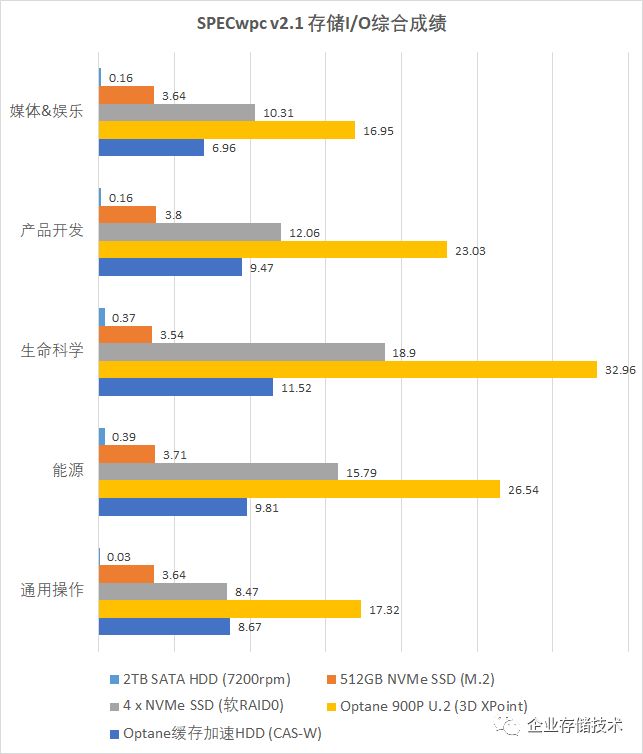

首先看

I/O

综合成绩的对比。

SATA

机械硬盘与

SSD

相比确实相差悬殊;

4

个

M.2 NVMe SSD

在

Windows

下

软

RAID 0

(带区卷)

比单盘有显著提高,但还是

Optane 900P

的表现最好。

至于使用

Intel Cache Acceleration Software

(

CAS-W

)

缓存软件配合

Optane 900P

来加速

HDD

硬盘

的组合,其表现基本

介于

NVMe SSD

单盘与

RAID 0

之间

,应该说是比较理想的结果了。

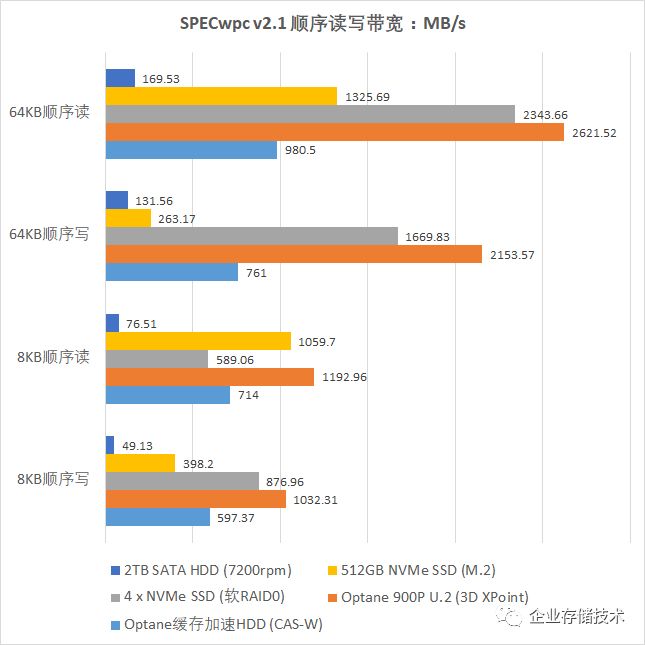

由于本文聚焦于存储性能,下面我们来看看具体单项测试的结果。

在顺序读写测试中,传统闪存

SSD

与

Optane 900P

的差距缩小了;而

512GB SSD

单盘和

RAID 0

却在

64KB

顺序写和

8KB

顺序读测试中出现了很大的反差,这是为什么呢?

1、

消费级

SSD

的峰值写带宽与

触发

GC

(垃圾回收)后的写带宽

往往存在一定差距,而组建

RAID 0

的每个成员

SSD

写入数据量只有

1/4

,此时可能还没下降到稳态性能。

2、

8KB

顺序读测试虽然在这里记录的是带宽,但

IOPS

容易成为实际的瓶颈,我们知道

RAID

的

IOPS

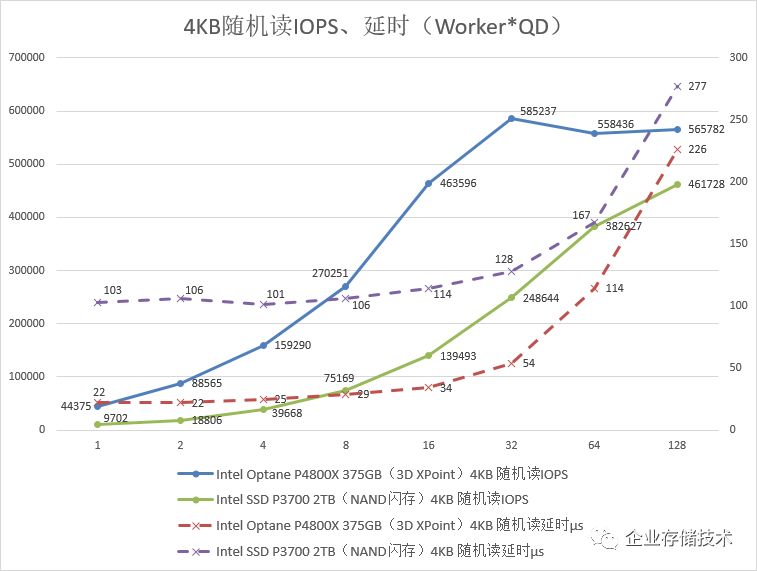

性能发挥往往要依赖于队列深度(高并发)。上面引用了以前的一个测试结果,我还介绍过

SSD

性能的“色子效应”

——同样需要高出闪存通道数许多的队列深度才能充分发挥性能。

工作站的应用大多队列深度不超过

8

,此时

RAID

对小数据块读

IOPS

的价值就很难讲了

。

可能有朋友会问,那为什么

8KB

顺序写的情况不同呢?原因很简单,就是

SSD

有写缓存,数据可以先合并后再写入闪存

,所以与读是不一样的。

看懂

SPECwpc

测试结果,从每种应用

I/O

模型开始

下面我们再来看具体针对每种应用软件的

I/O

测试。

SPECwpc

媒体

&

娱乐

部分

I/O

测试包括

Autodesk 3ds Max

、

Blender

、

Handbrake

、

Maya 2012

和

Adobe CS6

几项。我想有必要让大家能看懂这些测试结果:有的软件读带宽比写带宽高,而有的正相反,其实

Iometer

执行的测试脚本一个读写混合的模型

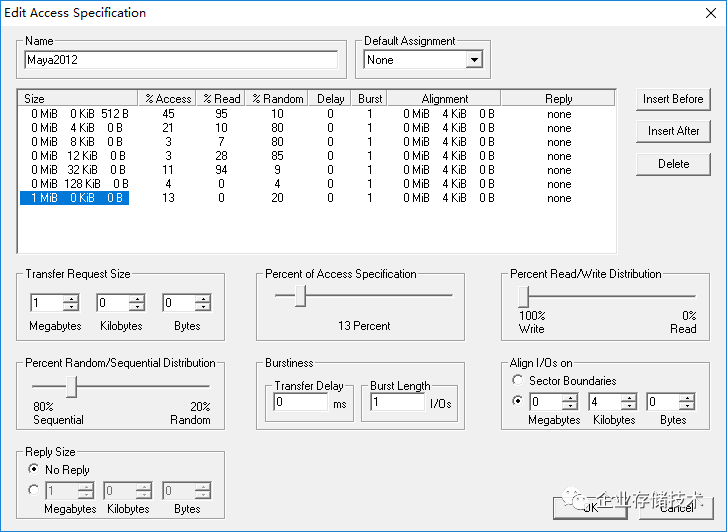

。下面我们以

Maya

为例来讲解:

由于这个

Maya I/O

测试的配置,有

13%

比例的

1MB

数据块访问为

100%

写入,所以最终结果自然是写带宽明显比读带宽大。

在《

图形工作站专业显卡测试:

SPECviewperf12

》一文中,我曾讲过该

BenchMark

是将显示子系统负载从

3D

设计软件中“抽象”出来。而

SPECwpc

的存储测试,则应该是

记录使用者在软件操作中一段时间的

I/O

访问特征

,就像我在《

揭秘

VDI

存储测试:

4

节点

SDS

模拟

12000

虚拟桌面

》中使用的压力模型来源一样。

每个工作站用户的使用习惯特点不同,

SPECwpc

每一个单独的测试模型不见得都有普遍代表性,但是我认为

综合起来整体看是有参考价值的

。这样来看,按照几个行业计算综合

I/O

得分也是合理的。

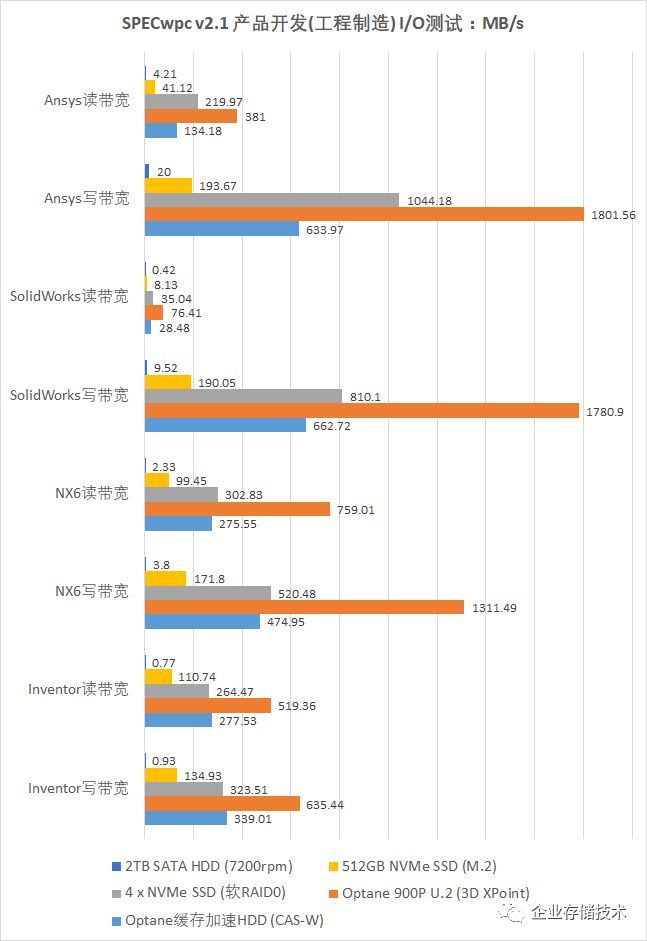

工程制造

中的

PLM

(

CAD

)测试,包含著名的有限元分析软件

Ansys

、达索

SolidWorks

、

Siemens NX6

和

Autodesk Inventor

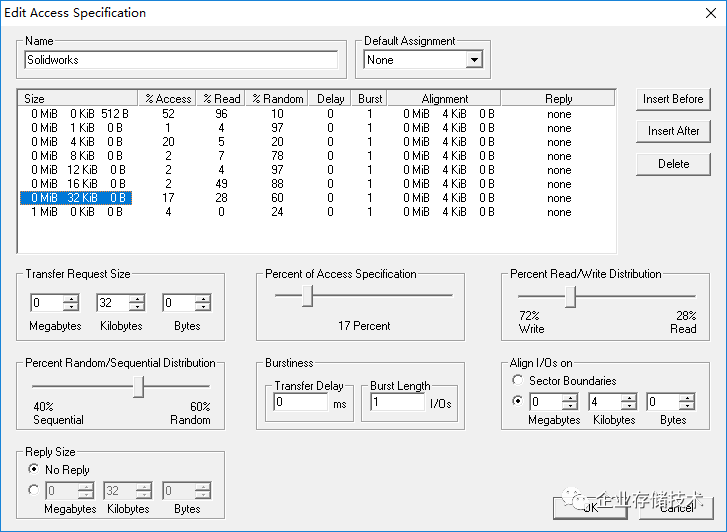

几项,制造业是最主要的工作站应用领域之一。下面我们把

SolidWorks

测试的访问模型列举给大家:

与前面

Maya

测试有些类似,这里

32KB

访问的比例占到

17%

,而且只有

28%

为读操作,因此

SolidWorks

混合测试结果又是写带宽显著高于读带宽。

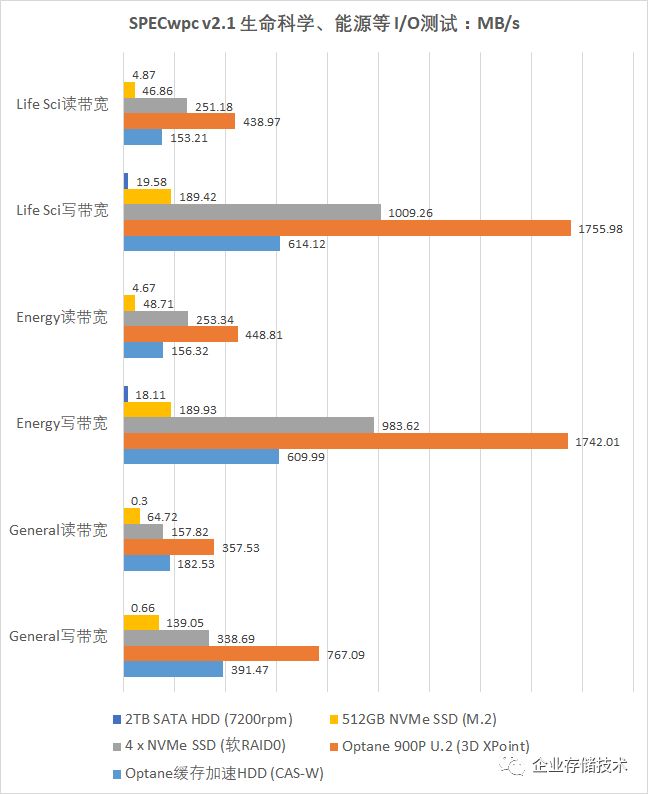

关于

生命科学、能源

和通用

I/O

测试,

SPEC

并没有说明具体是模拟的哪种应用软件。而测试结果的排名顺序,基本上与我们前面介绍的一致。

SPECwpc

测试到此先告一段落,我估计绝大多数读者朋友之前对这个

BenchMark

并不熟悉,下面我再列出一款简单的测试软件做为参照。

没有对比,便没有优劣

。当然这里所说的测试方法好坏,是限定于工作站这个应用领域,如果是一般桌面应用,比较常用的

PCMark

其实也有局限。

CrystalDiskMark

:我是这样测试的

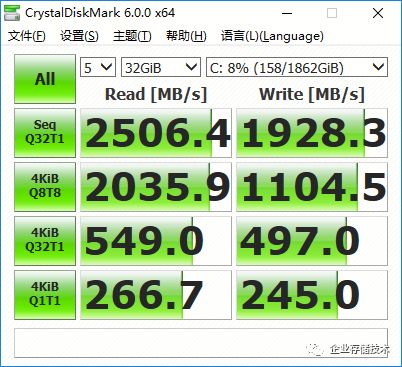

这部分测试我们统一采用

32GB

文件大小(最大设置)

从上面的测试截图,大家可以看出

C

盘是

2TB

的

HDD

,

如果没有

Optane+CAS

缓存软件的帮助,一块机械硬盘肯定跑不到这么高

。

除了对

5

种不同存储配置分别运行上面的默认测试之外,我还调整

CrystalDiskMark

测试参数获得了更全面的性能结果——有点像用

Iometer

来做的事情。而这次我没有用

Iometer

,是因为之前

Optane P4800X

已经测的很详细了(参见《

Intel Optane P4800X

评测

(3)

:

Windows

绑核优化篇

》),

900P

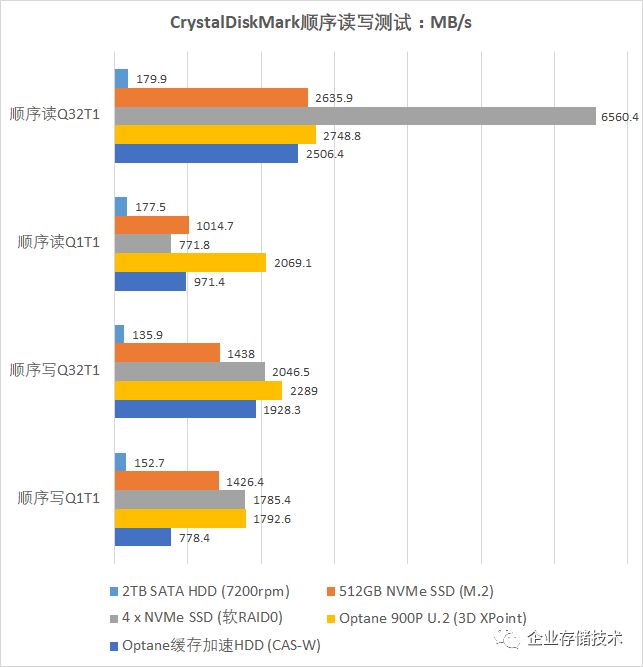

的结果没什么悬念。

在

QD32

(高并发)顺序读测试中,

4

个

M.2 NVMe SSD RAID 0

终于火力全开了一把,超过

6500MB/s

让官方标称

2500MB/s

的

Optane 900P

也望尘莫及。但是普通

闪存

SSD

的读写性能不对称

,另外我们在上文中也提到过,组成

RAID

的

SSD

在

Dell

工作站上还不是最高的性能等级,

Optane 900P

的单盘价值还是能体现出来。

同时我还列出了队列深度

=1

时的带宽结果,这里我们注意到

2

点:一个是顺序读性能与

QD32

时相差比较多;另外

Optane 900P

用于

CAS

缓存加速的表现与原始性能相差较大。说明一下,我用的软件版本

IntelCacheAccelerationSoftware_x64-3.1.0.83

不是最新的,可能当时

Intel

还没充分意识到需要为

Optane

低队列深度下做优化吧?如果想解决这一点的瓶颈,我想应该不困难。

相比上面的图表,用户应该更关心他们的盘在真实应用中能跑多快,这就是我们

下一篇

8K

视频编辑存储测试

的目的。

机械硬盘的随机性能与

SSD

相差太多,在这里数值都不太有必要标出了。

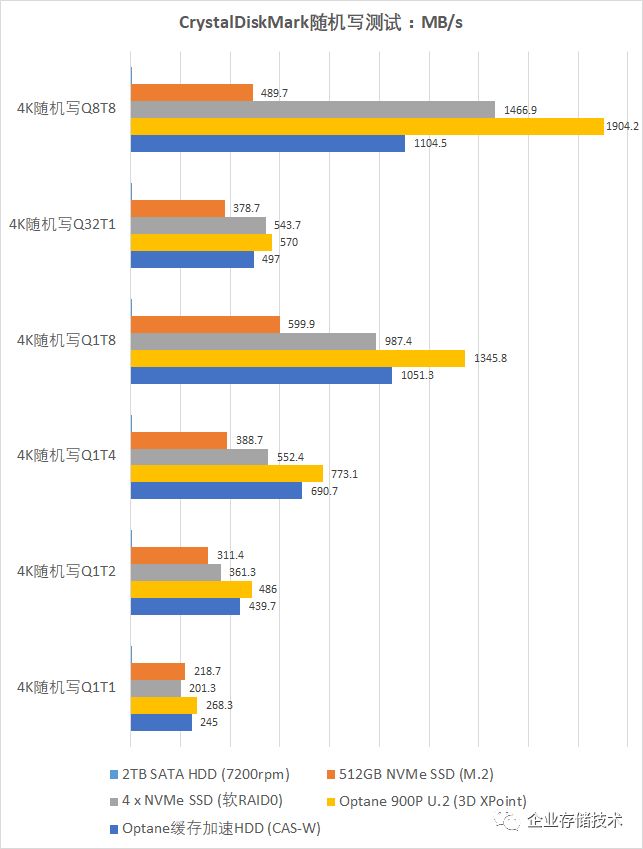

接着看

4KB

随机读,在低队列深度下

Optane 900P

(包括缓存加速

HDD

)基本无敌;

Q32T1

(单线程)是卡在了

CPU

的单核性能上(约

17

万

IOPS

)

;

Q8T8

下

Optane

再次领先。

由于前面提到过的原因,

在这个队列深度下

SSD RAID IOPS

还无法充分发挥

,不过继续提高并发对于工作站也没多大意义。

随机写测试中传统闪存

SSD

与

Optane 900P

的差距缩小了许多,主要还是写缓存的功劳,因为

CrystalDiskMark

每组测试只跑

5

轮

x 5

秒。其中

4KB

随机写

Q32T1

还是可以看到单核

CPU

的瓶颈。

无论

Iometer

还是

CrystalDiskMark

,其测试结果如何对应到具体的业务场景都是一个问题。因此除了我们拿实际应用来评估之外,

SPECwpc

基准测试就成了另一个比较合适的综合参考。

渲染(数据

IO

)时间,越短越好

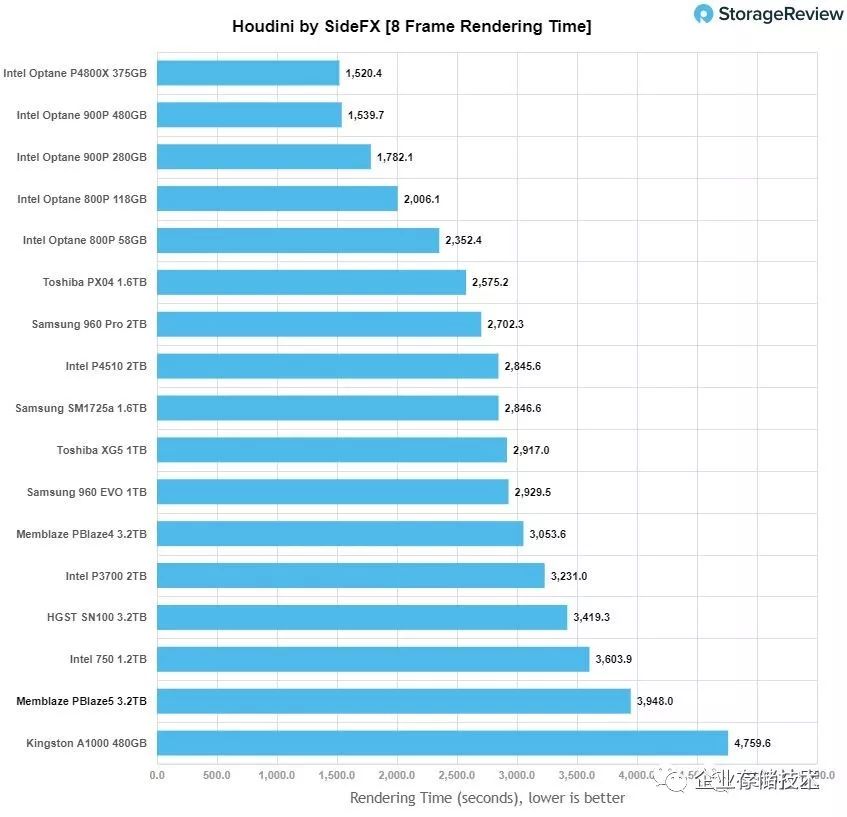

上面我引用了国外网站

StorageReview

的一个测试对比,使用的

Houdini

是工作站上流行的电影特效软件。在这里

Optane 900P

的表现超过了包括

Intel P3700

和

Samsung 1725a

在内的众多知名

NAND

闪存

SSD

。

性能测试小结

简单总结下本文的性能测试,

Optane 900P

凭借

3D XPoint Memory

均衡无损的读写性能、低队列深度优势,更好的写入寿命,使其成为工作站上的存储利器

。即使

4

个传统

NVMe SSD RAID 0

在许多主流工作站应用中也不是它的对手。

这里我又将本文第一个对比图表转换成性能提高比例,以

512G NVMe SSD

做为基准“

1

”,

Optane 900P

在不同类工作站应用中可达前者的

4-9

倍

;当

900P+CAS

缓存加速机械硬盘时,性能也提高到

NVMe SSD

单盘的大约

2-3

倍

。

有的工作站用户习惯将操作系统和常用软件

/

数据装在

256GB

或者更大一些的

SSD

,更多的“冷数据”存放于机械硬盘。如果这时觉得普通

SATA/NVMe SSD

还不够快,换成

Optane 900P

预计能显著提高工作效率

。

进一步考虑单位容量成本(性价比),我想不少用户每天频繁访问的热数据应该在

100-200GB

以内,这样拿

280GB Optane

作为缓存盘结合廉价大容量的

HDD

,对于大多数工作站用户都是一个值得考虑的不错选择

。在我们的测试中,这一组合性能表现全面超过了单个

NVMe SSD

,其加速效果远非之前

16/32GB

的

Optane Memory

可比。

再谈Optane SSD

热插拔的意义

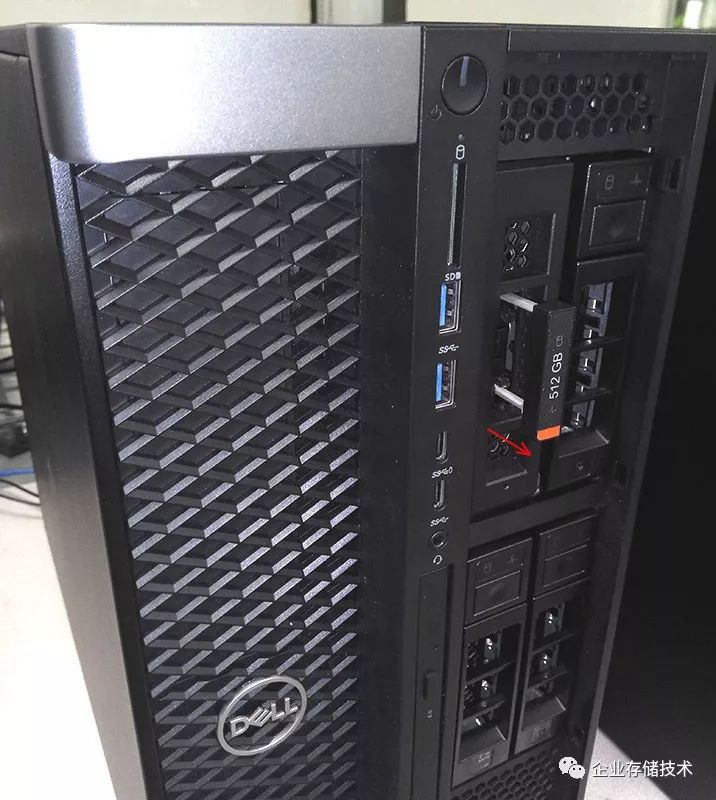

之前我介绍过,

Optane 900P

就安装在这个热插拔

M.2 SSD

右边的位置。

在上一篇中我讲过,

Dell

在新一代工作站上采用前置热插拔盘设计的一个意义是

数据安全

,而我认为

2.5

英寸

U.2

热插拔

Optane 900P

在缓存应用中也有独特的价值。

比如用户采购一批工作站,起初并不确实其中哪些更需要存储加速,同时也是为了尝鲜

Optane

做

Cache

的效果,可以先购买少量

Optane SSD 900P

。这时有了前置热插拔,就可以

方便地将缓存盘在不同机器之间移动,把好钢用在刀刃上

,并且后续添加缓存盘也是很方便的。

这张截图是停止

Cache

操作时,正在将脏数据回刷到永久存储的过程。

对缓存盘进行热插拔之前,强烈建议先停止

CAS

的

Cache

状态,特别是在

Write Back

缓存模式下这样做能避免数据丢失。如果使用普通

M.2 NVMe SSD +

缓存软件来加速机械硬盘,前置热插拔也能带来同样的价值。

以上是

Optane 900P

工作站应用评测的第二篇,相信

下一篇

8K

视频编辑测试

会更精彩

…

注

:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。

进一步交流

技术

,

可以

加我的

QQ/

微信:

490834312

。如果您想在这个公众号上分享自己的技术干货,也欢迎联系我:)

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:

HL_Storage

长按二维码可直接识别关注

历史文章汇总

:

http://chuansong.me/account/huangliang_storage