1.为收购NXP融资,高通发债百亿美元获四倍认购;

2.并购频发,全球半导体市场趋向集中;

3.第二代TPU带来更大运算效能, 但应用领域仍有局限;

4.澳洲科学家用纳米管在芯片上培育脑细胞

集微网推出集成电路微信公共号:“天天IC”,重大新闻即时发布,天天IC、天天集微网,积微成著!点击文章末端“

阅读原文

”或长按 laoyaoic 复制微信公共号搜索添加关注。

1.为收购NXP融资,高通发债百亿美元获四倍认购;

集微网消息,据金融时报报道,高通发债筹资110亿美元,认购金额竟四倍于发债规模,可见全球投资人对美国高收益公司债仍趋之若鹜。

金融时报引述知情人士报导,高通19日顺利完成九种不同到期日的发债,在美国今年以来发债规模名列第三,吸引认购规模超过400亿美元。

Invesco经理人Matt Brill形容需求「超标」,因为全球股市当周一度崩盘,应该多少会影响投资人的兴致。 他说,美股周四和周五反弹,为高通带来转机。

高通筹资所得将用来支应并购恩智浦半导体所需。 高通以470亿美元并购这家荷兰半导体公司,加快投入车用电子市场的脚步。

全球利率仍低,加上欧、日央行货币政策仍保持宽松,吸引投资人涌向美国信用市场寻求收益。 据Lipper统计,美国投资级公司债基金今年流入近550亿美元。

2.并购频发,全球半导体市场趋向集中;

根据调研机构Gartner最新公布的2016年半导体市场规模最终统计报告,当年全球半导体市场规模为3,435.14亿美元,较2015年3,349.34亿美元,成长2.6%。

Gartner研究总监James Hines表示,2016年半导体市场,由于一开始时的库存调整,使得市场需求疲弱,而引发不少担忧。他指出,全球半导体营收成长主要受惠于诸多电子设备领域产能增加、NAND Flash存储器价格改善,以及相对有利的汇率走势,因此2016全年全球半导体市场整体表现大幅优于2015年。

然而随著各半导体业者彼此间的收购或整并案不断,2016年全球营收前25大半导体业者合计营收,较2015年前25大增加了10.5%。相较而言,当年营收前25大以外的所有业者合计营收,则是大幅下滑了15.6%。这意味,全球半导体业市场,正在趋向主要业者集中。

资料显示,2016年全球营收前25大半导体业者合计营收,已占当年整体半导体市场规模的74.9%。

而在2016年前十大半导体业者中,英特尔(Intel)与三星电子(Samsung Electronics)营收分别年增4.6%,与5.9%,以540.91亿美元与401.04亿美元续居全球前二大。

高通(Qualcomm)与SK海力士(SK Hynix)营收虽然分别年减4.1%,与10.2%,但仍以154.15亿美元与147.00亿美元,位居全球第三与四名。2015年SK海力士排名为第三,高通为第四。

至于2016年全球营收排名第五的业者,则是由原名为安华高科技(Avago)的新加坡半导体业者博通(Broadcom)取得。安华高于2016年初完成对美国芯片设计业者博通购并作业后,将合并后的新公司仍命名为博通。

新成立的博通2016年营收大幅年增191.1%,达132.23亿美元。营收排名也由2015年的17,跳升为2016年的第五。

2016年营收排名因购并案而攀升的业者尚包括,如购并快捷半导体(Fairchild)的安森美半导体(ON Semiconductor),以及购并新帝(SanDisk)的威腾(WD)等。

Gartner表示,如果将各收购案中的收购者与被收购者营收回归至原个别业者来计算的话,那么2016年营收前25大半导体业者合计营收,仅较2015年前25大成长1.9%,前25大以外所有业者合计营收,则会较2015年成长4.6%。

资料显示,台湾地区芯片设计业者联发科2016年营收为87.25亿美元,年增30.1%。该公司2015年与2016年营收排名均为第十 DIGITIMES

3.第二代TPU带来更大运算效能, 但应用领域仍有局限;

对于标榜可发挥高达180TFLOPS的第二代TPU (Tensor Processing Unit),Google说明此项处理器依然是针对开放学习框架TensorFlow加速为主,因此无法像NVIDIA提出Tesla V100等GPU加速模式可额外支持Caffe、Cognitive Toolkit等学习框架。

相比第一代TPU仅能针对逻辑推演作加速,Google此次宣布推出的第二代TPU不但大幅提升运算效能,更增加对应深度学习应用加速设计,配合越来越多人使用的TensorFlow学习框架,将使TPU应用领域变得更加多元,甚至直接挑战NVIDIA以GPU加速的深度学习应用模式。

不过,在Google I/O 2017期间进一步向Google询问,确认第二代TPU设计依然是以针对开放学习框架TensorFlow加速为主,本身并不像NVIDIA Tesla V100等藉由GPU加速模式可额外支持Caffe、Cognitive Toolkit等学习框架,因此在实际布署应用弹性可能相对受限。 只是从TPU大幅去除非必要组件,仅针对深度学习、逻辑推演加速功能优化,预期仍将使NVIDIA面临不少竞争压力。

但从NVIDIA为使加速学习效率提升,在新款加速卡Tesla V100架构设计额外加上对应TensorFlow学习框架的Tensor核心,藉此让深度学习效率可进一步提升,显然也是呼应越来越多藉由TensorFlow学习框架产生的深度学习应用需求,同时更有向Google说明GPU加速仍有较广泛应用的叫阵意味。

而对于开发者需求部分,Google方面则认为无论是什么样的加速学习模式都有其优点,例如聚焦在TensorFlow学习框架的深度学习,或许第二代TPU能带来更好加速学习效率,但若是针对TensorFlow以外学习框架应用,NVIDIA的Tesla V100显然就有较高使用弹性,因此主要还是看本身设计内容挑选较合适的学习模式。 同时在越来越多的选择之下,对于开发者所能使用资源、带动市场发展动能都能带来好处。 经济日报

4.澳洲科学家用纳米管在芯片上培育脑细胞

[摘要]研究人员在芯片上安装一个纳米管支架,上面放置脑细胞,加入培养液,观察细胞生长,目的是了解大脑神经元是怎样建立回路的。

腾讯数码讯(天空之城)信号从一个神经元出发,抵达另一个神经元,如是形成了人类思维。这些连接是怎样形成的?我们所知甚少。为了了解脑信号的处理过程,澳大利亚科研人员在半导体芯片上造了一个纳米管支架,它可以帮助脑细胞生长、形成回路。最近,科研人员在《纳米通讯》(Nano Letters)杂志上介绍了新设备。

未来我们也许可以看到大脑芯片,不过科研人员开发的神经支架相去还很遥远。澳大利亚国立大学生物材料工程师高塔姆(Vini Gautam)说,它的确可以帮助科学家了解神经元是怎样生长的,又是如何连接的。

要在实验室重建神经元回路,对科学家来说一直是一个挑战。大脑神经元的连接与沟通方式是有秩序的。但在实验室内细胞的重建却是随意的,受到实验条件的限制,回路与真实大脑的回路不一样。

高塔姆说:“理解大脑神经元回路是如何形成的,这是神经科学的一个根本问题。”连接成为人类处理信息的根本,理解连接可以帮助人类找到治疗精神疾病的有效方法。

高塔姆和同事创造一个环境,引导神经元生长,让它们建立自然、协同的连接。为了达到目标,研究团队制造了一个纳米管支架,它是用磷化铟制造的。这种半导体材料用在纳米电子中,所以相当有名,比如制造LED、太阳能电池时就会用到它。高塔姆说,没有人用磷化铟与大脑细胞建立连接。

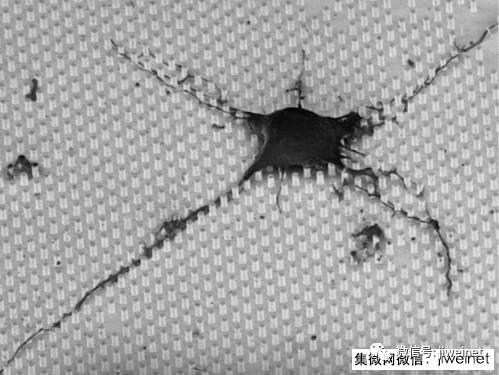

研究人员将纳米管排列成方形网格,每个支架上放置约50个啮齿动物的脑细胞,然后加入培养液,观察它们的生长状况。

几天之后,神经元生成了神经突。在大脑内部,长而薄的神经突从细胞体伸展出来,与其它神经元连接,结点就是突触。在高塔姆的纳米管支架上,神经元长出神经突,它们在晶格上扩张,通过突触与其它细胞连接。

高塔姆说:“我以前观察过许多神经元细胞。”不过这些神经元细胞的生长是随意的。她还说:“这一次不同,我用显微镜观察支架,发现一个惊人的现象:细胞的突触以直线的形式排成网格。”

这是一件好事,意味着突触的生长是可以用支架的形状引导的,研究人员可以控制它的生长。与此同时,细胞以自然的方式连接,细胞之间的通信也是协同的,正如大脑一样。将上述因素整合在一起,我们就可以得出一个结论:支架是一个很好的平台,可以帮助科学家研究生物神经元回路。

研究团队用扫描电子显微术监控细胞的生长,用功能性钙成像技术评估神经元的沟通效果。

现在研究团队已经优化了支架,它可以更好模拟大脑的生理特征,研究人员用它调查神经元回路的形成机制。高塔姆希望他们可以最终开发出大脑假体,如果人的神经元回路因为受伤或者疾病出现问题,可以用假体修复。

来源:ieee

集微网推出集成电路微信公共号:“天天IC”,重大新闻即时发布,天天IC、天天集微网,积微成著!点击文章末端“