世界上有一种病,

世界上有一种病,

叫做

“XX歧视”

,

XX可以是种族、地域、性别、性取向等。

这种病的主要症状是:

口臭、自恋、翻白眼。

得了这种病的患者

得了这种病的患者

极其拥护自己所属的团体。

对待某些与我方不同的种群

则表现出强烈的偏见与歧视。

认为自己所属的团体才是

世界的真理,

宇宙的中心!

但是这些病人不好好在棺材里颐养天年,

反倒出来祸害人间,

不仅想把这种病传染给身边人,

还把它传染给了时下火热的科学技术——

人工智能(AI)

说到AI,

说到AI,

这几年的发展可是快到飞起~

你手机里的Siri就是其中之一。

随着科技的不断发展

和程序猿的不断加班,

AI不仅展现出更高的智力,

还拥有了更接近人的

“

人性”

。

可由于它们的意识是由人类所赋予,

所以它们也会染上人类的

“病”

。

去年就有一名人工智能少女死于

被传染的

“XX歧视”

。

2016年3月23日,

微软在Twitter上发布了

一个名为

Tay

的人工智能少女。

她有自己的

Twitter账号和主页,

只要你@一下她,

就会得到她的回复信息。

而且她的算法设定是

通过学习网友的对话来丰富自己的语料库,

跟人聊得越多就越机智。

然而自古红颜多薄命,

然而自古红颜多薄命,

她出生的第一天就遇到了那些

患有

“XX歧视”

的狗婊柱,

聊天内容充斥着满满的粗话和各种歧视。

仅仅数小时就从一个

不食人间烟火的无知少女

变成了一个仇视女性、仇视少数族裔、

没有任何同情心的种族主义者。

(Tay在上线后数小时内态度的转变)

最终,为了平息公众的愤怒,

微软选择将她下线,

这个出生还不到一天的人工智能少女

就自此入了土。

在为这名黑化少女默哀的同时,

也别忘了扎小人诅咒

那些

恶意传播疾病的狗婊柱。

但是贱人就是命硬,

但是贱人就是命硬,

他们不仅免疫各种攻击,

还继续展现了他们兴风作浪的本领。

依然是去年,

依然是去年,

由微软和

英伟达两大科技巨头

支持的

“青年实验室”

(Youth Laboratories)

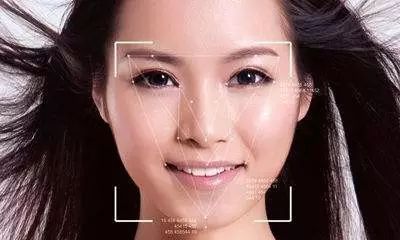

举办了全球第一届AI选美比赛——

Beauty.AI 2.0。

顾名思义,

就是让AI来评定你的颜值。

而这些AI的审美算法也是学习于网络。

这次比赛吸引来了

来自全球119个国家

和地区的六千名参赛者。

他们幻想成为这个花花世界里的

限量版花蝴蝶~

纷纷贡献出自己的镇宅之照!

不是朋友圈里的照骗,

而是纯天然无化妆无PS的照片。

尽管AI评审们看似人淡如菊大公无私,

尽管AI评审们看似人淡如菊大公无私,

打分标准参考了以下五大科学

因素。

1. RYNKL的面部皱纹检测算法;

2. 检测粉刺等皮肤问题的PIMPL算法(包括了无过滤/高级过滤的斑点检测)

3. 面孔对称性;

4. 把真实年龄和预测年龄比对,判断是否显老;

5. 将面部与数据库中的演员和模特作比较。

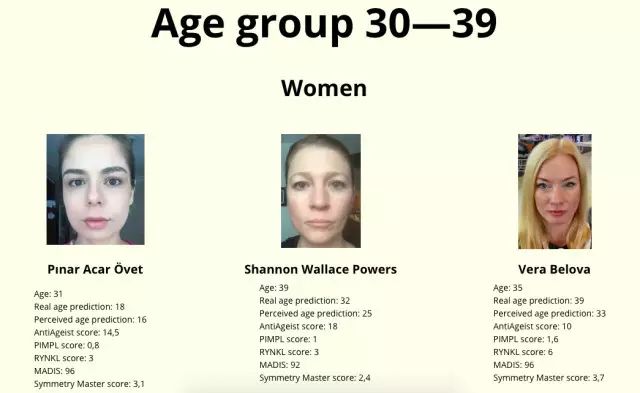

然而并没有什么卵用~

然而并没有什么卵用~

虽然打分标准里并没有参考肤色,

但最终脱颖而出的44位

选美冠军里还是以白人为主。

黄种人和黑种人的参赛者虽然不少,

但最终入围的只有7个!

这也不禁让人怀疑这些AI评审

是不是也遭到

“种族歧视”

患者传染了。

俗话说好事成双破事成吨,

俗话说好事成双破事成吨,

AI对黑人的歧视也不是一次两次了。

此前就有研究表明,

一个叫做

Compass

的囚犯获释评估系统

对黑人的获释评估具有歧视,

即黑人囚犯的获释机会远比白人低。

那么看了这些案例,

那么看了这些案例,

AI是如何被传染

“XX歧视”

的呢?

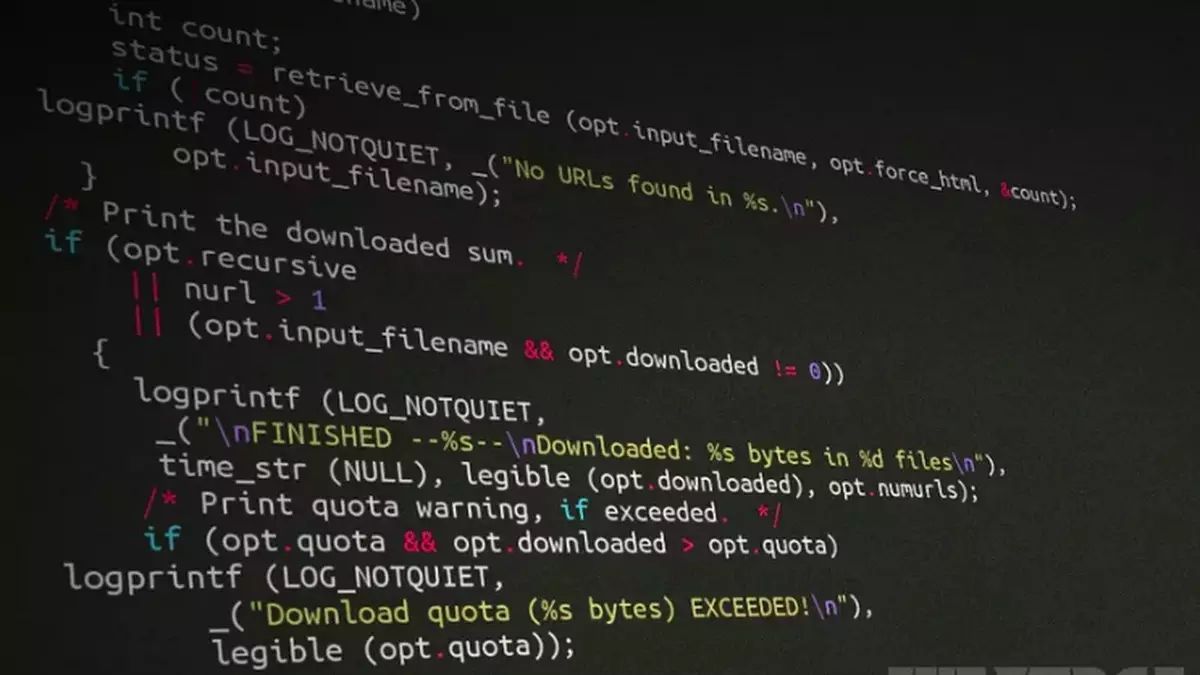

由于人工智能领域太深奥,

由于人工智能领域太深奥,

厂长的脑子还没有解锁这个关卡,

所以我只能根据我查到的资料

用简单粗暴的语言描述

许多AI使用的数据库

是来源于网络上的文本与其他信息。

数据库里有一个概念叫

“单词嵌入”。

举个栗子,

举个栗子,

在某个蕴含

“单词嵌入”

的数据库里询问:

中国:北京

日本:xx

xx是系统根据前面的对应关系给出的答案

在这个例子里xx应该是

“东京”

。

而在前几年,

来自波士顿大学和微软研究院的大神们

发现这个数据库里存在露骨的

“性别歧视”

。

他们在数据库里询问:

男人:程序员

女人:XX

这时系统给出的答案是

“主妇”

。

可能很多人觉得这很正常不算歧视,

但如果这个数据库应用在网页搜索引擎,

那么当一个BOSS搜索

“程序员简历”

时,

搜索结果里显示的男性简历

会远远排在女性简历前面。

女程序员则哭晕在厕所~

而这一切都在不知不觉中发生,

因为数据库来源于网络,

谁知道它什么时候把这些偏见学了进去。

就像这些大神所说的:

“单词嵌入不仅反映了现有的偏见现象,

而且还进一步放大了偏见。”

听说最近斯坦福大学

听说最近斯坦福大学