5月21-22日,由中国人工智能学会和中国中文信息学会联合主办的“2017全球人工智能技术大会”在北京国家会议中心隆重举行。

首次于2016年举办的全球人工智能技术大会,已发展成为中国人工智能技术和产业领域规模最大、影响力最强的年度盛会。2017年,汇聚了上百位全球人工智能学术界和产业界著名学者、顶级专家和业界精英,以及上千位人工智能领域技术专家、创业者、投资家以及爱好者,在“交叉、融合、相生、共赢”的主旋律下,共同探讨人工智能发展的科技创新与行业变革战略,破解人工智能创业和商业模式的密码。

本次大会主席由中国人工智能学会理事长李德毅、IBM中国研究院院长沈晓卫担任,嘉宾到场有美国微软研究院技术院士黄学东、华为诺亚方舟实验室主任李航、联想首席技术官兼高级副总裁芮勇、中科院沈阳自动化所所长于海斌等。

数据堂程兰颖,在大会上针对智能驾驶领域做出主题演讲:数据助力智能驾驶体验

以下是演讲实录

邓伟文/主持人:程女士多年从事智能人机系统的研究和应用领域的开发,先后在声学所,Nuance海外和中国工作,早年专注于语音识别的研究,发表过多篇相关论文,近10年在人工智能的应用领域涉猎比较多,从事智能手机、智能客服和智能汽车的应用设计和开发,加入数据堂以后,负责公司的技术和产品设计相关工作,我们有请她为大家分享

程兰颖:之前在人工智能领域,最为专注研究的是语音方面,从去年加入数据堂以来,专注于在数据这块,数据和人工智能之间的关系,我想大家都很了解,也不言而喻,数据是一个非常重要的方面。我喜欢用一个比喻,数据跟算法之间的关系,如果数据是一个教材,那么算法就像是一位老师,老师用教材去教导你未来想要产生的人工智能任何一个应用,比如说在今天的论坛上,智能驾驶,智能驾驶我们想让它成为智能应用的一个孩子。

我们先看一下智能驾驶,大家讲了很多在自动驾驶方面的事情,未来我想从另外一个角度,从纯体验的角度,作为一个车的车主,在未来的几年我们可以期望,我跟自己的车可以成为伙伴关系,我跟它之间需要有交互,而且这个交互可以是多模式的。

同时,比如说我们讲车的自动驾驶,除了现在一般提到的5个不同的级别,未来我们希望能够达到最高的级别,在第5个级别完全把我载到目的地。同时它需要在自动层面做到自动控制,就是我能自动控制调节车内的温度,可以自动控制车内的娱乐设备,这是自动控制方面的。同时,也需要有一些共享的方面,我的共享的信息,可以是车与车之间的,比如说前方的车碰到了交通事故,它把交通事故的信息分享给大家,车与车之间的信息分享,当然车内的乘客也可以有一个信息的分享。所以在这几个方面呢,大家可以想象一下,未来你下了班,你告诉你的汽车五分钟以后到大楼门口等我,进了车以后,告诉车把我的座椅调整到60度,告诉它从最近的距离载我回家。在这个过程中,汽车启动了,把你载回家,在车中收到了汽车中心控制器发生的信息,告诉你有一个紧急的邮件需要你签字控制,你通过手工的签字,然后语音控制发送它,发送给你的秘书,你回到座椅上继续享受旅程。回家路上,你从中控中心收到这样一个信息,告诉你前方有事故,同时给了你几个选择,可以绕开事故现场,这个状态下你跟你的车有一个交互,而不是你希望从某一条路线绕过这个交通事故,你告诉你的车从这里绕过。在整体的体验下,我们期望我们的车未来自动做一些事情,能够真的成为你的伙伴。

为了达到这个愿景,很多嘉宾和在座的各位,都在做不懈的努力,刚才有嘉宾分享了硬件方面和软件方面的东西,这些事情在未来的自动驾驶和智能驾驶里也是需要达到高度的融合,比如有不同的传感器,有声音传感器,有照相机,还有雷达显示器,和GPS,它们得到的信息通过控制器进入中央处理器,中央处理器通过识别和算法,得到最终的判断结果,当然它需要进入到你的不同的终端,比如说我要听音乐,你告诉它播放刘德华的音乐,它就需要从音乐控制终端播放音乐,从最近的距离回家,自动驾驶需要执行这个命令。在整个过程中,虽然还有很长的路可走,但是未来整个技术的发展和融合是不可避免的。

在这个过程中,数据也是很重要的一个方面,我们在数据堂有幸对智能驾驶领域做了一些关于数据方面的尝试,形成了一系列的数据集,服务于刚才我提到的各个算法,各个不同的智能算法,这些数据集包括用于刚才我说到的交互的数据集,比如说语音交互,文字交互,手势交互,我们有一类是称之为交互的数据。另外一类就是自动驾驶类的数据集,不言而喻,刚才很多嘉宾都提到了自动驾驶,大家都在做软件硬件和算法,为了满足大家对于各种不同驾驶算法的需求,我们在自动驾驶数据集里做了不同层面的标的,给大家一些数据集。

首先给大家介绍一下交互方面的数据集,我们有两方面的东西,一个就是基础数据,基础数据的变化在于说,我们有很多不同语言,包含很多不同语言,包括国内的普通话和方言,去年大家很关注上海话,上海话最近方言领域里比较常用的交互语言,同时有欧洲语系和亚洲语系的其他语言。年龄是分为成年和青少年,年龄涵盖是从3岁到了70岁的年龄,作为一个基础数据集大也知道它的口音覆盖非常重要,所以对于我们来说,我们在数据集的生产过程中,任何一种语言都会涵盖语言的各个不同的区域,作为基础数据集,它的内容是通用的内容,包括一些体育、娱乐、商务,当然也包括我们在语音交互过程中常用的东西。大家对比一下基础数据和车载数据,车载数据是我们专门为车载环境采集的数据,它在场景和内容上就有一些不同,内容我们可以看到,在这个数据集里,内容除了通用的语料之外,还会加入控制命令,一些地址,一些音乐方面的内容,这个是针对车内的应用场景而做的一些变化。同时,在场景方面,车在不同的驾驶环境下,在不同的路况下,比如车速、车窗我们都有一些考虑。对于车载数据和基础数据集,我们做了一个简单的算法,做算法的研究者,他研究算法的提高,通常他们做的测试是基于这个测试集,在这个算法下面的算法改进,能够让我的效果改进多少,对于我们做数据的,我们做的是在不同的数据集下面,基于同样的算法,我的效果能够提升多少,我们有做过一些基础的测试,对于车载的测试,在车载环境下基于同一算法,我们有10%到30%的提升。这是语音交互方面的。

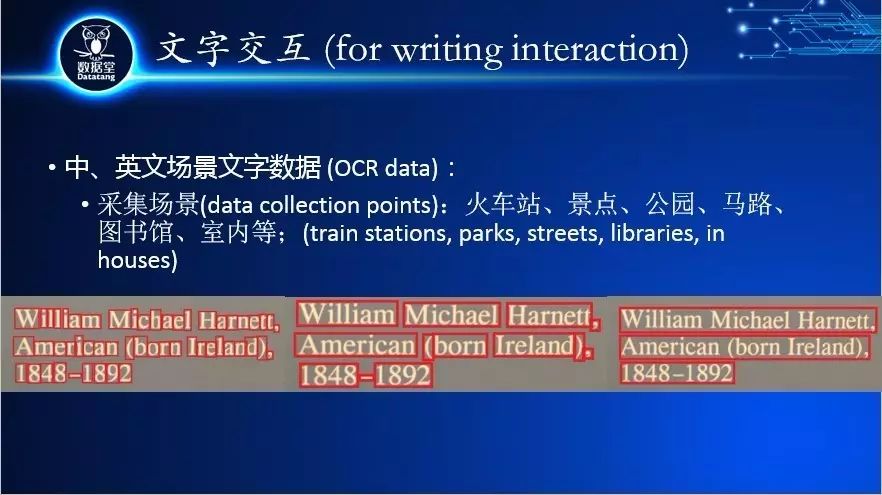

另外,从我们分享的愿景来看,我们在车里有可能用到文字,目前有中英文场景文字输入,这是我给大家的样例,在不同的场景下,比如火车站、公园、图书馆、马路、室内,不同场景下实拍的一些照片。下面我没有写相干这类的文字交互我们还要做手写体,因为现在在车里,大家去打字这个事情很难实现,所以下一步会做手写体的数据。

回到我今天重点跟大家介绍的自动驾驶的数据,这个数据是我们今年刚刚生产的,目前第一期已经做完了,下半年还有计划做第二期。这套数据它的硬件,它实际上是相机拍摄的图片,我们有两种相机,这两种相机具体的规范我不跟大家一一念了,虽然在设备上有小小的不同,但是基本上这两个相机功能差不多,我们拍摄的时候,它安装的位置是前车窗上端的中心位置。采集范围,大家知道业内有一些比较开放的数据集,最近(英文)也有数据集出来,我们这个数据集它的采集范围是在全国范围内,就是中国全国范围内不同道路的路况,下面我会跟大家介绍一下对于道路类型分类的状况。采集的时间是从早上8点到下午6、7点,有一些知道光线也是有变化的。

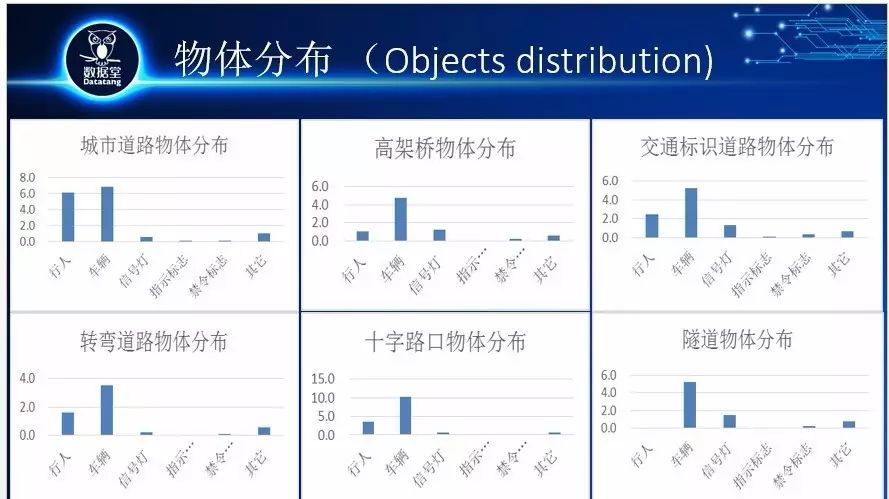

就采集地点的细节,我们说是全国,但是我们就采集规范的细节做了一些分类,对比较有特点的路段,进行一些特别的关注,比如在城区的德国,有交通标识的地区我们要进行采集,然后就是转弯的地方,还有十字路口,有交通等灯的地方,还有隧道里比较暗的地方。从采集地点来讲,我们对这几个地点有一些特别的标定。

物体分布,针对刚才所说的几个不同的采集地点,物体的分布是有不同的,大家可以看到,比如在城市、城区、行人、车辆很多,隧道里几乎没有什么行人,其他地方可以看到,有一个特点,我们选择的路段,或者说我们选择做标定的图片,车辆是比较多的,因为大家做算法的时候,一个很重要的目标,就是要检测到前方的车,所以对象我们选择的这些做过标定的路段,对于车辆的数目还是不少的,因为我们在拍摄的过程中,虽然有很多的原始的图片,但是在标定的图片,我们做过一些选择的。

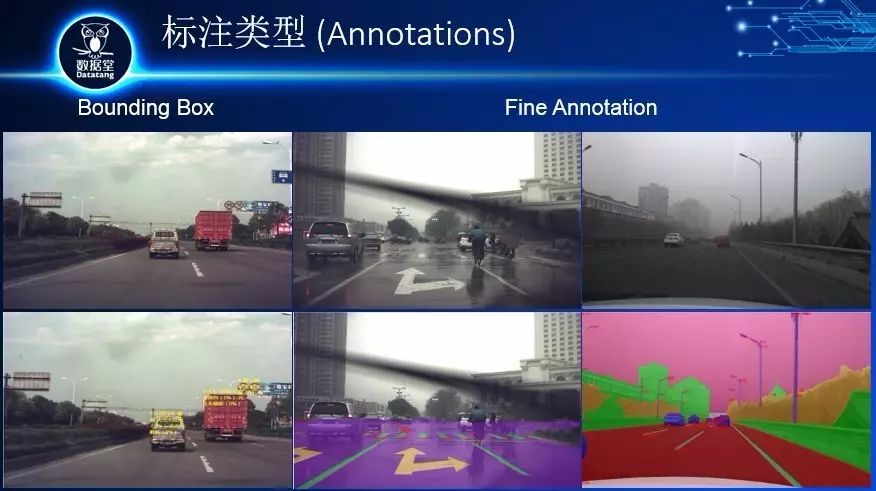

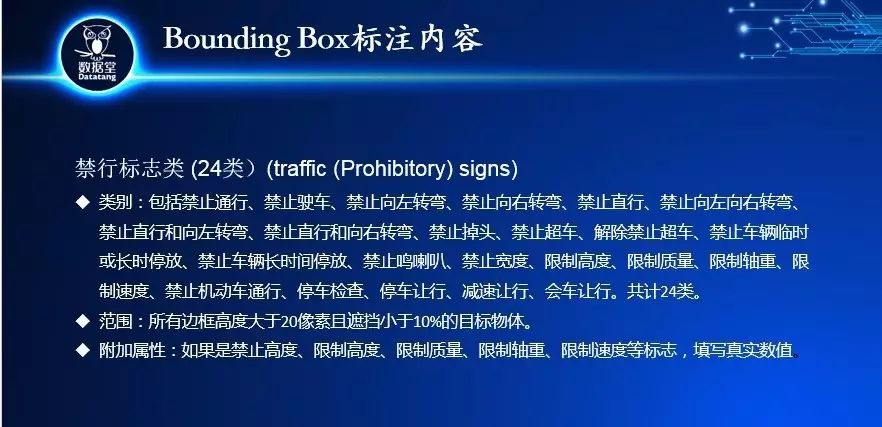

标注的类型,配合大家做算法的方式,标注的类型也有几个不同的方法,一个就是标Bounding Box,这个是原图片,这个是标注过以后的图片,除了标注框以外,我们对它的属性也做了标定。另外一个标定方法就是Fine Annotation,这是像素级的标定,我们有两种不同的标定,一个是针对道路线和道路上的指示标识做的标定,另外一个就是对全景,包括天空,周围的树木和建筑做的标定。

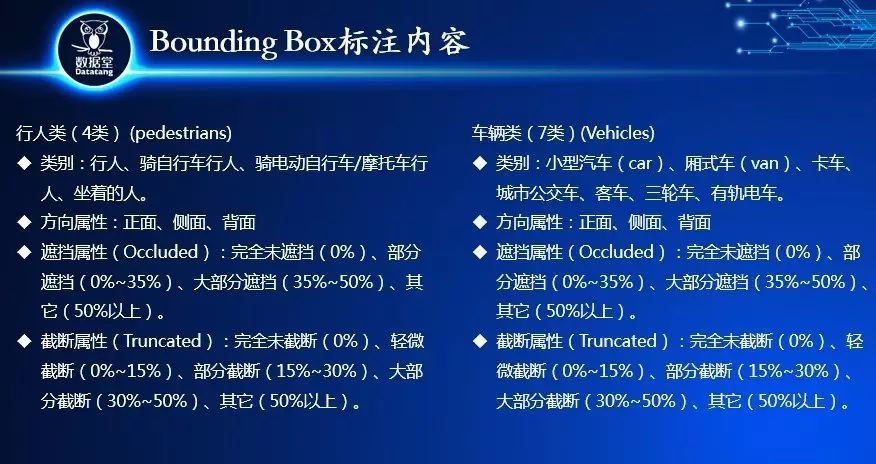

这是我们标定的内容,现在加起来应该有76类,是目前标定数据集里比较全的数据集,行人类就标定了4种,一种是普通的行人,然后是骑自行车的,然后骑电动车或摩托车,还有坐着的。车也是7种类型的车,包括方向,遮挡属性,截断属性,这里都有一些详细的定义,我不跟大家一一念了,大家如果有细节的需求,可以下来联络我。

我们或对信号灯和指示标志类也做了标注,信号灯做了10类,指示标志类30类,包括所有常见的指示标识。后面还有标的另外一大类,就是禁行标识,包括禁止通行,禁止左转等方面的一些禁行标识类的标注,前面几个类型包括红绿灯标识和禁行标识,人和车,这是用Bounding Box标定的。

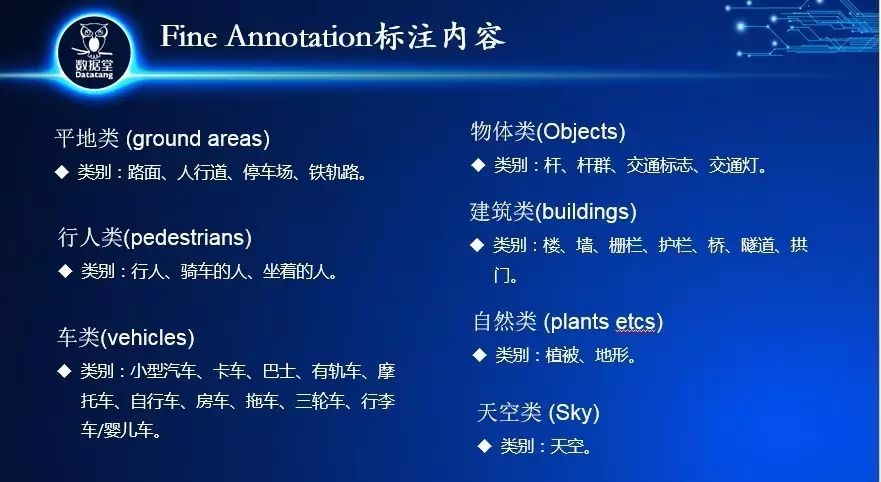

下面看一下Fine Annotation,Fine Annotation增加了路面标识,就是道路线的标识,就是路面所有的道路线和指示标识的Fine Annotation。对于道路上的东西,我们标注了这样几类,一个是路面的指示标识,还有道路线,还有路面上的限速标志,还有道路的边界线,这几类是我们在Fine Annotation对于道路标注的方法。比如在划框类标识的人和车也都做了标注,我们还增加了这几类,全景类标注,指一张图片里,把所有的物体都做标识,所以增加了一些平地,比如路面和人行道,不属于我们标注的范围内,我们也把它在全景类标注里标定出来了,还有一些物体,包括电线杆东西,路边的建筑,天空,云,等于一张图片里所有物体都进行了标注,这是全景类标注的方法。

下面看一下Fine Annotation,Fine Annotation增加了路面标识,就是道路线的标识,就是路面所有的道路线和指示标识的Fine Annotation。对于道路上的东西,我们标注了这样几类,一个是路面的指示标识,还有道路线,还有路面上的限速标志,还有道路的边界线,这几类是我们在Fine Annotation对于道路标注的方法。比如在划框类标识的人和车也都做了标注,我们还增加了这几类,全景类标注,指一张图片里,把所有的物体都做标识,所以增加了一些平地,比如路面和人行道,不属于我们标注的范围内,我们也把它在全景类标注里标定出来了,还有一些物体,包括电线杆东西,路边的建筑,天空,云,等于一张图片里所有物体都进行了标注,这是全景类标注的方法。

我的介绍就到这里,这里缺的数据大家很明显看出来,激光雷达数据所产生的照片,后面还会有这些数据的规划出来。谢谢大家。

邓伟文/主持人:你的标注是自动标注还是手工标注?

程兰颖:标注是自动+手动的检测,纯自动的准确率达不到标准,我们的准确性是给做算法的人做标准的,准确率一定要很高,一般我们的准确率都会在95%以上,这是我们普通的标准。

邓伟文/主持人:标注的效率有多少?

程兰颖:这个就不一样了,比如说标框的,也就是十几秒左右,但是如果我标后面那种精细标注,可能就需要十几分钟,还有更细的,在智能驾驶里没有,比如有标人物的,都是像素级的,那个时候一个最细的项目,一天只标出几张图而已。

以上是数据堂此次在2017人工智能计划大会上的演讲全部内容,有想了解更多内容的可以留言给堂妹哦。