点击上方

蓝色字体

关注「程序员大咖」

来源:花生!~~

链接:cnblogs.com/yczz/p/6067791.html

前提

由于工作的原因,经常需要对海量数据进行处理,做的数据爬虫相关,动辄千万级别的数据,单表几十个G都是都是家常便饭。 主要开发语言是C#,数据库使用的是MySQL。

最常见的操作便是 select 读取数据,然后在C#中对数据进行处理, 完毕后再插入数据库中。 简而言之就 select -> process -> insert三个步骤。 对于数据量小的情况下(百万级别 or 几百兆)可能

最多1个小时就处理完了。但是对于千万级数据可能几天,甚至更多。 那么问题来了,如何优化??

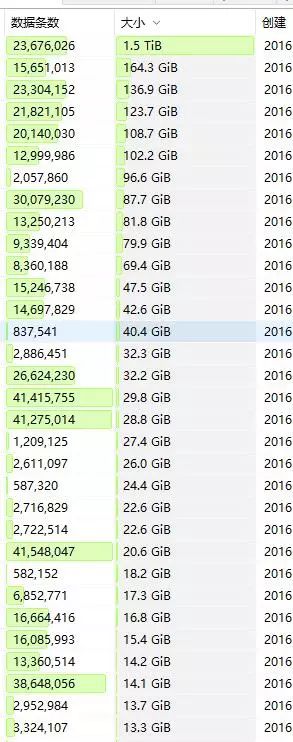

(数据库的一览,有图有真相)

第一步 解决读取的问题

跟数据库打交道的方式有很多,我来列举下吧:

1. 【重武器-坦克大炮】使用重型ORM框架,比如EF,NHibernat 这样的框架。

2. 【轻武器-AK47】 使用Dapper,PetaPoco之类,单cs文件。灵活高效,使用简单。居家越货必备(我更喜欢PetaPoco :))

3. 【冷兵器?匕首?】使用原生的Connection、Command。 然后写原生的SQL语句。。

分析:

【重武器】在我们这里肯定直接被PASS, 他们应该被用在大型项目中。

【轻武器】Dapper,PetaPoco 看过源码你会发现用到了反射,虽然使用IL和缓存技术,但是还是会影响读取效率,PASS

好吧那就只有使用匕首,原生SQL走起, 利用DataReader 进行高效读取,并且使用索引取数据(更快),而不是列名。

大概的代码如下:

using (var conn = new MySqlConnection("Connection String..."))

{

conn.Open();

//此处设置读取的超时,不然在海量数据时很容易超时

var c = new MySqlCommand("set net_write_timeout=9999999; set net_read_timeout=9999999", conn);

c.ExecuteNonQuery();

MySqlCommand rcmd = new MySqlCommand();

rcmd.Connection = conn;

rcmd.CommandText = @"SELECT `f1`,`f2` FROM `table1`";

//设置命令的执行超时

rcmd.CommandTimeout = 99999999;

var myData = rcmd.ExecuteReader();

while (myData.Read())

{

var f1= myData.GetInt32(0);

var f2= myData.GetString(1);

//这里做数据处理....

}

}

哈哈,怎么样,代码非常原始,还是使用索引来取数据,很容易出错。 当然一切为了性能咱都忍了

第二步 数据处理

其实这一步,根据你的业务需要,代码肯定不一, 不过无非是一些字符串处理,类型转换的操作,这时候就是考验你的C#基础功底的时候了。 以及如何高效编写正则表达式。。。

具体代码也没法写啊 ,先看完CLR via C# 在来跟我讨论吧 ,O(∩_∩)O哈哈哈~ 跳过。。。。

第三部 数据插入

如何批量插入才最高效呢? 有同学会说, 使用事务啊,BeginTransaction, 然后EndTransaction。 恩,这个的确可以提高插入效率。 但是还有更加高效的方法,那就是合并insert语句。

那么怎么合并呢?

insert into table (f1,f2) values(1,'sss'),values(2,'bbbb'),values(3,'cccc');

就是把values后面的全部用逗号,链接起来,然后一次性执行 。

当然不能一次性提交个100MB的SQL执行,MySQL服务器对每次执行命令的长度是有限制的。 通过 MySQL服务器端的max_allowed_packet 属性可以查看, 默认是1MB

咱们来看看伪代码吧

//使用StringBuilder高效拼接字符串

var sqlBuilder = new StringBuilder();

//添加insert 语句的头

string sqlHeader = "insert into table1 (`f1`,`f2`) values";

sqlBuilder.Append(sqlHeader);

using (var conn = new MySqlConnection("Connection String..."))

{

conn.Open();

//此处设置读取的超时,不然在海量数据时很容易超时

var c = new MySqlCommand("set net_write_timeout=9999999; set net_read_timeout=9999999", conn);