来源:asimovinstitute.org

编译:弗格森

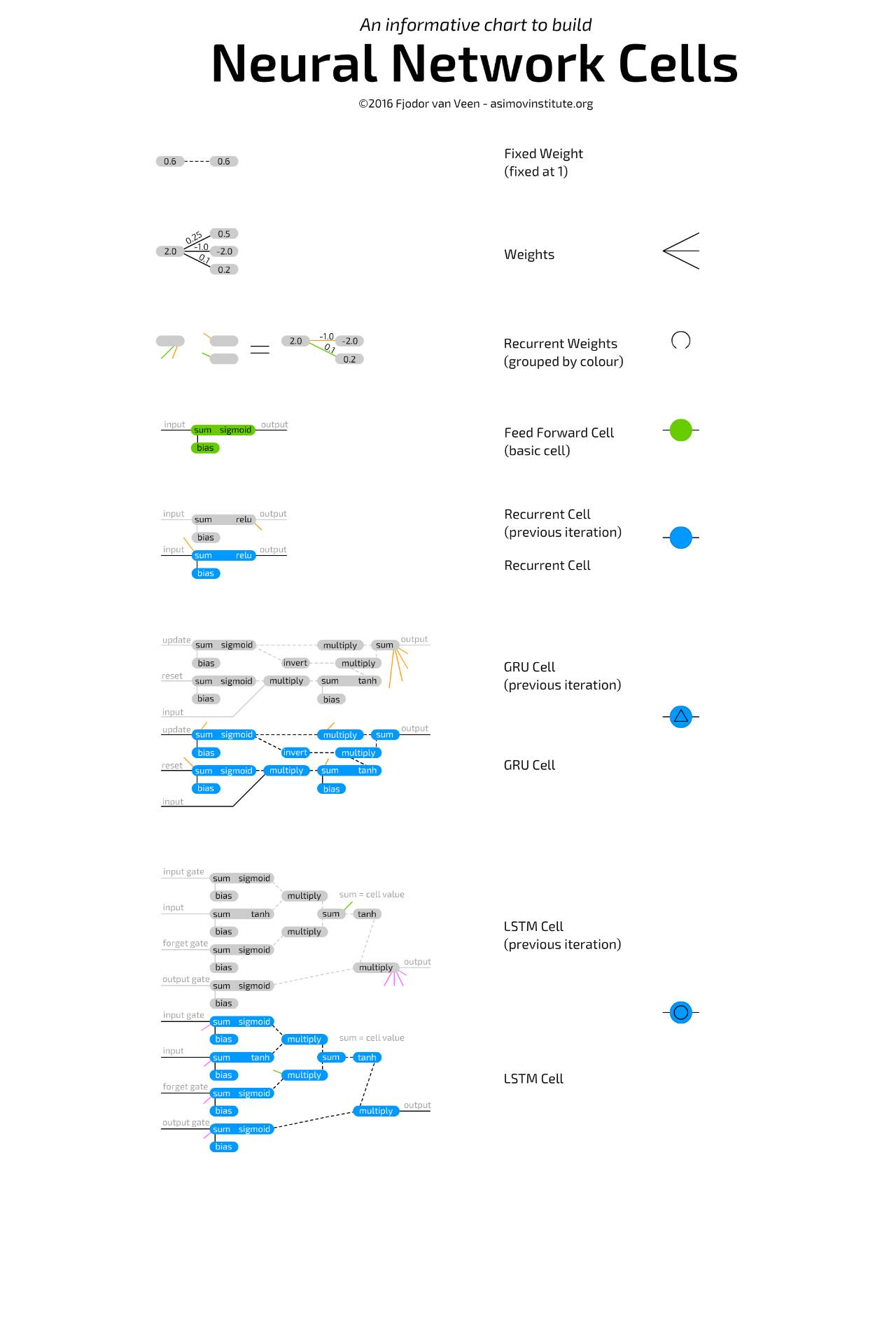

【新智元导读】 此前介绍的神经网络动物园让大家大饱眼福,看到了各种各样的神经网络模型。今天带来更为基础的介绍:组成神经网络模型的基本单元和层是怎么样的?通过信息图表,作者介绍了最基础的单元、长短期记忆单元、门循环单元等等。

信息图表:神经网络基本单元

神经网络动物园

展示了不同类型的神经网络基本单元和多样化的神经网络层之间的连接。但是,它并没有真正地展示每一个基本单元是如何工作的。许多基本单元的类型我最初会赋予不同的颜色来区分网络,但是现在我发现,这些基本单元或多或少是以相同的方式工作的,所以这里只需要提供基本的单元图像,就足以进行描述。

一个基本的神经网络单元

是非常简单的,这也就是你在常规的前馈架构中会看到的那一类。单元通过权重连接到其他神经元,即它可以连接到先前层中的所有神经元。每个连接都有自己的权重,这通常只是一个随机数。权重可以是负数,正数,非常小,非常大或为零。每一个基本单元连接的值都会乘以相应的连接权重,得到的值再全部相加。除此之外,还增加了偏差(bias)。偏差可以防止单元在零输出的情况下被卡住,并且可以加速一些操作,减少解决问题所需的神经元数量。偏差也是一个数字,有时是常数(通常为-1或1),有时是变量。然后,这个总和通过激活函数,其结果的值然后变为单元的值。

卷积单元

非常像前馈单元,除了它们通常仅连接到前一层的几个神经元。它们通常用于保存空间信息,因为它们不是连接到几个随机单元,而是连接到一定距离内的所有单元。这使得它们对于具有许多局部信息(例如图像和声波(但大多是图像))的数据是非常实用的。去卷积(Deconvolutional)单元恰恰相反:它们倾向于通过局部连接到下一层来解码空间信息。这两个单元通常都有很多独立进行训练的克隆单元(clone);每个克隆单元都有自己的权重,但是连接的方式是完全一样的。这些克隆单元可以被认为是位于具有相同结构的分开的网络中。两者基本上与常规单元相同,但它们的使用方式不同。

池化和内插(interpolating)单元

经常与卷积单元结合。这些单元不是真正的单元,而更多的是原始的操作。池化单元接收传入的连接,并决定哪个连接能通过。在图像中,这可以被认为是在缩小图像,您将无法再看到所有像素,并且必须了解保留哪些像素、丢弃哪些像素。内插单元执行相反的操作:它们接收一些信息并将其映射到更多信息。额外的信息由它编造的,就像放在一张小分辨率图片上一样。内插单元不是池化单元的唯一反向操作,但它们相对较为常见,因为它们实现起来很简单。二者在连接上分别像卷积和去卷积单元。

均值和标准偏差单元

(二者几乎只能在概率单元中作为配对出现)用于表示概率分布。均值是平均的值,标准偏差表示偏离平均值(在两个方向)有多远。例如,用于图像的概率单元可以包含关于特定像素中有多少红色的信息。比如,平均值可能是0.5,标准偏差0.2。当从这些概率单元进行采样时,可以在高斯随机数发生器中输入这些值,0.4到0.6之间的任何值都是非常可能的结果,远离0.5的值会越来越少见(但仍然可能)。它们通常完全连接到上一层或下一层,并且它们没有偏差。

循环单元

的连接不仅表现在层次上,还表现在时间上。每个单元内部会存储其先前的值。它们像基本单元格一样更新,但具有额外的权重:连接到单元的以前的值,大部分时间也连接到同一层中的所有单元格。当前值和存储的先前值之间的这些权重非常像一个易失性存储器(如RAM),继承了具有一定“状态”的两个属性,如果不被馈送就会消失。因为先前的值是通过激活功能传递的值,并且每个更新通过激活功能与其他权重一起传递此激活值,信息将不断丢失。实际上,保留率是如此之低,后来只要经过四五次迭代,几乎所有的信息都会丢失。