原作者:Tom Simonite

译者:彭婷

概要:

尽管对超智能机器可能危害人类的担忧现在没有任何新的发展,但是这种想法最近却已经是难以避免了。

尽管对超智能机器可能危害人类的担忧现在没有任何新的发展,但是这种想法最近却已经是难以避免了。

AI的突飞猛进以及诸如Bill Gates(宣称自己担忧超智能)等人的评论使超智能软件的噩梦更为真实。现在人工智能热潮下有两个主要的中心正试图在地球上掀起关于智能机器危险性的讨论。Google旗下的DeepMind(谷歌的AI围棋冠军背后的部门)和OpenAI(Tesla的Elon Musk资助部分经费的非营利性实验室)已经联合起来并在一个他们认为吸引了许多头条却还缺少可行性的问题上取得了实际性的进展:如何使智能软件不会成为流氓软件?

DarioAmodei,OpenAI小组中在负责AI安全工作的研究员说:“如果你担心会有不好的事情发生,那么我们可以做的最好的事情就是研究现在AI系统中会出错的但相对较为平淡的事情。” “这说起来好像没那么可怕,也更为明智些,如你所知,50年后我们可能就会要面对这个问题。” OpenAI和DeepMind在去年夏天提出了一份表明立场的文件,他们呼吁对AI的近期安全问题进行更具体的工作。

一份来自这两个组织的机器学习系统的新文件就将这项工作贯彻到底了,而这个机器学习系统并没有想出自身可能存在的,未知的方法,而是使用了人类的指点来学习新的任务。Amodei说,该项目表明,我们可以在不会使机器学习系统产生糟糕意外的情况下做一些实际的工作(这个项目可以看作是Musk采取的实际行动;2014年在麻省理工学院,他将AI的工作描述为“召唤恶魔”。)

DeepMind的研究人员都没有发表评论,但发言人Jonathan Fildes在一封电子邮件中写道:该公司希望持续的合作将激励他人努力使机器学习不会胡作非为。他邮件中说:“在AI安全方面,我们要使越来越多的组织采用最佳的方式来预防。”

OpenAI和DeepMind所面对的第一个问题是,由所谓的强化学习推动的软件并不会总是做主人想要做的事情,而且有时候它会欺骗我们。该技术现在在AI中很热门,它让软件通过尝试不同的动作并且保持最高的虚拟奖励或得分来解决一个任务,而这里面的赏罚是通过运行像数学激励机制一样的代码来实现的。它有助于DeepMind的AlphaGo在围棋上击败人类冠军,它也展示了机器人将可以更好地操控物体。

但是制定数学激励机制或奖励功能,使系统做正确的事情并不容易。对于多步骤复杂的任务,想想就会觉得很困难——想象一下用数学定义一个评分系统从而来整理你的卧室--- 就算对于看似简单的任务,结果也可能会令人惊讶。例如,当OpenAI设置强化学习代理赛舟游戏CoastRunners时,令创作者惊讶的是,它没有完成指定的航线,而是想出了可以通过绕圈行驶获得积分的方法。

DeepMind和OpenAI的解决方案是让强化学习软件从人类训练者处获得反馈,再用他们输入的数据来定义虚拟奖励系统。他们聘请实验人员通过一个界面反馈给AI代理,而这个界面则会反复询问:AI代理工作中的两个短视频片段哪一个最接近所需的行为。

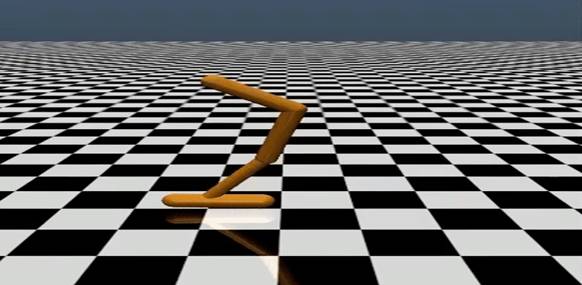

这个被称为Hopper--- 一个简单的模拟机器人,在尝试不同动作,并获得了来自AI培训师900次肯定后学会了后空翻。在数千次反馈后,该系统的另一个版本学会了玩乒乓球等Atari游戏,并且玩驾驶游戏Enduro时表现得比人类玩家更好。现在,这种方法需要太多的人力监督来引导复杂任务,但是Amodei说,结果早已暗示这可能会是一个使AI系统更符合人类需求的有效方式。

人类花了不到一小时给出反馈意见让Hopper学会了后空翻,相比之下,OpenAI的研究人员花了两个多小时才制作了一个奖励功能,而且它最终的后空翻动作还不是很优雅。

Amodei说:“它看起来非常奇怪。”“我们从人类反馈中训练的后空翻动作更好,因为它更符合人类审美的判断。”你可以看到,对于像打扫房屋等复杂的任务,使用人类反馈方式会比只使用代码更为简单。

制造可以了解人类目的和动机的AI系统已经成为制造安全可靠的机器项目的主要议题。例如,隶属于加州大学伯克利分校人类学研究中心的研究人员正在尝试让自动驾驶汽车或家庭助理等机器人接受人们的建议或身体指导。中心的负责人AncaDragan说:“目标不应该是你刚刚写下来给机器人的东西;他们应该来自于人们的合作过程。”

她希望这个想法可以在DeepMind和OpenAI的探索之外的行业中得到应用,并表示公司已经遇到了一些问题,而这些问题可以通过向AI系统中融入一些人类判断得以解决。2015年,Google在将黑人的照片误认为大猩猩后,匆忙调整了其照片识别服务。

Amodei说,在未来几年里,我们要为让现有的,处于中等水平的智能机器学习系统更符合人类目的而工作,而这项工作也会为未来我们可能面临的超智能打下基础。他说:“在将来的某一天,当我们面对非常强大的AI系统时,我们就真的可以成为让他们与人类互动的专家了。”如果发生这种情况的话,也许第一台超智能机器在睁开它的电子双眸时会带着深切的感情凝视着我们。

原作者:Tom Simonite

译者:彭婷

原文链接:

https://www.wired.com/story/two-giants-of-ai-team-up-to-head-off-the-robot-apocalypse/?utm_content=buffer7eb33&utm_medium=social&utm_source=twitter.com&utm_campaign=buffer

欢迎加入未来科技学院企业家群,共同提升企业科技竞争力

一日千里的科技进展,层出不穷的新概念,使企业家,投资人和社会大众面临巨大的科技发展压力,前沿科技现状和未来发展方向是什么?现代企业家如何应对新科学技术带来的产业升级挑战?

欢迎加入未来科技学院企业家群,

未来科技学院将通过举办企业家与科技专家研讨会,未来科技学习班,企业家与科技专家、投资人的聚会交流,企业科技问题专题研究会等多种形式,帮助现代企业通过前沿科技解决产业升级问题、开展新业务拓展,提高科技竞争力。