今天给大家介绍一篇关于图神经网络readout相关的论文。我们都知道readout函数有多种, 比如mean, sum, max等等。本文作者发现由神经网络给出的自适应readout函数竟然表现十分优秀,在40多个不同领域的数据表现惊人。

-

-

作者:David Buterez, Jon Paul Janet, Steven J. Kiddle, Dino Oglic, Pietro Liò

-

机构:University of Cambridge, UK; CVRM, BioPharmaceuticals R&D, AstraZeneca, Sweden; DS&AI, BioPharmaceuticals R&D, AstraZeneca, UK

2. 主要内容

本文研究了图表示readout函数的重要性,这与图神经网络的多任务学习密不可分。作者发现由神经网络给出的自适应readout函数竟然表现十分优秀,在40多个不同领域的数据表现惊人。主要的方法如下,MLP版本

where

is the output of the first layer,

and

are hyperparameters,

is a batch normalization layer, and RELU is the rectified linear unit.

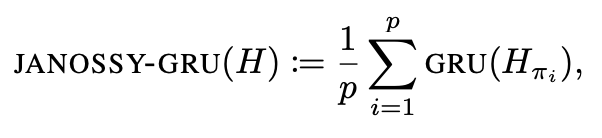

GRU版本