如若转载本文请在文章顶部标注“

本文转载自51CTO(ID:weixin51cto),作者:熊小妹

如果上班的时候想放松一下,或者直说想偷偷懒,看点和工作无关的网页,这时候万一老板突然出现在背后,会不会感到很难堪呢?

有的浏览器设置了boss按键,手快的人还可以切换屏幕,不过总会显得不自然,而且经常搞的手忙脚乱的。

一个日本程序员决定自己动手,编写一个一劳永逸的办法,我们来看看他是怎么实现的吧~

当老板接近我的工位时,电脑就会自动切换屏幕

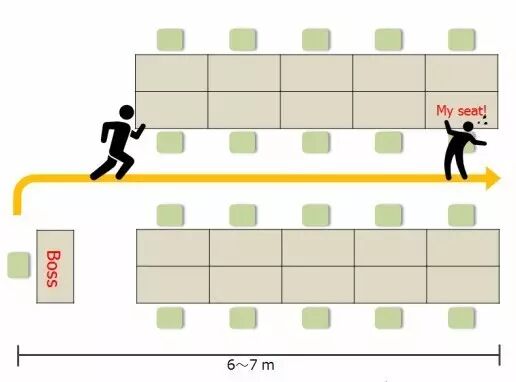

办公室的情况如下:

从老板的座位到我的座位大约6~7米,他会在离开座位后4到5秒钟到达我的座位,因此,需要在这之前隐藏屏幕,所以时间比较紧迫。

首先需要让电脑完成对老板面部的深度学习。然后在我的办公桌上摆上一个网络摄像头,让摄像头对着通道,当网络摄像头捕捉到老板的脸时就切换屏幕。

嗯,这是一个完美的项目。先取一个好名字,就叫Boss Sensor(老板探测器)好了。

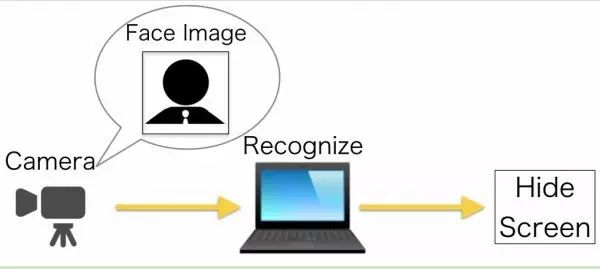

Boss Sensor的简单结构图如下:

处理过程分为三步:

-

网络摄像头实时拍摄图像

-

学习模型检测和识别所拍摄图像的人脸

-

如果识别结果是老板则切换屏幕

所需要的技术实现只有三项:

一步步完成之后整合就可以了。

首先找一个网络摄像头,我用的是BUFFALO BSW20KM11BK摄像头,大家随便找个清晰度够的就可以了。

最好不要用相机自带的识别软件裁剪人脸,因为后面的深度学习过程还需要处理。所以,我用Python和OpenCV编写了一段裁剪人脸图像的脚本,代码在这里下载:

https://github.com/Hironsan/BossSensor/blob/master/camera_reader.py

偷拍到的人脸图像比我之前设想的更清楚▼

接下来,要用机器学习教会电脑识别老板的脸。

我们需要以下三个步骤:

让我们一个接一个看一下。