用 10 周时间,让你从 TensorFlow 基础入门,到搭建 CNN、自编码、RNN、GAN 等模型,并最终掌握开发的实战技能。4 月线上开课,

www.mooc.ai

现已开放预约。

雷锋网按:

关于 iPhone 8 延期发布的消息,日前又有了新的细节披露,再次证实了苹果对 AR 的投入,并逐渐将其融入消费级产品中。

苹果分析师 Brian White 在给投资者一份说明中提到,“因 3D 感知技术的一些挑战,5.8 英寸 iPhone8 将会延迟数周上市,但能在 12 月假期之前与大家见面。” 其中,他肯定了 5.8 英寸 iPhone 8 中将采用 3D 感知技术和 OLED 显示屏,而此前也有消息表示,正是因为屏幕和 3D 技术前置摄像头两者很那完美匹配,造成了 iPhone 8 的延期。

此前,尽管苹果目前还未推出有关的 AR/VR 产品,但暗地里一直积极地布局,例如申请相关技术专利,收购其他技术公司等等。库克也多次对外表示十分看好 AR 。外界也不断地猜测苹果到底会做出一款什么样的产品。

直到今年 3 月份,彭博社的一篇报道证实了苹果的 AR 布局。

关于产品方面,彭博社确认苹果手机将率先支持 AR 功能。另一方面,苹果也正在研发数款 AR 产品,其中包括数字眼镜,可与手机无线连接,并为用户呈现电影、地图等内容。听起来有些像以前的谷歌眼镜,但比起手机的 AR 功能,苹果 AR 眼镜等待的时间要更久。

另外,

报道提到苹果正在为 iPhone 研发的一项功能是,改变所拍照片或是照片中特定物体的景深;另一项功能是,对照片进行抠图,如可抠出人像的头部,对其 180 度翻转。

这其中可能会加入地 AR,生成虚拟特效,类似于 Snapchat 的效果。

为此,iPhone 摄像头将有望依赖于深度感知技术,并且使用由 PrimeSense 公司研发的算法。

或许,苹果不会一次性推出所有这些功能,但现在 iPhone 8 证实将采用 3D 感知技术,想必这也是苹果向 AR 迈出的一小步。

同时,回顾过去苹果的一些动作,雷锋网发现,苹果针对 AR 的人才和技术储备愈加完善。

人才储备

Mike Rockwell 2015 年加入苹果

根据彭博社引述知情人士的报道,苹果已经组建了一支研发团队,该团队聚集了各路硬软件研发的老兵。而早在 2016 年 1 月,雷锋网曾报道苹果当时正在组建一个数百名的 “秘密研发团队”,对

虚拟现实

头盔等其他技术进行试验。

该团队由前杜比执行副总裁 MiKe Rockwell 负责,他曾是杜比的标志性人物,担任过 AR 公司 Meta 的顾问。作为苹果内部 AR 团队的负责人,Rockwell 向 Dan Riccio 报告工作,而 Riccio 主要负责 iPhone 和 iPad 硬件工程团队的工作。

从去年开始,苹果陆续将其他软硬件部门的人调往 AR 团队,包括曾负责苹果手表设计的 Fletcher Rothkopf,创建了 THX 标准(一种音效标准,)的 Tomlinson Holman。

苹果还请了从 3D 视频到可穿戴硬件各方面的人才加入,包括前亚马逊 Lumberyard 虚拟现实平台首席工程师 Cody WHite,前 Meta 软件开发总监 Duncan McRoberts,前

Oculus

分析师 Yury Petrov,以及曾在 HoloLens 和 Google Earth 工作过的 Avi Bar-Zeev。

这支团队中也加入了前维塔视觉特效公司成员,他们曾参与过《阿凡达》、《金刚》等影片的制作。

技术储备

这一点主要体现为苹果收购其他公司,以及专利申请。

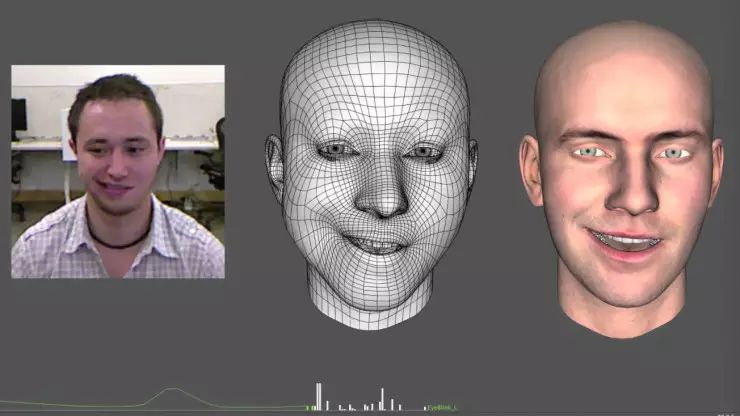

FaceShift 的面部识别

FaceShift 的面部识别

以下是苹果从 2013 年到 2016 年陆续收购的一系列公司:

-

2013 年 11 月 收购以色列硬件公司 PrimeSense

该公司主要为微软的 Xbox 游戏机制造 Kinect 动感捕捉摄像头。

-

2014 年 12 月 收购脸部视觉识别公司 FaceShift

该公司的技术能够利用摄像头对用户脸部图像进行实时捕捉,甚至可以生成虚拟的头像。

-

2015 年 4 月 收购以色列初创公司 LinX

LinX 创建于 2011 年,该公司的技术能够通过将数字图像分成三个部分的方式在照片中增加景深。

-

2015 年 5 月 收购德国 AR 公司 Metaio

该公司主要开发

智能手机

平台的增强现实应用软件,比如其曾经开发一款让家具视觉化呈现的工具。Metaio 曾经的 CEO Thomas Alt 目前属于苹果战略交易团队,决定应该投资哪项技术。

-

2016 年 1 月 收购 Flyby Media。

该公司主要利用空间感知技术,可以强化人们对其周围环境的了解。

甚至还有消息称,库克曾拜访过 Magic Leap 的办公司,并表示对他们 AR 技术很感兴趣。

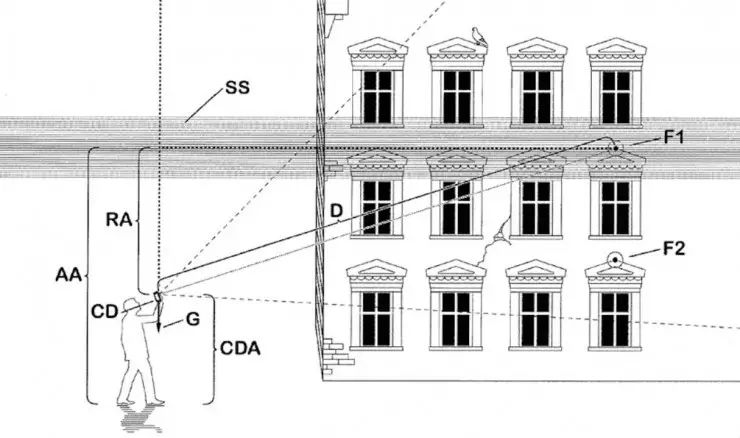

“带有摄像头的可穿戴信息系统” 专利描述图

同时,苹果也没有放松对专利的申请,如下:

-

2015 年 5 月 申请柔性屏幕专利

这是一种在固体发光像素周围设计许多小孔的屏幕,可将屏幕变得又薄又柔软,以帮助 AR 应用。通过像素现实虚拟图像,同时透过小孔查看屏幕另一边的现实图像。

-

2016 年 7 月 申请 AR 显示使用到的类似光波导技术

这项技术是让图像从离轴源文件中投射出来,通过透明物质 (护目镜或薄片) 进入视线。

-

9 月 申请 AR 映射系统

这套 AR 映射系统能够利用 iPhone 的硬件将增强现实功能叠加到直播视频上。用户通过手机应用可以在一些现实场景中标记数字信息,比如街道名称、兴趣点等等,并用摄像头进行扫描。

-

11 月 申请 AR 头盔专利

这项专利描述的是一种保留移动电子设备屏幕的头盔式显示屏仪器,头盔式屏幕系统以及操作方案可以让用户 “配对” 或 “解除”。

-

2017 年 2 月 申请带有摄像头的可穿戴信息系统

这项技术可能会用在一款头戴显示器中,而显示器上搭载的摄像头可以接收与显示器相同视角的信息。该系统可下载有趣的内容,并用 AR 展示出来。

-

3 月 申请专利名为 “利用景深加强人脸检测”

这项专利是通过计算机视觉系统,利用专门的硬件和软件进行

人脸识别

,尤其是已经保存到数据库中的人脸数据。

2016 年 11 月,苹果被爆与 LG 联合开发 3D 摄像头模组,研究如何将自家的 3D 摄像头技术应用于 LG Innotek 生产的