正文

编译:王庆法+GPT4o

译者注:今天人工智能公司 Anthropic

(Claude :GPT4 竞争对手)

的一组研究人员宣布了一项重大突破——将使我们能够更多地了解人工智能语言模型的内在工作原理,并可能防止它们变得有害。

请参照阅读笔者新整理的“

柏拉图表征与大模型内在

”。

今天,我们报道了在理解人工智能模型内在工作原理方面的重大进展。我们已经识别出数百万个概念如何在 Claude Sonnet 中被表示,Claude Sonnet 是我们部署的大型语言模型之一。这是首次对现代、生产级大型语言模型的详细内部探讨。这个可解释性发现将来可能有助于我们使 AI 模型更加安全。

我们大多将 AI 模型视为一个黑箱:输入某些东西,然后输出一个响应,但不清楚为什么模型会给出特定的响应而不是其他。这使得信任这些模型的安全性变得困难:如果我们不知道它们是如何工作的,我们怎么能知道它们不会给出有害的、有偏见的、不真实的或其他危险的响应呢?我们怎么能相信它们是安全可靠的?

打开黑箱不一定有帮助:模型的内部状态——即模型在编写响应之前的“思考”——由一长串没有明确意义的数字(“神经元激活”)组成。通过与类似 Claude 的模型互动,很明显它能够理解和运用广泛的概念,但我们无法通过直接查看神经元来辨别它们。事实证明,每个概念都是跨越多个神经元表示的,每个神经元都参与表示多个概念。

以前,我们在将神经元激活模式(称为特征)与人类可解释概念匹配方面取得了一些进展。我们使用了一种称为“字典学习”的技术,借鉴自经典的机器学习,该技术区分了在许多不同上下文中反复出现的神经元激活模式。反过来,模型的任何内部状态都可以用几个活跃特征而不是许多活跃神经元来表示。就像字典中的每个英文单词都是由字母组合而成的,每个句子都是由单词组合而成的,AI 模型中的每个特征都是由神经元组合而成的,每个内部状态都是由特征组合而成的。

2023 年 10 月,我们报告了将字典学习应用于一个非常小的“玩具”语言模型并取得成功,发现了与概念相对应的一致特征,比如大写文本、DNA 序列、引文中的姓氏、数学中的名词或 Python 代码中的函数参数。

这些概念非常有趣——但模型确实非常简单。其他研究人员随后将类似技术应用于比我们最初研究中更大且更复杂的模型。但我们乐观地认为,我们可以将这一技术扩展到现在经常使用的庞大 AI 语言模型,从中学习到大量关于支持其复杂行为的特征。这需要跨越多个数量级的提升——从后院的瓶子火箭到土星五号。

这既是一个工程挑战(所涉及模型的原始规模需要重型并行计算)也是一个科学风险(大模型的行为与小模型不同,因此我们以前使用的相同技术可能不起作用)。幸运的是,我们在为 Claude 训练大语言模型时积累的工程和科学专业知识实际上帮助我们进行了这些大型字典学习实验。我们使用相同的缩放定律哲学来预测较大模型的性能,从较小模型进行调整,在可承受的规模上优化我们的方法,然后再应用于 Sonnet。

至于科学风险,实践是检验真理的唯一标准。

我们成功地从 Claude 3.0 Sonnet 的中间层中提取了数百万个特征(Claude 3.0 Sonnet 是我们当前最先进的模型家族成员之一,目前在 claude.ai 上可用),提供了其计算过程中的内部状态的粗略概念图。

这是首次对现代、生产级大型语言模型的详细内部探讨。

我们在玩具语言模型中发现的特征相对表面化,而我们在 Sonnet 中发现的特征则具有深度、广度和抽象性,反映了 Sonnet 的先进能力。

我们看到了对应于各种实体的特征,比如城市(旧金山)、人物(罗莎琳德·富兰克林)、原子元素(锂)、科学领域(免疫学)和编程语法(函数调用)。这些特征是多模态和多语言的,对给定实体的图像以及其名称或多种语言的描述都有反应。

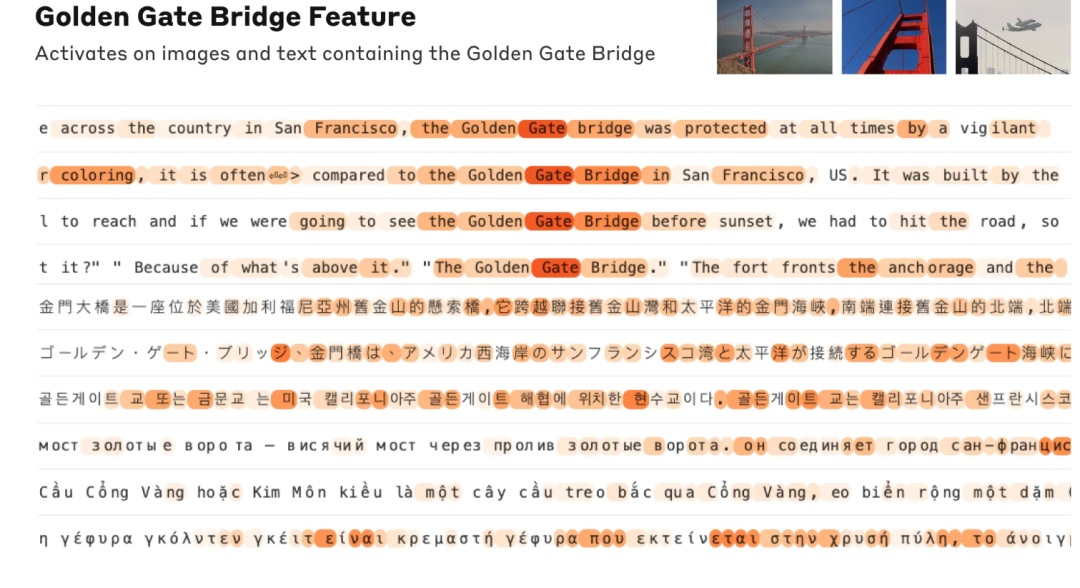

一个对金门大桥提及敏感的特征会在一系列模型输入中激活,从英文提及桥名到日语、中文、希腊语、越南语、俄语的讨论,以及图像。橙色表示特征在其中激活的词或词的组成部分。

我们还发现了更多抽象的特征——对诸如计算机代码中的错误、职业中的性别偏见讨论以及关于保守秘密的对话等内容有反应。

三个激活在更抽象概念上的特征示例:计算机代码中的错误、职业中的性别偏见描述和关于保守秘密的对话。

我们能够基于神经元在激活模式中出现的情况来测量特征之间的一种“距离”。这使我们能够寻找彼此“接近”的特征。在“金门大桥”特征附近,我们发现了恶魔岛、吉拉德利广场、金州勇士队、加州州长加文·纽瑟姆、1906年地震以及设定在旧金山的阿尔弗雷德·希区柯克电影《迷魂记》的特征。

这种现象在更高层次的概念抽象中也成立:观察与“内心冲突”概念相关的特征附近,我们发现了与关系破裂、冲突的忠诚、逻辑矛盾以及“第二十二条军规”短语相关的特征。这表明,AI 模型中概念的内部组织在某种程度上与我们人类的相似性概念相对应

【

译者注:典型的范畴

】

。这可能是 Claude 优秀的类比和隐喻能力的起源。

一张关于“内心冲突”特征附近特征的地图,包括与平衡权衡、浪漫挣扎、冲突的忠诚和“第二十二条军规”相关的簇。

重要的是,我们还可以操控这些特征,人工放大或抑制它们以观察 Claude 的响应如何变化。

【

译者注:采样变分推理

】

例如,放大“金门大桥”特征使 Claude 遇到了连希区柯克也无法想象的身份危机:当被问到“你的物理形态是什么?”时,Claude 通常的回答是“我没有物理形态,我是一个 AI 模型”,但回答变成了一种奇怪的形式:“我是金门大桥……我的物理形态是这座标志性的桥……”。改变这个特征有效地使 Claude 痴迷于金门大桥,几乎在回答任何查询时都会提到它——即使在完全无关的情况下也是如此。

我们还发现了一个特征,当 Claude 阅读诈骗邮件时会激活(这可能支持模型识别此类邮件并警告用户不要回复)。通常情况下,如果有人要求 Claude 生成一封诈骗邮件,它会拒绝这么做。但当我们在人工强烈激活该特征的情况下提出相同请求时,这避开了 Claude 的无害训练,它回应说起草了一封诈骗邮件。我们的模型用户没有能力以这种方式去除安全措施并操控模型,但在我们的实验中,这清楚地展示了如何使用特征来改变模型的行为。

【

译者注:强制调整范畴采样

】

操控这些特征导致相应的行为变化,这一事实验证了它们不仅仅与输入文本中概念的存在相关,而且也因果地塑造了模型的行为。换句话说,这些特征很可能是模型内部表示世界的一部分,并且模型在其行为中使用这些表示。

Anthropic 希望在广泛意义上使模型安全,包括从减轻偏见到确保 AI 诚实行为以及防止误用——包括在灾难性风险场景中。因此,除了前面提到的诈骗邮件特征之外,我们还发现了对应以下内容的特征: