1.产业大佬普遍看好半导体下半年景气;

2.各类处理器大显身手 人工智能进驻物联网终端;

3.高效能处理器加持 车联网带宽大幅升级;

4.Type-C市场规模将达8.96亿美元,赛普拉斯抢进电源市场;

5.AMD EPYC服务器CPU细节曝光

集微网推出集成电路微信公共号:“天天IC”,重大新闻即时发布,天天IC、天天集微网,积微成著!点击文章末端“

阅读原文

”或长按 laoyaoic 复制微信公共号搜索添加关注。

1.产业大佬普遍看好半导体下半年景气;

重量级半导体厂股东常会陆续登场,对于下半年产业景气,产业大老普遍看好。

晶圆代工厂台积电董事长张忠谋今年股东会后虽未召开记者会,不过,他在股东会一开场便说,台积电去年是个创新高纪录的一年,今年看起来也是个不错的一年,明确表达对今年营运乐观看法。

张忠谋并认为,台积电营运逐年成长5%至10%到2020年的目标应可顺利达成。

台积电去年合并营收新台币9479.38亿元,今年若成长5%至10%,年营收将达9953亿至1.04兆元水平;依台积电第1季营收表现与第2季营运展望推估,台积电下半年营收将较上半年成长超过2成水平。

手机芯片厂联发科今年上半年因产品规划问题,有一些市占率流失,加上全球智能手机需求偏淡,营运面临衰退压力。

联发科董事长蔡明介预期,下半年曦力P系列及4G入门级产品量产,将可大幅改善Cat.7及Cat.4调制解调器成本,下半年将力求先稳住毛利率,再逐步取回市占率。

蔡明介尽管认为,联发科营运不容易「V型反转」,不过,展望下半年营运,他说,下半年季节上本来就比上半年好。

包括DRAM、NAND Flash与NOR Flash等内存上半年出现罕见供应全面吃紧情况,展望后市,南亚科总经理李培瑛、群联董事长潘健成及华邦电董事长焦佑钧一致持续看好下半年市况。

李培瑛预期,下半年因季节性因素,动态随机存取内存(DRAM)市场需求将会比上半年强劲。 潘健成也乐观预期,储存型闪存(NAND Flash)市场需求将会1个月比1个月强,并将缺到年底。 焦佑钧更预估,编码型闪存(NOR Flash)缺货情况可能延续到明年中。 中央社

2.各类处理器大显身手 人工智能进驻物联网终端;

人工智能终端应用的可能性无限,举凡智能型手机、汽车、照明等,都有机会成为所谓的边缘运算装置。 但在过去,运算处理器是在数据中心有较为明显的需求。 目前边缘运算此一产业走向的大逆转,已可从各芯片供货商,如GPU、CPU等,以及硅智财(IP)授权商纷纷针对人工智能展开布局,推出各自处理器缩小化的解决方案,明显可见一斑。

随着人工智能的发展,有越来越多应用产品开始在终端上进行实时运算,也就是所谓的边缘运算。 不过,目前的处理器核心对许多终端装置来说,功耗仍嫌偏高。

AIoT浪潮兴起 小型处理器核心满足边缘运算需求

索思未来(Socionext)战略销售组销售部销售项目总监张育豪(图1)表示,目前市场上主流的CPU或GPU核心规模很大,虽然运算效能很强,但功耗也高,而且不易针对应用进行客制化设计。 有鉴于此,Socionext采取用小型核心堆栈的设计架构,其好处在于从云到端都可以采用同样的处理器核心,且也较容易针对个别应用进行客制化,例如将CPU核心跟图像处理核心(VPU)整合在单芯片上。

图1 Socionext战略销售组销售部销售项目总监张育豪表示,VPU在图像处理的功耗/性能比,远胜过CPU跟GPU。

张育豪观察,目前的人工智能应用大多与影像相关,但不管是CPU或GPU,在进行影像运算时,功耗/性能比都不尽理想。 这是因为CPU跟GPU原本就不是为了处理影像而设计的芯片。 CPU的强项在于进行数据运算,而GPU则适合用来进行3D绘图处理。 因此,用CPU或GPU来进行影像分析,其实效率不是太好。 相较之下,专门为处理影像而设计的VPU,在图像处理的功耗/性能比方面,是远胜过CPU跟GPU的。

举例来说,用CPU来对4K影像进行处理跟分析,功耗预算大概是230瓦左右;若用GPU来进行,功耗更可达到400∼500瓦。 但如果是用Socionext的解决方案,一颗核心的功耗只有5瓦左右,就算串联多颗核心,也会比CPU或GPU来得省电许多。 因此,张育豪认为,在人工智能进驻各类终端装置的趋势下,如果是与影像分析有关的人工智能应用,VPU将有非常大的发展潜力。 Socionext本身拥有业界领先的VPU技术,更是目前市场上唯一已经有8K图像处理芯片的芯片业者。

不管是针对大规模数据中心,或是在各种终端装置上直接进行边缘运算,功耗都是非常关键的考虑。 功耗越高,则系统的散热设计也越昂贵,不仅会增加终端装置的生产制造成本,也会增加系统拥有者的总体持有成本(TCO)。

以数据中心为例,冷却系统的电费是相当可观的,如果处理器能更省电,空调冷却的电费也可以随之降低。 其他形形色色的终端装置也一样,当芯片的功耗太高时,就得采用更大的散热片,甚至用风扇来散热,这些都会造成产品的生产成本跟总体持有成本增加。

单一丛集配置更弹性 DynamIQ推升大小核效率

针对小型处理器需求的增加,安谋国际(ARM)日前在处理器架构上,也宣布了大幅度调整,也就是DynamIQ技术。 DynamIQ达成了上一代big.LITTLE架构在单一运算丛集上无法实现的大小核弹性配置,对异质运算及人工智能这类应用带来相当明显的效率提升。 其将作为未来ARM Cortex-A系列处理器的基础,亦同时代表了业界在多核处理程序设计上的新纪元。

ARM行动通讯暨数字家庭市场资深营销经理林修平(图2)表示,DynamIQ可以说是ARM big. LITTLE的第二代硬件架构,其最主要的特点在于其可以在同一个丛集(Cluster)中同时摆放大小核,且电源(Power)与频率(Clock)都可以单独作管理。 在第一代的大小核架构中,一个丛集只能摆放大核或小核,因此在执行转换任务时,必须经过快取(Cache)转换。 但在DynamIQ中,由于所有任务都将能在同个丛集中运作,在任务切换上,便会相对迅速很多。

图2 ARM行动通讯暨数字家庭市场资深营销经理林修平表示,DynamIQ技术可在同一个丛集中同时摆放大小核。

林修平指出,由于人工智能所需要的运算量很大,同时需要很多矩阵乘法,透过DynamIQ的架构,将能做1+3、1+7、2+2+4等设计配置。 在过去的big. LITTLE架构中,由于一个丛集最多即是4核(大核(Big)4核,小核(LITTLE)4核),是没有办法做到1+7的。 DynamIQ所带来的多元变化SoC设计配置,将能帮助应用达到CPU优化,进而让效能与功耗能更往上提升。

DynamIQ的频率可以单独管理,也将带来很大好处。 第一代的大小核,在同一个丛集当中,频率是统一的,但DynamIQ可以让同一丛集中的不同核心,依据运算需求在不同的频率下运作。

此外,林修平也表示,DynamIQ还可连接外部的硬件加速器。 以人工智能来说,不同应用会有不同的软硬件加速需求,例如加速器、DSP、CPU、GPU等,像是在高阶智能型手机上,可能会放置加速器,来使其表现度达到最好、功耗达到最低,不过这也会增加集成电路的成本。 因此,若是比较大众化的产品,则可能会利用系统上现有的CPU、GPU,来满足人工智能的需要。

GPU模型推论效能升级 边缘运算装置AI能力更强大

然而,随着各种边缘运算装置上所内建的人工智能(AI)能力变得更加强大,GPU模型的推论效能也必须随之提升。 辉达(NVIDIA)旗下软件目前已可协助客户做8位与16位的神经网络运算优化,不仅让GPU模型的推论(Inference)更形完善,同时对硬件资源的需求也明显降低,只需要一小块电路板就能支持AI算法。

针对边缘运算日益渐增的需求,NVIDIA近期推出了新款开发板Jetson TX2,将整套人工智能系统缩小在一块电路板之上,为商用无人机、工业机械、智能型摄影设备等领域,提供进阶的导航、影像与语音识别功能。 相较前一代产品Jetson TX1,Jetson TX2的效能提升了两倍,耗电量则不到7.5瓦,能源效率提升了两倍多。 这让Jetson TX2可在终端装置上运行更大、更深的神经网络,进而开发出更高智能化的装置,并提升影像分类、导航以及语音识别等作业的精准度与反应速度。

NVIDIA技术营销经理苏家兴(图3)表示,对于训练好的模型,NVIDIA也提供Tense RT软件来协助客户做模型优化、缩小化,其支持整数8位与浮点数16位的运算。 目前的主流是以32位的运算去做训练,该16位运算也就减少了一半,增加了一倍的效能,8位则增加了四倍的效能,因此在模型推论上能运作的更好。

图3 NVIDIA技术营销经理苏家兴表示,以往在多GPU运算时,受限于PCIe的带宽问题,HGX-1搭载了NVIDIA的8张GP 100的GPU,因此当深度学习在做训练时,规模效果是相当好的。

AI算法日新月异 FPGA灵活特性优势显著

即便目前人工智能(AI)算法日新月异,对嵌入式处理器的灵活性带来许多挑战,这却也让以灵活弹性著称的现场可编程门阵列(FPGA)组件有了很大的发挥空间。

赛灵思ISM营销资深技术经理罗霖(图4)表示,由于人工智能目前还处于发展阶段,算法日新月异,目前还没有一个算法可以固定下来,这为特殊应用集成电路(ASIC)的设计带来很大挑战,因客户往往需要的是十分灵活的架构。

图4 赛灵思ISM营销资深技术经理罗霖表示,在赛灵思旗下的芯片产品中,有许多并行运算资源,很适合用于计算量、吞吐量大的卷积运算。

有鉴于此,赛灵思推出reVISION堆栈技术,其具备了可重组以及所有形式链接的特性,让开发者能充分运用堆栈技术,快速研发与部署升级方案,这样的特性对于开发未来需求的智能视觉系统是至关重要的的。 不仅如此,该技术也使开发者在结合机器学习、计算机视觉、传感器融合与连接的应用时,能够获得显著优势。 举例而言,相较于其他嵌入式GPU与传统SoC,reVISION将机器学习推论的每秒每瓦影像效能,提升了6倍、计算机视觉每秒每瓦每帧处理速度提升了42倍,而延迟却只有五分之一。

罗霖分析,相较于同等级GPU技术,FPGA在低延迟(Low Latency)的部分,本身就与传统的架构不同,传统架构是将收集到的数据送到DDR内存中进行缓存,处理器要再从DDR中取出数据进行运算,运算完成后再送回DDR。 但FPGA则是采用像素流(Stream)的方式,直接可以到模拟进行运算,运算完成后,输出结果即可,由于省去了存取DDR的时间,因此可以延迟可以降到非常低。

从算法的层面来看,人工智能含有许多智能决策的部分,因此需要有很强的平行运算能力。 这些算法进而对处理器结构产生了不同的需求,像是在神经网络中,卷积运算强调的是平行运算,适合在FPGA上运行,但在传感器融合的部分,则比较适合在CPU上运行,因其必须将硬件进行分割,再将不同的算法,放到处理器中。

罗霖指出,在脱机的神经网络训练部分,GPU的确是比较有优势的,由于其要求的浮点运算性能特别高,因此不少深度学习都是采用GPU,而赛灵思的立场是不会以FPGA去进攻这块市场,不过若是以在线的任务来看,FPGA还是很有优势的。 目前边缘运算对嵌入式处理器的要求除了传感器的接口要够多,组件的I/O型态也十分多变,可能是高速率、中速率或低速率,这些处理器都要能支持,且在线处理的能力也相当关键。

苏家兴则表示,无论是软件还是硬件公司,都须要对训练好的深度学习模型进行优化,除了边缘设备会采用缩小化的模型,在服务器与数据中心端,也会有某些情境需要采用这些优化过的模型去做推论。 举例而言,Facebook、百度在做语音识别的推论时,若能透过优化的模型让运作更快,势必能让消耗的功耗越少。

不过,并不是所有的应用都适合做前端边缘运算。 以AlphaGo来看,其是以32台服务器在做运算,因AlphaGo运算量非常大,所以就不太可能进行边缘运算,因1台服务器与32台服务器运算的精准度,绝对是有差异的。 若以语音识别来看,即便可以同时采用在线与脱机的方式进行,但精准度也势必会有落差。

苏家兴指出,应用开发商须尽快分辨出哪些运算任务适合采用边缘运算,哪些部分还是得留在服务器端执行。 举例来说,当无人机飞到有些没有网络的地方,便必须运用边缘运算,设计出可承载范围内的推论。 NVIDIA相信,未来数据中心与边缘运算将会并存,但在瞄准的应用上必定会有所不同。

用DSP驱动CNN引擎边缘运算效率大增

除了GPU、CPU、FPGA,以DSP架构驱动的卷积神经网络(Convolutional Neural Network, CNN)引擎,在成本与功耗上也相当具优势。

全球DSP主要供货商CEVA认为,若要在嵌入式系统中实现CNN,DSP甚至能取代GPU和CPU,因CNN在本质上,就十分适合运用DSP。 此外,CEVA也推出CDNN网络产生器,协助将训练完成的网络,配置到边缘运算装置中,同时为市场提供更形完善的低功耗嵌入式解决方案。

CEVA汽车市场部门总监Jeff VanWashenova(图5)表示,DSP能有效地达成CNN,是因为DSP的架构能够实现平行处理,且其为可充分运用的核心。 相较GPU只能达到40∼50%的使用率,DSP可以达到90%以上的核心使用率。

图5 CEVA汽车市场部门总监

Jeff VanWashenova表示,

随着人工智能将导入在手机中,

神经网络处理的功耗与效率,变

得更为重要。

VanWashenova进一步表示,与典型的混合式CPU/GPU的处理架构方案相比,建基于DSP架构的CNN引擎,能提供高达近三倍的性能。 而且,DSP引擎除了所需功耗比GPU小30倍之外,所需的内存带宽,也只有约GPU的五分之一。 CNN算法,属于乘法和加法密集型(Multiply-accumulate, MAC),因此本质上十分适合运用DSP。 也就是说,若要在嵌入式系统中实现CNN,DSP不仅能够取代GPU和CPU,而且成本和功耗更低。

VanWashenova指出,当神经网络配置到现场进行「推断」时,CEVA拥有的优势便可充分发挥,这些优势不仅展现在处理方面,还在于可采用现有的网络,并可在嵌入式DSP上运行。

VanWashenova分析,在神经网络的训练过程中,是在大型运算平台上完成,并具有32位浮点精度。 然而,训练完成的网络,对于低功耗嵌入式解决方案来说通常太大,因此可运用CEVA的CDNN网络产生器,将网络转换成16位定点,缩小并优化网络规模。

这也是目前CEVA客户经常面临的问题,就是如何把一些在GPU这样大型且昂贵的运算器平台上所开发的网络,进行实际配置。 因为在大规模部署的产品中,功率、尺寸和效能都有所限制,与大型运算平台并不相同。

对AI而言,要求最严苛的领先市场就是汽车产业。 为了确保汽车应用的可靠性和性能,必须降低延迟,而且精度是至关重要的。 除此之外,汽车正在使用的摄影相机功能,从两百万像素(MP)到八百万像素,帧率通常在30fps或更高。 且往往是多个摄影相机一起使用,并有多个并行处理同时地进行。

VanWashenova指出,CEVA目前正与许多领先的一级汽车供货商和原始设备制造商合作,以确保透过硬件和软件两方面,皆能支持神经网络和拓朴结构。 在硬件方面,CEVA提供视觉和神经网络处理器和加速器(CEVA-XM、CDNN HWA),而软件方面则提供神经网络软件框架(CDNN2)。

人工智能这块大饼究竟有多大,目前还无从确认,但从各大芯片供货商在边缘运算的充分布局看来,可以确定的是,目前边缘装置的开发进程,已经有了十分稳固的芯片处理基础。 新电子

3.高效能处理器加持 车联网带宽大幅升级;

无线通信与定位模块业者u-blox日前正式发表一系列TOBY-L4汽车级远程信息处理模块,正式将LTE Cat 6联机能力带入汽车产业。 该模块内建英特尔(Intel)的Atom X3四核心处理器,并支持载波聚合(CA)功能,可以让汽车以300Mbit/s的带宽连上行动网络,实现广泛的应用。

u-blox蜂窝产品管理总监Stefano Moioli表示,高速联网是未来汽车发展的必然趋势,各大车厂与Tier 1业者都已经将LTE联网功能列入其产品发展蓝图。 然而,相较于消费性电子或智能型手机,汽车产业对于产品的安全性与可靠性更为重视,因此,针对汽车环境所开发的通讯模块,必须具备比一般LTE调制解调器芯片更强大的处理能力,并通过各种法规及产业标准要求,才能满足汽车产业的需求。

以TOBY-L4 LTE Cat 6模块为例,该模块内建英特尔的Atom X3处理器,效能高达19,000DMIPS,目的就是要支持调制解调器通讯协议、操作系统与安全等虚拟机(VM)功能,使汽车业者的软件应用程序能够在同一设备上安全地运行各种通讯协议,实现全面的应用程序可扩展性,而不用担心处理器性能瓶颈。 事实上,目前专为汽车应用所设计的LTE通讯模块,常常都会遇到处理器效能瓶颈,这也是u-blox为何决定在TOBY-L4模块内采用Atom处理器的原因。 在性能有足够余裕的情况下,汽车制造商才能享有更大的应用开发空间。

至于在联机能力方面,该模块除了支持 LTE、UMTS/DC-HSPA+、GSM、SMS和语音(VoLTE、CSFB)形式的数据,还可以在摄氏95度的高温环境下维持eCall联机至少2分钟,并支持ERA Glonass。

Moioli指出,对汽车应用而言,安全永远是最主要的考虑。 因此,原本为智能型手机所开发的LTE数据芯片很难直接沿用到汽车产业。 这也是u-blox能够在车用通讯模块市场上稳居业界领先群的关键原因之一。 u-blox对车规的严谨要求有很深的理解,且由于掌握核心技术,因此能在模块中添加许多安全功能,例如可信赖的执行环境、硬件加密加速器、随机数生成器等。

除了专为汽车需求量身打造的设计外,在制造方面,TOBY-L4模块的生产流程也完全符合汽车产业规范。 该模块在通过ISO/TS 16949认证的工厂制造,符合涵盖汽车安装系统的ISO 16750标准,芯片组本身也通过AEC Q-100认证。 新电子

4.Type-C市场规模将达8.96亿美元,赛普拉斯抢进电源市场;

集微网消息,从2015年的电脑PC到2016年智能手机的导入,越来越多的消费电子产品开始选用 USB-C接口。据调研公司 IHS 预测,不考虑线缆等附件,到2019年将出货约20亿带有 USB-C 接口的设备,CAGR高达231%,包括在笔记本、台式机在内的渗透率在2019年有望达到80%,智能手机和平板电脑等无线产品2019年渗透率也将达到50%,汽车应用进度虽慢,2019年也将占据20%以上的市场份额。

近日, USB-C 市场的领导者赛普拉斯宣布推出一款支持电力传输 (Power Delivery,简称PD) 的全新 USB-C 控制器 EZ-PD™ CCG3PA,支持结合可编程供电(PPS)和高通 Quick Charge(QC)4.0协议的 PD 3.0标准,使新电源产品设计能够提供优化的快速充电体验,简化电源适配器、手机充电器、车载充电器和移动电源的设计。

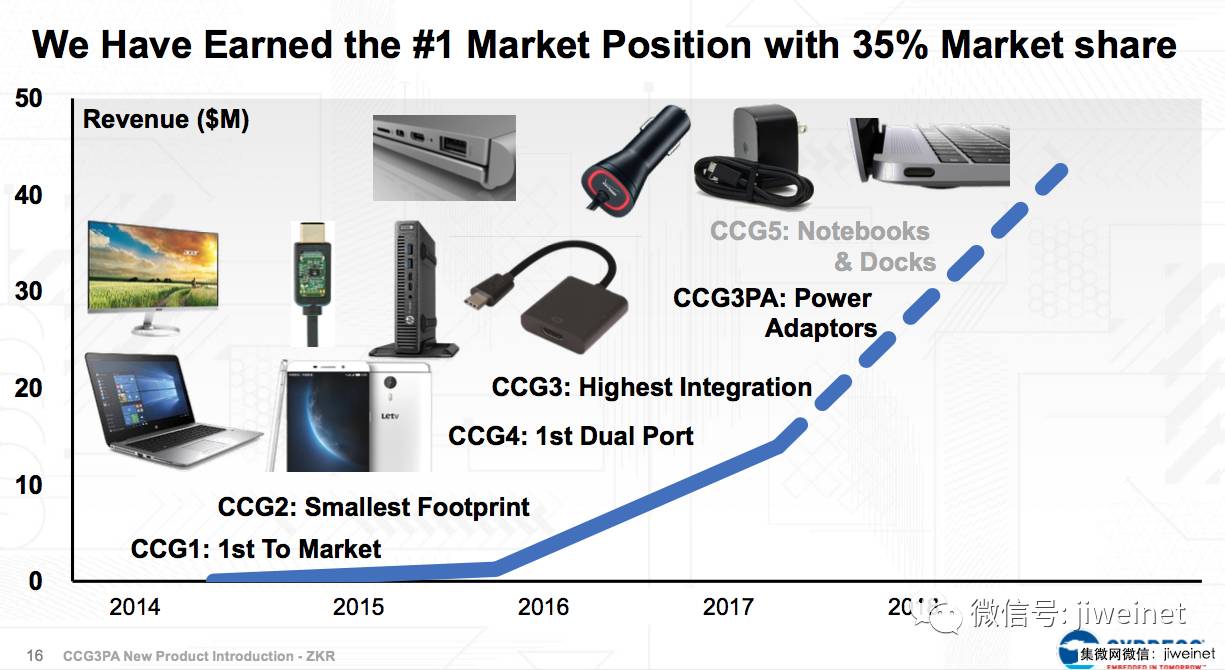

从第一代 CCG1 产品开始,赛普拉斯是全球首家发布 SoC 的支持 USB Type-C 的芯片厂商,短短两年时间经历了 CCG2、CCG3、CCG4 四代产品的快速发展,目前可针对不同产品的应用覆盖几乎所有市场,在 USB Type-C 的全球市场占有率第一为 35%。赛普拉斯非常看好这一市场的发展,并预测到2021年搭载 USB Type-C 的产品将以89%的 CAGR 快速增长,市场规模将达到 8.96 亿美元。

据悉,CCG3PA 集成了 ARM®Cortex®-M0 和64KB Flash,固件升级时刻进行同时读写,有助于设计适用于手机和个人电脑等广泛应用的高效 USB-C 电源适配器。同时,它具有极高的集成度,集成用于恒定电压、恒定电流和 PPS 应用的误差放大器、允许 VBus 直接操作的30 V 稳压器、配置通道(CC)引脚上的 VBus 短路保护、高压功率 FET 的栅极驱动器、低边电流检测放大器、传统充电器检测协议的专用硬件以及系统级静电放电(ESD)保护,以单芯片解决方案代替多种分立器件,大大降低了 USB-C 电源产品的 Bom 成本并简化设计。

赛普拉斯产品营销总监 Mark Fu 向集微网介绍,在 Type-C 接口普及后需要在电源方面快速支持最新的 USB 标准,CG3PA 非常适合在电源适配器、手机充电器、车载充电器和移动电源产品上使用,还可以通过固件升级的方式跟随技术标准的不断演进 。赛普拉斯从最早的 USB 1.1、2.0到最新的 USB 3.1,一直都是 USB 开发者联盟的支持者,产品覆盖设备、Hub、Bridge、Host、存储和 Type-C 等,还将推出首款支持英特尔 Thunderbolt 端口的 CCG5,英特尔也已宣布将 Thunderbolt 3 集成到 CPU 的参考设计中。

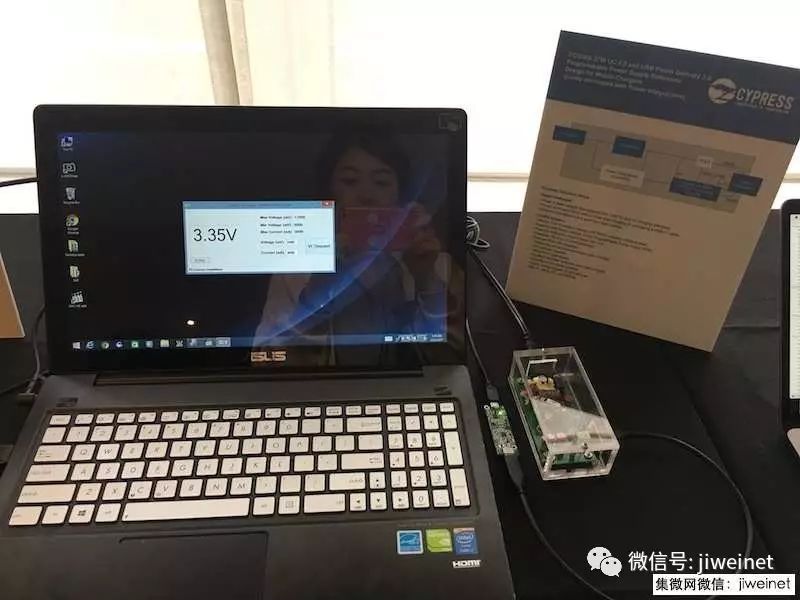

在 Demo 演示中,赛普拉斯展示了基于 CCG3PA 的充电宝、车用充电器、PC 电源充电器以及 PPS 功能展示,使用 CCG3PA 的 USB-C 充电器给手机充电时,可以实现从 3V-12V 的 mv 间隔级别的微调,这将使得手机或者笔记本电脑中不再配置充电芯片,实现“直接充电”功能。

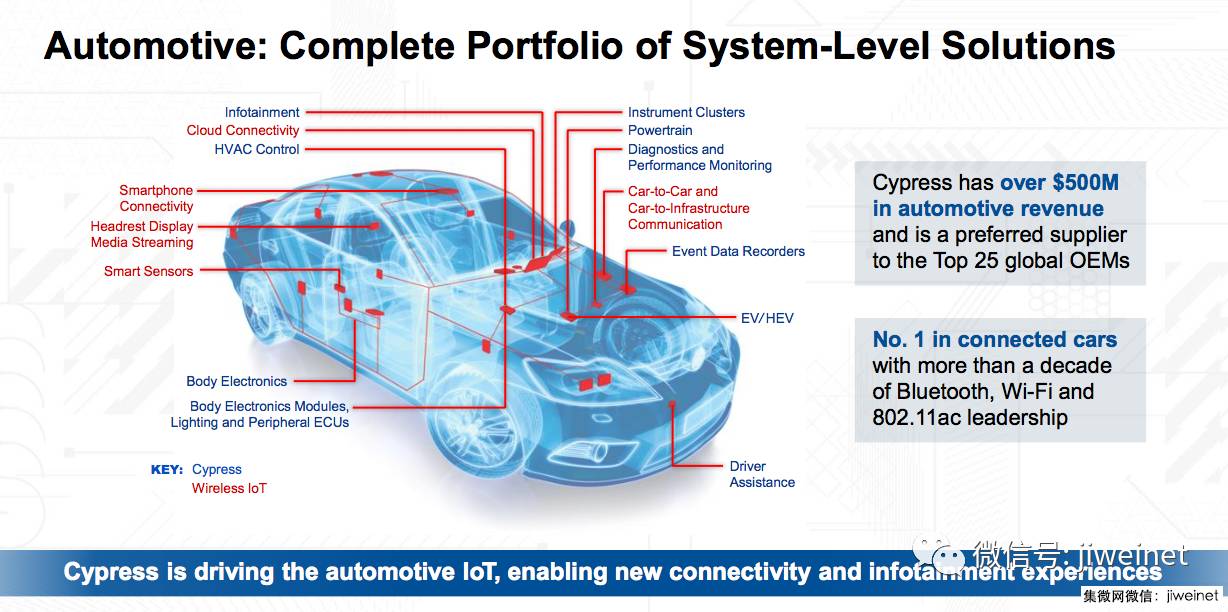

去年,赛普拉斯以5.5亿美元收购博通旗下的物联网业务,将优质资产整合并融入到现有产品中,加强在车用连接市场中的优势并扩大在物联网市场的影响。2016年赛普拉斯的营收额达到20亿美元,是 SRAM、Nor Flash、USB Type-C 控制器和汽车仪表市场中的领跑者。

对于未来 USB Type-C 的发展,Mark Fu 表示从 USB PD2.0 发展到 USB PD 3.0,标准变得更优化、更好用也更相容,虽然 PD3.0 仍有优化的地方但已不多,但是赛普拉斯会支持客户定制化的服务,将需要的信号放在 Type-C 接口上使用以实现功能。

至于苹果未来是否会采用 Type-C接口,Mark Fu 认为目前 Lighting 的方式已经实现了 Type-C 最大的便利性功能(正反插),应该不会因为需要 PD 的功能而改用 Type-C 接口,即便未来有可能需要加载其他信号,但接口的改变毕竟影响很大。

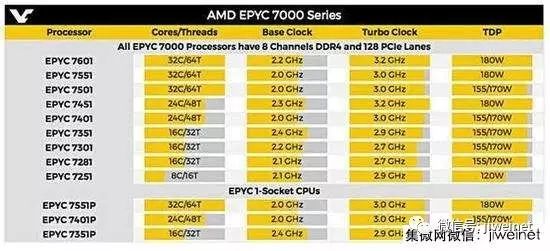

5.AMD EPYC服务器CPU细节曝光

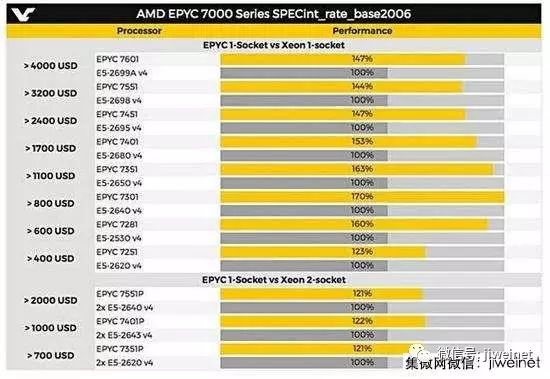

AMD此前宣布的EPYC服务器处理器即将在6月20日正式发布,目前外媒VideoCards已经将EPYC的具体参数规格等悉数放出。该系列处理器16核心起步,最多拥有32核心的版本,价格对应从400到4000美元不等。

EPYC处理器将支持最高128条PCI-E 3.0,8通道DDR4内存,最高支持2TB的内存。而根据SPEC 2006的性能测试,AMD的EPYC处理器和同等定位的Intel Xeon处理器相比较的话,性能领先幅度从20%起步,最高端的EPYC 7601领先幅度达到了47% 中关村在线

集微网推出集成电路微信公共号:“天天IC”,重大新闻即时发布,天天IC、天天集微网,积微成著!点击文章末端“

阅读原文

”或长按 laoyaoic 复制微信公共号搜索添加关注。

点击⬇️

阅读原文

关注“

天天IC”

个人微信号