王小新 编译整理

量子位 报道 | 公众号 QbitAI

最近,来自加州大学伯克利分校的Deepak Pathak、Pulkit Agrawal、Alexei A. Efros等人写了一篇题为“基于自监督预测的好奇心驱动探索”的论文,这篇文章提出了一种内在好奇心单元(Intrinsic Curiosity Module),来帮助操作者探索新环境。

论文被收录于8月11号在悉尼举办的ICML 2017上,以下是论文的主要内容:

摘要

在许多真实的场景中,外部环境对操作者的奖励非常少或几乎不存在。在这种情况下,好奇心可以作为一种内在的奖励信号,让操作者去探索未知的新环境,学习一些在以后生活中可能有用的技能。

在这篇文章中,我们基于自监督方法建立了反向动力学模型,训练得到了一个视觉特征的高维空间。在此空间中,我们将操作者预测自身行为可能导致后果的能力,即预测值和真实值之间的误差称为好奇心(curiosity)。

对于图像序列这样的高维连续状态空间,我们的公式非常适用,能绕过直接预测像素的难题,而且选择性地忽略部分不能影响操作者的环境因素。

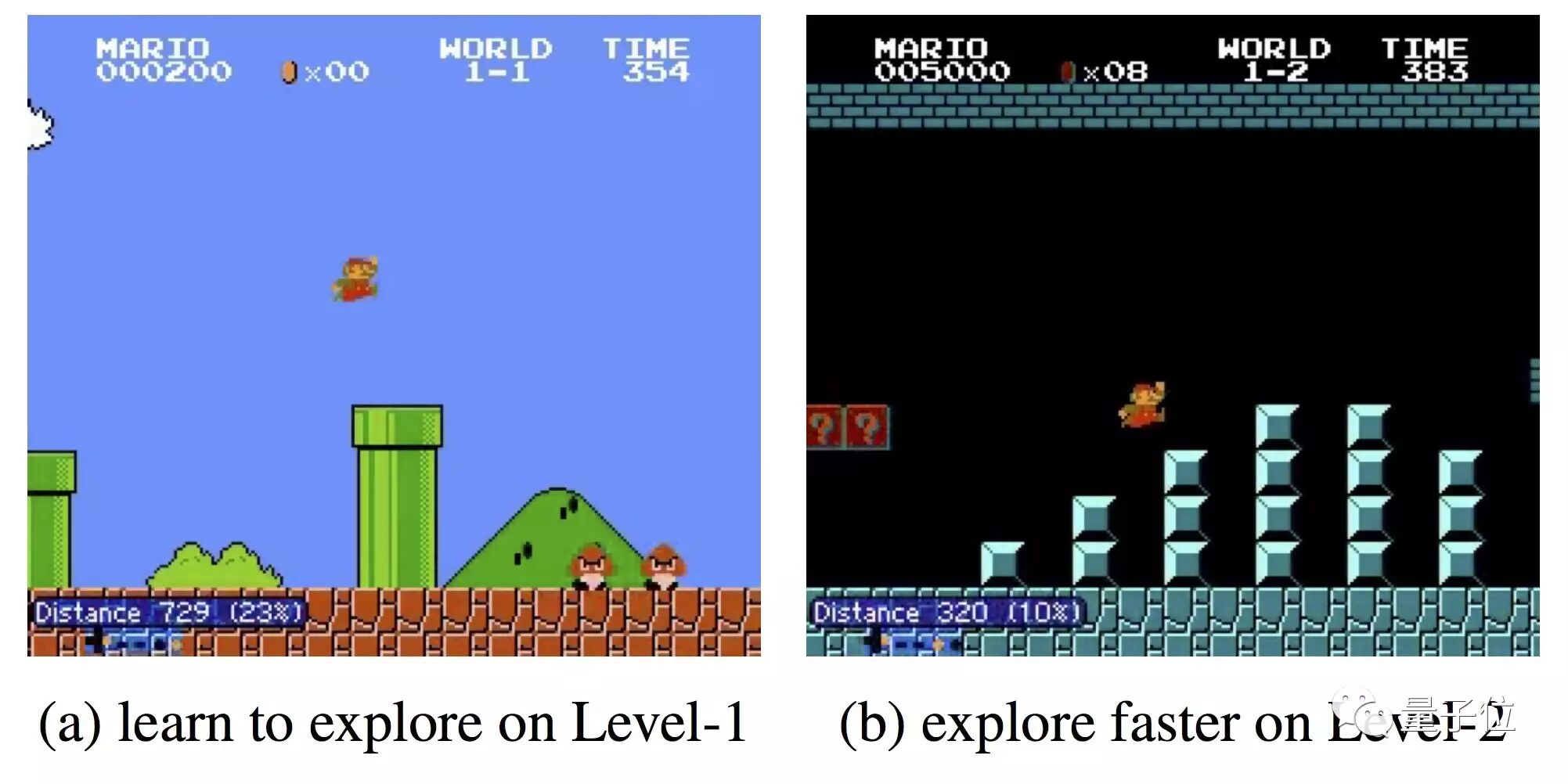

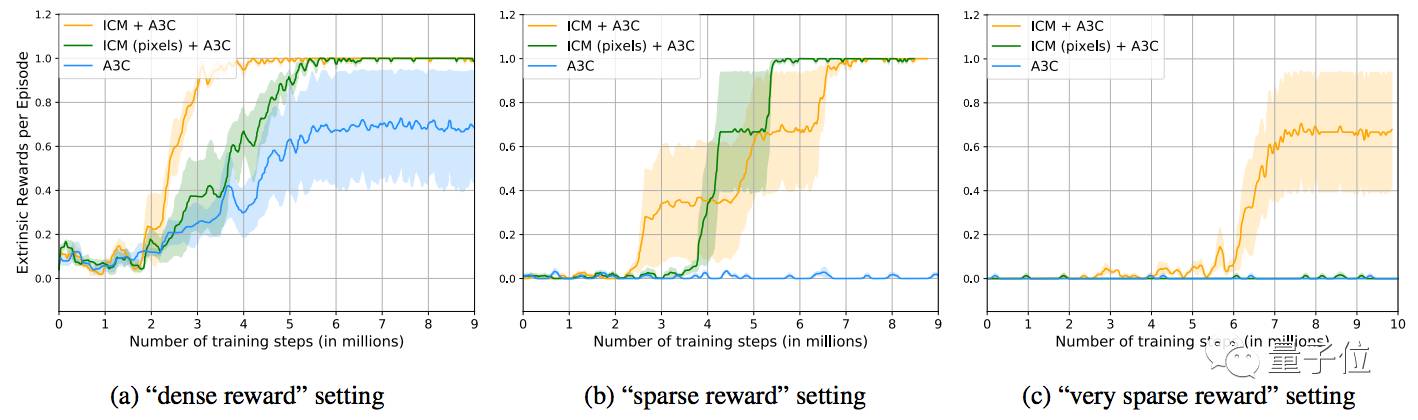

我们在两个游戏环境中评估所提出的方法:毁灭战士(VizDoom)和超级马里奥兄弟(Super Mario Bros)。

有如下三个大概的研究背景:

1.极少的外部奖励,与外部环境的相互作用远远少于期望值;

2.不输入外部奖励,好奇心促使操作者的探索更有效;

3.推广到未接触过的场景(例如同一游戏的新关卡),从早期经历获得知识的操作者比从头开始探索新地点的操作者学习要快得多。

演示视频

核心创新点

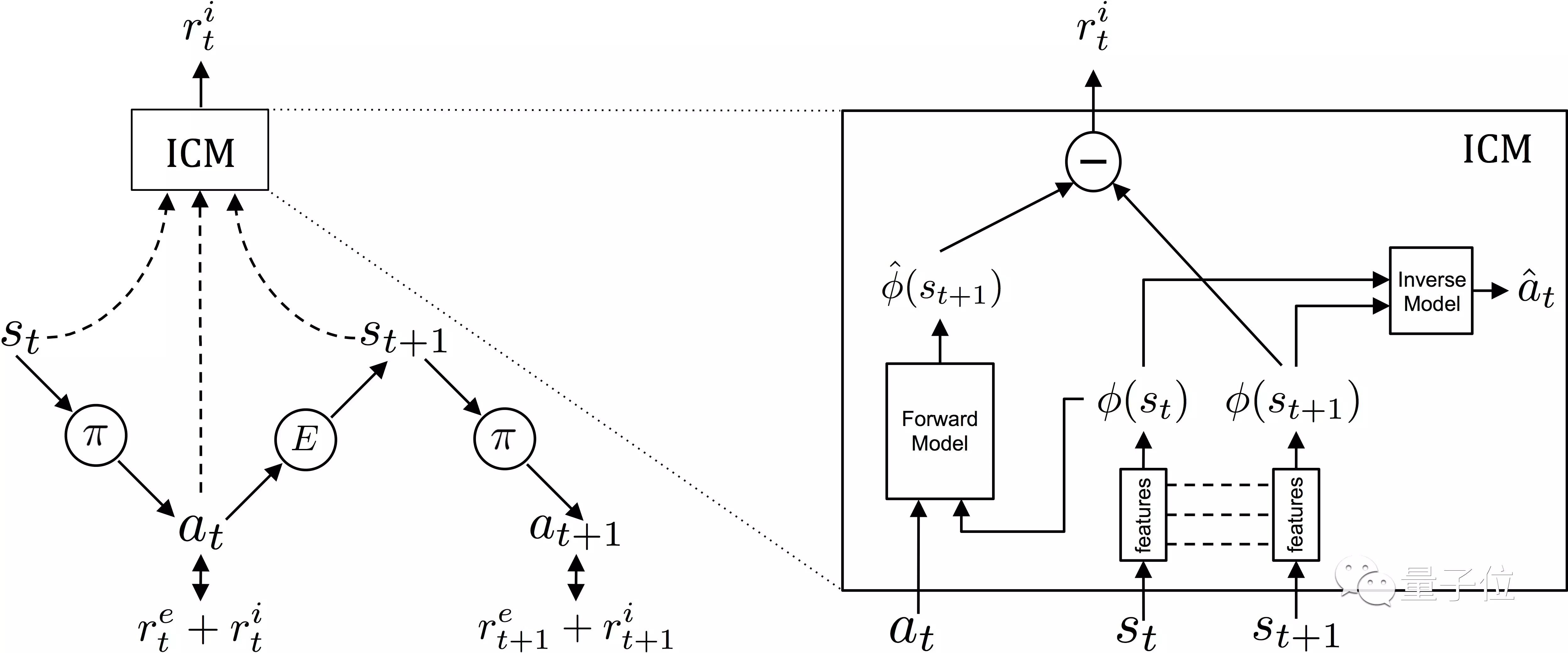

内部好奇心单元:我们提出了内在好奇心单元,来帮助操作者探索。在外部奖励很少或完全不存在的情况下,好奇心能帮助操作者了解新环境。

即使没有任何来自外部环境的奖励下,我们提出的内在好奇心单元也能结合操作者的策略,进行联合学习。模型示意图如下图所示。

相关链接

Paper:

https://pathak22.github.io/noreward-rl/resources/icml17.pdf

GitHub Code:

https://github.com/pathak22/noreward-rl

【完】

招聘

量子位正在招募编辑记者、运营、产品等岗位,工作地点在北京中关村。相关细节,请在公众号对话界面,回复:“招聘”。

One More Thing…

今天AI界还有哪些事值得关注?在量子位(QbitAI)公众号对话界面回复“今天”,看我们全网搜罗的AI行业和研究动态。笔芯~

另外,欢迎加量子位小助手的微信:qbitbot,如果你研究或者从事AI领域,小助手会把你带入量子位的交流群里。

△

扫码强行关注『量子位』

追踪人工智能领域最劲内容