最近在读《AI极简经济学》,除了翻译得读着很痛苦,确实是本好书。

国内的翻译作品给译者的报酬实在是太低了,也难保出现大量的谷歌翻译式的作品。

这本书核心解释了一件事情:

人工智能的预测,与经济学之间的关系。

因为当人工智能的预测效果与成本都足够可控,那很快就会进入寻常百姓家、渗透进我们的衣食住行。

读的过程中我在即刻发了一个消息:

不少朋友留言表示比较疑惑,到底什么算替代品、什么算互补品?

到底哪些会被取代?

哪些比较安全?

确实怪我直接引用了本就翻译略差的原文。

我过去也跟AI算是有一些接触。

我读研的实验室是哈工大信息检索实验室(已改名哈工大社会计算与信息检索研究中心),做过一些机器翻译和机器学习的项目,身边的同学毕业也大都去做算法研究或算法工程了。

所以今天就基于这个问题,结合我过去的经验,跟你分享下我的想法。

1 常见的 AI 都是如何运转的

现阶段大部分优异的人工智能,都是绝佳的模仿者,而非思考者。

从 AlphaGo,到 AlphaStar,都是学习了无数人类的操作才变得这么厉害的,而人类为什么要如此操作,它们全然不知。

(AlphaStar被质疑赢过职业选手全靠手速。

)

要解释 AI 的运转逻辑,机器翻译就是很典型的课题。

早在计算机出现之前,就有苏联科学家提出了基础的构想,在 ENIAC 之后,IBM 为首的企业也参与进机器翻译的研究中。

不少学者都期待,能够出现一个像科幻片里那种实时翻译器一样的工具,全球各族人民肯定能够更加团结,这必然是划时代的发明。

翻译这件事,乍一看好像没有太难。

一个事物,在绝大多数语言中,都有对应的词汇,“妈妈”对应“mother”,“桌子”对应“desk”,可以建立对应关系;

语言学也有了成熟的体系,语言的语法规则特点做拆解后,变成有效的算法策略,岂不应该是水到渠成的吗。

可是事与愿违,机器翻译却直到20年前才算有长足的进步。

为什么呢?

因为基于规则的机器翻译太难了,同一个词语,在不同的情景下,含义全然不同。

比如:

大量的俚语和用词习惯都是在人类实际使用语言的过程中毫无规律地出现的,用规则方式解读,几乎没有可能。

无数语言学家和计算机科学家探索了几十年,都没有做出一个哪怕看起来勉强可用的翻译器。

而在规则机器翻译流派之外,49年就有科学家提出了统计机器翻译的理念,认为是否可以用“猜”的方式去做翻译。

也就是说,机器不关心“意思”到底是什么含义,而是看“不好意思”和“是我不好意思”同时出现的时候,大概率会对应哪个英文短语。

可以想象机器是一个学舌的鹦鹉,左边站着一个中国人,右边站着一个美国人,他们每次说同样含义的话。

鹦鹉就会疯狂学习和记忆他们的说话内容,等到再有第三个人来跟它讲话,它就把记忆中最高频的同时出现的句子或者短语讲出来就好了。

这个方法在早期没有特别受重视,因为效果跟规则机器翻译比也好不到哪去。

机器翻译的发展,一直在基于规则的路上,每年提升零点几个点的速度前进。

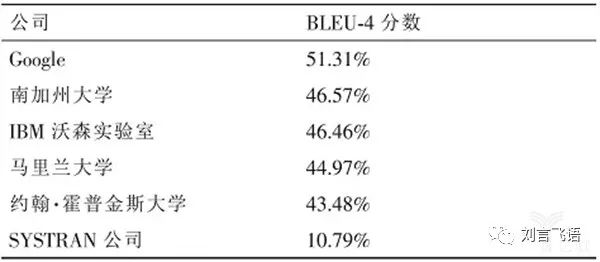

2005年,机器翻译突然有匹黑马出现。

NIST 的年度机器翻译评测里,Google 一跃成为冠军,而且比第二名要超出5%,引起了轰动。

(图源:

吴军老师的《数学之美》)

这是划时代的一幕。

究其原因,说来也简单,Google 有两个武器:

做搜索引擎积累下的海量语言数据库,以及互联网大公司才有的分布式计算能力。

前者让统计机器翻译的数据更全面,后者让模型可以变得非常庞大复杂。

此后,机器翻译就走上了统计之路。

在 2016 年, Google 发布了基于神经网络的更强大的翻译系统,始终是机器翻译的领军角色。

直到现在,各位手里用到的机器翻译工具,也全部都是基于统计原理设计的。

想必说到这里,绝大多数 AI 的原理也就容易理解了。

它们全都是出色的鹦鹉,在模仿学习人处理事物的行为,做出准确的复现或者预测。

2 现在的 AI 做不好什么

绝大多数 AI 都是基于统计的,训练出一个“出色的鹦鹉”,是要靠反复的、海量的输入。

AlphaGo 要输入无数的棋谱,AlphaStar 要输入无数的游戏录像。

当然,现在的机器学习尤其深度学习,已经能够让鹦鹉变得略聪明一些,不只是学舌,还知道总结部分方法和规律,来验证新的内容。

像人脸识别系统,就可以对一张全新的脸,做有效的识别模型。

但它依然不知道本质的原理,这也是基于统计似乎很难走到的终点。

在这样的背景下,输入的数据是影响 AI 质量最重要的点。

最优秀的 AI 大都在互联网公司和政府手里,他们拥有最全面的数据输入;

而不是研究规则和理论为主的学界。

这样看,AI 存在的瓶颈有这样几种。

首先,输入不足的事物 AI 就很难预测。

有的事情属于迭代太慢。

像美国总统大选,每 4 年才举行一次,每次的影响因素又太多,拿到的“训练集”实在太少,就根本无法预测。

还有的事情是输入几乎不可能完备,或者以现今技术根本做不到。

像“女朋友生气了到底是为什么”就是输入几乎不可能完备的预测。

因为人的心理变化涉及的因素太多,有可能就是女朋友看到朋友圈你为别人点了个赞,又联想到了上次你没有给她买生日礼物,再想到你给前任买的礼物特别贵… … 衍生出一系列的结果,你压根都无从推理。

在这种缺乏输入的判断上,人和机器一样无能。

其次,AI 只能学会教给它的东西,不会学习新的,除非你再教给它。

比如,之前特斯拉的无人驾驶系统出了误判,就是把卡车上的蓝白色车身当做了蓝天白云。

人工智能没有结合周边更多显而易见的场景来推测这是个卡车——因为系统里没有这些输入。

总之,看到车身颜色就按照统计概率看认为是蓝天白云,才做出了误判。

再比如,哪怕是再强大的机器翻译器,在遇到新词汇和压根没有在网上出现的词汇时就完全无能为力。

“坑爹”这样曾经的网络热词,假如没有一个网友曾经准确在网上翻译给外国友人过,那这个词翻译器就永远不会翻译,它没有能力根据上下文去猜测。

最后,没有评测体系的预测, AI 也无法胜任。

机器学习的 AI 都要有一个对量化标准的追求,以建立预测结果跟标准之间的关系来训练模型。

比如,当我们输入一堆音乐,来让 AI 学习后,AI 谱出的曲子一定是参差不齐的。

要么我们就在输入好的音乐后,还要输入坏的音乐,并且告诉 AI 好和坏的程度;

要么我们就在 AI 谱出曲子之后,反复给它的曲子打分。

AlphaGo 就是在 AI 互相对战反复确认胜负后,才能快速成长的。

在一些特殊的领域,像涉及到文艺创作的、有价值观差异的许多无法明辨好坏的事物,就很难让 AI 做好预测。

比如用 AI 去判定一个人是好人还是坏人,由于不存在评价好坏的绝对标准,那 AI 就无法完成。

目前的 AI ,只能基于“已知”做预测,不能创造未来。

都需要已知的数据、已知的结论、已知的课题。

从人类借用 AI 的预测做决策,到人类完全信任 AI 直接做决策,还有巨大的鸿沟要跨越。

3 AI 会让给哪些工作更有价值?

《AI极简经济学》里认为,数据、判断和行动是互补品,会变得更重要。

这三者分别是什么呢?

我讲下我的理解。

数据,指的不是做数据统计的人,或者做数据分析的人,而是指拥有数据的人/组织和有能力获取数据的人/组织。

比如,基于统计的消费推荐变得愈发重要,那阿里、京东的产品和背后的数据积累就变得重要;

基于统计的无人驾驶变得愈发重要,那交通部门、导航软件和网约车平台就变得重要。

有大量做数据工作的人,反而其实是在做 AI 替代品的工作,比如说单纯的导航功能,有角色会根据过往的用户出行数据来做分析和统计,以便找出一些规则。

但足够强大的 AI 根本不需要规则,只要输入足够,就能给出好太多的预测,就会把这样的角色替代掉。

(实际场景可能复杂得多,需要做判断,仍然需要人的参与。

)

判断,指的是要告诉 AI 哪些是对的、哪些是错的。

AI 学习和掌握一个能力,是为了人类服务的,那这个“服务的目的”,是必须人来赋予。

这里就需要人来给出判断。

比如,刚刚提到的导航功能,就可以用机器学习做得足够智能,可以算作是 AI 产品。

但是这就代表不需要任何产品运营的参与了吗?

当然不是,对于这个产品需要达成的目标尤其是约束条件,仍然是人要赋予的。

最短时间当然是第一要素,但在多大程度上用户会为节省时间而愿意付高速费?

多大程度上用户会很讨厌堵车或者等红绿灯?

等等,这些基于人感受的判断,会影响导航推荐路线的策略。

行动,当然就是基于预测的执行了。

拿到了无人驾驶的好算法,该怎样应用?

拿到用户消费行为的推荐,该怎样应用?

不过,通常执行的内容本身又会延伸出是否有可能被 AI 替代的问题。

我们以一个更具体的案例来说数据、判断和执行。

我在点我达做调度产品的时候,在搭建了基础的基于全局高效为目标的调度系统后,就发现了一个很实际的问题:

骑手经常会遇到取送餐的困难地点,而这个信息通过高德地图或者百度地图是无法获取的。

什么是取送餐的困难地点呢?

比如,这个大厦的保安不允许走客梯,那就只能走货梯,非常慢;

这个小区不允许电动车驶入,步行送餐非常麻烦;

这个商区高峰期人特别多,不管扶梯还是直梯都要等很久。

等等。

这个因素不考虑进调度的算法决策里,得到的结果就不准确,骑手就会很不满。