点击上方【车云】,关注并查看更多往期内容。

DeepScale的特色是,在嵌入式设备上实现原始数据融合。

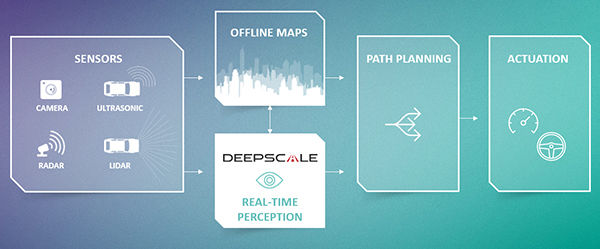

自动驾驶汽车观察周围环境时,如何满足安全、准确、实时的要求?其中很关键的一点就是把所有传感器的信息融合起来。

加州山景城有一家名叫DeepScale的创业公司,他们研发了一个 “感知系统”,可以用于ADAS和高度自动驾驶汽车。“感知系统”的最大特点在于,采用了原始数据 (raw data) 融合,而不是目标数据 (object data) 融合,并且可以在嵌入式设备上实现。

DeepScale的 CEO Forrest Iandola表示,目前很多深度神经网络(DNN)的研究是在现有DNN框架上调整修改。但是DeepScale利用原始数据开发了自己的DNN网络,这些原始数据不仅来自图像传感器,还包括了雷达和激光雷达。

Phil Magney是视觉系统智能(Vision Systems Intelligence,简称VSI)的创始人,他认为DeepScale的研究非常与时俱进DeepScale的方案利用传感器的原始数据来训练神经网络,这和其他传感器融合方法有什么不同?

▲后期融合

Iandola介绍,现在,大多数传感器融合都是目标层的融合,而不是原始数据层的融合。在大多数案例中,核心传感器都会在本身的芯片上处理生成目标数据,其他传感器把原始数据传输到主处理器生成目标,然后再进行传感器融合,这种融合方法叫“后期融合”。

融合目标数据与原始数据时会遇到一个问题,尤其是在不同传感器数据融合的时候。“比如激光雷达产生的是3D点云数据,当你要重建环境时,就会发现从摄像头收到的图像数据帧率完全不同。”

当生成目标时,无关的信息就会被过滤掉,于是就发生了原始数据的丢失。这些被过滤掉的原始数据可能能跟其他传感器数据融合。设想一些场景,太阳直射导致摄像头致盲,大雪正好覆盖了雷达,或者传感器数据得出的结果并不一致,在这种情况下,目标层融合就面临着很大的挑战。

▲早期融合

Iandola介绍道,“所以我们认为要在更早期就开始做传感器数据融合,而且要在更靠近传感器的地方进行,更早的融合可以减少上述那些问题”。

计算机视觉方面已经存在经过训练的DNN框架,并且发展良好,因为有很多早期自动驾驶汽车技术的研发者撬动着这个领域。但是对其他感知数据,比如雷达和激光雷达数据,并没有使用DNN神经网络进行过训练。DeepScale希望进入这个空白领域。

DeepScale在开发自己的DNN方面有一定的积累和经验。

还在学术研究时期,Iandola在加州伯克利大学和团队主要研究的就是一种名为SqueezNet的深度神经网络模型。团队里的一些人后来也加入了Iandola的创业公司。SqueezNet一开始不是为解决自动驾驶问题而生的,团队的研发初衷是“让这个模型做得尽可能小,同时能保证应用在计算机视觉数据集时,能有达到比较合理的准确率”。

类似的,Iandola也参与开发过一个类似的DNN框架——FireCaffe,用来加速训练,可以用于嵌入式设备。在一篇论文中,Iandola和他的团队表示基于一个GPU族群,FireCaffe可以大规模训练深度神经网络。

在思考“激光雷达和毫米波雷达缺乏DNN框架”这个问题时,Iandola称,“之所以这样也是有原因的。因为长期以来,摄像头成为了最流行并且容易获得的传感器,已经用来生成了很多感知数据。你从YouTube就能获得足够多的视频数据,结合地图信息,就可以比较容易地建构DNN”。

近期,DeepScale已经在和一些雷达和激光雷达供应商合作,为主机厂研发经过充分训练的算法。合作伙伴中既有老牌供应商,也有新技术研发公司。“DeepScale的目标是研发无需定制的DNN,可以从不同传感器导入数据。”

据Iandola介绍,团队使用多种传感器共有的信息,使感知环节的准确性最大化并降低不确定性。打过标签的训练数据可以被再次利用,这些数据可以来自不同传感器,在传感器端只进行了最小化的标定。

VSI的Magney认为,DeepScale的解决方案不因传感器方案不同而受影响,他们开发的DNN也可以在不同处理器平台上运行。DeepScale的技术可以帮助主机厂和TIER 1搭建出一个基于AI的环境建模方案,不用他们自己训练神经网络,也不用自己写算法。

DeepScale认为自己方案的优点在于——不受传感器方案和处理器影响。更重要的是,它在处理器上的运算效率很高,功耗也更小。

传感器原始数据来自4个摄像头和1个雷达,可以在一块用于智能手机APP的处理器(比如高通车规级芯片Snapdragon)上运行。12个传感器的原始数据可以在一块英伟达GPU上处理。

DeepScale十分清楚:主机厂十分关注成本,他们想要一个低功率处理器(无需额外冷却装置)。

▲DRS360平台

有一家名叫Mentor Graphics的公司,和DeepScale 的想法很像,前者最近正在推荐自己的DRS360平台。DRS360平台由Xilinx Zynq UltraScale和MPSoC FPGAs组成,使用了基于机器学习的神经网络算法。

Mentor的副总裁和嵌入式系统部负责人Glenn Perry称,“在设计高度自动驾驶的汽车架构时,数据层的传感器融合不是唯一的途径,但却是最聪明的方法”。

但是,收集多种传感器数据,实时进行数据层融合,这种想法在汽车行业引起了不同的反应。Perry 认为,OEM发展历史中逐级递增的设计思路会带来一些反对声音。

比如,一些OEM已经投入研发一款ADAS系统,使用的是来自雷达的目标数据,用于实现巡航控制。摄像头雷达做融合就可以实现紧急制动系统。让他们再回头去做数据层的融合,对他们来说要打破当前的做事方式。

Perry认为DeepScale正在做的用于数据层融合的算法,是一项很有“钱景”的创新,也正是他们研发DRS360解决方案时已经涉及的一部分,对Mentor Graphics来说是件好事。消费者在使用DRS360硬件平台时,DeepScale的产品可以作为一种可选的融合算法。

DeepScale的竞争对手是谁呢?

Magney介绍,很多东西都在发展,不少硬件公司(出售处理器或/和系统)都会提供DNNs/CNNs。他们通常会提供处理器/平台以及附加工具,来支持基于AI的算法,这部分算法和DeepScale提供的内容比较相似。“但是,”他又补充道,“大多数硬件公司的解决方案都不能提供DeepScale这样经过完全训练的算法。”

Magney表示,还没有那么多公司可以提供包含预先训练好算法的AI软件,用于传感器数据层融合获得整个环境建模。他补充道,“AImotive和Mobileye有类似的研究,但是需要专用且特定的主处理器”。

那么英伟达呢?Magney说,英伟达没有为全环境预训练好算法的软件“栈”。英伟达提供硬件解决方案和用来创建专门应用的工具,也是用原始数据做传感器融合。

但是分析师猜想,AI软件要耗费大量工作,并不像最初看到的那么简单。“创业者都在秘密进行研发,也很少说他们做了些什么。”

在最近公布的演讲中,VSI讨论了“自动驾驶汽车架构”这个话题。整个架构被分为5大部分——感知、定位&规划、决策/执行、控制,连接&I/O。

▲DeepScale的角色

DeepScale的关注点是前两个部分——感知、定位&规划,他们会支持整个环境建模,包括:目标识别、栅格网络、车道分割、目标追踪和自定位。

公司目前刚刚挤进行业。Iandola不觉得DeepScale一定要等待全自动驾驶汽车到来再推广这项技术。“我们看到感知方面的问题很普遍。类似的技术可以被用在已经量产的ADAS汽车和用来接驳服务的自动驾驶汽车。”DeepScale的感知系统适用于L2-L4/5。

Magney称Deepscale的产品适合用于现在的ADAS传感器组合,可以让OEM在中期更新中加入自动化功能。他们的软件最快可以在2020年进入量产车。

显然,安全是所有自动驾驶公司的关注重点。Deepscale跳出这个问题给了一个回答,他们觉得自动驾驶一定是比人类驾驶要安全的。

Iandola此前提到了“安全监管”的概念——自动驾驶汽车不是等待事故发生,车辆会进行自检。每个模块可以自检“此时能否让驾驶员放手”,或者“此时开启自动驾驶的把握有多少”。车不断发送数据,帮助识别出最坏的情况,并且建立一个有效的安全保障模型。

Magney指出,Deepscale在“栈”里有一个安全监视器,用来监管安全并且捕捉边缘案例,用来持续提升算法。此外他还补充道,Deepscale还支持OTA并为之建立了模型,功能和特斯拉十分类似。

车 云 推 荐

车 云 推 荐