有没有在网上遇到特别爱挑事的人?

不知为啥,有些人就是不会好好说话,一打字就是人身攻击。这种人古今中外都有,就连著名的维基百科也遇到了同样的危机。去年甚至有个维基编辑被网上的恶毒攻击弄得想自杀……

于是,维基百科和高科技孵化公司Jigsaw联合起来,试着解决这个问题,他们想到了——AI。

去年他们设立了一个研究项目叫“去毒”(Detox),试着用机器学习方法来标记出含有人身攻击的评论。研究者分析了维基百科14年来的评论,找出欺负攻击型评论的模式。

Jigsaw其实有个关于对话的AI大项目,“去毒”就是其中的一部分。这个大项目的最终目的是建立一个开源的AI工具,用以帮助网络论坛和社交媒体平台去打击网络骚扰和欺凌。

“去毒”团队刚刚发表了一篇arXiv预印本论文。(https://arxiv.org/pdf/1610.08914.pdf)论文讨论了维基媒体如何利用AI来研究平台上出现的骚扰。他们发现,骚扰的类型很多,我们需要多种多样的战术来打击才能奏效。

Ellery Wulczyn是维基百科的数据科学家,也是去毒项目的研究员,他表示,这不算是突破性的机器学习研究,但这个规模的数据能让我们更好地理解网络骚扰这个问题。而获得这些数据的关键,是教会AI识别出有毒的评论。

为了让算法可以识别出人身攻击,去毒项目用大量数据集来进行训练。他们先从维基的对话页面里拿到了10万条彼此争论的评论。接下来,4000人一起评出其中有人身攻击意味的评论,每条评论都经过10个不同的人检查。

这样产生的结果,就是目前最大的带注释的线上攻击数据集。

目前这个数据集可以在Figshare下载到https://figshare.com/projects/Wikipedia_Talk/16731 。他们的代码则放在了Github上https://github.com/ewulczyn/wiki-detox ——人人都可以使用,不限于维基平台。

接下来,就是用这些人工挑选出来的线上攻击言论,集中训练AI。

在完成了这样的大数据集中训练后,算法确定人身攻击的可靠程度,大约相当于一个由三位版主组成的团队。

Step3. 用训练过的AI,去评估维基史上所有的评论

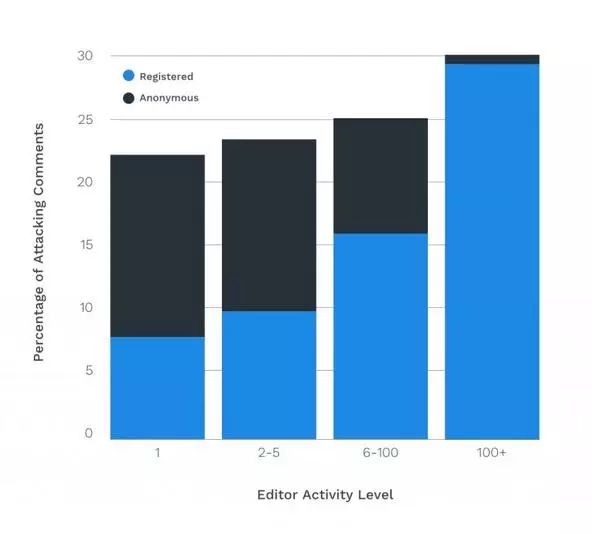

“去毒”团队随后又用算法分析了维基英文百科从2001~2015年间的6300万条评论,并分析了所有侮辱性评论的模式特点。Wulczyn说,“这就好像有个三人小组标记了一遍维基历史上的所有评论。这让我们可能更深入地分析并了解网络攻击。”

以下,就是AI的分析结果……

Wulczyn说:“这表明要终结网络攻击问题,需要多样化的策略。知道这点很有帮助。”

维基目前很关注网络攻击导致的编辑流失,研究人员也将利用这些数据来研究这点。他们还将研究如何用机器学习来改善维基的讨论氛围。比如说,AI可以自动标记一些可疑的评论来让版主关注。

Wulczyn说,他自己也同意要慎用机器学习方法进行自动判定。不过,用算法来分流事件,节省人力,不是很好吗?

面对AI的进攻,人类当然也不会听凭宰割。可以预想,当人们发现AI在监控他们的讨论时,他们就可能会尝试去愚弄算法。一些4chan上的家伙最近就用谷歌的产品名来替换一些种族歧视的辱骂,以此绕过歧视言论的算法监视。

当人类跟算法对敌时会发生什么呢? Wulczyn说他也不知道,可能必须不断监测人类眼中的人身攻击和算法眼中的人身攻击是否一致吧。

但去毒团队已经准备好接受挑战了。

不管是灵车漂移,坟头蹦迪,还是棺板冲浪,骨灰拌饭,或是螺旋飞升,火葬七分熟~都放马过来吧。先喷者贱,被AI打死应无怨。

Inside Wikipedia’s Attempt to Use Artificial Intelligence to Combat Harassment. (2017). Motherboard. https://motherboard.vice.com/en_us/article/wikipedia-jigsaw-google-artificial-intelligence

Wikipedia using AI machine learning algorithms to get rid of prolific internet trolls. (2017). International Business Times UK. http://www.ibtimes.co.uk/wikipedia-using-ai-machine-learning-algorithms-get-rid-prolific-internet-trolls-1606518

Wulczyn, Ellery, Nithum Thain, and Lucas Dixon. "Ex Machina: Personal Attacks Seen at Scale." arXiv preprint arXiv:1610.08914 (2016).

……为什么要识别哪些评论是恶意的?人类什么的,统统骂死就好了啊。

果壳网

ID:Guokr42

虽然换了二维码

但依然整天在科普些不正经玩意儿

欢迎关注

⬆️——而这,就是“去毒”团队和他们的AI想做的事情。