编者按:

神经网络算法重要推动人

Geoffrey Hinton获得了今年诺贝尔物理学奖,其1980年代反向传播算法将神经网络推到了新高度,但随后又开始下坠,实际上往后坐了接近30年的冷板凳,神经网络不是人工智能主流算法,直到李飞飞的ImageNet开启深度学习时代,Hinton用异于常人的信仰和坚持终于等到了光明那一天。

欢迎关注!

前言:

2018年计算机图灵奖颁发给了

Hinton,杨立昆(Yann LeCun

)

和Bengio

三位计算机科学家,他们共同开创基于深度学习的人工智能时代,也构筑了GPT的爆火和AGI的远景的基础设施。实际上,Hinton当下就职Google Brain,杨立昆则担任Meta(Facebook)首席人工智能科学家。如果再翻翻他们的学生,则几乎遍布Open AI,Deepmind,Google,苹果等顶级人工智能部门。本篇,我们从源头学习一下深度学习发展历史,其如何从一个普遍被质疑的科研方向,走到给人类带来AGI第一缕阳光。

书籍:《Genius Makers》by Cade Metz,

这本书也有中文版如下,作者简洁明了的基本按时间顺序梳理了神经网络从几次大起大落,从无人问津走向关注焦点,从学术研究走向顶级科技公司的发展历程,不管从核心人物角度,还是从核心公司角度都记录清晰,值得一读。

神经网络早期:信仰驱动研究

Perceptron,开端与“终结”。

Frank Rosenblatt出生于1928年,他大学专业是心理学,但是他的兴趣更加广泛。博士毕业后,Rosenblatt进入康奈尔大学航空学实验室做研究,基于美国海军国防部项目经费,他开始研究人的大脑结构,并且根据神经网络结构设计了Perceptron,1960年第一台神经网络

原型机Mark I

发布,这台机器可以通过学习认识

ABCD英文单词

(在有人告诉他结果是否正确前提下)。Rosenblatt对神经网络的未来保持乐观,当时学术界也有许多支持的声音,甚至认为人工智能时代马上就要到来(Rosenblatt自己认为

Perceptron只是一种能够识别特征的的工具)。

然而神经网络第一阶段发展被一位叫

Minsky的科学家终结。

Minsky是MIT的教授,他同样深耕AI领域,并且早在1969年就因为人工智能贡献,获得了计算机图灵奖。Minsky大胆直言不看神经网络未来,他甚至专门发布了一本书就叫《Perceptrons》,里面描述了当时神经网络

种种局限性

,比较有名的就是其连“

亦或

”的操作都做不了。Minsky“坚定有力”的反对声音几乎断送了神经网络发展,当时人工智能主流方式转向

Symbolists

(具体人工智能几个门派见

【读书】走向AGI的N条路径:科普篇

)。不幸的是,Rosenblatt在1971年一次划船事故中不幸去世,只活了43岁,没有看到神经网络翻身的那一天。相反,Minsky却活到了2016年,他应该看到了神经网络崛起的那一刻。

Hinton推动1980年代神经网络发展。

Geoffrey Hinton出生于1947年英国,他的家庭从祖爷爷辈(George Boole,逻辑学家)开始就是科学世家,此后家族里面

科学家辈出

。

Hinton

在想研究人脑,并且阅读了加拿大生理学家Donald Hebb的著作《The Organization of behavior》,这本书提到“

关联反应的神经元,同时也连在一起”。

正是这个理论,启发了前文提到的Rosenblatt等人工智能学家,因此Hinton认为生理学和人工智能科学

底层是相通,可以互相促进的。

然而,1970年代,Hinton求学时候,神经网络却是一门

不受待见的边缘学科

,甚至

在爱丁堡大学求学期间,Hinton的导师都跟随Minsky的脚步放弃了神经网络,拥抱了Symbolic。Hinton说他和导师每周一次的会面经常是大吵来结尾,可见Hinton真的是

热爱

才选择这个方向。此外,Hinton并不擅长计算机科学,他也不喜欢数学,但是他相信

只要让机器模仿大脑思考方式

,就能打造出强大人工智能。

发明Backpropation和Bolzman机器。

当时支持神经网络领域研究的政府项目很少,英国政府有一定支持,而在美国则主要集中在UCSD(圣地亚哥),Hinton于是来到圣地亚哥和相关教授

Rumelhart进行合作

。早在Rosenblatt的时候,他就认为如果能够打造

多层神经网络

,其就能突破“亦或”等当时不能解决的难题,而当时要打造一个多层神经网络最重要的问题就是系数如何确定,因为对于多层神经网络,不同神经元之间相互连接,相互影响。Rumelhart提出一种叫

Backpropation

的方法来计算神经网络的系数,但是最开始他总是把系数全部设置为0,这样得到结果是每次系数都会收敛到同样的状态(无用)。Hinton提出,如果

我们随机选择初始状态会怎样

?恰是这样的一种

微小初始状态改变

,神经网络开始可以处理亦或等Minsky当时指责的基础问题了。1980年代中期,Hinton和UCSD学者

Sejnowski

合作,打造了

Boltzmann机器,

其不仅能够分析声音、图片,而且能够产生对应的声音和图片,模仿人脑的想象模式。Hinton对神经网络的执念也吸引了CMU(卡耐基梅隆)大学计算机系教授Fahlman的关注,他觉得虽然Hinton是非主流模式,但是或许可以成为CMU在AI研究上的一种对冲,于是Hinton开始在CMU工作。在CMU期间,Hinton证明了神经网络通过

Backpropation

学习参数可以学习

很多知识

,比如可以识别家庭成员之家关系。

神经网络进入第一轮中兴,杨立昆发明CNN。

1980年代,Backpropation发明后,神经网络进入第一轮中兴,其中CMU人工智能实验室在1987年发布了可以

无人驾驶的模型。

实际上,CMU对于自动驾驶已经研究了数年,其最开始方式就是人将固定规则写入代码,但是汽车始终只能以几英寸

每秒的速度运行

(几厘米)。1987年一位博士生基于神经网络构建了模型,其能够观察人的驾驶行为从而自我学习,1991年其实现了

60英里时

速从匹兹堡到滨州erie的驾驶。其他案例包括Sejnowoski的

NETtalk

,其能够不断学习单词读音,从最开始很迟钝,到后来很流利(这个视频在Youtube还能找到)。

Yann LeCun(中文名杨立昆)

出生于1960年法国,他从十几岁开始就对学习的本质感兴趣,他

认为只要有大脑的动物就能够学习

,1985年他听了Hinton的演讲后,他发现后者和自己有共同的信仰,博士毕业后,杨立昆来到多伦多大学Hinton实验室做了一年博士后。杨立昆当时最大的成就是从一位日本学者那里获得灵感,发明了“

卷积神经网络

”(CNN),其基于视觉神经分层的特征,CNN也是通过不同层次提取不同特征,最后再合并分析,使得神经网络获得重大突破。基于CNN,杨立昆打造了

能够识别手写英文字体的模型

,其当时在ATT 贝尔实验室工作,这项发明也成为最早商用的神经网络应用之一——1990年代美国大约

10%

的手写支票是这个模型来读取的。此外,杨立昆还主导研发一款专门针对神经网络的ASIC芯片,用来提效。

神经网络破圈:成为巨头追逐对象

算力不够导致神经网络再次陷入低谷。

神经网络模型在1980-1990年代迎来高峰后,再次遇到了低谷,核心原因还是其当时发明都有些华而不实——NETtalk看起来像个

Party上展示娱乐项目

,杨立昆手写识别模型也不过是

众多能够处理类似

工作方式中的一种,同时CNN模型在遇到更加复杂的照片时候就会显得无力。Hinton认为行业遇到瓶颈的原因

是算力不够

,但是当时大家也不知道到底还需要多少算力。拿典型翻译工作来说,直到2004年,神经网络在所有翻译方式中排第三,排前面的例如

类比模式

(类比不同语言中出现频率和场景类似的词,大概率就是对应翻译)。加拿大成为了低谷期对神经网络仍然有信心的科研人员聚集地,其中,Hinton在多伦多大学,Yoshua Bengio在Montreal大学,只有杨立昆在纽约大学。

Ian Goodfellow

(GAN的发明者)当时就放弃了斯坦佛等大学Offer,入读了Montreal大学,因为他想研究神经网络。甚至当时的学者们开始避免使用神经(Neural)这个词语,神经网络仅仅出现在5%当时相关领域研究论文中。杨立昆的重要发明CNN(

Convolutional neural network

)被改为“Convolutional networks。

Hinton坚持深耕,进入深度学习时代。

行业遇到低谷并不耽误Hinton继续为其废寝忘食,他甚至根据自己

体重减轻程度

来评价科研想法的重要性。2004年,Hinton开始探索

大模型大数据

(相对前面模型而言),他最开始称之为“Deep belief networks”。当时,在神经网络重要科研论文基本上都和

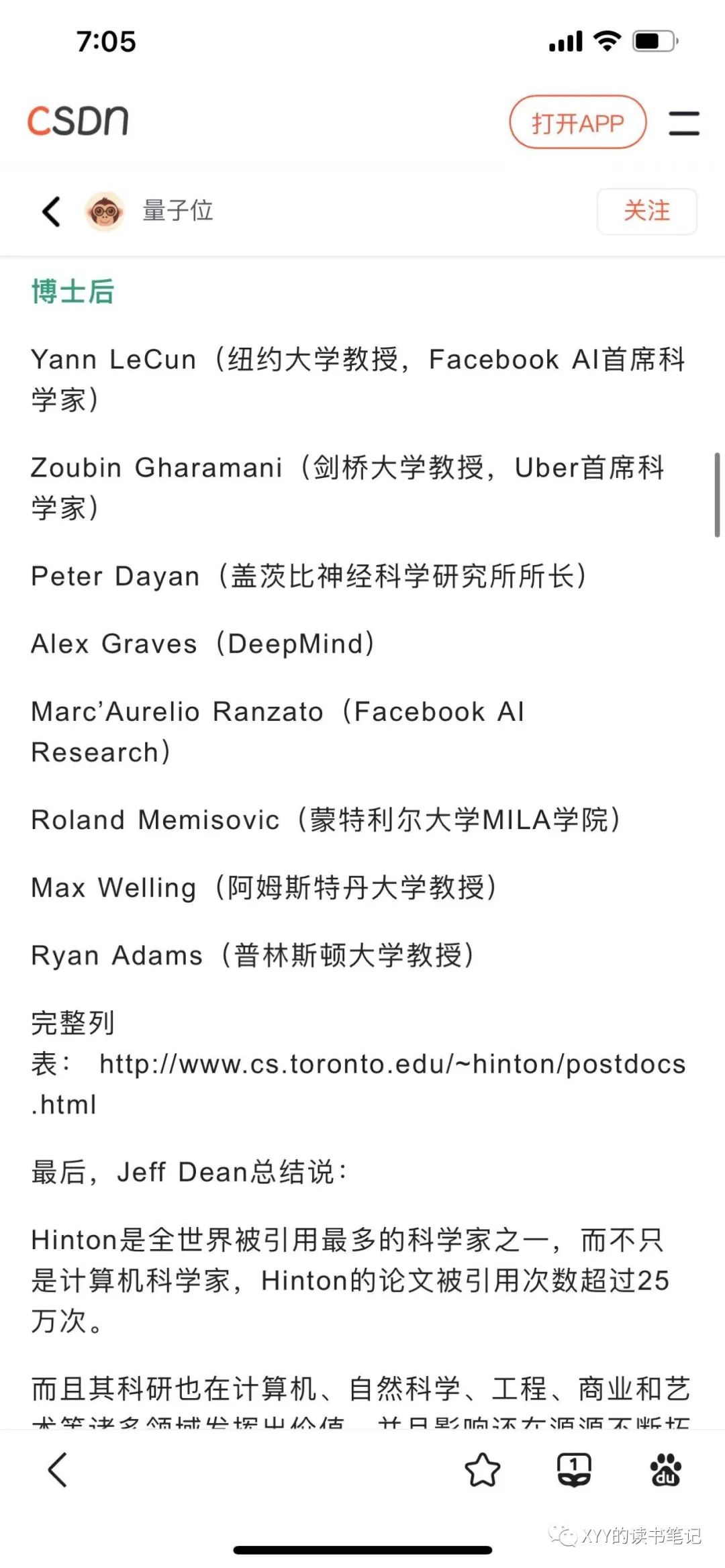

Hinton和他的学生

有关系,也不知道是优秀的人才都跑到了他那里,还是他拥有超于常人培养学术技能,下图可以看看Hinton的学术目前分布。Hinton认为只要是好主意,不管多久都必须坚持(Bengio,杨立昆,包括后来加入百度最终创办地平线的余凯,都是神经网络深度信仰者)。2007年,在每年一度人工智能权威

NIPS

会议上Hinton在他60岁之际发布了

深度学习

的概念,这个名字指的还是多层神经网络模型,更多是一种重新命名营销,用来重振这个不怎么被关注的学科。

深度学习在语音识别获得突破。

2008年,深耕语音识别多年,当时在微软工作的邓力同样在NIPS上遇到了Hinton,后者表示深度学习已经

在语音识别上取得了突破

。邓力不相信,因为过去多年来深度学习从未真正解决过某个重要问题,Hinton当时发布了神经网络

通过大量数据训练后

可以成为行业领先语音识别解决方案,但是论文没有引起关注。2009年夏天,邓力邀请Hinton到微软访问,并且共同探讨语音识别,微软研发实验室从1991年成立开始就致力于解决语音识别等核心问题。当时Hinton的背部疾病已经开始发酵了,他已经不能坐了,怎么移动成为了重要问题(后来Google都是雇佣私人飞机)。此后,Hinton用MATLAB编写了简单的模型代码,最终证明神经网络效果不错,虽然仍然不如当时表现最好的模型,但足以让邓力相信其潜力(因为刚开始)。当时,多伦多大学已经开始使用

GPU训练模型

,当邓力在微软内部要求购买GPU时,却遭遇了反对,一方面领导认为GPU就是给游戏的,不是给AI科研的;另一方面,当时微软从CMU雇佣一位研发负责人Peter Lee

压根也不相信神经网络的未来

,他的观念还停留在Minsky抨击神经网络时代。当年夏天,Hinton的学生

George Dahl(后来就职于Google Brain)

展示了可以在一堆吵杂的噪音背景下识别出真实含义的模型,深度学

习取得了突破,且立马引起了连锁反应,

2010年秋天,Hinton的学生Mohamed开始在

IBM的Watson

实验室工作进行类似研究。

Google开始接触神经网络。

也就在2010年左右,Hinton的学生Navdeep Jaitly(Google Brain)来到Google进行暑期实习,准备复刻神经网络进行语音识别。一位Google工程师问他是否可以基于

2000小时

语音材料训练一个识别模型,他惊呆了,因为之前Dahl和Mohamed基于训练语音库只有

3个小时。

Google的海量数据在神经网络夹持下效果倍增,Jaitly的模型错误率只有

21%

,当时最好的系统却有

23%

,经过2个星期调整后,Jaitly系统错误率下降到

18%

。这个效果

显然超越了Google工程师的预期

,虽然当时深度学习模型处理速度仍然只有竞品的十分之一,但他们仍然决定

半年内

落地商用产品。等产品真正落地后,外界还没感知到差异,一个之前合作公司找Google合作一种可以降噪的芯片,显然深度学习模型已经

强大到替代了这种应用了

。此外,2010年,来自斯坦佛大学深耕神经网络的教授Andrew Ng和Larry Page吃了个饭,他跟Page说深度学习不仅仅可以做图片识别,语音识别等,未来还可以走向

真正智能(AGI)

。

Hinton加入Google。

2011年,Andrew Ng加入Google,最开始他找到Google搜索的负责人Amit Singhal想把深度学习运用到搜索,Ng说这样用户就不需要搜索关键词,而是可以

直接问问题了(想象现在GPT)

,

Amit Si

nghal表示没有兴趣,他觉得用户不喜欢问问题,

关键词搜索就是最顺人性的方式

。深度学习还有一个仍然望而却步的点就是不可解释性(黑盒子)。Andrew Ng还是在Google内部找到了盟友,Jeff Dean,后者是Google的元老员工,其擅长将

一系列工程系统整合

在一起并且高效工作。

Jeff Dean此前研究过神经网络,且对其很感兴趣,重要的是他在Google拥有话语权,且乐于合作。他们开始建立一个模型用来

识别Youtube视频中的猫,且

在第二年将研究成果发布论文,这就是有名的

Cat Paper,

这项研究还有一个重要成果就是催生了

Google Brain(2011)。

2012年,Andrew Ng离开了Google,他推荐的继任人就是Hinton,2013年,Google以

4400万美元

收购了Hinton的创业公司(当时竞购公司包括微软、Deepmind、百度,Hinton和自己学生

Ilya Sutskever(Google Brain——OPEN AI)和Alex Krizhevsky(Google brain,17年离开)一起创立的

)。Hinton到了Google后(他还保留多伦多大学的教职,他的做法后来成为模板,杨立昆到FB也保留了NYU的教职),发现公司

很多做法都是错的

,比如还用CPU而不是GPU在训练模型,比Google的模型(叫Disbelief)用的还是

没有经过标注的数据

。2012年,Hinton指导学生

Ilya Sutskever和Alex Krizhevsky

基于改善后的CNN算法赢得了ImageNet比赛。深度学习一系列的突破吸引了全球顶尖科技公司的注意力,其中包括微软的

邓力和陆奇

,百度的

余凯和李彦宏等

。

DeepMind:AGI的雄心

创始人Hassabis。

Demis Hassabis出生于1976年,跟Google的两位创始人基本处于同年龄。他有四分之一中国血统,其目前是一位新加坡的华裔。14岁时候,Hassabis就曾经是

全球排名第二

的国际象棋选手。Hassabis拥有不服输的品质,Hinton评价他

开朗、有竞争力

和

擅长社交(他很会激励周边的科学家,一起工作,同时兼具视野、技术和管理的人才,实在难得)

。Hassabis有两个兴趣爱好,第一个是

游戏

,在gap year,他曾经和英国游戏设计师Molyneux设计一款销售量达到1000万份的主题公园游戏,开创虚拟人生品类游戏。他第二个兴趣爱好就是

AI

,他相信自己能够打造类人脑的机器。他进入伦敦大学(UCL)攻读神经学博士。此后,他进入Gatsby Unit进修博士后,这个实验室研究领域横跨神经学和AI,其创始人之一就是Hinton。Hassabis坚持认为学术研究只是暂时状态,最终他一定要在商业落地,他认为这是唯一能够获得充足资源的方式。其创立Deepmind后,这俩爱好

合二为一了

,公司很长时间的研究项目就是训练会打游戏的AI。

DeepMind成立,被Google收购。

2010年,Hassabis,Deepmind另外一位创始人

Shane Legg,

以及一位社会活动家

Mustafa Suleyman

联合成立了DeepMind,在商业企划第一行清楚写着他们的目标实现Artificial General Intelligence(AGI),也就是

通用人工智能

。在成立之初的会议上,Hassabis认为要实现AGI的终极方式就是模仿人脑,核心是提取人脑思考的形式和核心算法。

Shane Legg则认为AGI实现过程中可追踪性很重要,

其始终要重视AGI发展的风险。Peter Thiel成为DeepMind第一位投资人,在200万英镑种子轮投资中,他投资了120万。DeepMind首先尝试方向是训练机器玩古老的Atari接机游戏(Pong),他们使用“

加强学习

”方式,使得模型可以在无监督模式下自己摸索玩法,自我学习。此外,DeepMind内部还在研发一款可以根据文字生成图片的模型,

Generative models

也是其最早重要研究方向之一(GPT就是)。2013年,Google收购了Hinton的公司后,深度学习得到了

Larry Page

充分重视,并且开始追逐其他行业顶级的收购对象,DeepMind自然成为其目标,为了表示诚意,其租了一架私人飞机载Hinton(Hinton背有问题,不能坐,只能躺着)到伦敦谈并购。当时AI领域的军备竞赛已经开始,大公司为了追逐顶尖人才都很舍得给钱(此后一次财报中,DeepMind 700多名员工工资高达2.6亿美元,平均年薪达到

37万美元

,这里面还有大量刚毕业的博士生),DeepMind也感受到了压力,选择了出售,Google收购价格是

6.5亿美元

,DeepMind两位创始人出售最重要要求就是他们

研发技术以后不能用于军事,Google也同意DeepMind被收购后保持独立运营

。实际上,当时竞购DeepMind还包括Facebook,且后者愿意出比Google高一倍的价格,但是Hassabis在和Zuckerberg聊完之后,觉得他们在最基础的问题上存在较大分歧,Zuckerberg不觉得AGI是一种风险,但是Hassabis显然不这么看,他们觉得两家公司文化很可能不能融合。

Google将深度学习融入各个产品。

如前文所言,Google在收购Hinton的公司后,其计算中心还在用CPU计算而不是GPU,Google数据中心负责人当时对于深度学习并没有信仰,因此也没有看到为其匹配GPU的重要性。最终Jeff Dean和

John Giannandrea

两人最终拍板给Google买了

4万张GPU

(投资了1.3亿美元)。此后,深度学习开始向Google 各个产品渗透,以自动驾驶为例,只要Google能够搜集足够的代表各种情形的数据,神经网络就能够自动识别足够多的物体。此后,深度学习被引入

Google Photo

(自动分类照片),

Gmail

(自动预测下一个词语),

AdWords

(预测用户点击率)。最终Google搜索也不得不拥抱深度学习,2015年其推出

RankBrain

,基于神经网络来排序搜索结果,其帮助公司提升了

15%搜索请求

。DeepMind还打造一个能够

智能调节数据中心耗能的神经网络

,很快其帮助Google节省的能耗成本就把

收购DeepMind的成本收回来了

。当然,最主流的应用还是语音助手,除了苹果的Siri,Google在安卓系统推出语音助手,亚马逊也推出Alexa。百度、微软、Facebook也开始建设自己的语音助手(基于深度学习)。英伟达也很快基于深度学习概念重新组织了自身的AI布局,开始探索图片识别和自动驾驶。

Sutskever发明语言模型,奠基大模型路线。

Ilya Sutskever 是Hinton的博士生,当他加入Google后(通过对Hinton公司收购),深度学习已经在图片识别,语音识别上取得了突破,下一个要攻克的目标是

翻译

。当时,Google Brain已经做了“

知识图谱”

方向的研究,即通过机器分析一系列英文语料(比如Wikipedia),神经网络可以建立

一张庞大的知识图谱

,在其中任何单词都会变成一个向量,和诸多其他向量产生连接,比如Harvard会和University,Ivy,Boston相连,这张图谱不是我们人类认知的二维,或者三维,而是

有成千上万的维度

。Ilya Sutskever加入后,基于这个概念,给机器提供英文和法语对应翻译的语料,模型在分析英语和法语后,会在两种语音之间建立向量连接,他这套

系统翻译效果

超过了当时效果最好的解决方案。Ilya Sutskever看来,这种方法不仅可以用来翻译,只要有合适的数据,还可以用来进行一系列生成场景,比如很快

提炼文章核心要义

,比如提炼图片中核心意思,只要有

足够大的模型,足够多的数据

,成功是确定的。Ilya Sutskever后来成为了

OPEN AI的联合创始人

,实际上,当时他想法和GPT已经比较接近了(后来Google推出的Transformer延续了这个思维)。最后,为了加速模型训练,Google还专门研发了

TPU(专有硬件,此后又基于此推出了TensorFlow,深度学习云计算运行基础设施

),其省去了一些计算的精细度(比如13.64*45.83就会变成13*45),但是换来了训练速度的飞跃。

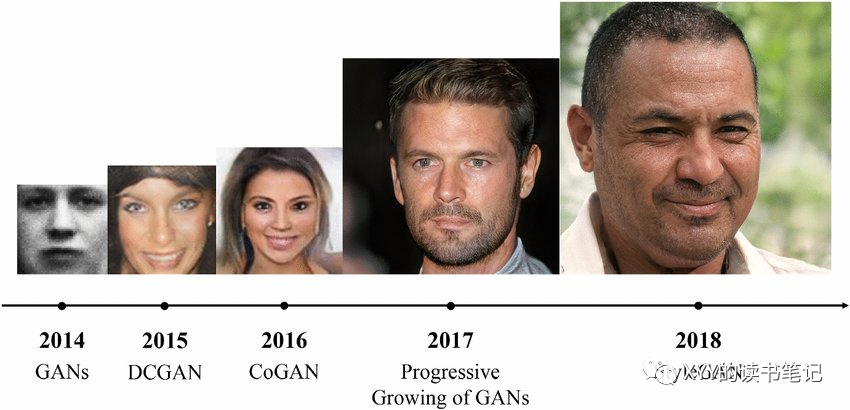

GAN——生成逼真AIGC创新模式。

2013年,Bengio的博士生Ian Goodfellow面试了Facebook,觉得不合适,他对Google Brain的工作更感兴趣。在一次实验室博士聚会中,有人提出

如何使用神经网络模型生成逼真的图片

,当时DeepMind已经有方法可以反向生成图片,但是只是对高品质输入图片才有用。在聚会中,博士生提出可以基于生成图片进行像素级分析,然后和原有图片进行对比来验证仿真程度。Goodfellow提出一个颠覆式创新的想法——为什么

不训练两个神经网络模型

,其中一个生成图片,一个来验证生成图片是否足够逼真呢?这样,两个模型可以互相促进,直到生成的图片足够逼真(能够骗过机器)为止。这个想法被其他博士生嗤之以鼻,但是Goodfellow决定自己尝试,且取得了不错的效果,他在论文中将这个模型命名为

Generative adversarial network(简称GAN)

。2016年,杨立昆在一次科研会议上将

GAN称为深度学习过去20年最有趣的创意。

此后,英伟达发布了Progressive GAN,能够生成全尺寸的植物、动物、汽车等逼真的图像。同时,在分析了数千张人脸后,其能够生成

逼真的人脸

,Deepfake时代来临,也同时

让AI伦理和AI安全成为大家关注重点

。

巨头们的深度学习野心

Facebook邀请杨立昆建立AI Lab。

深度学习的突破进展,以及Google的一系列动作当然也吸引了Zuckerberg的注意力,Facebook也要建立自己的AI Lab进行深度学习研究。Zuckerberg找到了杨立昆,请他领军(足够分量),但是后者担忧Facebook

是否能给一个长期的科研环境

(而不是追求短期回报),最初只是答应做咨询。Zuckerberg展开了持续追求,他告诉杨立昆深度学习可以在社交网络有充分发挥空间,可以自动识别语音、图片等;长期来看,可以打造元宇宙里面的自动助手等。杨立昆问,有什么领域是Facebook不会做的吗?Zuckerberg的答案是

机器人(

真正的)。最终,杨立昆被打动,答应出任Facebook AI实验室主任,但是他提了两个条件,其一是

不离开NYU的教职

(兼任),且不离开纽约(Facebook在纽约设立办公室)。他每周会花一天在NYU,四天在Facebook。此外,他要求在Facebook推行学术界的

开放研究标准

,因为只有开放可以加速研究。实际上,杨立昆的要求后来成为很多顶尖科研人才进入科技公司的标准。实际上,除了直接被科技公司高薪聘请,在深度学习军备竞赛期间,

极客们觉得先创业,然后被收购的收获更加丰厚

,比如杨立昆一位学生

Clement Farabet(最新就任DeepMind研究VP)

就拒绝了Facebook邀请,选择自己创业Madbits,六个月后还没推出真正产品,公司就被Twitter收购(上千万美元到手)。

Facebook基于AI在内容审核领域尝试。

2016年后,Facebook持续陷入舆论危机(

【读书】Facebook的救赎:那些成功的光环,终将褪去?

),核心还是其平台上的内容出了问题,各种色情、恐怖组织内容还好识别,Facebook通过训练机器学习模型,开始快速解决问题。但是最难处理的就是Hate Speech,很多时候就是不同观点,这个很多时候连人都分辨不清。因此,众多专家包括杨立昆在内都不觉得AI能够处理好Hate Speech的问题。2019年,一个

新西兰杀手在Facebook直播枪击全过程

,平台用了1个小时才下线直播。主要原因是AI没有见过类似的场景,所以没有识别出来。在内容审查方面,Facebook不得不依赖更多人力。

微软:起个大早,赶了个晚集。

微软一直在人工智能领域投入了很大的精力,包括深度学习在语音识别领域应用最早也是邓力和Hinton的合作成功。然而,在深度学习后续的发展进程中,微软开始落后了:首先是

Windows

拖了后腿,由于当时神经网络训练都是

基于Linux

,其能够提供显著更便宜和更灵活的建立分布式计算系统的解决方案,但是微软的研究员们却不得不基于Windows。2009年,陆奇加入微软后,负责打造了Bing搜索,他也成为深度学习在微软内部忠实支持者。在陆奇看来,微软的问题在于

用老方法去运用新技术(New Tech,Old Way)

。他觉得微软当时思维惯性仍然在PC的世界里,但实际上当时已经过渡到了移动互联网,他们总是为已经不再存在的市场去打造产品。一个典型案例是当时执掌微软科研实验室的

Peter Lee(他现在还在)对深度学习

的观念还停留在Minsky时代,根本不相信其能够取得突破。为了寻找深度学习领军人物,在当时新CEO Nadella支持下,陆奇飞到加拿大去拜访Bengio(2018年和Hinton,杨立昆共享图灵奖),想请他出山,但是后者坚决留在学术界,他把自己学生创立一家公司

Maluuba

介绍给微软(2017年1.3亿美元收购)。为了让公司摆脱这种思维惯性,陆奇还专门设计一款Backward Bike(就是反直觉的,车把往左,车轮往右),结果摔伤了自己,2016年陆奇离开了微软。虽然微软初期落后,但微软后来和OPEN AI合作,强调了AGI时代第一张巨头入场券,不得不说世事难料。

百度进入深度学习。

百度进入深度学习首先可以追溯到在

余凯

推荐下,对于Hinton公司的竞购,当时百度愿意匹配GOOGLE开出的任何价格,只是Hinton没有选择百度而已。此后,李彦宏就开始紧密关注深度学习。2014年,知名深度学习专家

Andrew Ng

加入百度,并负责在百度广告竞价广告系统,搜索系统中运用深度学习。2017年初,

陆奇

加入百度,引领百度进军自动驾驶领域(他在微软时候就想推动),在陆奇看来中国拥有最大规模的用户,数据优势最终将使得AI在中国拥有更好的应用效果。此后,对标Google的TensorFlow,百度也发布了“飞浆”可以说,百度确实是国内最早进入深度学习领域的科技公司之一。

Alpha Go掀起新一轮高潮

Alpha Go击败李世石。

2015年,Facebook的CTO

Mike Schroepfer

提到公司的深度学习专家们正在教模型下围棋。实际上,AI模型在

国际象棋领域早就取得了突破

(早在1997年IBM深蓝打败了国际象棋大师卡斯帕罗夫),然而

围棋

却是一个从复杂程度远超国际象棋的品类,计算机一直没有突破。Facebook对外放风背后其实有一个重要目的,就是Zuckerberg很想在机器学习等方向做出引领行业的成果,让外界认为Facebook是科技引领公司。然而,

DeepMind的Alpha Go最后抢先了

,就在Facebook对外宣传几天后,DeepMind就在《Nature》上发表了一篇论文,描述了Alpha Go击败了欧洲的围棋冠军。2016年3月,Alpha Go迎来了历史时刻,他将对战当时人类最优秀的围棋选手

李世石

。在李世石以及绝大多数外界看来,

李世石毫无疑问会获胜

,然而Hassabis有很不一样的认知,因为他看到了Alpha Go夜以继日的自我训练,在迅速变得越来越聪明,在击败欧洲冠军Fan Hui后,Alpha Go又变强了很多。最终结果大家可能有印象,5局比赛,Alpha Go

最终4:1获胜

,有趣的是,模型在第4局78步上走了一步昏招(李世石也变聪明了,他故意下了一步Alpha Go没有看过的招数),最终挽回一点颜面。2017年5月,当Alpha Go面对柯洁时候,后者就没有那么好运了,3:0战胜了柯洁。实际上,Google 2017年将

Alpha Go带到乌镇比赛

也有点私心,就是想在中国推广Google云,特别是TensorFlow 深度学习计算服务。此外,当时Google 还邀请斯坦佛大学AI教授李菲菲在中国组建AI Lab。,但是这个想法显然有点天真,一方面BAT等国内互联网巨头都在组建自己的云计算能力,另一方面,Alpha Go VS 柯洁最开始的直播计划临时被取消,也显示了监管的态度。

Google继续推动深度学习发展。

首先是在医疗应用领域,印度每年有7000万糖尿病人,他们都有致盲风险,如果处置得早,则可以避免。2015年,一位印度裔的Google工程师想打造一个基于深度学习的识别糖尿病致盲症的模型。2016年,团队发表论文发现深度学习系统在识别致盲症准确率高达90%,相比于行业标准80%。Google Brain也专门成立了

医疗小组

,DeepMind内部也成立了

医疗健康小组

。2017年,Google准备和国防部合作基于深度学习打造自动攻击的武器,这个项目本身很小只有大约3000万美元,但是Google目标是国防部10年价值100亿美元云服务采购订单。然而,将深度学习运用到制造武器引起了

包括Google员工在内各方面的反对

,Elon

Musk认为在军事方面AI可能是最危险的领域

。大家可能记得DeepMind出售给Google时候最重要一个前提条件就是其研发技术不会用于军事领域。由于各方的激烈反对,Google最终取消了这个小项目合作,但很快内部反对这个项目的员工也开始被边缘化。2018年,在Google I/O的会议上,公司发布了

能够自己打电话的语音助手

,其将原来仅能识别又往前推了一大步,包括语音识别、语音生成、自然语言理解等,会上助手演示了自己打电话订外卖等操作,显示了AI的进展。

OpenAI另辟蹊径

OpenAI成立。

2015年,Y Combinator的负责人 Sam Altman,支付平台Stripe的CTO Greg Brockman,以及Elon Musk等讨论成立一家独立于大公司的AI公司的可能性。Sam Altman生于1985年,2005年他创立一家社交网络公司Loopt,获得了Y Combinator的投资,7年后社交网络公司关闭, Sam Altman直接被

Paul Graham

任命为接班人,在运行YC时候Altman培养了自己识人的能力,更不用说融资的能力。回到2015年当天会谈,他们谈论几个核心问题:现在成立AI实验室太晚了吗?他们一致认为难度很高,首先是要获得最优秀的人才,其次才可能有研究成果。他们首先联系了Bengio,后者推荐了一些顶级AI人才其中就包括当时在Deepmind工作的

Ilya Sutskever

,这些AI研究者们被一个

独立、开放(初衷是研究成功免费共享给社会)

的AI研究组织定位吸引,同样也被Musk等人对于

AGI未来发展审慎的态度所吸引

。3周后,他们联系的10位专家中9位同意加入Open AI(5位有DeepMind工作经验,Hassabis觉得自己被Musk背叛了,因为后者也投资了DeepMind),只有

Ilya Sutskever还在犹豫,

因为Google给他开出200万美元年薪,而Open AI只能给他零头,最终他还是答应加入。早期OpenAI并不被看好,杨立昆就觉得,他们招募了一些不错的学者,但是都太年轻了,OpenAI也太小了,很难在长期保持人才竞争力。

开放的科研理念实际上并不新鲜

,Facebook、Google实际上都公开了他们大部分科研成果(GPT基于Transformer就来自Google)。

OpenAI的初衷,以及妥协。

Altman看来,随着AI能力不断增强,AGI只是时间的问题,到时候Google是不是愿意向他人分享是个问题。因此,OpenAI建立初衷就是进行类似技术研究同时向外界公布他们的研究成果,任何人都可以使用他们的开源成果。从研究方向来看,OpenAI的研究方向包括

语言大模型

,以及

机器人

(基于加强学习,在虚拟世界里面玩Dota2,类似DeepMind)然而,随着技术不断发展,他们开始意识到开源的技术也可能被坏人使用,比如可能用来生产虚假信息等。2018年,GAN之父,

Ian Goodfellow

在加盟OpenAI 11个月之后,

宣布回归Google

。此外,Musk宣布从OpenAI离职,核心原因是特斯拉的利益冲突,他还在OpenAI挖走了

Andrej Karpathy(2022年又回到了OpenAI)

,后者将执掌特斯拉的AI部门。Altman面临需要持续吸引顶尖人才的问题,在当时高昂人才成本下(微软的Peter Lee说一名AI科学家的成本高于一名NFL四分卫),OpenAI也不得不设立

营利架构(很复杂,投资者回到不超过投资100倍)

,当时创立一个

不受商业干扰的科研环境的初衷只坚持不到4年

。2019年微软宣布投资OpenAI

10亿美元

。在Altman看来,OpenAI不管是变得更加封闭,还是变成营利性都是为了一个目标——实现有利于人类的AGI,他认为要实现这个目标还需要

250-500亿美元(

2019年说的)。另一方面,OpenAI这种初衷改变还是引起了一批员工的警觉,有一部分选择出来创业,其中比较有名包括基于加强学习的机器人公司Covriant,以及2021年成立的开发类似大模型LLM的Anthropic。

Google BERT看到AGI的曙光。

2015年,杨立昆在一次和一位学者辩论时候提到当时AI领域已经发生的主要应用场景是识别物体和翻译,下一步就是让深度学习模型

能够理解人类的话(NLP)

,甚至能够进行对话。2018年,一位Google工程师发布了

Bert大模型

,其被称为Universal language model——基于大模型,大数据(出版图书、Wikipedia等),OpenAI、Google等都在进行类似的研究(GPT),其中GPT核心方式通过上文预测下一个单词,而Bert则是通过上下文进行完形填空。后来Bert证明可以通过

Allen Institue

一系列阅读理解的测试,回答一些知识类问题。Google 将BERT进行开源,并且在

100多种语言进行训练

,也有其他人用更大数据来训练它。NYU一位教授Gary Marcus预测说NLP模型不会发展太快,因为学者们经常会聚焦他们擅长的领域(意思是还不擅长LLM)。Hinton反击说,他的话没有技术描述,

“永不过时”。

加强学习+机器人。

2015-2017年亚马逊一直举办一个拣货机器人大赛,其要求参赛机器人在15分钟里面分拣10个货品,难度很高,也现实行业的需求。Google Brain在建立医疗分布后就开始

AI+机器人研究,由

Sergey Levine主要负责,他觉得人类可以通过与外界的感知交互获得技能,机器人也可以。于是Google Brain开始设置了一些机械臂,让他们基于深度学习模型自我学习如何分拣货物,几个星期后,这些机械臂能够轻松捡起“

眼前

”的货品。2019年,Google Brain发布一个机械臂,通过14小时学习后,能够拿起货物丢进正确的箱子里,准确率达到85%,而人类准确率只有80%。OpenAI也在做类似的研究,除了训练机器人打游戏(Dota2),其

Rubik's Cube(魔方)项目,

当他们要训练机械臂时,他们选择在虚拟现实世界里面训练(不是真正的机械臂,而是仿真)。另一个知名AI机器人创业企业是

Covriant

,其创始人为前OpenAI员工,

Abbeel,以及他的学生PeterChen和Rocky Duan

。

Covriant

最早投资人来自Hinton(他说后悔当时投少了)和杨立昆。Covriant后来和著名机器人公司

ABB

达成合作,在一个德国仓库的实验中,其机器人分拣准确度达到

99%

。

Hinton聚焦研究Capsule Network。

早在Hinton到Google之后,其便和Jeff Dean合作开始了对

Capsule Network研究,

其是缘起于1970年代的一种更复杂模仿大脑结构的模型。在Hinton看来,当时深度学习模型能够通过输入图片识别各种物体,但是这些图像都是

二维的

,比如其可以识别一个咖啡杯,但是如果被子打翻了,模型可能就认不出了。

Capsule Network

能够有三维信息输入(和人一样),2017年,他推出了能够比当时主流神经网络从不同角度更准确识别物体的

Capsule Network,

在Hinton看来,

Capsule Network

本质是对大脑结构一种更复杂的模拟,其潜力可能也更大。最开始,Hinton不看好DeepMind的加强学习路线,他觉得需要太多数据、太多算力。他也不看好AGI的方向,他觉得

机器就是专用的就行

,为什么我的

手术机器人需要知道棒球规则呢

?但是后来他投资Covariant后,他看到加强学习的强大效果后,相信了加强学习的威力,但是

他仍然不相信AGI

。

结语:因为相信,所以看见

那个写书抨击神经网络的Minsky 1969年就拿到了图灵奖。1970年代,Hinton

冒天下之大不韪

,选择了无人问津的神经网络研究,出于自己的相信,杨立昆,Bengio也是,他们2018年终于拿到了图灵奖。

DeepMind和OpenAI的创立本身就来自于对AGI的信仰。

微软在2010年神经网络爆发没有赶上,因为Peter Lee等人

压根不相信神经网络

能有这么大威力。Google Brain没有追上GPT这一波AGI浪潮,是不是和Hinton压根不相信AGI相关?(可能他现在不这么想了)。

这个世界能够阻碍你进步的,大概只有你的认知了。