选自arXiv

作者:Yunpeng Chen等

机器之心编译

参与:蒋思源、Smith

最后一届 ImageNet 挑战赛

刚刚落下帷幕,而新加坡国立大学参与的三个团队都凭借着双路径网络(DPN)获得了非常不错的成绩,其中 NUS-Qihoo_DPNs (CLS-LOC) 团队获得了目标定位任务中的冠军。在本文中,我们将简要介绍这篇双路径网络(DPN)论文,希望能有助于读者构建更加高效的计算机视觉模型。

论文:Dual Path Networks

论文链接:

https://arxiv.org/abs/1707.01629

在本项研究工作中,我们提出了一种用于图像分类的简单、高效和模块化的双路径网络(Dual Path Network /DPN),该神经网络内部连接路径采用了一种新的拓扑结构。通过在 HORNN 框架下揭示性能最优秀的残差网络(ResNet)和密集卷积神经网络(DenseNet)之间的等价性,我们发现 ResNet 能重复利用特征,而 DenseNet 能探索新的特征,这两种都对学习一个优秀的表征十分重要。为了获得两种路径拓扑的长处,我们提出了双路径网络(DPN),该神经网络能共享公共特征,并且通过双路径架构保留灵活性以探索新的特征。我们在三个基准数据集(ImagNet-1k、Places365 和 PASCAL VOC)上的大量实验表明该 DPN 有最优秀的性能。特别是在 ImagNet-1k 数据集上,较浅 DPN 的性能超越了 ResNeXt-101(64x4d),并且模型大小还要小 26%、计算成本少 25%、内存消耗少 8%。而更深层的 DPN(DPN-131)在令单模型性能达到最优的情况下训练速度还要比残差网络快三倍。DPN 在 Places365 大规模场景数据集、PASCAL VOC 检测数据集和 PASCAL VOC 分割数据集上,它相对于 DenseNet、ResNet 和最新的 ResNeXt 都表现出更好的性能。

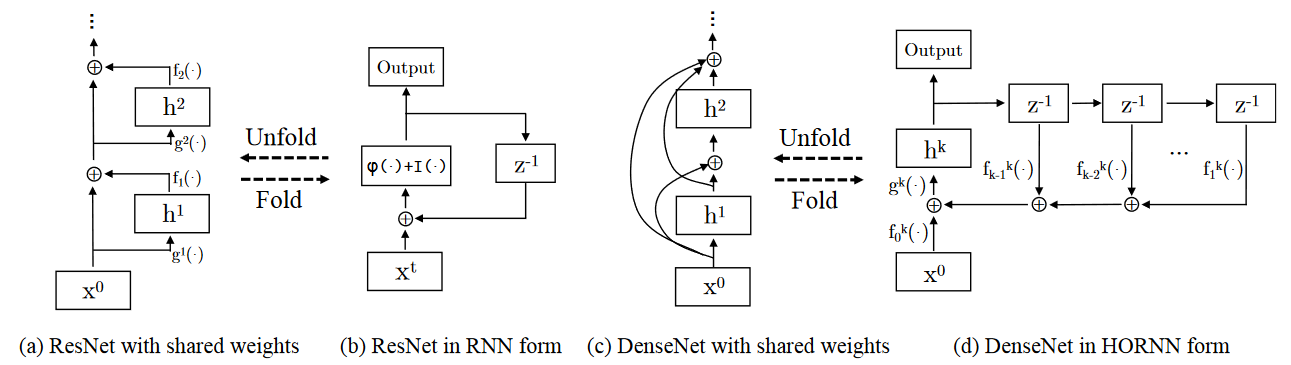

在本项工作中,我们旨在从高阶 RNN 的角度更深入地理解密集连接型网络,并解释为什么残差网络是密集连接型网络中的一个特例。因此基于这些分析,我们希望提出一种双路径网络架构,它不仅能实现极高的精度,同时还必须拥有极高的参数效率和计算效率。下图展示了不同类型神经网络的拓扑结构。

图 1:不同类型神经网络之间的拓扑关系。(a) 和 (b) 展示残差网络和 RNN 之间的关系,(c) 和 (d) 展示了 DesNet 和高阶循环神经网络间的关系。其中「z^(-1)」表示一个时间延迟单元,「⊕」表示元素级的和,而「I(·)」表示恒等映射函数。

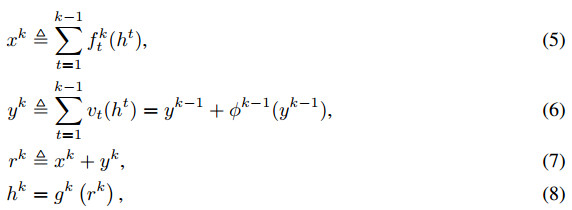

双路径架构

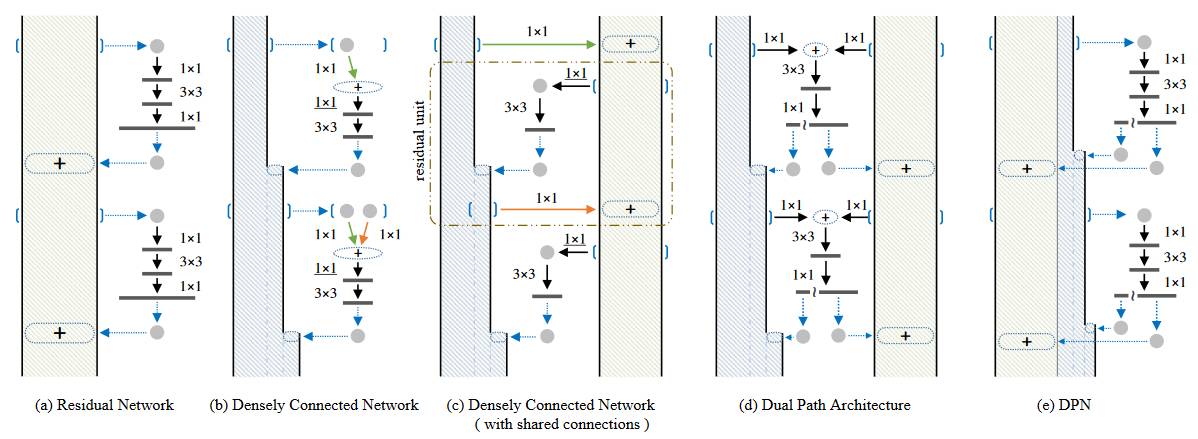

我们提出了一种简单的双路径架构,该架构在所有模块中共享 f_t^k (·) 函数以在少量冗余下可重复利用公共特征,同时该架构保留了密集的连接路径以令神经网络足够灵活而能学习新的特征。我们可以形式化这样的双路径架构为:

其中 x^k 和 y^k 表示在第 k 步从独立路径中所提取的信息。vt(·) 作为 f_t^k(·) 是特征学习函数。

广义上,我们提出的 DPN 是一簇卷积神经网络,其包括类似残差的路径和类似密集连接的路径。和这些网络相同,我们可以定制 DPN 微块的功能(micro-block function)以用于特定的任务或提升整体性能。

图 2:不同网络的结构对比。

(a)残差网络;(b)密集连接网络,每一层都可以获取所有先前微模块的输出。这里,添加 1×1 卷积层是为了与(a)中的微模块设计保持一致性;(c)通过共享(b)中层间的相同输出的首个 1×1 连接,密集连接网简并

成一个残差网络,(c)中用虚线圈起的长方形标出了残差单元的位置;(d)本篇所提出的双路径结构——dual path architecture——DPN。(e)实现过程中(d)的等价形式,「~」表示一个分支操作(split operation),「+」表示元素级(element-wise)的相加。

双路径网络

本篇提出的网络是通过堆叠多个模块化的微模块创建的,如图 2 所示。在此网络结构中,每一个微模块的结构都是以瓶颈(bottleneck)的方式来设计的,首先是一个 1×1 的卷积层,然后连接一个 3×3 的卷积层,并且以一个 1×1 的卷积层来结束。前一个 1×1 卷积层的输出被分成两个部分:第一部分是以元素方式添加到残差路径,第二部分与密集型连接通路相连接。为了提高每一个微模块的倾斜容量(leaning capacity),我们像 ResNeXt 一样,在第二层使用了组合卷积层(grouped convolution layer)。

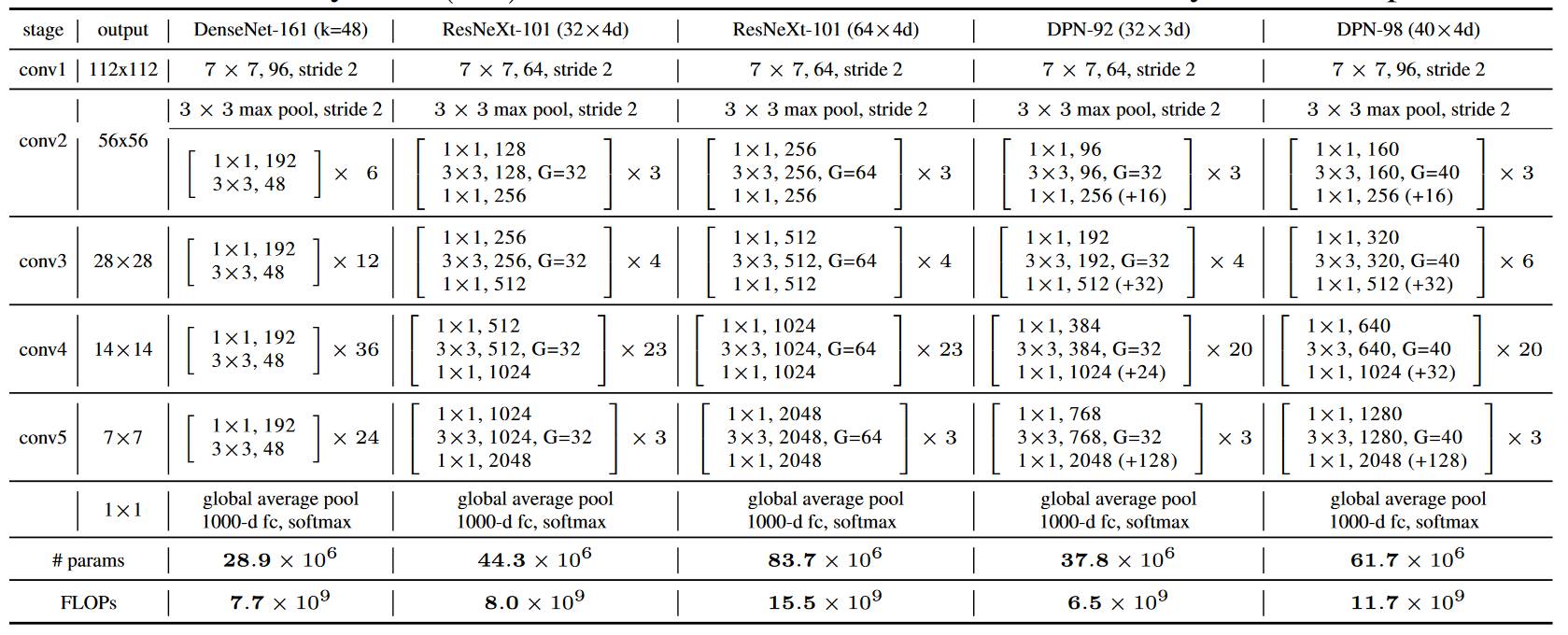

考虑到在实际应用当中,残差网络比密集型连接网络应用得更加广泛,我们选择了残差网络作为主干,而且填加了一条细薄的密集型连接路径以建造双路径网络。这样的设计有助于减缓密集型连接通路的宽度增量和 GPU 的内存消耗。表 1 呈现了详细的结构设置。在表中,G 代表组数,k 代表密集型连接通路的通道增量。对于新提出的 DPNs,我们使用(+k)来指明密集型连接通路的宽度增量。

表格 1:双路径结构(DPNs)和其它最新型网络的结构和复杂度对比情况。我们用两种基准方法对 DPNs 进行了比较:DenseNet 和 ResNeXt。标志(+k)表示密集连接路径(densely connected path)上的宽度增量。

实验部分

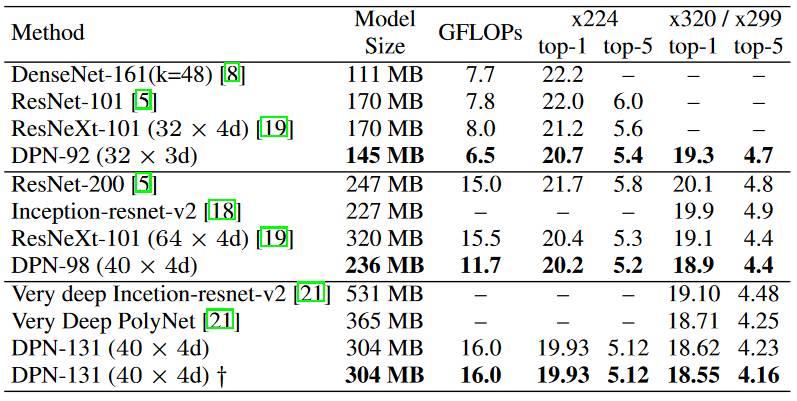

表 2 : 在 ImageNet-1k 数据集上与最优秀 CNN 的对比情况。验证集中的单一因素验证误差率(%)。

表 3:在 Places365 标准数据集上与最优秀 CNN 的对比。

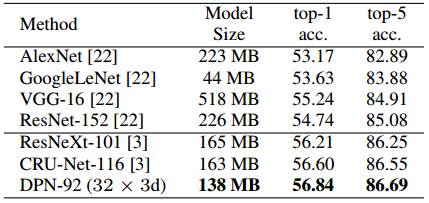

图 3:不同模型训练期间实际成本比较

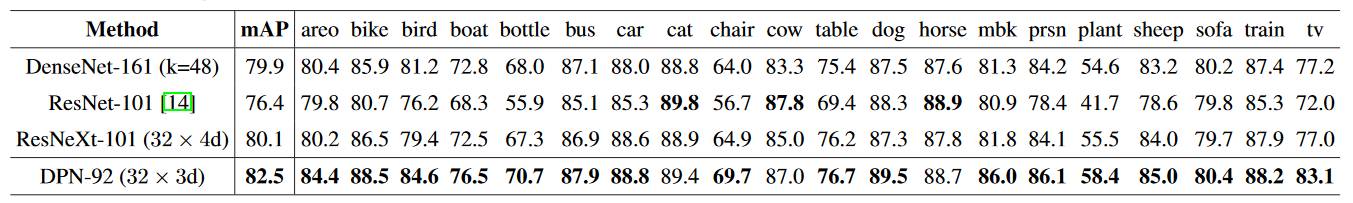

表 4:PASCAL VOC 2007 测试数据集中的物体检测结果。性能表现通过平均精度来衡量(mAP,%)。

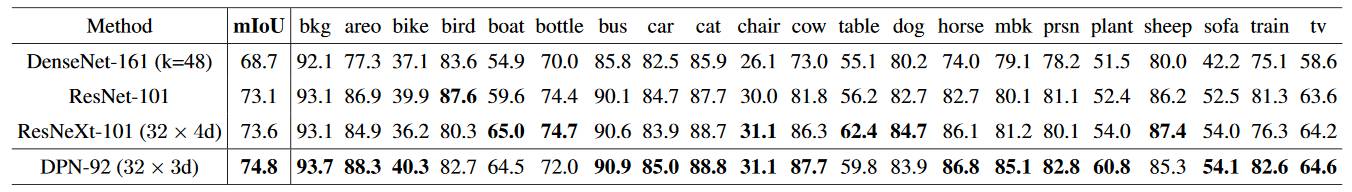

表 5:PASCAL VOC 2012 测试数据集中的语义分割结果。性能表现由 mIoU(%)来衡量。

本篇论文中,我们回顾了密集连接型网络(densely connected networks),在密集连接型网络和高阶循环神经网络(Higher Order RNNs)间架起了桥梁,并且证明了残差网络本质上是一个带有共享型连接(shared connections)的密集连接型网络。在此种新型解释的基础上,我们提出了一种双路径结构,可以从双边获益。随后,基于此双路径结构,这个新型网络 DPN 又被进一步研发。图像分类任务的相关实验说明了 DPN 有着高精度,小模型规格,低计算成本和低 GPU 内存消耗,这使得 DPN 在科研工作和实际应用当中都极为有用。物体检测任务和语义分割任务的相关实验说明了 DPN 通过简单地对基础网络进行替换,也能对其它任务有所裨益。