雷锋网将联合英伟达 DLI

,面向 AI 技术从业者,特别推出

深度学习课程

,

对深度学习和英伟达 GPU 加速技术感兴趣的朋友可以参阅

文末介绍

!

雷峰网按:

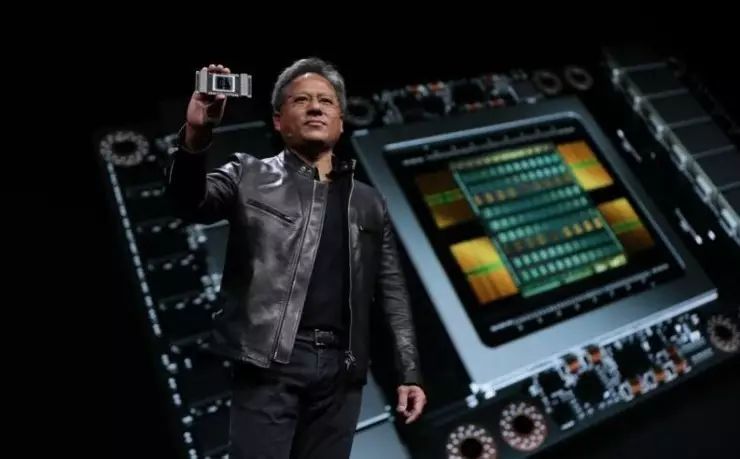

上周,英伟达在加州举行了 2017 年的 GPU 技术大会(GTC2017)。在大会上,英伟达 CEO 黄仁勋发布了全新力作——NVIDIA Tesla V100。根据英伟达官方介绍,Tesla V100 采用了全新架构 Volta,不仅会有更强的性能,还增加了 TensorCore 用以专门针对深度学习。在发布会后,英伟达的股价也随之走高。那么英伟达能凭借 Tesla V100 强悍的性能在深度学习领域力压群雄吗?

Tesla V100 的优点和存在的不足

根据英伟达官方介绍,Tesla V100 采用台积电 12nm FinFET 制造工艺,供集成了 210 亿个晶体管,芯片面积达 815 平方毫米。英伟达为了针对深度学习,专门进行了优化,经过优化的设计比前代 Pascal 架构能效高 50%。而且新的 Tensor Core 是专门为深度学习设计的,为浮点运算速度带来了 12 倍的提升——Tesla V100 增加了 Tensor Core,Tensor 单元本质上是把运算器做得更密集,以这种方式获取更强性能。此外,Tesla V100 还拥有更大的带宽和更低的延迟,半精度浮点乘混合单精度浮点加法也非常适合深度学习训练。

简而言之,就是运算器堆的更多,矩阵乘法运算能力更强,性能得道大幅提升,Tesla V100 双精浮点运算性能高达 7.5TFlops,相比之下,Intel 用于深度学习的 KnightsMill 双精浮点性能为 3TFlops。

由于人工智能的迅速发展,诸多企业对与高性能深度学习处理器的需求也与日俱增:

微软的 ResNet 的深度学习项目需要每秒 7 百亿亿次浮点运算的处理能力;

百度 2016 年打造的 DeepSpeech2AI 需要每秒 20 百亿亿次浮点运算的处理能力;

谷歌 2017 年打造的 NMT 则需要每秒 105 百亿亿次浮点运算的处理能力;

......

因此,英伟达的 Tesla V100 作为数据中心 GPU 是非常具有潜力的,不仅可以满足训练的需求,还可以放在后台提供相关服务。

虽然 Tesla V100 在性能上无与伦比,而且在一些领域颇具市场潜力,但还是存在不少缺点的。比如芯片面积过大——高达 815 平方毫米,而过大的芯片面积,加上英伟达在该款芯片上巨额的研发投入(黄仁勋称英伟达花了 30 亿美元打造这款芯片),直接导致 Tesla V100 的价格异常昂贵,售价高达 14.9 万美元。如此高的售价会让很多用户望而却步。

就产品定位来说,Tesla V100 性能超强,拿来类比的话是一台超级计算机,而在很多场景下,其实用不到性能这么强,价格如此昂贵的产品。对于普罗大众和大多数应用场景来说,性能够用、功耗低且廉价的产品才是最好的选择,就像普通消费者需要的是智能手机和 PC,而不是超级计算机。比如将来智能手机里如果要集成针对深度学习的模块,英伟达的产品显然是不合适的。在这种场景下,开发专门针对嵌入式平台的处理器 IP 更加符合市场需求。

英伟达的 Tesla V100 的市场定位类似于核弹,但真正需要核弹的场景其实相对不多,而且客户也只能是谷歌、微软、百度这些国际巨头。正如核弹仅被少数国家掌握,而且在国际冲突和局部战争中鲜有使用,AK47 和 RPG 是才是被最广泛使用的武器类似,英伟达的这种市场定位,会使其失去非常广阔的嵌入式设备市场。

最后就是功耗的问题,英伟达的终端低功耗做得不够好。必须说明的是,台积电的 12nm 工艺其实是 16nm 工艺的改良版本,是针对三星玩 14nm 命名游戏的反击。因此,台积电的 12nm 工艺到底对功耗控制有多大实际效果还是等产品上市后才能见分晓了。

深度学习处理器将进入战国时代

自 AlphaGo 与韩国棋手李世石大战之后,深度学习、人工智能这些概念立马火了,不仅成为资本的宠儿,各色各样的深度学习处理器纷纷涌现出来,各家 IC 设计公司推出了各自 CPU、GPU、FPGA、DSP、ASIC 等方案。

就 CPU 来说,最典型的就是 Intel 的 Xeon Phi。Intel 的众核芯片双精浮点性能为 3 TFlops,性能功耗比为 12 GFlops/W。虽然 Intel 宣称:“四片 Knights Landing Xeon Phi 芯片比四片 GPU 要快 2.3 倍”、“使用 Intel 优化版的 Caffe 深度学习框架时,Xeon Phi 芯片要比标准 Caffe 实现快 30 倍”。但目前来说,还是英伟达的 GPU 更胜一筹。除了 Intel 之外,中国自主设计的申威 26010 也是一个潜在的选手,在人工智能领域也有应用的潜力,百度还为此与申威有过接触。

在 DSP 上,国内外还有不少单位或公司也选择用传统 SIMD/DSP 架构适配神经网络。比如中星微的星光智能一号、CEVA 公司的 XM4 处理器、Cadence 公司的 Tensilica Vision P5 处理器、Synopsys 公司的 EV 处理器等。这些处理器本质上都是将传统的面向数字信号处理的 DSP 处理器架构用于处理神经网络,主要在运算器方面作了相应修改,例如低位宽和超越函数。这种做法的优势在于可以充分利用现有的成熟技术,但缺点也很明显,就是在应用领域上有一定局限性。大多用于卷积神经网(CNN),而对循环神经网络(RNN)和长短期记忆网络(LSTM)等处理语音和自然语言的网络则无能为力。换言之,就是这种 DSP 主要用于机器视觉领域,可能难以应用到语音识别、文本处理和自然语言理解等领域。虽然采用 DSP 作为人工智能硬件存在一定不足。不过,采用现有比较成熟技术应用于人工智能细分市场的做法在商业上还是有一定潜力的。

在 FPGA 上,阿尔特拉推出的用于人工智能的 FPGA,双精浮点性能为 1.5TFlops,虽然双精浮点性能只有 Xeon Phi 众核芯片的一半,但性能功耗比却高达 50GFlops/W,如果人工智能硬件选择 FPGA,那么不仅对 Xeon Phi 众核芯片在性能功耗比上有明显优势,对英伟达的 GPGPU 也占据优势地位。而更高的性能功耗比就意味着在运营和维护中能够节省电费。FPGA 虽然会在新兴领域取得一定成绩,但却缺乏性价比的问题,而且在新兴领域发展壮大后容易被专用芯片所取代。不过,就目前来说,FPGA 也是深度学习处理器的一个选择。

在 ASIC 方面,中国中科院计算所孵化好市场化的寒武纪公司寒武纪开发出了一系列产品,在芯片面积控制和性能功耗比上具有非常出色的表现。而在学术成果斐然:在 2014 年—2016 年横扫体系结构学术圈,Diannao(电脑)是 ASPLOS'14 最佳论文(亚洲第一次);DaDiannao(大电脑)是 MICRO'14 最佳论文(美国以外国家的第一次);PuDiannao(普电脑)、ShiDiannao(视电脑)、还有指令集 Cambricon 等后继工作都连中 ASPLOS、ISCA。不过,ASIC 也存在开发周期比较长的遗憾,这对寒武纪在人工智能芯片的短期商业竞争中非常不利,特别是在中国半导体工业原本就落后于西方的情况下。

最后要说的是谷歌的 TPU,谷歌 TPU 其实是传统脉动阵列机的结构,MIT 于 2016 年前后发表的 Eyeriss 也是类似的架构,必须指出的是,脉动阵列架构是非常老的技术,同时也是非常经典的技术。早在上世纪 80 年代初,中科院计算所的夏培肃院士和李国杰院士就曾将脉动阵列架构用于石油勘探——计算所曾经研发过的石油勘探专用机就是采用了脉动阵列架构。

从实际运行性能表现上看,TPU 虽然可能在面对退化情形的卷积上也会遇到困难,但做卷积神经网路(CNN)时总体效果还是不错,但做其他类型的神经网络运算,可能效率不是那么高,通用性不是那么的好。例如在语音识别和自然语言理解中常用的长短期记忆网络(LSTM)上面,TPU 只有 4% 左右的效率。

总而言之,就深度学习处理器而言,已然进入战国时代,而且各家的产品都有可能在这个广阔的市场中找到自己的定位和细分市场,在这种情形下,英伟达想凭借 Tesla V100 一统江山显然是不切合实际的。在战国时代,相对于技术上的片面追求极致性能,而忽视成本、功耗、价格,如何开拓更多细分市场,更好的商业化才是在大争之世的当务之急。

附:英伟达CEO黄仁勋现场主题演讲

「

55页完整PPT

」

,在雷锋网微信后台回复

「0511」

立即获得。

在即将开幕的第二届 CCF-GAIR 2017 全球人工智能与机器人峰会上,雷锋网将联合英伟达 DLI ,面向 AI 技术从业者,特别推出一个深度学习开发者专场。对深度学习和英伟达 GPU 加速技术感兴趣的朋友,可以通过这次专场对英伟达 DLI 课程来一个现场体验。

专场的具体议程安排如下

----------------------------------------

NVIDIA DLI Course 英伟达深度学习课程

9:00-10:00

Deep Learning Demystified 揭秘深度学习 (lecture 讲演)

10:00-10:10

Break

10:10-12:00

Getting Started with Deep Learning 深度学习入门 (Lecture with lab 讲演与实验)

13:30- 15:30

Approaches to Object Detection 目标检测的方法 (Lecture with lab 讲演与实验)

15:30-15:40

Break

15:40- 17:40

Image Segmentation Using Deep Learning 使用深度学习进行图像分割 (Lecture with lab 讲演与实验)

17:40- 18:00

Closing Comments & Questions 互动答疑 / 结束

目前,开发者专场门票已经开始火热预售,只需 1999 元即可获得与英伟达官方深度学习团队现场交流的机会,数量有限,售完即止!(

详情点击

)