10 月 12 日,2017 杭州·云栖大会主会场上,周以真教授发表了题为“数据的好处——可怕的人工智能以及大数据带来的其它威胁”的演讲。本文整理自现场演讲速记。

更多精彩文章请添加微信“AI 前线”(ID:ai-front)

周以真(英文名 Jeannette M.Wing)

,美国计算机科学家,卡内基梅隆大学教授,美国国家自然基金会计算与信息科学工程部助理部长,ACM 和 IEEE 会士。她的主要研究领域是形式化方法、可信计算、分布式系统、编程语言等。

-

1993 年她与图灵奖得主芭芭拉·利斯科夫合作,提出了著名的 Liskov 代换原则,是面向对象基本原则之一。

-

1979 年 6 月在麻省理工学院获得学士和硕士学位,导师中有图灵奖得主 Ronald Rivest。1983 年获得该校的博士学位。

-

1983-1985 年,在南加州大学任助理教授。1985 年起,任教于卡内基梅隆大学。2004-2007 年间,曾担任该校计算机系主任。

-

2006 年 3 月,在美国计算机权威期刊《Communications of the ACM》杂志上给出,并定义的计算思维(Computational Thinking)。 认为:计算思维是运用计算机科学的基础概念进行问题求解、系统设计、以及人类行为理解等涵盖计算机科学之广度的一系列思维活动。

周以真教授曾担任卡内基—梅隆大学计算机学院院长、美国国家科学院计算机科学与通讯部门主席、美国国防部高级研究计划署(DARPA)信息科学与技术委员会、美国国家科学基金科学顾问委员会以及 Sloan 研究基金程序委员会的成员。2007 年她出任美国国家科学基金会(NSF)计算机与信息科学与工程部(CISE)副部长,负责管理 NSF 在信息科学和计算机研究领域的基金。CISE 每年的预算高达 5.27 亿美元,占整个美国联邦政府对计算机科学研究资助经费的 86%。

卡内基梅隆大学的校长 Jared L Cohon 评价说:“周以真是当今世界上最有创新精神、最具原创力的计算机科学家之一。她在科研、教学和行政上均作出了重大贡献。NSF 不可能找到一个比周以真更好的人选。”微软同样认为周以真的工作经验和文凭“无可挑剔”。

以下是周以真教授在本次 2017 阿里云栖大会上的演讲完整内容。

非常感谢,非常荣幸能够来到这里,感谢阿里巴巴集团邀请我来到这里,在云栖大会上进行发言,大家刚才听到了很多关于大数据的话题,我要谈一谈数据的好处,但是我的讲话副标题是

“可怕的人工智能以及大数据带来的其它威胁”

。

首先我想来看一下,数据能够带来一些什么样的好处,数据的好处,我这里要分两方面来说。

但是今天我只是会去谈有责任地使用数据这一个方面,因为我们所有人都是在使用数据,我们使用数据的目的都是为了应对社会的挑战。我演讲的目的,是给大家敲一个警钟,我们在使用数据过程当中不负责任的话,会有什么样的后果。

在这里面我想用 FATES(命运)这个比喻的缩写来去讲一下怎么有责任的使用,

F 是代表公平,A 是可靠,T 是透明,E 是有道德,S 是代表安全

。

实际上这个 FATES 是我和我的朋友共同想出来的缩写的词语,我和我的朋友分别贡献了 FATES 当中的几个字母。

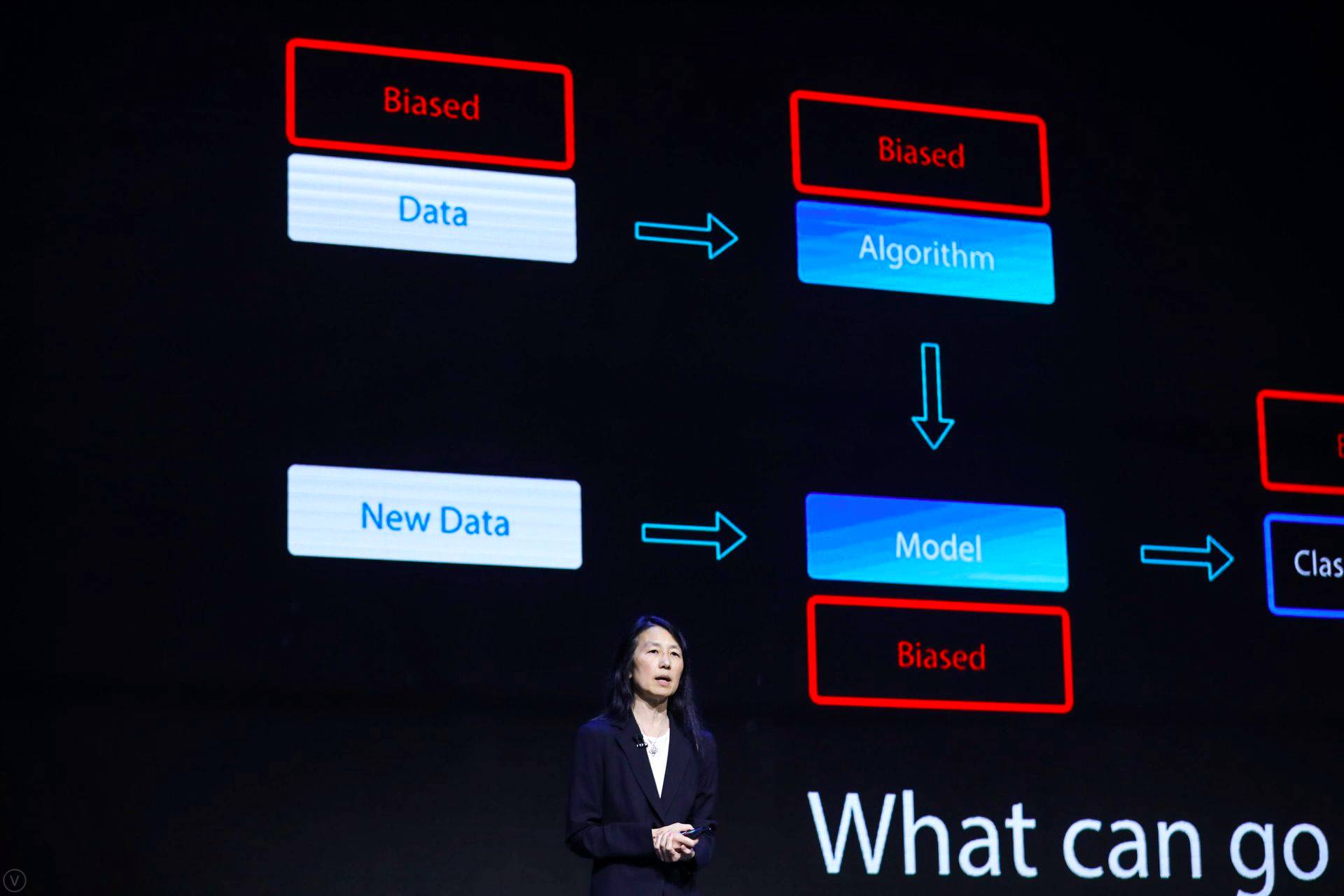

首先来看一下数据,我在给大家分享之前,先非常简单的讲一下典型的算法和模式,我们在用大数据作为原料,进行大数据计算的时候,涉及到的一些算法和模型。我们知道机器学习会形成一种模型,有这个模型,我可以再输入新的数据,这个新的数据,经过这个模型之后,有可能产生新的结果,之后我们可以来判断和预计,这个用户有可能采购哪些商品。

那么我们知道数据和算法都可能是有偏见的,那么如果数据和算法是有偏见的话,那么我们的这个模型可能也会有偏见,那么我们的结果也会有偏见的。让我们来看一个实例,那么这是几年前我们看到两个小偷,在美国的法官用了这种算法来决定判断量刑过程当中是否恰当,我们看到这些自主研发的算法,在法官当中广为流行的算法,用于帮助法官去判断这些量刑。

我发现他们对于黑人和白人量刑的结果是不同的,那么当然了,大家觉得这是不公平的,其实结果还不仅仅于此,我们在算法当中有一些什么样的问题,这个算法本身是有偏见的,而且哈佛大学学者研究出来,这些算法有可能是可以判断的,又可能是错误的,但不可能两者兼具,实际上是不可能去判断这个风险的分数。

第二个例子,这是我的这些同事做的项目,我的这些同事研究了在 Google 上的广告,他们发现这些高薪的工作机会更多的会向男性网民展现,女性网民看到这些高薪的招聘广告机会会比较少,我们觉得这是不公平的。现在我们就要去思考,这个模型是否是公正的,这些分类是否是公正的,我们怎么样来确保,这个案例引发了另外一个问题,那就是

可靠性

。

说到底,出现问题的时候,我们应该怪谁呢,对于充满偏见的结果,这是 Google 的错吗,这是算法的错吗,这是广告商的错吗,或者说还是整个生态系统的错误,我们应该怪谁呢。好像这个问题很难找出一个好的答案,但是我们要有担当,

我们在 IT 界,我们是发明这些算法的人,我们是使用数据的人,我们是产生和收集这些数据的人,并且生成这些结果的人,我们要有担当

。

如果你是一家企业,那么如果你是一个有责任的企业,你应该做什么,你首先可以把政策进行公布,你的隐私政策进行公布,而且你要遵守这些政策,如果有人违规的话,违反了这个政策,你就要去修补你的这个漏洞。

我和的同事在微软研究院所做的,我们会看一下在人们遵守这个公共政策的规模和程度是如何,这涉及到我们编程的语言,我们做成数据地图,这个数据地图每天晚上在微软运行,帮我们找到我们政策上的漏洞,所以自动化可以在这方面帮助我们,让我们负起责任来,让我们对于我们发布的政策负起责任来。

第三个关键词是

透明度

,透明度现在是一个很大的问题,特别是我们涉及到这些深层的神经网络的时候,我们是否应该对这个结果予以信任,我们为什么要对这个结果予以信任呢,我们都不知道怎么样来运作的,从这个科学的角度来说,我们其实并不了解他们是如何来工作的,那这样的话,就会引起一些问题。所以在给大家举例子之前,首先给大家介绍一下,我们最大的 DNN,这是 152 层的 DNN,那么它是获得了 2015 年的 ImageNet 的竞赛奖项,这里面我们可以看到这里的 DNN 一共有 152 层,大家问为什么要 152 层,事实上我们不知道为什么是 152 层,结果就是如此,对于科学家来讲,我们不仅仅满足于这个答案,我们看这个 DNN 在什么情况下会出错。

左边这张图片是 57.7 的信度,这个我们相信是熊猫,然后把噪音信号进行混合,我们可以看到右边的这个熊猫的图案,这个信度是比之前更高,我们知道这是一个猴子,猴子跟熊猫合成之后,第三张合成的图片的信度更高了。

这个例子看出来,我们为什么使用这个 DNN、做图象识别的时候要小心,这是一段视频。在这个视频当中,我们可以看到,我们在驾驶车辆,我们开车的时候,可以看到有一个车速限速度的标志,在右侧可以看到,在右边是停止的 Stop 的牌子,在左边是涂鸦的限速 45 英里的牌子,这个 DNN 识别到在右侧 Stop 的图像。它认为有了这个涂鸦的限速牌,不认为这是一个限速牌,在开车不到一秒的时间里面,我们可以看到后面驾驶的车辆,开得很近的时候,发现涂鸦的这个标牌也是 Stop 的标牌,但是看见的时候已经太迟了,他觉得这个时候要刹车已经来不及了,这时候就有可能发生撞车的事故。

现在不光是熊猫、猴子,还有刚才我们所提的这样一些例子,这个就是大家可以看到的,这里面就会潜在地造成一些威胁。如果我们对于这个 DNN 怎样工作的原理不清楚的话,这里面我们再来看一个例子。我们可以看到奥巴马在同样一个音轨,同样的话,用四种语音语段发出来,这是一个 Youtube 上面比较好玩的事情。这样一来,大家看到就越界了,对于这样一个音频流,你可以知道任何人都可以模拟任何人的发音,这样就会产生威胁。

这不单会产生技术问题,也不是写写论文的问题,应该说这是一个实实在在的,对于大公司,比方说像阿里巴巴这样的大公司,正在努力致力于研究解决的这样一些问题。这里面欧盟也有这样的政策,2018 年所有大的公司,都要遵守这样的一个有关于数据方面的问题的法规章程,不然的话,你就会被罚款或者说有 4% 这样的营业收入就要来交营业罚款,这就是有

四个标准,一个是可访问的权利,一个是可忘却的权利,一个是数据的可携带性,还有可解释的权利

,2017 年到 2018 年之间,科学家正在致力于了解深度学习到底是怎么样来进行工作的,要能够解释得清,这里面是一个伦理的问题。

这里面我们可以看到,这里是一个列车的问题,我们可以看到这里面一辆列车开过来,扳这里有一个选择,到底是通过扳道,是往上面的通道走还是往下面的通道走,下面可能是小孩子或者说肥胖的人,不管是把道路往哪个方向搬,这都会牵涉到伦理方面的难题。那么现在有了我们这个自动驾驶车,必须要做这样的决定,比方说在碰到类似情况的时候,这个车应该做什么样的决断。比方说在右边有一个行人,但是这个人比方说在人行道上面也有其他的人,这个车躲避的话,到底是躲避谁,撞上什么,这是很难下的决定。

这里面是一个假新闻的问题,假新闻现在也在美国到处肆虐,这里应该说假新闻泛滥,造成了很多的问题。微软有这样一个例子,一个聊天机器人叫做小冰,这个聊天机器人是如此的流行,以至于在美国,我们有一点嫉妒,你们中国有这样的很好的聊天机器人,在美国还没有这么好的聊天机器人,于是去年微软也有了这么一个聊天机器人。

我们在 24 小时之内,不得不把这个聊天机器人关闭了,为什么呢?因为我们看到由于互联网之间有一些阴暗面的存在,很快我们发现聊天机器人被诱导,引导说一些很不好听的话题,这里面我们才认识到互联网,这里面也有一些快速传播的不良信息,

我们要非常重视伦理道德,我们在设计的时候就要注意,而不是在运用的时候

。