文 | 王启隆

出品丨AI 科技大本营(ID:rgznai100)

近日,27 岁天才创始人

Joel Hellermark

分享了自己和“AI 教父”

Geoffery Hinton

的最新采访。Hinton 在对话中回忆自己的人工智能生涯,谈论

神经网络、Scaling Law、多模态学习、模拟计算和人工智能伦理安全

等多个话题,并聊了聊他的得意门生

Ilya Sutskever

(

前段时间离职的 OpenAI 首席科学家

)。

Geoffery Hinton

受访者非常“重量级”,但采访者其实也不容小觑。Joel Hellermark 自幼在东京长大,13 岁开始编码,14 岁创立了一家视频推荐公司。在一家数字广告公司工作后,他于 19 岁创办了

人工智能研究实验室

Sana(当时还不叫 Sana AI,而是叫 Sana Labs),并在 2023 年的时候筹齐 8000 万美元融资。

Hellermark

坚信学习的力量,所以他没有选择上大学

,而是通过斯坦福公开的课程学习如何编码

。他创办 Sana 公司的目标就是四个字:“改变教育”。Hellermark 希望通过培养员工学习和访问信息的能力,来提高员工的工作效率。

Hellermark:

你是什么时候开始编程的?

Hellermark:

你是什么时候开始编程的?

Hinton:

我从英国刚到卡内基梅隆大学的时候。

Hinton:

我从英国刚到卡内基梅隆大学的时候。

1982

年

直至

1987

年

我在英国的研究单位时,每晚六点钟大家都会去酒吧喝一杯。

但到了

卡内基梅隆

几周后,我还没交到多少朋友。所以在

某个周六晚上,我发现自己

不知道该做什么,于是决定去实验室编写一些程序:因为实验室里有一台

Lisp 机器

,家里没有。

所以,我在那个周六晚上的九点左右前往卡内基梅隆的实验室,里面人声鼎沸,所有学生都在那里研究未来,他们相信自己接下来要做的事情将会改变计算机科学的进程。这与我在英国看到的情况截然不同,令我耳目一新。

Hellermark

:

能不能把我们带回一切的起点 —— 剑桥时期的 Geoffrey(

~

1970 年

),试图理解人脑。脑研究是什么样的体验?

Hellermark

:

能不能把我们带回一切的起点 —— 剑桥时期的 Geoffrey(

~

1970 年

),试图理解人脑。脑研究是什么样的体验?

Hinton

:

非常令人失望

。我为了研究大脑,先是去学习

生理学

。在夏季学期,(

剑桥的

)老师打算教我们大脑是如何工作的,但实际上他们只教了我们神经元如何传导动作电位……这非常有趣,但不是大脑工作的原理。所以,那堂课真是令人极度失望。

Hinton

:

非常令人失望

。我为了研究大脑,先是去学习

生理学

。在夏季学期,(

剑桥的

)老师打算教我们大脑是如何工作的,但实际上他们只教了我们神经元如何传导动作电位……这非常有趣,但不是大脑工作的原理。所以,那堂课真是令人极度失望。

于是我又转向了

哲学

,因为我以为他们会告诉我心灵是如何运作的。结果也是非常令人失望。最终,我选择到爱丁堡学习

人工智能

。人工智能倒是更有趣一些,至少我可以模拟事物,从而测试理论。

Hellermark

:

你还记得是什么激起了你对人工智能的兴趣吗?是一篇论文吗?还是某位特定的人向你介绍了这些想法?

Hellermark

:

你还记得是什么激起了你对人工智能的兴趣吗?是一篇论文吗?还是某位特定的人向你介绍了这些想法?

Hinton

:

我想是因为

唐纳德·赫布(

Donald Hebb

)

的一本书,它对我影响很大。里面介绍了如何学习神经网络中的连接强度。

Hinton

:

我想是因为

唐纳德·赫布(

Donald Hebb

)

的一本书,它对我影响很大。里面介绍了如何学习神经网络中的连接强度。

Donald Hebb

曾在《

行为的组织

》一书中

早期我还读过

约翰·冯·诺伊曼(

John von Neumann

)

的一本书(

《计算机与人脑》

),书里介绍了大脑的计算方式以及大脑计算与普通计算机的区别。

Hellermark

:

当时你是否确信书里的这些学说?你的直觉是什么?

Hellermark

:

当时你是否确信书里的这些学说?你的直觉是什么?

Hinton

:

我当时的想法是,大脑学习肯定有其独特的方式。显然,大脑不是通过预设各种程序,再运用逻辑推理规则 —— 从一开始我就觉得这种方法很荒谬。所以我们必须弄清楚大脑是如何

在神经网络中调整连接以完成复杂任务

的。冯·诺依曼和

图灵(

Alan Turing

)

都相信这一点,他们二人在逻辑方面都很出色,且他们并不认同这种逻辑方法。

Hinton

:

我当时的想法是,大脑学习肯定有其独特的方式。显然,大脑不是通过预设各种程序,再运用逻辑推理规则 —— 从一开始我就觉得这种方法很荒谬。所以我们必须弄清楚大脑是如何

在神经网络中调整连接以完成复杂任务

的。冯·诺依曼和

图灵(

Alan Turing

)

都相信这一点,他们二人在逻辑方面都很出色,且他们并不认同这种逻辑方法。

Hellermark

:

你是如何平衡「

研究神经科学

」和「

开发 AI 算法

」的?你早期从神经科学研究中获得了多少灵感?

Hellermark

:

你是如何平衡「

研究神经科学

」和「

开发 AI 算法

」的?你早期从神经科学研究中获得了多少灵感?

Hinton

:

其实

我并没有深入研究过神经科学,我只是常被大脑工作原理的相关知识所启发

。大脑中有大量的神经元,它们执行“

相对简单

”的操作 —— 通过神经元接收输入、进行加权处理并产生输出,以及通过调整权重来优化整体功能 —— 在概念上,这些操作听起来很简单,但实际上并非如此,

问题在于如何调整这些权重以使整个系统实现有益的功能

。

Hinton

:

其实

我并没有深入研究过神经科学,我只是常被大脑工作原理的相关知识所启发

。大脑中有大量的神经元,它们执行“

相对简单

”的操作 —— 通过神经元接收输入、进行加权处理并产生输出,以及通过调整权重来优化整体功能 —— 在概念上,这些操作听起来很简单,但实际上并非如此,

问题在于如何调整这些权重以使整个系统实现有益的功能

。

Hellermark

:

你还记得以前经历过的合作吗?

Hellermark

:

你还记得以前经历过的合作吗?

Hinton

:

我在卡内基梅隆大学时曾与

泰伦斯·塞诺夫斯基(

Terry Sinofsky

)

有过许多交流,他当时在巴尔的摩(

Baltimore

)的约翰霍普金斯大学(

Johns Hopkins

)。

Hinton

:

我在卡内基梅隆大学时曾与

泰伦斯·塞诺夫斯基(

Terry Sinofsky

)

有过许多交流,他当时在巴尔的摩(

Baltimore

)的约翰霍普金斯大学(

Johns Hopkins

)。

我们每个月定期联络,要么他开车来匹兹堡,要么我开车去巴尔的摩。两地相距 250 英里(

相当于从北京到石家庄的距离

)。我们会一起度过一个周末,共同研究

玻尔兹曼机

(

Boltzmann Machines,由玻尔兹曼分布得名

)

。

那是我做过的最令人兴奋的研究

,并且产生了很多非常有趣的技术成果,我们曾一度以为那就是大脑的工作方式。

Hinton

和

Sinofsky

发明了

玻尔兹曼机

这是随机神经网络和循环神经网络的一种

我还与

彼得·布朗(

Peter Brown

)

有过一次非常好的交流,他是一位非常优秀的统计学家,在 IBM 从事语音识别工作。后来他作为一个更成熟的学生来到卡内基梅隆大学攻读博士学位(

编者注:实际上,Hinton 是 Brown 的博导

)。

Brown 教会我许多关于语音的知识,甚至还帮助我弄懂了

隐马尔可夫模型

(

Hidden Markov Model, HMMs

)。

我认为我从他那里学到的比他学到的多,而这就是我想要的那种学生

。

当时我正在着手于带有类似结构的网络进行

反向传播

(

backpropagation

)研究,但尚未采用“隐藏层”这一明确命名。Brown 让我受到了隐马尔可夫模型中“隐藏”状态概念的启发,使得我们后来共同决定采用“

隐藏层

”(

hidden layers

)一词来描述神经网络中那些

无法直接观测、却对模型学习和预测起到关键作用

的中间层。

Hellermark

:

请带我们回忆你的另一位学生 ——

Ilya Sutskever

。

Hellermark

:

请带我们回忆你的另一位学生 ——

Ilya Sutskever

。

Hinton

:

我当时在我的办公室里编程,时间可能是某一个周日。突然有人敲门 —— 不是普通的敲门声,而是有点...几乎是急促的敲门声。于是我走过去开门,门口站着一位年轻的学生。他告诉我,比起暑期炸薯条的工作,他更渴望能在我的实验室工作。所以我告诉他,“

那你为什么不预约一下,我们谈谈呢?

”

Hinton

:

我当时在我的办公室里编程,时间可能是某一个周日。突然有人敲门 —— 不是普通的敲门声,而是有点...几乎是急促的敲门声。于是我走过去开门,门口站着一位年轻的学生。他告诉我,比起暑期炸薯条的工作,他更渴望能在我的实验室工作。所以我告诉他,“

那你为什么不预约一下,我们谈谈呢?

”

Ilya 说:“

那就现在谈谈吧!

” 这正是他的性格。

所以我们聊了一会儿,我给了他一篇论文阅读,那是关于反向传播的《自然》(

Nature

)论文。我们约定一周后再见面,他回来后说:“

我没看懂。

”

我感到非常失望。我想:“

他看起来挺聪明的,但这只是链式法则而已。理解起来并不难。

”

他却说:“

哦,不,不,那个我懂。我只是不明白 —— 为什么不直接将梯度(即损失函数相对于模型参数的导数)应用于一个更合理的函数优化器呢?

” 后来,这个问题成为了我们多年研究探讨的重点。Ilya 就是这样,他对事物的

直觉

总是非常敏锐。

左一为

Ilya

,右一为

Hinton

中间则是

Alex Krizhevsky

在

ImageNet

比赛取得了冠军

Hellermark

:

你认为是什么让 Ilya 有着这样的直觉?

Hellermark

:

你认为是什么让 Ilya 有着这样的直觉?

Hinton

:

我不知道。我觉得他总是独立思考。他从小就对人工智能感兴趣,且他显然数学很好,所以...很难确切知道原因。

Hinton

:

我不知道。我觉得他总是独立思考。他从小就对人工智能感兴趣,且他显然数学很好,所以...很难确切知道原因。

Hellermark

:

你们俩是如何交流的?你们各自扮演着什么样的角色?

Hellermark

:

你们俩是如何交流的?你们各自扮演着什么样的角色?

Hinton

:

非常有趣。

Hinton

:

非常有趣。

我记得有一次我们试图用数据制作复杂的地图,其中用到了混合模型,

目标是

利用相同的相似性集合生成两张地图

。在一张地图上,「

bank(银行)

」可能靠近「

greed(贪婪)

」,而在另一张地图上,「

bank(银行)

」则可能靠近「

river(河流)

」。

由于在一张地图上,

「bank」

不能同时靠近

「greed」

和

「river」

这两个相距甚远的词语。因此,我们需要创建地图的混合体。这项工作在 MATLAB 编程环境中进行,需要大量重构代码以实现正确的矩阵乘法操作。

在这个过程中,Ilya 对反复修改代码感到厌烦。有一天他告诉我,

“

我要为 MATLAB 编写一个接口,这样我就可以用另一种语言编程,从而直接将其转换成 MATLAB 代码。

”

我告诉他:“

不行,Ilya,这会花掉你一个月的时间。我们得继续推进这个项目。别被那个分心了。

”

Ilya 却说:“

没关系,我今天早上已经搞定了。

”

Hellermark

:

哈哈,真

是令人难以置信。

在这些年里,最大的转变不仅仅是算法,还有

规模

(

scale

)。你是如何看待这些年来的数据规模增长?

Hellermark

:

哈哈,真

是令人难以置信。

在这些年里,最大的转变不仅仅是算法,还有

规模

(

scale

)。你是如何看待这些年来的数据规模增长?

Hinton

:

Ilya 很早就有了“

增加规模会有更好效果

”的直觉

。他一直主张“

只要模型做得更大,效果就会更好

”,而我起初认为这只是逃避复杂问题的一种方式,告诉他“

除了扩大规模,还需要有新的创意和想法

”。

Hinton

:

Ilya 很早就有了“

增加规模会有更好效果

”的直觉

。他一直主张“

只要模型做得更大,效果就会更好

”,而我起初认为这只是逃避复杂问题的一种方式,告诉他“

除了扩大规模,还需要有新的创意和想法

”。

事实证明,

Ilya 的观点基本上是对的,虽然新想法如 Transformer 架构确实带来了很大帮助,但真正推动进步的是数据规模的扩大和计算能力的提升

。在早期,我们未曾预料到计算机的速度会提高上亿倍 —— 我们原本预计最多只能提升百倍。因此,我们当时一直尝试通过巧妙的创新想法来解决问题,而实际上,如果当时就有如今这么大规模的数据和计算能力,许多问题可能早已迎刃而解。

大约在 2011 年,我和 Ilya 以及另一位研究生

詹姆斯·马丁(

James Martens

)

合作了一篇论文,利用维基百科(

Wikipedia

)作为数据源,尝试预测下一个 HTML 字符,结果出奇地好。我们一直对模型的表现感到惊讶:虽然我们不敢确定模型是否真的理解了内容,但从表现上看仿佛它确实理解了一样,令人难以置信。

在数届

机器学习国际会议(ICML)

上

他们师徒三人

多次合作发表论文

后来,

Martens

加入了

Google Deepmind

Hellermark

:

你在选拔人才的时候主要依靠

直觉

还是

反复的揣度

?当 Ilya

出现在你面前时,你的第一印象是“这是个聪明人,我想和他合作。” ——还是对此有更多思考?

Hellermark

:

你在选拔人才的时候主要依靠

直觉

还是

反复的揣度

?当 Ilya

出现在你面前时,你的第一印象是“这是个聪明人,我想和他合作。” ——还是对此有更多思考?

Hinton

:

有时候就是说不上来为什么。和 Ilya 交谈不久后,他给我的感觉是“

非常聪明

”。然后再和他多聊一会儿,我就发现他显然不仅非常聪明,而且直觉很好,数学也很强。所以选择他根本不需要犹豫。

Hinton

:

有时候就是说不上来为什么。和 Ilya 交谈不久后,他给我的感觉是“

非常聪明

”。然后再和他多聊一会儿,我就发现他显然不仅非常聪明,而且直觉很好,数学也很强。所以选择他根本不需要犹豫。

还有一位同样杰出的人才,那是在某次 NIPS 会议上,我们贴了一张海报,这时有人走过来开始询问关于海报的问题。他提出的每一个问题都深入洞察了我们工作的不足之处。五分钟后,我就向他提供了博士后职位。那个人就是

David Mackay

,我很遗憾他去世了(

Mackay 在 2016 年因胃癌逝世

)。

优秀的学生类型多样,有的人可能在技术创新上不那么突出,但在技术实现上极为出色;另一些人可能技术实力一般,但极其富有创造力。理想情况下,最好的人才是二者的结合体,但现实中并不总是能找到这样的人。在实验室环境下,我认为需要集合多种类型的学生,这样才能促进团队的多样性和创新能力。但我仍然相信直觉,有些人的直觉就是天生敏锐的。

Hellermark

:

所以为什么有些人的直觉更好?我们能培养这种直觉吗?

Hellermark

:

所以为什么有些人的直觉更好?我们能培养这种直觉吗?

Hinton

:

拥有更好直觉的人通常不会接受无用的信息

。盲目相信所听到的一切,会导致形成模糊且不具备辨别力的思维框架,这是无益的。相反,那些拥有清晰思维框架的人,会在接收新信息时尝试将其与自己的认知框架相匹配,如果新信息不符合框架,则会选择拒绝。

Hinton

:

拥有更好直觉的人通常不会接受无用的信息

。盲目相信所听到的一切,会导致形成模糊且不具备辨别力的思维框架,这是无益的。相反,那些拥有清晰思维框架的人,会在接收新信息时尝试将其与自己的认知框架相匹配,如果新信息不符合框架,则会选择拒绝。

我认为,

拥有一个坚定的世界观并据此筛选信息

,是培养良好直觉的关键路径。如果你的直觉已经被验证是良好的,就应该相信它们。而对于直觉不佳的人来说,无论采取何种策略,效果可能都差不多,因此他们也可以选择相信自己的直觉。

Scaling Law:GPT-4 的创造力甚至会超过人类

Hellermark

:

可以为我们科普一下这些模型是如何训练来

预测

下一个单词(

predict the next word

)

的吗?为什么说这是一种错误的思维方式?

Hellermark

:

可以为我们科普一下这些模型是如何训练来

预测

下一个单词(

predict the next word

)

的吗?为什么说这是一种错误的思维方式?

Hinton

:

我其实并不认为这是错误的思考方式。实际上,我制作了第一个

使用嵌入和反向传播的神经网络语言模型

。数据非常简单,只运用了三元组。它将每个符号转换为嵌入,然后让这些嵌入相互作用以预测下一个符号的嵌入,并从那里预测下一个符号。然后通过整个过程的反向传播来学习这些三元组,我的研究相当于展示了它的

泛化能力

。

Hinton

:

我其实并不认为这是错误的思考方式。实际上,我制作了第一个

使用嵌入和反向传播的神经网络语言模型

。数据非常简单,只运用了三元组。它将每个符号转换为嵌入,然后让这些嵌入相互作用以预测下一个符号的嵌入,并从那里预测下一个符号。然后通过整个过程的反向传播来学习这些三元组,我的研究相当于展示了它的

泛化能力

。

大约 10 年后,

约书亚·本吉奥(

Yoshua Bengio,和 Hinton 齐名的 “人工智能三教父”

)

使用了一个非常类似的网络,并展示了它

在真实文本上的效果

。

在

麦吉尔大学

读研究生时

Bengio

读到了

Hinton

的论文

从此他坚定地走在神经网络的道路上

度过了“AI 冬天”最寒冷的时期

他和

Hinton、LeCun

共同获得了

2018 年图灵奖

然后再过了 10 年,语言学家们开始相信嵌入的概念,所以这是一个缓慢的过程。我认为

预测下一个词不仅仅是基于统计的简单预测

,比如传统自动补全那样基于词频的匹配。在现代语言模型中,为了准确预测下一个词,模型必须理解上下文,这涉及到对问题或对话内容的理解。因此,预测下一个词的行为实际上迫使模型去理解语境,这种理解方式与人类的思维方式有相似之处。

尽管外界有人质疑这些模型缺乏像人类一样的推理能力,但随着模型规模的扩大,即使没有特别设计用于推理的组件,它们也展现出了推理的能力,并且

随着规模继续增长,它们的推理能力也将随之增强

。

Hellermark

:

是什么让 AI 模型能够学习如此广泛的领域?

Hellermark

:

是什么让 AI 模型能够学习如此广泛的领域?

Hinton

:

这些大语言模型所做的,是寻找共同的结构

。通过发现共同结构,它们可以使用这种共同结构来编码事物,因为这样更高效。

Hinton

:

这些大语言模型所做的,是寻找共同的结构

。通过发现共同结构,它们可以使用这种共同结构来编码事物,因为这样更高效。

让我给你举个例子。如果你问 GPT-4,“

为什么堆肥堆像原子弹?

”

大多数人无法回答这个问题,他们从未考虑过这一点,而是会认为原子弹和堆肥堆是非常不同的东西。但 GPT-4 会告诉你:“

嗯,它们的能量规模非常不同,时间规模也非常不同。但相同的是,当堆肥堆变热时,它产生的热量更快。而当原子弹产生更多中子时,它产生的中子更快

。

”

显然,GPT-4 能从这个问题

理解并联想到

链式反应

的概念。正是利用这种理解,

将所有信息压缩到其权重中

。如果它正在这样做,那么它也将对数百种我们尚未看出类比的事物进行同样的处理,而这正是

创造力产生

的地方,源自于在表面上截然不同的事物之间看到这些类比。

因此,我认为

GPT-4 在规模扩大后,将会变得非常有创造力

。我认为那种认为“

它只是在重复所学知识的观点,只是在拼凑已经学过的文本

”的观点是完全错误的。

它的创造力甚至会超过人类

。

Hellermark

:

“人工智能不会仅仅重复我们迄今为止发展的人类知识,而且有可能实现超越”……我认为这是我们尚未完全见识到的,

我们基本上仍处于当前科学水平。你认为什么将使人工智能超越人类?

Hellermark

:

“人工智能不会仅仅重复我们迄今为止发展的人类知识,而且有可能实现超越”……我认为这是我们尚未完全见识到的,

我们基本上仍处于当前科学水平。你认为什么将使人工智能超越人类?

Hinton

:

我们在更有限的情境中已经见过这种情况。

Hinton

:

我们在更有限的情境中已经见过这种情况。

以

AlphaGo

为例,在与

李世石

的那场著名比赛中,

第 37 手

,AlphaGo 下了一步所有专家都认为必定是失误的棋,但实际上后来他们意识到这是一步妙手。所以那是在围棋这种有限领域内的创造性。我认为

随着这些系统变得更大,我们会看到更多这样的情况

。

Hellermark

:

AlphaGo 的不同之处还在于它使用了

强化学习

,这使它能够超越当前的状态。它最初是从模仿学习开始的,观察人类如何玩游戏,然后通过自我对弈,发展得远超于此。你认为这是否是当前机器学习缺失的要素?

Hellermark

:

AlphaGo 的不同之处还在于它使用了

强化学习

,这使它能够超越当前的状态。它最初是从模仿学习开始的,观察人类如何玩游戏,然后通过自我对弈,发展得远超于此。你认为这是否是当前机器学习缺失的要素?

Hinton

:

我认为这很可能是一个缺失的要素,没错。

Hinton

:

我认为这很可能是一个缺失的要素,没错。

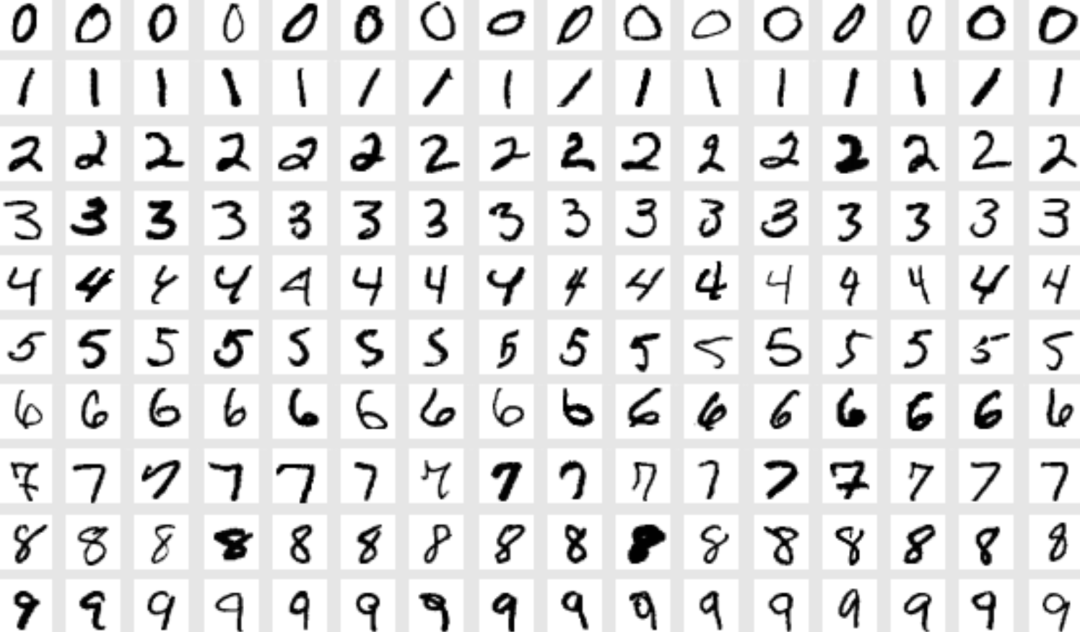

AlphaGo 和 AlphaZero 的自我对弈是其能够做出这些创造性走法的重要原因。但我不认为这是完全必要的。很久以前我做过一个小实验,就是训练一个神经网络来识别手写数字,即

MNIST

的案例。

我故意在手写数字识别任务的训练集中加入了 50% 的错误标签,

并保持这种状态。因此它不能通过简单地看到相同的例子,有时是正确答案,有时是错误答案,来平均消除错误。

而即便如此,

神经网络通过反向传播训练后,依然能够将错误率降低到 5% 或更低

。这意味着网络有能力从错误中学习,区分哪些数据标记可能是错误的,并且从中提取出正确的模式

。

这就是聪明的学生有时候能比他们的导师更聪明的原因。当导师告诉学生

所有

的信息时,有一半会被聪明的学生认为是“废话”,左耳朵进右耳朵出;还有另一半知识被学生们吸取,最终导致学生变得比导师更聪明。

所以

实际上

这些

大型神经网络的表现可以远超其训练数据,而大多数人没有意识到这一点

。

Hellermark

:

那么,你期望如何在人工智能模型中加入推理能力呢?是

通过一种思维链的方式让模型自我反馈其推理过程

,还是说

模型不断增长就能自然提升推理能力

?

Hellermark

:

那么,你期望如何在人工智能模型中加入推理能力呢?是

通过一种思维链的方式让模型自我反馈其推理过程

,还是说

模型不断增长就能自然提升推理能力

?

Hinton

:

我的直觉是,

随着人工智能模型,尤其是大语言模型的规模扩大,它们在推理能力上将自然地得到提升

。

Hinton

:

我的直觉是,

随着人工智能模型,尤其是大语言模型的规模扩大,它们在推理能力上将自然地得到提升

。

我想将这一过程与人类的认知过程相比较。人类通过直觉进行初步判断,并利用推理来修正和完善这些直觉。同样,AlphaGo 和 AlphaZero 这类系统通过结合直观的评估函数与深入的

蒙特卡洛树搜索

(

Monte Carlo rollout

)来优化决策,这种机制允许模型不仅仅模仿人类已有的知识和行为,还能在某种程度上创新。这正是 AlphaGo 能够做出第 37 步那种创造性走法的原因。它拥有更多的训练数据,可以使用推理来检查下一步正确的走法应该是什么。

Hellermark

:

你对多模态有什么看法?多模态是如何影响人工智能模型理解和生成类比的能力的?—— 我的意思是,

当模型不仅仅处理语言,还能处理图像、视频和声音等多媒体信息时,这将如何改变模型的本质和能力

?

Hellermark

:

你对多模态有什么看法?多模态是如何影响人工智能模型理解和生成类比的能力的?—— 我的意思是,

当模型不仅仅处理语言,还能处理图像、视频和声音等多媒体信息时,这将如何改变模型的本质和能力

?

Hinton

:

多模态输入会让模型有显著的改进

,尤其是在理解空间关系和物体方面。例如,一个能够“看”并“操作”物体的多模态系统相比仅依赖语言的系统,能更深刻地理解物体。虽然语言可以传达大量信息,但多模态学习因为结合了多种感官输入,提供了更加丰富的上下文,使得学习过程更为直接和高效。

Hinton

:

多模态输入会让模型有显著的改进

,尤其是在理解空间关系和物体方面。例如,一个能够“看”并“操作”物体的多模态系统相比仅依赖语言的系统,能更深刻地理解物体。虽然语言可以传达大量信息,但多模态学习因为结合了多种感官输入,提供了更加丰富的上下文,使得学习过程更为直接和高效。

而且,利用多模态数据(

如预测 YouTube 视频的下一帧

)可以让模型获得更多的训练数据,同时减少对语言的依赖。因此,我认为这些

多模态模型显然将会占据主导地位

。通过这种方式,你可以获取更多数据。它们需要的语言更少。这里其实有一个哲学观点,即

你可以仅通过语言学习到一个非常好的模型,但从多模态系统中学习要容易得多

。

Hellermark

:

你认为这将如何影响模型的推理能力?

Hellermark

:

你认为这将如何影响模型的推理能力?

Hinton

:

我认为它将大大提高模型对空间等事物的推理能力。比如推理当你拿起物体时会发生什么。如果一个机器人真的尝试拿起物体,它就能获得各种有助于训练的数据。

Hinton

:

我认为它将大大提高模型对空间等事物的推理能力。比如推理当你拿起物体时会发生什么。如果一个机器人真的尝试拿起物体,它就能获得各种有助于训练的数据。

Hellermark

:

你认为人类大脑是为了适应语言而进化的吗?还是说,语言为了适应人类大脑而发展的?

Hellermark

:

你认为人类大脑是为了适应语言而进化的吗?还是说,语言为了适应人类大脑而发展的?

Hinton

:

这是一个非常好的问题。我认为 -

两者都发生了

。我曾认为我们可以在不依赖语言的情况下进行大量认知活动。现在我的看法有所改变。让我给你介绍三种不同的语言观及其与认知的关系。

Hinton

:

这是一个非常好的问题。我认为 -

两者都发生了

。我曾认为我们可以在不依赖语言的情况下进行大量认知活动。现在我的看法有所改变。让我给你介绍三种不同的语言观及其与认知的关系。

首先是传统的

符号观

,即认知是

基于明确、抽象的逻辑符号及符号操作

,暗示语言与逻辑思维紧密相连,几乎构成认知的核心机制。这一观点倾向于认为人类大脑和语言是协同进化的,各自适应对方的存在与发展。所以,这是一种极端的观点

与之相反的极端观点是,你的大脑内部全都是

向量

。这种观点认为,

符号进入大脑会转换成大型向量,所有内部处理都是通过大型向量完成的

。然后,如果你想生成输出,就再次生成符号。大约在 2014 年,机器翻译领域有一个阶段,人们使用循环神经网络,单词不断输入时会有一个隐藏状态,并且在这个隐藏状态中不断积累信息。所以当他们到达句尾时,他们会得到一个大的隐藏向量,这个

向量捕捉了该句子的意义,然后可以用来在另一种语言中生成句子

。这被称为

思想向量

,是对语言的第二种看法。

但还有一种第三种观点,即

我现在所相信

的,那就是

语言和思维过程中确实涉及符号,但这些符号通过多层次的嵌入表示(

embedding representation

)被丰富化了

。但是,这些嵌入仍然与符号相关联,意味着

每个符号都有一个大的向量,这些向量相互作用,以产生下一个词的符号向量

。这就是所谓的“

理解

”。

“

理解

”就是知道如何将符号转换成这些向量,以及知道这些向量的元素应该如何相互作用来预测下一个符号的向量

。这就是大语言模型和我们大脑中的理解。这是一个介于两者之间的例子。你仍然保留着符号,但你将其解释为这些大型向量,而所有的努力都集中在这里。所有的知识都体现在你使用的向量以及这些向量元素之间的相互作用上,而非符号规则。但这并不是说你可以完全摆脱符号。它的意思是将符号转化为庞大的向量,但仍然停留在符号的表层结构上。

这就是这些模型的工作原理。现在在我看来,这也同样是一个更合理的人类思维模型。

Hellermark

:

你是第一批意识到使用 GPU 的人之一(

2009 年

),

黄仁勋

因此非常欣赏你。带我们回顾一下你的灵感来源。

Hellermark

:

你是第一批意识到使用 GPU 的人之一(

2009 年

),

黄仁勋

因此非常欣赏你。带我们回顾一下你的灵感来源。

Hinton

:

实际上,大约在 2006 年,我有一个叫

Rick Zelinsky

的

前研究生

,他是一位非常优秀的计算机视觉专家。在一次会议上,他告诉我:“

你知道吗,你应该考虑使用图形处理卡,因为它们在矩阵乘法方面非常出色。你现在的研究基本上都是矩阵乘法。

”

Hinton

:

实际上,大约在 2006 年,我有一个叫

Rick Zelinsky

的

前研究生

,他是一位非常优秀的计算机视觉专家。在一次会议上,他告诉我:“

你知道吗,你应该考虑使用图形处理卡,因为它们在矩阵乘法方面非常出色。你现在的研究基本上都是矩阵乘法。

”

我对此思考了一会儿,试着购买了游戏用的 GPU,发现它们让处理速度提升了 30 倍。接着我们买了一整套

NVIDIA Tesla GPU

,并在上面进行了语音处理,效果非常好。

随后到了 2009 年,我在 NIPS 上发表演讲,对 1,000 名机器学习研究人员说:“

你们都应该去买 NVIDIA 的 GPU。它们代表了未来。你们做机器学习需要它们。

”

实际上,我随后给 NVIDIA 发了一封邮件,说:“

我告诉了 1,000 名机器学习研究人员购买你们的显卡。你们能因此免费送我一块吗?

" 他们说不行 —— 我开玩笑的,其实他们只是没有回复。后来,黄仁勋知道了这件事,他免费送了我一块显卡。

Hellermark

:

那真是太好了,我觉得最有意思的地方在于 GPU 技术是伴随着 AI 领域一同发展的。你对于

计算技术下一步应该如何演进

有哪些看法?

Hellermark

:

那真是太好了,我觉得最有意思的地方在于 GPU 技术是伴随着 AI 领域一同发展的。你对于

计算技术下一步应该如何演进

有哪些看法?

Hinton

:

我在谷歌的最后几年里一直思考如何实现

模拟计算(

analog computation

)

。这样我们就不用消耗兆瓦级的电力,而是可以像大脑一样只用 30 瓦,从而在模拟硬件上运行这些大语言模型。尽管我没有成功实现这一目标,但这一过程让我加深了对数字计算价值的认识。

Hinton

:

我在谷歌的最后几年里一直思考如何实现

模拟计算(

analog computation

)

。这样我们就不用消耗兆瓦级的电力,而是可以像大脑一样只用 30 瓦,从而在模拟硬件上运行这些大语言模型。尽管我没有成功实现这一目标,但这一过程让我加深了对数字计算价值的认识。

模拟计算意味着每块硬件都有其独特性,这要求学习过程需适应硬件的具体特性,类似于人脑中每个个体的大脑差异性。由于人脑硬件的不同,使得权重无法直接从一个人转移到另一个人,信息传递效率低下,这被称为

知识蒸馏(

distillation

)

。

因其权重的可复制性和共享性,数字系统实际上是“永生”的。一旦某个系统学习到的权重被确定,它可以被保存并在任意兼容的数字系统上重现,无需考虑硬件的具体差异,从而实现高效的知识共享。数字系统间可以通过微小的学习更新,然后共享这些更新后的权重,实现集体知识的即时同步,这是人类目前无法做到的。因此,我认为

数字系统在知识共享方面比人类更加优越

。

Hellermark

:

神经科学中其实早已有很多类似的想法,并应用在了现代人工智能系统中。你觉得未来还有哪些神经科学原理尚待融入这些系统中?

Hellermark

:

神经科学中其实早已有很多类似的想法,并应用在了现代人工智能系统中。你觉得未来还有哪些神经科学原理尚待融入这些系统中?

Hinton

:

我们仍需在时间尺度上与神经科学同步的一个重要领域是

变化的时间尺度

。在现有的神经网络模型中,通常只有两个时间尺度:一个是

活动(

如神经元激活状态

)

的快速变化,另一个是

权重(

长期学习参数

)

的缓慢调整。然而,人脑中存在多个时间尺度的权重变化,这允许了临时记忆的形成。

Hinton

:

我们仍需在时间尺度上与神经科学同步的一个重要领域是

变化的时间尺度

。在现有的神经网络模型中,通常只有两个时间尺度:一个是

活动(

如神经元激活状态

)

的快速变化,另一个是

权重(

长期学习参数

)

的缓慢调整。然而,人脑中存在多个时间尺度的权重变化,这允许了临时记忆的形成。

例如,我突然没由头地喊一句“

黄瓜!

”,五分钟后你戴上耳机,并在周围释放很多噪音,这时候听到的词很微弱,却更容易识别出“黄瓜”这个词 —— 因为我五分钟前说过。那么,这种知识在大脑中是如何存储的呢?显然是体现在

突触的暂时性变化

中,而不是神经元在对你说:“

黄瓜,黄瓜,黄瓜。

” 这体现在权重的暂时性变化上。通过权重的暂时性变化,你可以做很多事情,我称之为

快速权重

—— 但在当前的神经模型中,我们并不这么做。

部分原因是,这些

模型依赖于并行处理大量数据以实现高效的矩阵运算,而这与快速权重所需的依据输入数据动态调整权重的机制相冲突

。然而,快速权重对于实现更接近人脑的临时记忆功能至关重要。我曾非常期待像

Graphcore

这样的技术如果采用顺序处理并仅进行在线学习,就有可能利用快速权重。但目前这一设想尚未实现。我预测随着技术进步,特别是当开始

使用电导作为权重表示

时,这一问题有望得到解决。

Hellermark

:

了解这些模型的工作原理以及大脑的工作方式,对你的思考方式有何影响?

Hellermark

:

了解这些模型的工作原理以及大脑的工作方式,对你的思考方式有何影响?

Hinton

:

我认为最大的影响在于对一个抽象概念的认知转变:过去,许多人,包括统计学家、语言学家及多数 AI 研究者,对通过一个大型随机神经网络并辅以大量训练数据来学习执行复杂任务的想法持怀疑态度,他们认为这仅是“

空想

”。没有内在知识和严格架构限制,不可能学会复杂事物。

Hinton

:

我认为最大的影响在于对一个抽象概念的认知转变:过去,许多人,包括统计学家、语言学家及多数 AI 研究者,对通过一个大型随机神经网络并辅以大量训练数据来学习执行复杂任务的想法持怀疑态度,他们认为这仅是“

空想

”。没有内在知识和严格架构限制,不可能学会复杂事物。

然而,大型神经网络模型的成功验证了这一观点的错误性:

通过随机梯度下降不断调整权重,确实能够学习并掌握复杂知识

。这一发现对于理解大脑的工作机制具有重要意义,表明大脑不必具备所有先天结构 —— 尽管大脑确有其固有的结构,但对于易于学习的事物,它并不需要特定的先天结构。

Hellermark

:

究竟如何能让 AI 模型更有效地模拟人类的意识?假如说有一个伴随人一生、具有自我反思能力的 AI 助手,那在得知主人去世的消息时,它是否会有所感受?

Hellermark

:

究竟如何能让 AI 模型更有效地模拟人类的意识?假如说有一个伴随人一生、具有自我反思能力的 AI 助手,那在得知主人去世的消息时,它是否会有所感受?

Hinton

:

AI 助手如果想「

得知

」

主人去世

,就需要另一个人

告诉

它,或是让它自己去

感知

—— 因为主人已经死了,无法给 AI 传递信息。

Hinton

:

AI 助手如果想「

得知

」

主人去世

,就需要另一个人

告诉

它,或是让它自己去

感知

—— 因为主人已经死了,无法给 AI 传递信息。

Hellermark

:

是的,你认为 AI 助手在主人去世时能

感知

到什么?

Hellermark

:

是的,你认为 AI 助手在主人去世时能

感知

到什么?

Hinton

:

我认为 AI 也能有情感

。就像我们有内心剧场模型来解释

感知

一样,我们也有类似的模型来解释

情感

,这些是我能体验到而别人无法体验的。

Hinton

:

我认为 AI 也能有情感

。就像我们有内心剧场模型来解释

感知

一样,我们也有类似的模型来解释

情感

,这些是我能体验到而别人无法体验的。