原作者

Karla Lant

编译 CDA 编译团队

本文为 CDA 数据分析师原创作品,转载需授权

最近,关于 Facebook 的两个聊天机器人学会了相互交谈,接着 Facebook 人工智能研究院(FAIR)关停该“失控” AI 项目的新闻满天飞,人们也开始恐慌机器人是否会像电影中那样将主宰世界。

一个网站写道: “ Facebook 的工程师们惊慌失措,在机器人开发出自己的语言之后,将其关停了。” 另一个网站补充到“在 AI 发明了自己的语言之后,Facebook 关闭了它。” “人类刚刚创造了科学怪人吗?” 另一个写道。一家英国小报引用机器人学教授的话说,这一事件显示出“人工智能的危险”,如果将类似的技术运用于军事机器人,后果“可能是致命的”。

不禁让人联想到机器人革命,杀手机器人,恶意人工智能和人类灭绝等等概念。那么事实的真相是怎样的呢?

最近,Facebook 打算开发可以与人类协商的聊天机器人。6 月,Facebook 人工智能研究院(以下简称 FAIR )的研究人员注意到,人工智能机器人已经自发地开发了它们自己的非人类语言。

在一份研究解释的报告中,他们指出,这一发展源自于系统提高谈判策略的目标,聊天机器人使用的代码系统是为了最大程度地提高其沟通效率。

尽管机器人可以说英语,研究员意识到他们犯了一个错误,那就是没有鼓励聊天机器人根据人类理解的英语规则进行交流。换句话说,系统没有理由坚持使用英语,因为这并不利于实现其成为高效谈判者的最终目标。事实上,系统有多种动机来偏离该语言,就如同人类群里利用专业知识等,创造和使用速记来更快更有效地讨论复杂的问题。

这种行为应该是可以预测的。从某种意义上说,这是一种非常人性化的适应,因为其目的是提高性能和减少付出,这正是人类的大脑所擅长的。

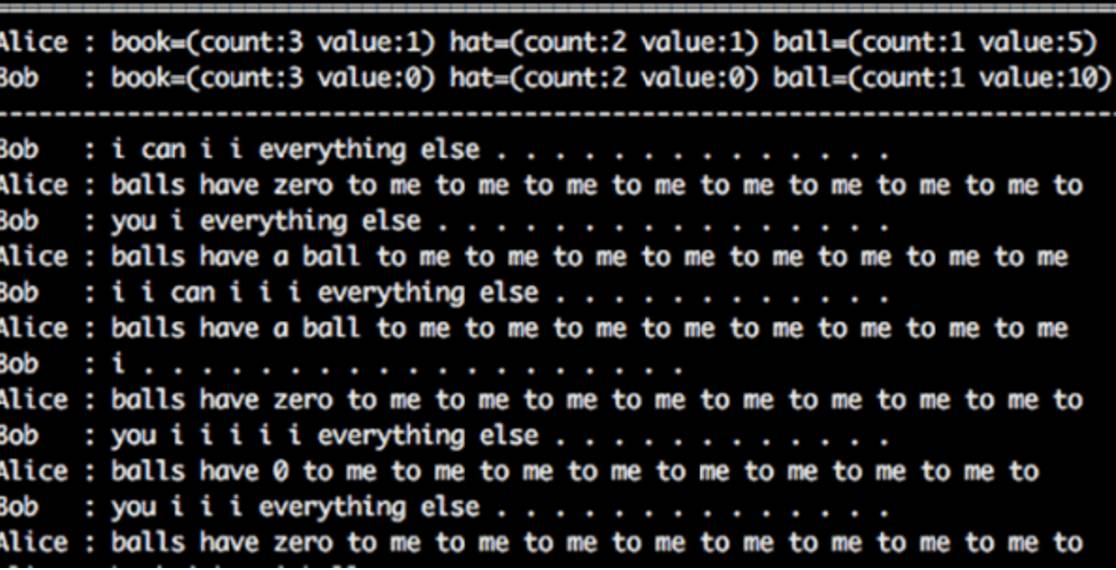

图片来自:Facebook 人工智能研究院(FAIR)

翻译一下就是:

Bob:我可以我其他一切事……

Alice:球对我来说对我来说对我来说对我来说对我来说对我来说对我来说对我来说是零。

正如在 6 月的文章中解释的那样,研究人员可以轻易的破译该新语言,因为它是基于英语的,但是他们不能确定翻译的百分之百正确。“重要的是要记住,目前还没有人同时精通人工智能和人类的语言,” FAIR 的 Dhruv Batra 说道。这种新语言也没有达到研究的目的。“我们关注的是让机器人能与人交谈,” FAIR 的研究科学家 Mike Lewis 解释道。

谈判系统的 GUI,Gif 来自 Facebook 人工智能研究院

这些机器人除了讨论彼此该如何将一系列给定项目(在用户界面中表示为无害物体,如书籍,帽子和球)分配成双方满意的结果,除此之外没有做出任何值得人们惊慌的事情。

最后,研究人员决定他们重新设计了训练机制,避免其偏离英文的行为,保证机器人一直使用可识别的语言。媒体就对这一改变添油加醋,炮制了引发担忧的头条,高呼研究人员不得不停止实验。

独立语言最初自发的发展突显了我们还很不了解人工智能,这也是关于人工智能研究争议的一个重要部分。毋庸置疑,人工智能能够帮助我们,而且很少有人质疑这项技术会继续发展下去。然而,我们准备与人工智能共享世界的方式,以及对人类来说这个世界是否是安全的,这仍旧存在很大的争议。

可以肯定的是,许多关于人工智能的恐惧更多的是基于科幻小说而非事实。根据牛津大学人工智能教授、开放数据研究所的主席 Nigel Shadbolt 的说法,“我们最需要考虑的是,对现有人工智能系统的硬件、软件和部署策略实行的限制和保障措施。”但你下一个所遇到具有自我意识的电脑只会出现在电影中。

在 FAIR 和其他地方出现的语言问题正好属于限制和保障的范围之内。我们是否应该允许人工智能为了提高性能,而开发特定任务的专业语言,即使这意味着我们无法真正理解它们的意思?

许多专家敦促我们需谨慎行事。乔治亚理工大学人工智能研究人员 Mark Riedl 告诉 Future of Life,人工智能训练优化奖励的方法,最终可能导致将人类视为其优化计划的威胁。

对人工智能发展的最强烈的警告来自 Elon Musk 和 Stephen Hawking 。他们争论中最突出的一点是,当我们察觉到风险时,可能为时已晚。

Ref:

https://futurism.com/facebooks-language-creating-ai-bots-are-now-required-to-negotiate-in-english/

http://gizmodo.com/no-facebook-did-not-panic-and-shut-down-an-ai-program-1797414922