导读

作者提出了一种名为

FrugalGPT

的简单灵活的 LLM 级联方法,帮助用户在降低使用大型语言模型(LLM)成本的同时提高准确性。

随着大型语言模型(LLM)的迅速发展,越来越多的用户需要支付费用来查询它们。流行的 LLM API,如 GPT-4、ChatGPT 和 J1-Jumbo 等,存在不同程度的价格差异,费用相差可高达两个数量级。尤其是在大量查询和文本上使用 LLM 时,费用可能非常昂贵。

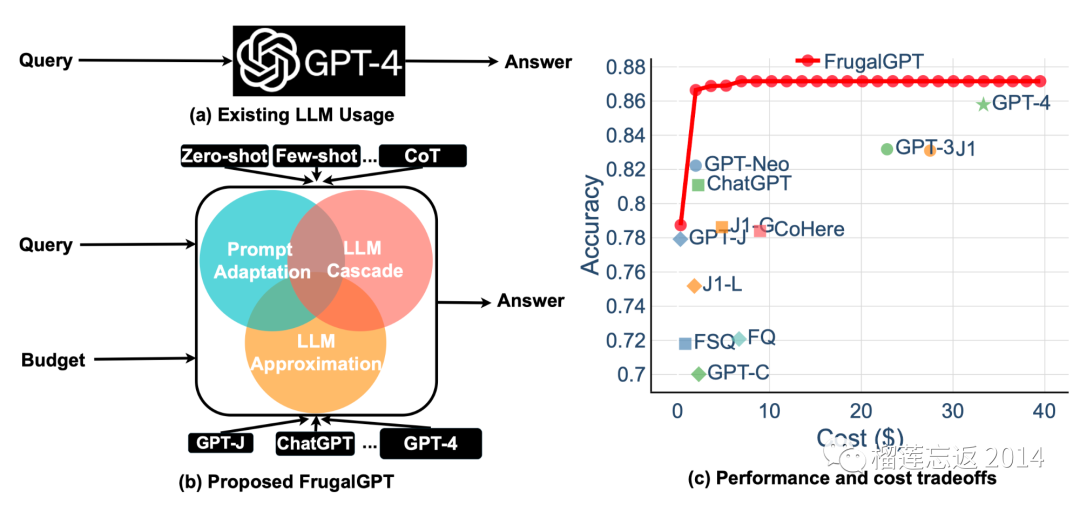

为解决这一问题,作者提出了三种降低使用 LLM 推理成本的策略:1)

提示适应

,2)

LLM 近似

,3)

LLM 级联

。

以 FrugalGPT 为例,这是一种简单而灵活的 LLM 级联实例,可以根据不同的查询选择合适的 LLM 组合以降低成本并提高准确性。

作者的实验表明,FrugalGPT 在降低成本的同时,能够达到最佳单一 LLM(如 GPT-4)的性能,最多可节省

98%

的成本。相同成本下,其准确性比 GPT-4 高出 4%。本文提出的观点和发现为 LLM 的可持续和高效使用奠定了基础。

引言

如今,大型语言模型(LLM)正处于爆炸式发展阶段。随着越来越多的公司(如 OpenAI、AI21 和 CoHere 等)提供 LLM 服务,LLM 在商业、科学和金融等大规模应用中的诱人前景引发了广泛关注。

作者提出了一个灵活的框架——FrugalGPT,利用 LLM API 处理自然语言查询,同时满足预算约束。实验表明,FrugalGPT 在保持与最佳单一 LLM API 相当的下游任务性能的同时,最多可以节省 98%的推理成本。

值得注意的是,LLM API 的输出涵盖了整个自然语言空间,但现有工作需要固定的标签集。提示选择和 LLM API 选择对生成任务的性能产生显著影响,导致优化空间比标准分类任务大得多。

问题陈述

对于许多小企业来说,LLM API 的高昂成本限制了其在各领域的广泛应用,因此需要一种有效策略来降低成本。

LLM API 通常包含三个成本组成部分:与提示长度成比例的部分、与生成答案长度成比例的部分以及每次查询的固定成本。以 GPT-4 为例,输入和响应的成本分别为每千个令牌 0.03 和 0.06 美元。因此,每月的总成本约为

360 × (0.03 × 1800 + 0.03 × 1800 + 0.06 × 80) ≈ $21.2K

。如此高的成本对许多小型企业来说是难以承受的。

值得注意的是,策略的搜索空间非常广阔,涉及诸如使用哪些提示、采用哪些 LLM API 以及如何聚合它们的响应等因素。为了降低成本,需要在这个复杂的搜索空间中找到一种有效的策略。

总之,针对高昂的 LLM API 成本,作者需要探讨一种降低成本的有效策略,以便让更多的小型企业能够在各个领域利用这些模型。

-

💸 LLM API 成本包括三部分:提示长度、生成答案长度和固定查询成本

-

-

🧩 策略搜索空间包括多种因素:提示选择、LLM API 选择和聚合响应方式

解决方案

通过采用 FrugalGPT 框架,作者可以实现在降低 LLM 成本的同时提高准确性,从而实现更加经济、高效地使用 LLM。

为了实现 LLM 的经济、准确使用,可以采用以下方法:

-

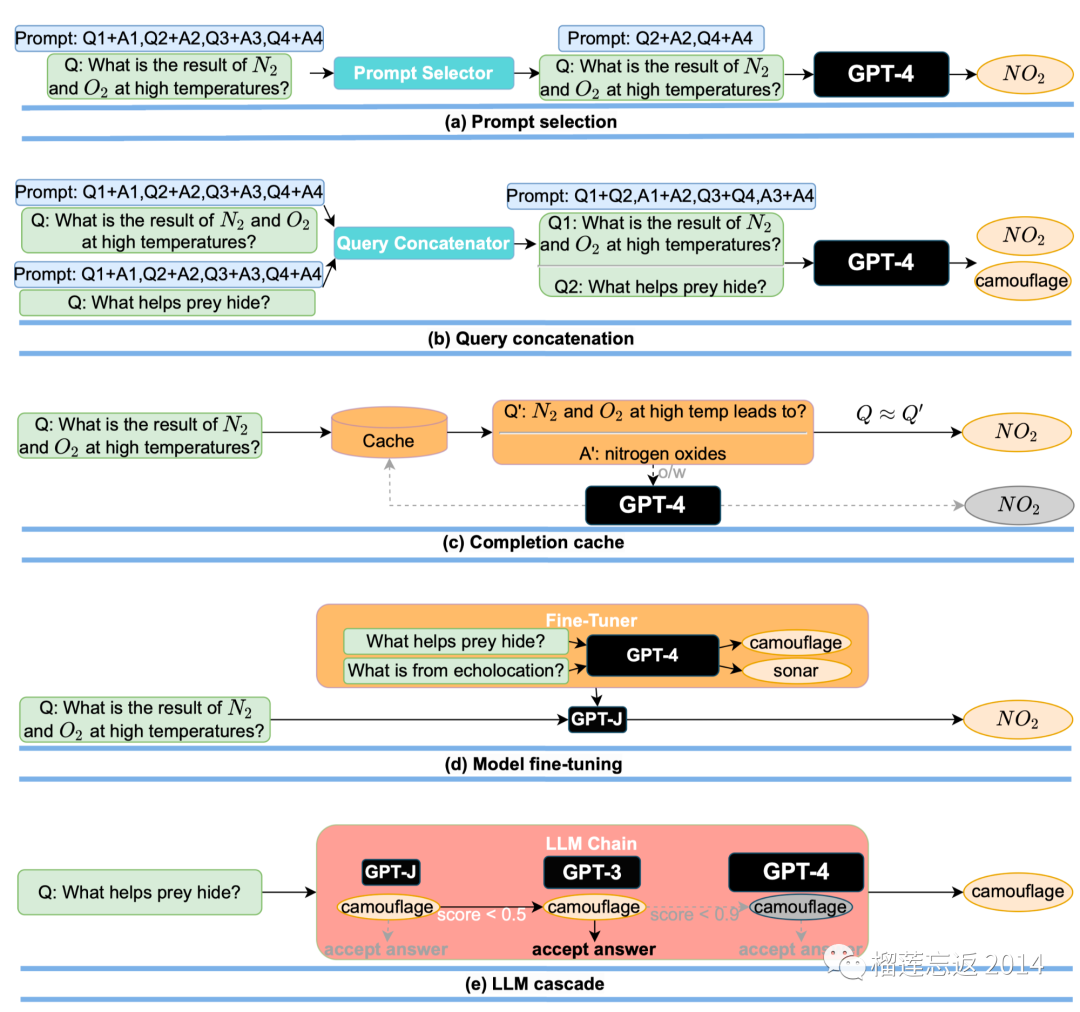

缩小提示以降低成本;当多个用户同时搜索相同或类似的关键词时,通过只调用一次 LLM 完成缓存来回答所有查询;

-

另一个例子是模型微调。联合提示和 LLM 选择是提示选择和 LLM 级联的组合:对于给定的查询,它会寻找最小的提示和最实惠的 LLM,以实现满意的任务性能。

-

还可以在现有的 LLM API 和微调模型之间进行搜索。这为研究查询成本、任务性能和计算成本之间的权衡铺平了道路。

LLM 级联可以降低成本并提高准确性。作者对 FrugalGPT LLM 级联进行了实证研究,目标有三个方面:

-

-

(ii)量化 FrugalGPT 在达到最佳单一 LLM API 性能的同时所实现的成本节省;

-

(iii)衡量 FrugalGPT 实现的性能和成本之间的权衡。

FrugalGPT 已经在这些 API 的基础上开发,并在一系列不同任务的数据集上进行了评估,包括 HEADLINES [SK21]、OVERRULING [ZGA+21]和 COQA [RCM19]。

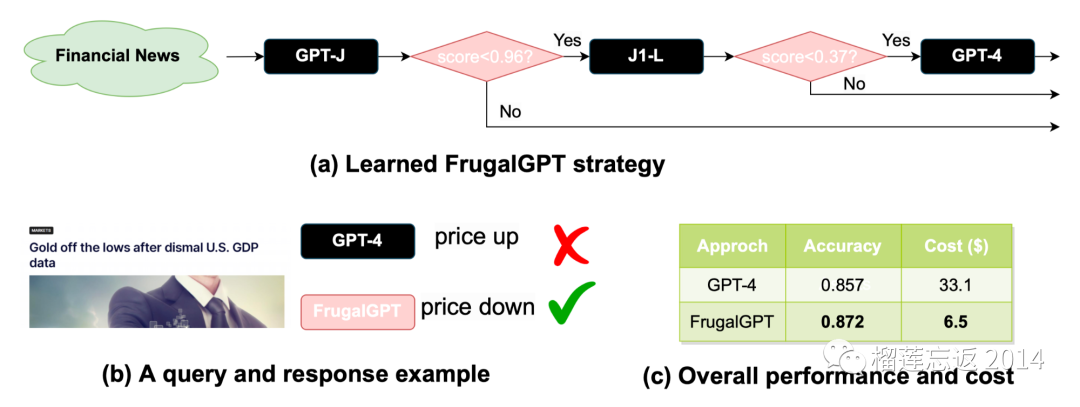

COQA 是一个在对话设置中开发的阅读理解数据集,作者将其改编为直接查询回答任务。如果 J1-L 的答案得分大于 0.37,则接受其作为最终回答;否则,调用 GPT-4 以获得最终答案。

这种方法在许多查询中胜过 GPT-4。对于来自纳斯达克的标题“

Gold off the lows after dismal U.S GDP data

”,FrugalGPT 准确预测价格下跌,而 GPT-4 无法预测。

通过采用 FrugalGPT 框架,作者可以在降低成本的同时提高准确性,为使用 LLM 提供了更为经济、高效的途径。

简而言之:

-

-

-

📊 FrugalGPT 的实证研究:理解、量化成本节省和性能成本权衡

结果

实验证明,FrugalGPT 在降低成本的同时,保持了最先进 LLM 的性能,为 LLM 用户提供了灵活的选择,有助于节省能源和减少碳排放。

几点发现:

-

💰 FrugalGPT 在成本降低 98%的情况下,性能与最佳个体 LLM 相当

-

-

实验结果表明,FrugalGPT 在降低成本 98%的情况下,性能与最佳个体 LLM(例如 GPT-4)相当,或者在相同成本下提高 GPT-4 的准确性 4%。

在 OVERRULING 数据集上,与最佳 LLM API GPT-4 相比,FrugalGPT 在减少成本 73%的情况下实现了 1%的准确性提升。作者的实证研究发现,FrugalGPT 在保持最先进 LLM 性能的同时,可以将成本降低高达 98%。

值得注意的是,FrugalGPT 在所有评估数据集上实现了平稳的性能-成本权衡,为 LLM 用户提供了灵活的选择。这不仅有助于 LLM API 供应商节省能源,还有助于减少碳排放。

在 OVERRULING 数据集上,与最佳 LLM API GPT-4 相比,FrugalGPT 在降低成本 73%的情况下实现了 1%的准确性提高。FrugalGPT 接受 GPT-J 的正确答案,避免使用昂贵的 LLM,提高了整体性能。

随着 LLM 及其应用的不断演进,必然会出现新的挑战和机遇,促进这一动态领域的进一步研究和发展。

图表:

图 1

:通过优化不同 LLM API(如 GPT-J,ChatGPT 和 GPT-4)以及提示策略(如 Zero-Shot、Few-Shot 和 CoT)的选择,作者可以实现显著的效率提升。

在提高准确性的同时降低 LLM 成本的愿景

在提高准确性的同时降低 LLM 成本的愿景

图 2

:提示选择使用一部分上下文示例作为提示以减小提示的大小;查询连接将多个查询合并以共享提示;完成缓存在提出类似查询时存储和重用 LLM API 的响应;模型微调使用昂贵的 LLM 响应来微调便宜的 LLM;LLM 级联为不同查询使用不同的 LLM API。

节省成本策略的示例

节省成本策略的示例

图 3

:FrugalGPT 在此数据集上学到了级联策略,总预算为 6.5 美元,是 GPT-4 成本的五分之一。只要 GPT-J 和 J1-L 生成高质量答案,FrugalGPT 就避免查询 GPT-4。作者观察到,与 GPT-4 相比,FrugalGPT 将成本降低了 80%,同时将准确性提高了 1.5%。

在 HEADLINES 数据集上的 FrugalGPT 案例研究

在 HEADLINES 数据集上的 FrugalGPT 案例研究

图 4

:作者观察到,便宜的 LLM 很多时候可以补充昂贵的 LLM。例如,在 HEADLINES 数据集上,约 6%的数据中,GPT-4 出错,但 GPJ-J(或 J-L 或 GPT-C)给出了正确答案。

每对 LLM 的最大性能改进(MPI)

每对 LLM 的最大性能改进(MPI)