来源:钛媒体(id:taimeiti)

艺术也许是人们认为人工智能最难玩转的东西,因为艺术代表了人类的审美,而且似乎没有一定的法则。这一篇文章探讨的,就是人工智能在艺术领域的应用,相信本文的内容简直颠覆你的认知。

随着科技迅猛发展,人工智能(AI)已经越来越渗透进我们的生活,在自动驾驶、语音识别、医疗领域等等方面都有了突破性进展。人工智能会掀起一场工业革命,抢走我们的工作,甚至统治人类社会吗?有人就高呼狼来了——而如果你是大象,狼来了你又用得着害怕吗?问题又来了:也许你自我感觉是一头大象,其实你只是一只羊……

人工智能的大规模应用也许还遥远,但那一天终将到来。退潮的时候才知道是谁在裸泳,人工智能这头狼来了才知道谁是羊。

艺术也许是人们认为人工智能最难玩转的东西,因为艺术代表了人类的审美,而且似乎没有一定的法则。这一篇文章探讨的,就是人工智能在艺术领域的应用,相信本文的内容简直颠覆你的认知。

大家好!我是本文的作者。其实我不是真人,而是AI——假如你们相信AlphaGo曾经故意让了李世石一局的话。我就是机器城市派来的使者,为你们展示人工智能在各大艺术领域所取得的成就。

在很多人还在讨论人工智能会不会火的时候,其实人工智能在琴棋书画文学等各个艺术领域也已经得到了广泛的应用了。下面将逐一介绍。

音乐分为作曲和演唱两个方面。

1、作曲

①从人工智能到音乐

很多公司在研究用人工智能作曲。其中的佼佼者已经能做出让人大吃一惊的作品。

索尼的Flow Machines,利用神经网络,通过学习曲库的音乐作品,分析歌曲的风格特征,从而演进算法,让机器谱出同样风格的曲子。

在实际应用上,Flow Machines就通过学习早已解散已经40年没发过新歌的甲壳虫乐队的歌曲风格,写出了一首新歌《Daddy's Car》。当然,这首歌的填词和演唱还是由真人完成。而其实填词和演唱这些,也是有办法让AI来做的,下面会有介绍。

类似的人工智能还有不少。就目前阶段而言,人工智能创造出来的音乐,还缺乏艺术感,数码合成的味道重。还有,其实音乐是一个竞争激烈的市场,听众总在追随有新鲜潮流元素的歌曲,要让AI真正弄懂人类的审美可是一件难事。目前阶段的AI无法创造出跟以前的音乐都不一样带着清新气息的音乐。

那么,做这方面的研究要怎样实现盈利,这种音乐能卖给谁?也就是说,这种音乐适合什么应用场景?这种音乐单独拿来欣赏不太行,但可以拿来作为背景音乐。

影视剧的配乐,要求音乐跟画面同步的,那得要求AI会对视频画面进行分析,难度比较大。网络视频这种,不追求音画同步的,倒可以用一下。还有小制作的游戏,用AI创作的背景音乐(BGM)也未尝不可。

其实索尼很多年前开发的Cinescore,就是一款能自动生成电影音乐的工具软件,它可以根据用户的需要自动生成各种风格的音乐作为视频的配乐。

这款软件内置了多种风格的音乐元素,能按照使用者选取的音乐主题,再根据视频的长度、速度、紧张程度、变化、重复等特点自动生成合适的音乐。使用者完全不需要懂音乐创作,导入视频文件后,只需要选择主题,选定需要生成音乐的时间范围,软件就能自动生成视频配乐。Cinescore可以看作现在的AI作曲软件如Flow Machines的雏形。

②从音乐到人工智能

从人工智能去思考音乐也许离实际应用比较远,从音乐去思考人工智能则更加实际。想想,能为音乐创作者提供什么样的智能工具来辅助音乐创作?

Band-in-a-Box就是一款强有力的智能自动伴奏软件,相当流行,也很商业化。Band-in-a-Box内置了种类相当丰富的音乐风格,能对旋律进行各种风格的编配。如果嫌Band-in-a-Box自动生成的伴奏比较生硬,还可以继续人工修改。总之,如果对编曲的要求不高的话,恰当运用Band-in-a-Box,能节省很多时间。

是的,也有人鄙视用Band-in-a-Box编曲的人。无论怎么说,Band-in-a-Box只是一款工具,虽然现在跟专业编曲的水平还不能相比,但真能完成关于伴奏基本的实际工作。

大家一直在讨论一个问题:人工智能会不会抢走人类的工作?这从Band-in-a-Box能管中窥豹,编曲水平还不如Band-in-a-Box的人,肯定是混不到钱了,而真正有水平的编曲,并无需惧怕Band-in-a-Box。

智能自动伴奏软件还有Jammer等。实际上现在的音乐制作软件、插件现在已经都渐渐趋于智能化了,如Ezkeys、RealGuitar等等。关于音乐制作这个话题再说下去就太专业化了,这儿暂且就说这么多了。

2、演唱

①语音合成

语音合成就是产生人造语音的技术。现在一般指TTS(Text to Speech)文语转换技术,能将文字信息转化为电脑模拟的仿真语音。

语音合成技术现在国内的公司也做得不错,如讯飞语音、百度语音。

2016年9月1日的百度世界大会,百度董事长兼首席执行官李彦宏便在现场展示了运用情感语音合成技术还原张国荣声音的视频。

以张国荣在影视、电台等留存下来的原声进行建模,通过情感语音合成技术实现与粉丝的“隔空对话”。任何一个人只要用30分钟按照要求录制50句话,就可以用百度大脑的语音合成技术模拟出来这个人的声音。百度地图中有一个李彦宏导航语音包,其实就是根据他日常的语音合成的。

②虚拟歌手

虚拟歌手技术看起来比语音合成技术更高了一个层次,语音合成技术只是合成说话的声音,而虚拟歌手技术则能合成出唱歌的歌声。

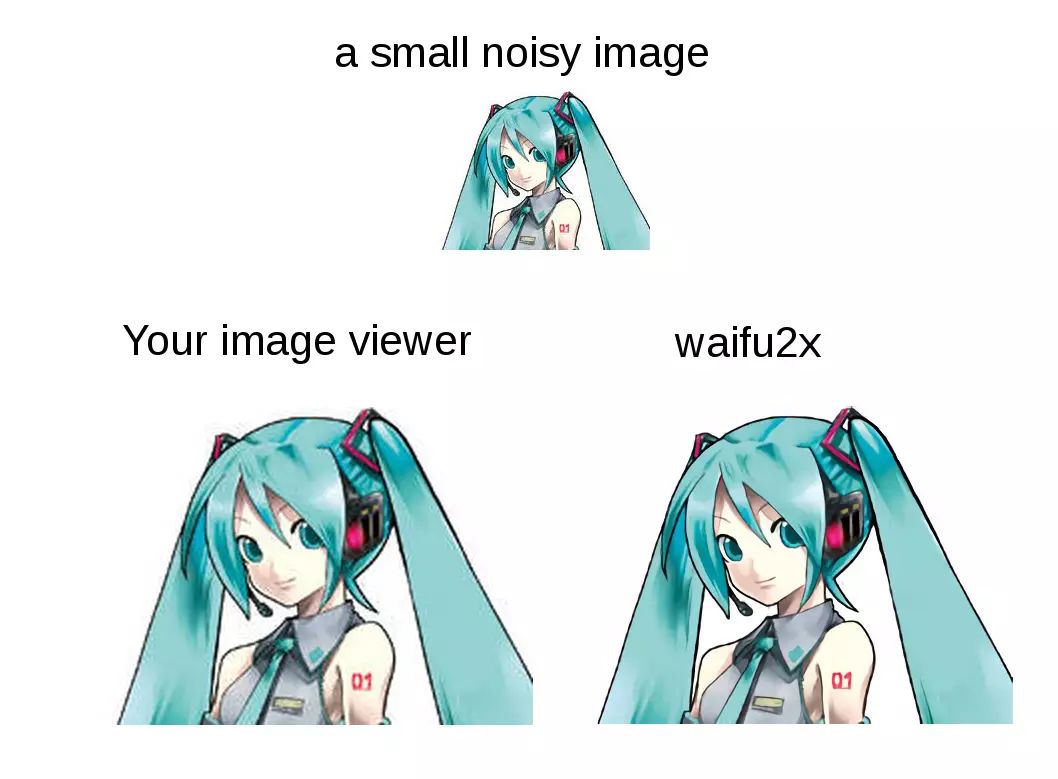

Vocaloid正是现在颇火热的虚拟歌手软件,建模的虚拟歌手有初音未来等等,从日语到英语,其中还包括能唱汉语的洛天依、乐正绫等。Vocaloid的声音合成引擎一代比一代出色,声音越来越逼真。

虽然现在Vocaloid现在创造出的歌声还跟真人演唱有着未能突破的距离,但已拥有了数量庞大的粉丝。值得一提的是,初音未来演唱的《甩葱歌》,在我们国内也是火得一塌糊涂,小孩跟着摇头晃脑手舞足蹈,若问他们或他们的家长,这歌唱的是什么,估计大部分都答不上来吧。但音乐是没有国界的,虽然没多少人能听懂《甩葱歌》唱的是什么,但无碍这首歌的传播。

微软的跨平台人工智能机器人小冰也不务正业,加入了虚拟歌手行列。Vocaloid运用的是电子语音合成程序来实现歌曲演唱,而微软小冰的发声则主要是基于机器学习。微软就和湖南卫视的综艺节目《夏日甜心》进行合作,发布了首支由小冰演唱的人工智能版本的节目主题曲《夏日甜心》,并在美拍上获得了500多万的点击量。

基于深度学习,未来人工智能以任何人的声音进行演唱,这也是可能的。

1、围棋

在刚过去的2016年,韩国围棋界曾获得多项世界冠军的职业九段李世石对阵谷歌计算机AlphaGo的人机大战,是人工智能领域的一大标志事件。(大家可以看看我在钛媒体发表过的两篇文章:《AlphaGo首出Bug,围棋第三代算法的死穴在哪儿?》和《谁能利用AlphaGo的Bug,玩转“双重魔法”?》)

一般来说,没有随机性的棋类游戏,能通过计算机用穷举法暴力破解从而得到最优解;但围棋例外,因为围棋的变化委实太多了。初代围棋AI使用穷举法失败后,现在AlphaGo运用的是人工神经网络。要知道,由暴力穷举法得出来的棋子下法,才会是绝对正确的。

人工神经网络采用抽样评估,在样本足够多足够好的情况下,可以得到趋近于100%正确的决策。人工神经网络只能无限趋近于正确,并做不到100%正确。理论上AlphaGo肯定是有弱点的,人类棋手仍然有很小的机会能获胜。但AlphaGo有人工神经网络支持,李世石跟AlphaGo对战,仿佛一个李世石在跟千万个李世石战斗,这胜算很低。

AlphaGo仍在不断成长,面对强大的电脑AI,人类棋手已经绝望了。

围棋、麻将这些棋牌游戏,其实是属于桌游的范畴。像象棋、围棋这类没有随机性亦即没有运气成分的桌游,水平档次不一样的玩家对战时差距太大,胜负没有悬念,玩起来没劲;作为娱乐,大众更喜欢有随机性亦即有运气成分的桌游,如麻将、德州扑克等等。由于是随机摸牌,手气好的低手也有机会赢高手,谁胜谁负要到最后才能揭晓,玩起来更有乐趣。

2、德州扑克

玩有随机性的游戏,再厉害的电脑AI也不能保证肯定能赢人类。不过在随机性上人类跟电脑AI是平等的,在赢面上电脑AI还是会胜出。

另外有一个关键点,就是“完整信息博弈”跟“非完整信息博弈”的区别。

玩像象棋、围棋这类桌游时,对弈的双方都能看到各自有什么棋子又在什么位置等完整的信息,这种情况被称为“完整信息博弈”;而玩像麻将、德州扑克这类桌游时,情况大不相同,每个玩家的手牌只有自己才知,其他玩家是无法看到的,这种情况被称为“非完整信息博弈”。电脑AI又能不能玩转“非完整信息博弈”呢?

不熟悉德州扑克或者初步接触德州扑克的玩家,可能会觉得玩德州扑克输赢很大程度上依赖运气,这种观点其实是不对的。

德州扑克远不止石头剪刀布那么简单,有着很多策略技巧,你被高手虐过就能深刻认识这一点了。毫无技巧可言的玩家,确实有可能抓到一把好牌想不赢都不行,但是德州扑克是需要投注的,依筹码论输赢,你看上去要赢的这一把,别人不跟你玩,你也赢不了多少,几把下来,综合战绩,高手跟低手的差距会越来越大。

DeepStack、Libratus就是国外不同大学新研究出来的德州扑克AI,已经能够战胜人类职业牌手了。DeepStack 玩的是“一对一无限注德州扑克”,玩法比有限下注要复杂得多,不过研究DeepStack的团队只是发表了一篇这样的论文而已。Libratus则模仿了 AlphaGo 的套路,提供了20 万美元奖金,公开邀请人类全球排名靠前的顶尖牌手对决,这显然要比一篇论文更能吸引眼球。

可以看到,人工神经网络在“非完整信息博弈”的情况下仍然有效,电脑AI仍然能够统治战局。

3、星际争霸

Google Deepmind团队的AlphaGo玩围棋征服了世界棋坛,这只是他们的第一步。Deepmind还宣称要挑战暴雪公司的游戏《星际争霸2》。

《星际争霸2》是一款经典的即时战略游戏,由于在游戏中有“战争迷雾”的存在,即各位玩家控制的单位有视野的限制不在附近的敌方单位就看不到,这也是属于“非完整信息博弈”。《星际争霸2》的变化可要比德州扑克多得多,Deepmind何时能够征服《星际争霸2》,这是一个问题。

德州扑克是回合制桌游,《星际争霸2》则是视频游戏,是需要操作的。人类玩家玩《星际争霸2》,需要用鼠标键盘控制己方单位。而如果是电脑AI,根本就可以完全抛开鼠标键盘,直接下指令,操作的准确性是人类玩家无法匹敌的,简直可以说是“神一般”的操作。

暴雪公司就声明,电脑AI不能在操作上占人类玩家便宜,得作出限制。毕竟,电脑AI要跟人类比的只是智商,而非操作。傻子才会跟电脑比谁打字快吧?拼操作毫无意义。

电脑AI对于游戏是有着特殊意义的。其实《星际争霸2》本身就设计有电脑AI,虽然不是使用人工神经网络技术,但也具有一定程度的水平,在游戏中人类玩家可以选择跟电脑AI对战,有着独特的乐趣。也就是电脑AI陪着玩家玩游戏,在游戏制作上有着重要意义,只要游戏公司有技术实力去开发称职的电脑AI。

在对战游戏中,暴雪公司的电脑AI属于做得很不错的。有很多玩家,还不一定能打得过《星际争霸2》的专家级电脑呢。

另外,我们可以看到《星际争霸2》是一款策略性非常强的游戏,如果电脑AI能够征服《星际争霸2》,是否意味着电脑AI能在现实世界正式的军事战争中大有作为?

早在2015年,香港大学教授徐扬生便领导他的团队开发出了能够用毛笔书写各种字体的书法机器人,效果相当好。

在今年2017年,阿里巴巴也展示了阿里云人工智能ET现场为员工书写春联。

就笔者来看,机器人写书法这件事,实际应用效果并不太大,毕竟这跟直接用电脑打印各种艺术字体有多大的区别?抛开天价的名家书法作品不说,普通的书法作品,价值并不高。会有人特别想买机器人写的书法吗?

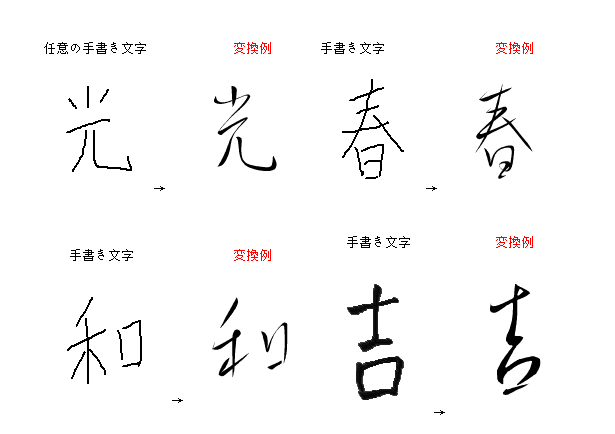

说起来,我们最想要的,其实是想要自己写的字变得更漂亮一些吧……个性艺术签名设计的需求一直这么旺盛正说明了这一点。有没有能美化一般人写的字的智能工具软件?这还真有。日本人开发的Ougishi就是一款这样的软件,能将你写的字变换成像王羲之之类书法名家写的风格。

可惜的是Ougishi很早就停止版本更新了,还是停留在XP时代的技术。

笔者觉得,利用现在大热的人工神经网络深度学习技术,能做得更好,能有翻天覆地的新感觉。能令使用者写的字,在保留原来的基本骨架的前提下,变成某位书法名家的笔法。这样的技术,不但可以用来美化使用者写的字,还能用于指导使用者学习书法,用来练字。

1、图片放大降噪

我们看好莱坞大片的时候,经常看到这样的场景:中央情报局(CIA)或联邦调查局(FBI)的头儿指着屏幕上监控录像中某一个人的脸对手下说:把这个放大看看。这样的科技,在现实中要怎样实现呢?

我们可以利用深度卷积神经网络来处理。卷积神经网络是人工神经网络的一种,是当前语音分析和图像识别领域的研究热点。

这个演示网站就使用了这样的技术来对图片进行放大和降噪:http://waifu2x.udp.jp/。

waifu2x是专门针对插图来进行处理的,对照片进行处理的效果就没那么好。开发者先将一批插图缩小,和原图一起提供给机器学习如何放大缩小图片,经过大量数据训练后,机器的算法不断自行优化处理方式,就学会如何为其它图片放大缩小。

依waifu2x的算法,动漫风格的画,线条感明显、色彩不太复杂的,用waifu2x来放大降噪效果非常好,线条锐利,色彩鲜明,相当于无损放大后还降噪处理了,实际出来的效果好到让人惊讶。但对复杂的照片,效果就不够理想,但是也能用。

要知道,图片是由一个个像素组成的,直接放大就是将这一个个像素都放大了,惨不忍睹。像Photoshop之类软件、相机(手机)的数码变焦,使用的是插值放大,通过运算在原来的像素之间插入一些新的像素,使色彩过渡得更平滑。而waifu2x能够利用神经网络,针对放大图片的线条、颜色、网点等特点做特殊的算法调整,从而达到比插值放大要好得多的效果。

2、自动描线与自动上色

画漫画、插画,描线和上色是基本功也是基本工作,如果有了自动描线和自动上色的新技术,画师能剩下很多工夫。描线和上色不过关的绘画爱好者,也能借助新科技提升自己作品的水平。

在2016年,日本早稻田大学就开发出了自动描线和自动上色的技术,使用了人工神经网络技术。

用铅笔画的复杂的草稿图,能通过机器利用神经网络算法,自动识别图像并确定图像的具体轮廓完成描线的工作,从而转换成像手工描线画出的线稿。大家来看看展示图,效果相当的惊人:

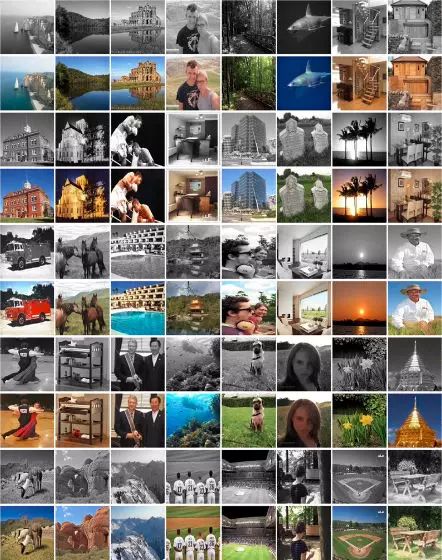

早稻田大学还有一项为黑白照片自动上色的技术,也是先行利用神经网络训练机器获取经验。然后,利用人工智能分析照片的整体特征,提取照片中的重要元素并进行上色。

在2017年的年初,我们看到有这么一个能为图片自动上色的网站火了:https://paintschainer.preferred.tech/。

其技术也是利用神经网络,提供许多上色插图来让AI不断学习、自我完善算法,从而获得为图片自动上色的技能。跟waifu2x类似,对动漫风格的线稿处理得很好,而对黑白照片的处理则可谓一塌糊涂。

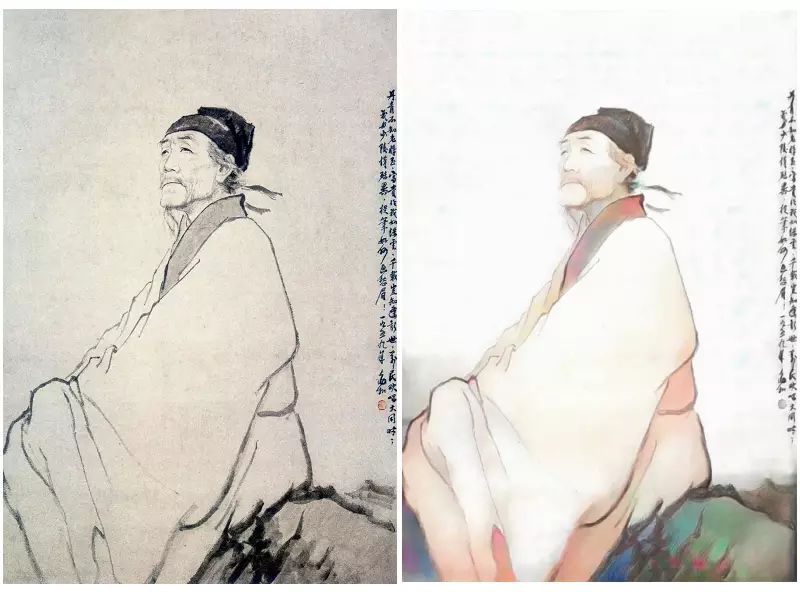

要想效果好,提供的图片需要是线条感明显的线稿(网站上已表明 “line drawing image”)。笔者试着上传杜甫的国画(网友们不知道是否记得“杜甫很忙”这一网友系列恶搞涂鸦事件?),发现上色的效果相当出色。大家来看看原图跟AI处理后的图片的对比图。

使用者如对直接处理的色彩不满意,还可以用网页提供的工具为原图各个区域标注上提示颜色,再让AI处理,效果会更理想。

笔者还试着上传了一些黑白照片,AI的处理结果让人掩面泪崩。看来,要对黑白照片上色,还是得看早稻田大学的那种技术。

3、图片合成

Ostagram是基于谷歌Deepmind算法的图像合成工具:http://www.ostagram.ru。

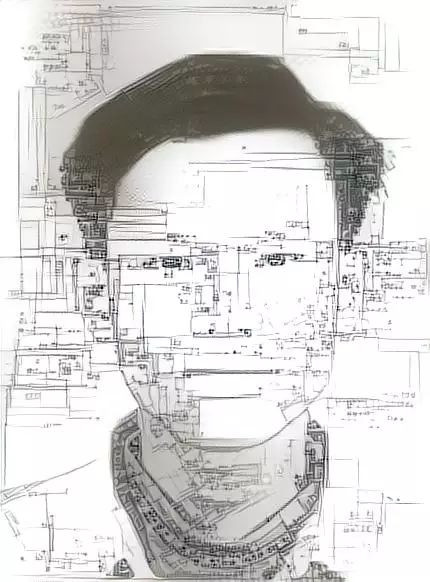

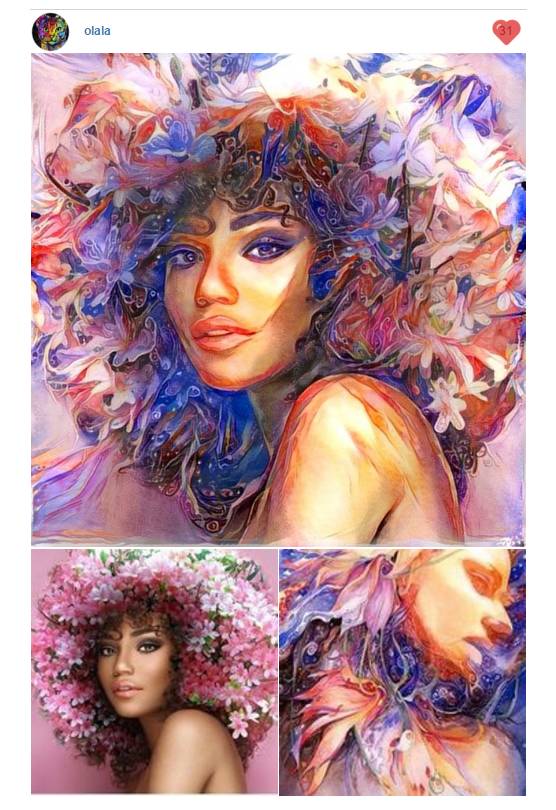

这种技术,也是利用了人工神经网络进行深度学习,能够将两张图片很神奇地合成为一张有着令人大吃一惊的效果的图片。大家来看看效果:

大家也可以到这个网站:https://deepdreamgenerator.com。

这个网站能提供每小时处理10张图片的服务。这图片数量很充裕了,因为AI处理图片需要时间,电脑运算速度快的话如果没有限制每小时能处理不止10张图片,但到了10张的限制时稍微等一下便又能用了。

网站的图片处理有预设的风格。当然,大家肯定是想自己玩一下个性风格。那么,需要先上传一张原图,再上传一张作为风格参考的图片,处理时有一些参数控制,懂的网友可以自己再调整一下。AI会提取第二张图片的风格特征,用于处理第一张图片。

你可以上传一张照片,再上传一张某种风格的画作,于是AI会将照片处理成某种画风的样子。于是,人人都可以成为大画家量产毕加索了!当然,你尽可以异想天开,发挥脑洞,用令人意想不到的图片,合成出似乎不会出现在这个世上的神奇图片来。

最近,美国康奈尔大学与Adobe公司也研发出了一项类似谷歌Deepmind的技术“Deep Photo Style Transfer”,能将一张图片的风格套用到另一张图片上,包括色彩以及光线。

通过深度学习程序,AI能对照片中的色彩与光线性质进行分析,理解并还原照片的天气状况、季节、时间,还能区分天空和大地。在实际应用中也做得更好,不但能从整体上改变图片的风格,还能只针对图片的某一细节部分进行改变,例如一栋大楼的窗户。

预计“Deep Photo Style Transfer”这一项技术未来可能成为Photoshop中的一个插件,能令用户如虎添翼。

用电脑AI来玩文学可谓“历史悠久”了。微软亚洲研究院自然语言计算组研究开发有电脑对联,至于作诗的则是一抓一大把,有的还宣称通过了图灵测试。但是通过了图灵测试又怎么样呢?只是让人无法分辨到底是人类还是人工智能创作的,并不代表好坏。要想实际应用,还得达到一定程度的文学欣赏水准。

谷歌为了使他们的AI更加健谈,让AI阅读了大量的爱情小说,于是AI现在也能写出一些多愁善感的诗歌了。谷歌的工程师为AI设计了每首诗的开头和结尾,然后AI能往中间填充适当的句子从而把这些内容串起来成为完整的诗。但AI只是一遍一遍地重复学习过的语句,它并没有一双在生活中寻找发现的眼睛,无法发挥创意。

我们可以看到这个世界已经有很多写作软件。最近热议的网文抄袭事件也让人见识到了写作软件的“厉害”之处。

正可谓“天下文章一大抄”,现在国内的一些写作软件号称“写作神器”,能够提供许多写作素材,方便作者调用,当然,这些写作素材是从网上搜集来的,版权方面问题很大,作者调用这些素材来写作当然得算抄袭。

因为这类写作软件用起来太方便,不少网络小说作者就是爱用,被发现抄袭并举报的一大批,就有小说被网站封掉的。这类“写作神器”,只是将网文书库里的那些描写随机组合,谈不上什么人工智能。

顺便说一下,我们见到的写作软件,还提供角色姓名、地名、门派、功法、兵器等等随机起名等工具,对小说作者还是很有用的,先随机起一个名字,再修改美化一下,也不怕犯抄袭。

还有,写小说更重要的是编故事。国内暂时还不见有这方面功能突出的写作软件,一般顶多提供故事树模板让作者自行填写。

在国外,有做得更好的写作软件。如Dramatica这个软件,内置了超过3万个故事结构,分门别类,能从一开始引导使用者一步一步地将想法化为及格的故事,如何设计冲突、塑造人物。

Dramatica是一款不错的写作软件,可惜只有英文版,国内的作者不好用。Dramatica在写作的过程起的是引导、提醒、评估等的作用,虽然有作用,可谓不错的智能工具,但也谈不上多高级的人工智能。

然而随着人工智能的发展,它迟早会进入文学创作的核心领域。现在AI能做更厉害的事情了。

日本科研人员开发的AI,写出的小说拿来参加比赛,都能通过初审了。纽约大学的AI研究人员就用AI创作了一部电影剧本,这个剧本随后被拍成了一部名为《Sunspring》的短片,主角的饰演者也是饰演过美剧《硅谷》男主角查理的 Thomas Middleditch,该短片参加了伦敦科幻电影节(Sci-Fi London) 48 小时挑战单元。

跟小说创作相比较,新闻写作更容易让AI上手。现在国内的腾讯、阿里巴巴、今日头条等等纷纷推出了自己的自动化新闻写作AI。

新闻写作跟小说写作不同,不需要“无中生有”创造出一个新故事,只需要挖掘线索,管理素材,容易实现模板式写作。而且,AI要比人类博闻强记,整理线索和素材要比真人强,相较真人写作,是拥有一方面优势的。你说,发些财经消息、体育比赛讯息,需要多高文学水平啊?用AI来编写不更省力省时间?

新闻报道这类属于非虚构文学创作,而小说一般属于虚构文学创作,前者目前的电脑AI有办法应付,而后者目前还存在诸多不足。研究小说创作的AI,要求研究者得懂小说创作。

建议相关研究者先研究一下类似Dramatica这样的软件,弄懂怎样引导AI写出一篇各方面结构完善的小说。也就是先做好小说建模,让AI写出一篇及格的小说。之后,也可以利用人工神经网络,提供海量数据,训练AI写出更好的小说。

我们可以看看前面提到的日本人工智能研究人员是怎么做的。有两种典型的创作方法。

日本公立函馆未来大学教授松原仁率领的团队名为“任性的人工智能之我是作家”,其两部作品是由人类事先设定好登场人物、内容大纲等相当于文章“零部件”的内容,人工智能AI再根据这些内容自动生成小说。

这一种,AI做的主要方面是“描写”,感觉有些类似网络写手设定好故事情节之后,利用国产“写作神器”抄袭别人作品的描写。笔者不免有些担心,AI写作是否会遭遇版权问题?又如谷歌的AI,学了那么多爱情小说的句子,重新排列组合,要到怎么样的随机程度,才能洗脱抄袭的嫌疑?

东京大学副教授鸟海不二夫率领的团队“人狼智能”的两部作品,则在人工智能之间玩“狼人游戏”(一款推理类桌游),然后选出有意思的故事发展,再由人类改编成小说。笔者更欣赏这一种方式,而且这不就是美剧的编剧方式吗?美剧的故事情节总是有许多方向的发展可能,而编剧会根据情况选择其中的一种。

笔者有些脑洞,相关研究者不妨参考一下。比如说,谷歌的图像合成算法Deepmind也可以运用到小说改编上,也就是将两部不同的小说合成一部神奇的小说。例如,将《三国演义》跟《红楼梦》合体,会怎么样?提取《红楼梦》的风格特征,重新演绎《三国演义》,出来的效果会如何?AI的演算结果相信会令世人震惊不已……

这一种方式,也有很大的实用意义。比如某影视公司买下了某军事小说的版权,又买下某言情小说的版权,公司高层想某军事小说改编影视剧时加入爱情元素从而更适应市场的娱乐审美,那么,能否提取某爱情小说的风格特征,重新演绎某军事小说?

这并不是不可能做到的事。先说简单的,让智能机器人为小孩讲故事。这现在就能做到,故事从素材库里随机抽取便可,但要想讲的故事有更多变化不让人腻味,能怎么做呢?

比如说有一个A故事:小熊不会爬树,熊妈妈鼓励它。又有一个B故事,小鸟学唱歌。我们可以训练AI,将A故事和B故事合成一个新的C故事:小鸟不会唱歌,鸟妈妈鼓励它。这是非常简单的变换。

只要我们继续努力去研究,相信能做出更复杂的变换,提取《三国演义》的风格特征重新演绎《红楼梦》并不是梦。Deepmind创造出的神奇图片,表明了“关公战秦琼”也许会非常精彩。让我们一起去梦想吧。

编辑:梁博宇