GTC 2017 现场,英伟达首席执行官黄仁勋站台发表主题演讲表示,五年前针对深度学习神经网络研究的就已经开始取得回报,GPU计算开始呈现爆发态势。与此同时,英伟达的股价再度暴涨17%,当它发布财报时,当天收盘股价已经飙升了14%。

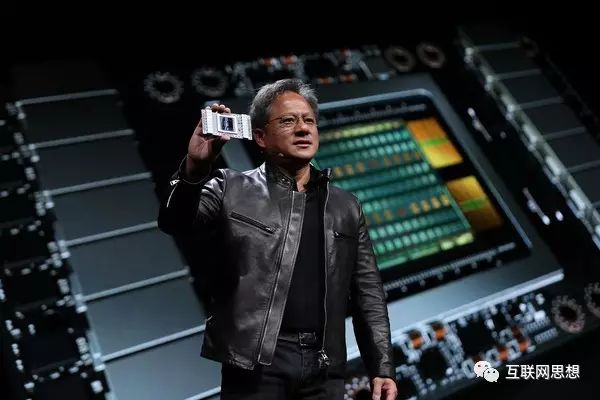

整个演讲的亮点是其宣布英伟达发布了新的Volta架构以及相应架构的V100芯片。

在过去的30年,由于受益于摩尔定律的影响,致使整个芯片行业可以一年又一年地推进微处理架构的更新升级,从而提高运算性能,但摩尔定律逐渐失效之后,开始进入第二个计算时代:机器学习的时代,英伟达迅速转身。

如今,押注AI的英伟达在经历了几年的积淀之后,不仅股价迅速飙升,营收层面也持续增长。根据刚发布的2017年第一季度财报显示,公司营收19.4亿美元,同比增长48%,公司净收入增加到5.07亿美元,比2016年第一季度的2.08亿美元增长了一倍之多。

5月11日,

英伟达举办了本年度GPU开发者大会,该公司首席执行官黄仁勋主题演讲历时两个多小时,其内容涉及到机器学习的方方面面,以及基于英伟达图形处理芯片(GPU)的众多应用程序。而整个演讲的亮点是其宣布英伟达发布了新的Volta架构以及相应架构的V100芯片。

英伟达一直在努力使其图形处理芯片更适用于人工智能应用程序,并在芯片中增加了16位浮点快速计算等功能。但它的新Volta架构将这种专业化功能提升到了一个新的层次,通过采用新的张量核心,极大地加速了神经网络的训练和推理能力。Volta的张量核心专门为神经网络设计,而传统的GPU核心主要用来完成像阴影处理这样的经典图形操作。

而对于神经网络来说,基本的构建模块是矩阵乘法和加法。英伟达的新张量核心可以执行所有的操作,可进行多组双4x 4矩阵运算,同时增加第三个矩阵并行计算。因此,V100上可并行运行5120个核心,而每个核心本身也可并行运行其他操作。英伟达表示,其结果是在推断学习过程中,V100的学习速度是Pascal的12倍,推理速度则是Pascal的6倍。

英伟达V100堪称有史以来最令人印象深刻的芯片之一。在815平方毫米的面积中,布满了210亿个晶体管,

英伟达的首席执行官黄仁勋表示,这是目前半导体领域可以制造的最大、最复杂的芯片。该芯片的研发成本为30亿美元

,而芯片是由台积电的12nm制程工艺制造,使用了三星提供的高速内存。

在主题演讲结束后,英伟达解释说,它之所以使用12nm的大尺寸,是为了制造出最先进的芯片。谷歌近期也针对人工智能打造了定制的TensorFlow芯片,但Volta架构芯片的发布或将有效阻止其竞争发展。

Volta显然是英伟达人工智能战略的一部分,但它并没有就此止步。黄还在大会上宣布了TensorRT,这就是Tensorflow和Caffe编译器,旨在优化gpu运行性能。编译器不仅能提高效率,还大大降低了谷歌定制芯片的缺陷。其使得TensorFlow芯片比Skylake或P100图像识别基准延迟低30%。而在设备负荷方面,Tesla V100 PCIe可以取代十几个传统CPU,而且能耗要低得多。

此外,英伟达还对定制化推理芯片竞争做出了更直接的回应,宣布该公司正在开发DLA(深度学习加速器和代码开源软件。其张量核心配置了高达20MB的寄存器堆,高达16GB的HBM2显存读写速度高达900GB/s,而NVLink输入输出达到300GB/s。其结果是Volta架构完全就是针对人工智能打造的芯片架构。

英伟达后来证实,并非所有Volta架构处理器都有如此高的人工智能加速功能,有些可能更专注于纯粹的图形或通用计算性能。英伟达解释称,它的张量核心是进行训练和推理操作的理想选择,而并不是要创建一个单一产品线。

V100芯片将是超级计算机DGX-1以及HGX-1的核心处理芯片。据悉,经过升级后的DGX-1采用8颗V100芯片,将于第三季度发布,售价约为149,000美元。而采用4颗V100芯片的DGX Station售价为69,000美元,同样计划在第三季度发布。而基于V100的OEM产品预计将在今年年底前开始发货。

英伟达还与微软Azure合作开发出了一款云友好型超级计算机HGX-1,其配置了8颗V100芯片,能够进行灵活配置,以满足各种云计算的需要。微软计划在自己的应用程序上使用Volta架构,并向Azure用户开放。

英伟达预计,除了纯粹的软件应用之外,Volta还将为自动驾驶汽车和机器人提供支持。英伟达预计,基于Volta架构的处理器和电路板将成为人工智能设备进行学习和推理的核心。

这其中包括了各种机器人系统,特别是那些使用英伟达新发布的Isaac机器人模拟工具,以及各种类型的自动驾驶汽车。其中空客公司正在设计一架可以垂直起飞的小型飞机,能够搭载两名乘客至70英里。其也使用了英伟达 新发布的Isaac机器人模拟工具。

(英文来源/entremetech编译/机器小易

网易智能

校对/晗冰)

后摩尔定律时代,NVIDIA发布Volta芯片迎人工智能

文/搜狐科技 陈丁丁

北京时间5月11日凌晨,在美国硅谷举办的NVIDIA GPU Techonology Conference(以下简称GTC)迎来了高潮。NVIDIA创始人兼董事长黄仁勋发表了关于“计算的未来”的演讲,演讲中他提到了运算速度的提升,人工智能的应用,深度学习的开发等,但是此次老黄的Keynote最为亮眼的还是在千呼万唤始出来的Volta芯片。

最近财报连连看涨的NVIDIA在这个Volta架构上的研发投入了超过30亿美元,这个吃入了巨大研发经费的架构显卡也显示出了碾压级的运算能力。这个使用了台积电12纳米FinFET(鳍式场效应晶体管)的Volta显卡有着5120个CUDA,可以进行120兆兆次浮点计算(TeraFlops),远甩开了微软、谷歌等对手。Volta作为NVIDIA第七代显卡架构,拥有超过210亿个晶体管,使用了16GB的HBM2显存,带宽高达900GB/s;同时支持

NV

Link,带宽达300GB/s。

在此次GTC的Keynote演讲上,黄仁勋反复强调的便是科技高度发展,已经迎来了下一个智能时代,NVIDIA将全心发展于人工智能,而这次的Volta芯片将是他们的发力之作。Volta芯片拥有5倍于现有构架Pascal,14倍于上一代构架Maxwell的运算能力,几乎是4倍于摩尔定律所预测的运算能力,黄仁勋自己也表示能开发出Volta架构本身,已经让他觉得不可思议了。

我们列举了Volta所带来了最新的科技成功:

-

Tensor单元:Volta的V100搭载了超过640个Tensor单元,可以做到120兆兆次的浮点计算能力。

-

新的GPU架构:新的GPU架构融合了Tensor单元和CUDA在统一的架构里面,在单个GPU终究可以做到AI运算的要求。

-

新的NVLink:新的NVLink提速了2倍,更好的链接CPU和GPU。

-

900 GB/sec HBM2 DRAMn的显存存:与三星共同研发的新一代显存存,比上一代提升了50%的带宽。

-

与Volta相配套的运算软件:CUDA,Tensor单元与cuDNN相应的软件,帮助Volta更好的处理运算。

最新的Volta Tesla V100芯片将最早搭载于超算DGX-1上,内置八个V100芯片的DGX-1售价将14.9万美元。

(Tesla V100芯片)

同时黄仁勋也就NVIDIA在自动驾驶的成果展示了一番。NVIDIA的两个自动驾驶解决方案Drive PX2 Parker和Drive PX Xavier在L2-L5的自动驾驶领域都与不同的厂商进行了深度的合作,继奥迪,特斯拉,博世等公司后,NVIDIA也宣布了最新的合作伙伴丰田。丰田自动驾驶技术以后将会使用NVIDIA的Xavier平台来进行开发。