大家好,欢迎来到我们的星球知识小卡片专栏,本期给大家分享模型压缩中的一个非常重要的方向,动态模型。

作者&编辑 | 言有三

Dynamic Convolution名为动态卷积,它可以根据输入图像,采用注意力机制自适应地调整卷积参数,不仅显著提升了表达能力,额外的计算成本也很小,类似的早期研究和后续研究非常多,包括Dynamic Filter Networks等。

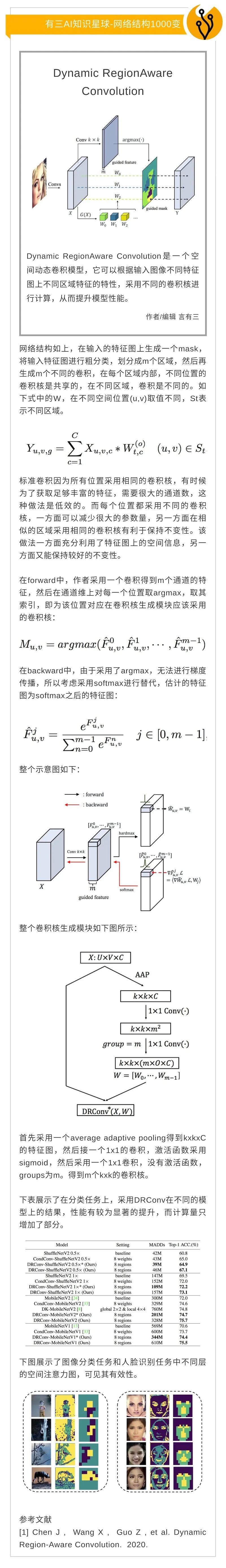

Dynamic RegionAware Convolution是一个空间动态卷积模型,它可以根据输入图像不同特征图上不同区域特征的特性,采用不同的卷积核进行计算,从而提升模型性能,类似的方法还有involution。

随着网络的加深,特征的表达能力越来越强,但是大部分简单的图片可以在较浅层时学习到足以识别的特征,BranchyNet基于此,以非常简洁的形式实现了不同难度的样本在测试时运行不同网络的思想,类似的还有基于模块删除的BlockDrop,SkipNet等。

在深度学习模型中,许多的非Tensor网络层,如BN层,参数量虽然很少,但是计算量非常大,耗时比较长,因此许多推理框架会将其与卷积层进行合并,类似的还有多分支合并策略,如RepVGG。

总的来说,动态模型有一些重要的研究方向,包括:

(1) 注意力机制的应用。

(2) 动态卷积的改进。

(3) 退出机制的设计。

(4) 模块删除机制的设计。

(5) 动态训练的策略。

(6) 其他等等。

以上内容,如果你不想自己学习,可以去我们知识星球的网络结构1000变板块—动态模型阅读。