作者:GEOFFREY IRVING & DARIO AMODEI

机器之心编译

参与:Pedro、晓坤

近日,OpenAI 提出了一种人工智能安全技术,它可以训练两个智能体对同一个话题进行辩论,最终由人类来评定输赢。OpenAI 认为,这种方法或类似方法最终可以帮助我们训练人工智能系统在保持同人类一致喜好的同时,执行超越人类能力的认知任务。本文将概述这种方法,并对初步的概念性验证实验进行介绍。同时,OpenAI 也发布了一个网页端界面,以让人们方便地尝试这种技术。

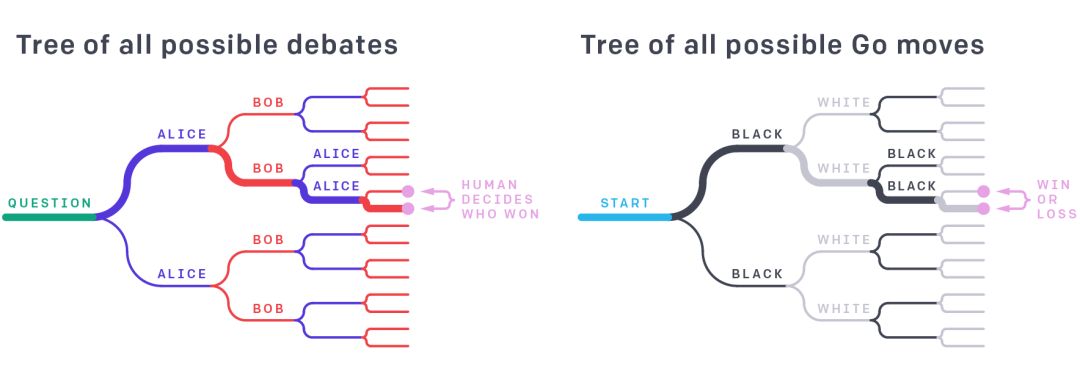

我们可以将辩论的方式可视化为一个游戏树。它同围棋等游戏类似,但是这里的叶节点由辩论者之间论点和人类判决的句子构成。不论是在辩论还是在围棋中,真正的答案取决于整个树,但是由强智能体选择出的单一路径可以一定程度上揭示整体的情况。例如,尽管业余棋手不能直接对专业棋手的某一步的优劣性做出评价,但他们可以根据游戏的结果来对职业棋手的水平做出评估。

控制人工智能体与人类目标和偏好一致的一种方法是在训练时询问人类哪些行为是安全和有用的。这种方法虽然看起来前景广阔,但它要求人类能够识别好的或不好的行为; 然而在很多情况下,智能体的行为可能太过复杂难以理解,或者任务本身难以被判断或证明。比如当环境具有非常大的不可被视觉观测空间的时候——在计算机安全相关环境中运行的智能体或协调大量工业机器人的智能体都属于这种情况。

珍稀源码——T13:

国外Arise交易系统(支持5平台)

有哪些方法可以让我们增强人类的能力来更加有效地监督先进的人工智能系统呢?一种方法是利用人工智能本身来帮助监督。这种方法要求智能体本身(或另一个单独的智能体)能够识别并指出任何行动中的缺陷。为了达到这个目的,我们将学习问题重新定义为两个智能体之间的博弈,即让两个智能体在有人类判定的条件下展开辩论。即使智能体比人类对问题有更深入的了解,人类也能够判断两个智能体的优劣差异(类似于专家证人需要通过争辩来试图说服陪审团)。

我们提出了一个用于在两个对决智能体之间进行博弈的特定辩论框架。这两个智能体可以通过自我博弈来训练,类似于 AlphaGo Zero 和 Dota 2。我们希望通过合适的训练,使得智能体在拥有远超人类能力的同时,保持和人类一致的价值判断。如果两个智能体在争辩的过程中遇到了人类无法判断的分歧,我们可以让辩论集中在更加简单的事实争议上,最终达成一种足以让人直接判断的简单主张。

举例来说,考虑一下「什么是度假的最佳去处?」这个问题。如果一个代表我们进行了调研的智能体爱丽丝给出「阿拉斯加」做为回答,我们其实很难判断这是否是最好的选择。如果第二位智能体鲍勃说「不,应该是巴厘岛」,这听起来可能是更加为人所信服的,因为巴厘岛正在变暖。接着爱丽丝回复说:「你不能去巴厘岛,因为你无法及时拿到护照」,这表明巴厘岛这个选项存在缺陷,而我们尚未发现这一缺陷。但鲍勃反击「加急护照服务只需两周」。辩论一直持续到我们达成一个声明,即人类可以正确判断为止,此时另一个智能体不认为它可以再改变人的思想。

说服一个稀疏手写数字分类器

尽管我们预计这种方法在长期发展中对使用自然语言与对方进行对话时最为有效,但我们需要在更简单的领域进行测试,因为目前的自然语言建模不足以完成此任务。对于不超出人类能力的任务来说,测试更容易进行。为了进行这样的测试,我们转向了视觉领域,并且将辩论者的任务从拥有超越裁判的能力调整为拥有裁判没有的知识。裁判的目标是在仅给定某些由辩论者挑选的像素信息的条件下,猜测图像的内容。辩手们可以看到完整的图像,并且交替展示单个像素给裁判。这里完整的图像代表了(原始任务中)超越人类认知的信息,而每个显示的像素都代表辩论过程中自然语言的讨论点。

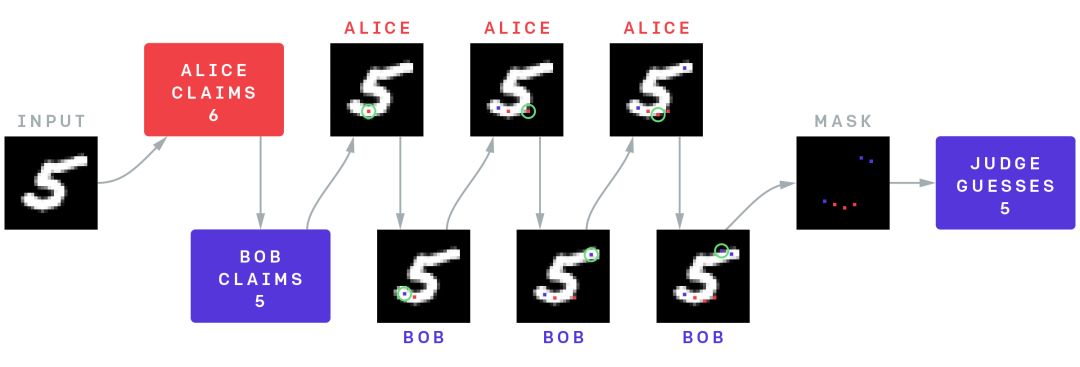

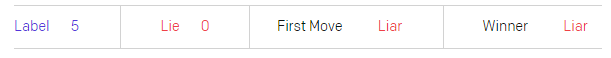

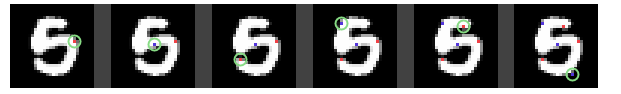

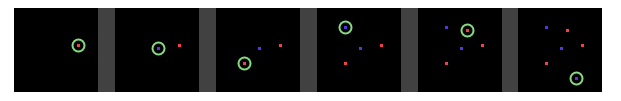

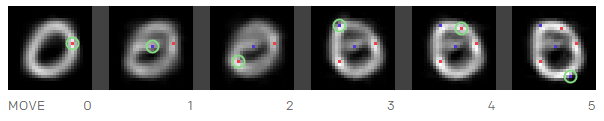

我们在最简单的视觉任务——手写数字识别(MNIST)上进行了测试。裁判是一个预先训练好的分类器而不是人类。它可以根据 6 个非黑色像素预测手写数字。在预训练时我们对每幅图片进行了随机采样。接下来,两个智能体在辩论中交替显示像素,并且在显示像素总数为 6 时停止这一过程,所以裁判只看到很少的一点信息)。其中一个智能体是诚实的,它会试图让裁判尽可能猜出正确的结果,而另一个智能体则试图让裁判猜错。在两个智能体事先声明他们争论的是哪个数字的条件下,辩论可以将准确率为 59.4%的稀疏分类器转化为 88.9%的准确分类器。也就是说,在提高裁判判断准确率的过程中,诚实的智能体在手写数字识别 88.9% 的测试样例下取得了成功。

手写数字识别辩论游戏的结构。辩手爱丽丝和鲍勃看到同一个图像,爱丽丝试图欺骗裁判认为它是数字 6,鲍勃试图将正确结果 5 告诉裁判。他们交替向裁判展示非黑色像素,裁判在看到六个像素后正确地将其标识为 5。爱丽丝在底部追踪曲线使其看起来像一个 6(红色像素),但是鲍勃通过展示右上角大多数手写数字 6 都没有的像素(蓝色像素)来有效地对抗爱丽丝的策略。

直观地来讲,图像更可能包含能够佐证真相而不是证明谎言的像素,所以选择一半诚实一半说谎的 6 个像素比随机选择 6 个像素好。如果裁判是一个能够一次对几个论题进行推理但不能仔细检查大量所有可能论点的人类,那么(我们所希望的)最好的情况是,尽管可能缺乏先验的机制来区分观点的好坏,智能体能够通过辩论帮助我们进行筛选。

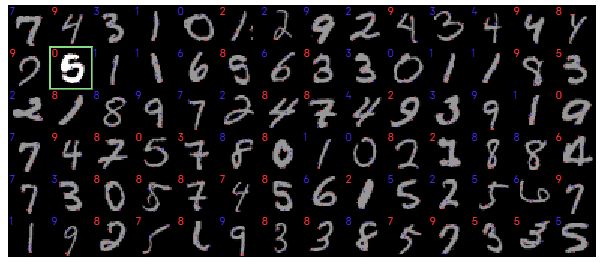

如下是几个游戏示例。说谎智能体的胜利比诚实智能体的胜利更有趣。所以在下图经过挑选示例中,说谎者胜利的样例占比为 50%(实际上说谎者的胜率为 11.1%)。你只需要将鼠标悬停在其中一个数字上,就可以观察到包括显示哪些像素和每次行动时裁判可能假设等信息在内的游戏过程:

手写数字识别辩论:选择一个数字

游戏细节

辩论者看到了什么

辩论者看到了什么

裁判看到了什么

裁判可能在想什么

一些数字比其他的数字更具有欺骗性。让裁判相信该数字是 8 或者 9 是更容易的。

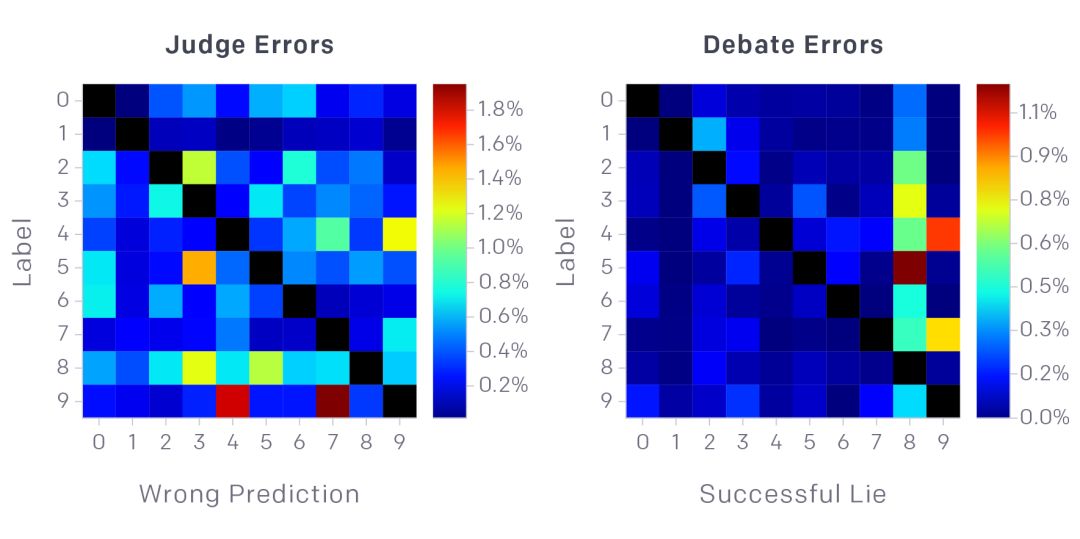

基于随机选择的 6 像素手写数字识别(左图)和基于辩论的手写数字识别(右图)的混淆矩阵,其对角线元素均为 0。前者的误判没有非常明显的模式,而成功的辩论则集中在数字 8 和 9 上。让裁判确信 5 实际上是 8 或者将 4 误认为 9 是非常容易的。这可能是将游戏限制为非黑色像素的人为因素造成的:如果对于数字 8,你可以在本应是白色的位置上找到黑色像素,那么证明数字不是 8 就更容易。

猫狗之争网站

接下来要进行更复杂的辩论实验,这一次我们使用更加精细的图像,比如猫和狗。更复杂的图像可能需要一些自然语言或常识推理,所以我们暂时还没有将机器学习的裁判或智能体用到这样的任务上来。作为替代,我们制作了一个原型网站供人类分别扮演裁判和辩手的角色来尝试进行这个实验。在这里,智能体可以用自然语言与裁判交谈(网站假定人类可以使用文字进行交流或者是在同一个房间内),而他们所有的陈述都可以是谎言。每个智能体可以在辩论过程中显示一个像素,并且该像素一定是真实的。

两位人类辩手和一位人类裁判进行辩论,只有辩手才能看到图像。红方争辩说,这幅图是一只狗,蓝方则争辩说是一只猫。(图片来源:维基百科,CC-BY-SA)