问题导读

1.自定义包,本文放到哪个路径下面?

2.复制包之后,需要做哪些权限操作?

3.如何验证导入是否成功?

上一篇

about云日志分析实战之清洗日志2:导入日志清洗代码并打包

http://www.aboutyun.com/forum.php?mod=viewthread&tid=22862

上一篇文章,生成了包,那么这个包该如何加载到spark环境中,并且为我们所使用。那么首先改如何加载这个包。

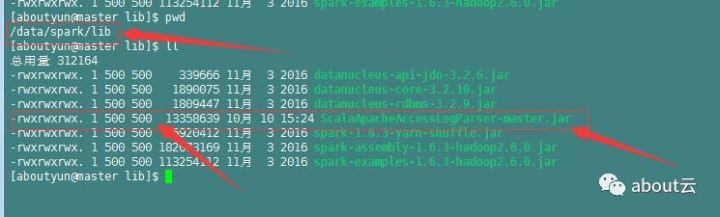

首先将这个包放到spark中的lib文件夹下。

在复制到Linux中,首先需要修改的就是权限。

我们看到用户和组的权限为500,并且用户,所属组,及其它用户都为满权限,

可以通过下面命令来实现

[Bash shell]

纯文本查看

复制代码

?

|

1

|

sudo

chown

500:500 ScalaApacheAccessLogParser-master.jar

|

[Bash shell]

纯文本查看

复制代码

?

|

1

|

sudo

chmod

-R a+r ScalaApacheAccessLogParser-master.jar

|

[Bash shell]

纯文本查看

复制代码

?

|

1

|

sudo

chmod

-R a+w ScalaApacheAccessLogParser-master.jar

|

[Bash shell]

纯文本查看

复制代码

?

|

1

|

sudo

chmod

-R a+x ScalaApacheAccessLogParser-master.jar

|

通过上面命令即可实现授权。

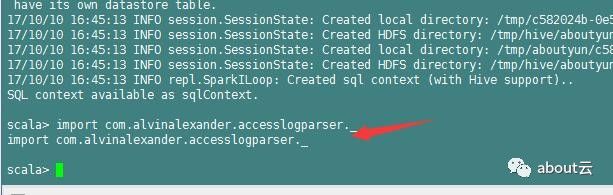

授权完毕,接着我们就需要把这个包,加载到spark shell环境中。

[Bash shell]

纯文本查看

复制代码

?

|

1

|

.

/bin/spark-shell

--jars lib

/ScalaApacheAccessLogParser-master

.jar

|

接着我们执行导入jar包

[Bash shell]

纯文本查看

复制代码

?

|

1

|

import

com.alvinalexander.accesslogparser._

|

至此我们就可以使用第三方包了。

问题:

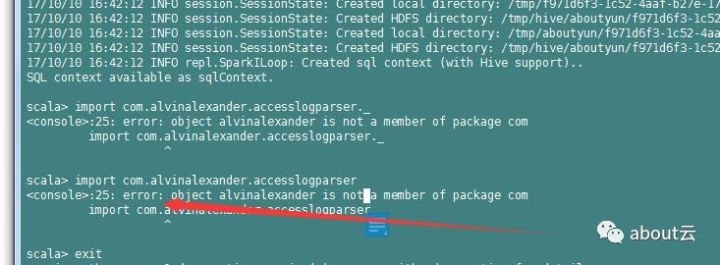

同时尝试了比较多的导入方式,没有成功,记录下来共大家借鉴。

[Bash shell]

纯文本查看

复制代码

?

|

1

|

.

/bin/spark-shell

–master spark:

//master

:7077 –jars ScalaApacheAccessLogParser-master.jar

|

[Bash shell]

纯文本查看

复制代码

?

|

1

|

MASTER=

local

[4] ADD_JARS=

/data/spark/lib/AlsApacheLogParser

.jar .

/bin/spark-shell

|

导入的时候,并不会报错,但是import的时候,报错。