这样对应的看一下,是不是就懂了?可能有人会问了,为什么不是find_all('div',

id = 'content', class_ =

'showtxt')?这样其实也是可以的,属性是作为查询时候的约束条件,添加一个class_='showtxt'条件,我们就已经能够准确匹配到我们想要的标签了,所以我们就不必再添加id这个属性了。运行代码查看我们匹配的结果:

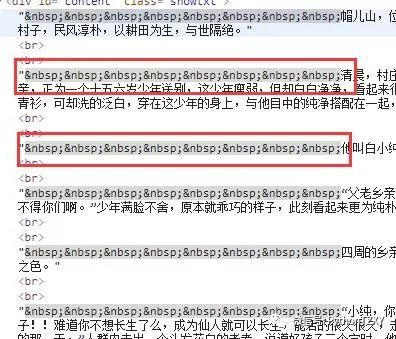

我们可以看到,我们已经顺利匹配到我们关心的正文内容,但是还有一些我们不想要的东西。比如div标签名,br标签,以及各种空格。怎么去除这些东西呢?我们继续编写代码:

# -*- coding:UTF-8 -*-

from bs4 import BeautifulSoup

import requests

if __name__ == "__main__":

target = 'http://www.biqukan.com/1_1094/5403177.html'

req = requests.get(url = target) html = req.text

bf = BeautifulSoup(html)

texts = bf.find_all('div', class_ = 'showtxt')

print(texts[0].text.replace('\xa0'*8,'

'))

find_all匹配的返回的结果是一个列表。提取匹配结果后,使用text属性,提取文本内容,滤除br标签。随后使用replace方法,剔除空格,替换为回车进行分段。 在html中是用来表示空格的。replace('\xa0'*8,'

')就是去掉下图的八个空格符号,并用回车代替:

程序运行结果如下:

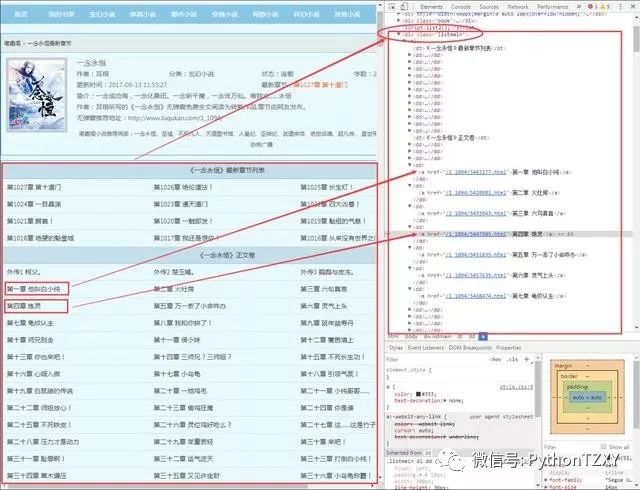

可以看到,我们很自然的匹配到了所有正文内容,并进行了分段。我们已经顺利获得了一个章节的内容,要想下载正本小说,我们就要获取每个章节的链接。我们先分析下小说目录:

URL:http://www.biqukan.com/1_1094/

通过审查元素,我们发现可以发现,这些章节都存放在了class属性为listmain的div标签下,选取部分html代码如下:

在分析之前,让我们先介绍一个概念:父节点、子节点、孙节点。

和

限定了

标签的开始和结束的位置,他们是成对出现的,有开始位置,就有结束位置。我们可以看到,在

标签包含

标签,那这个

标签就是

标签的子节点,

标签又包含

-

标签和

-

标签,那么

-

标签和

-

标签就是

标签的孙节点。有点绕?那你记住这句话:

谁包含谁,谁就是谁儿子!

他们之间的关系都是相对的

。比如对于

-

标签,它的子节点是

标签,它的父节点是

标签。这跟我们人是一样的,上有老下有小。

看到这里可能有人会问,这有好多

-

标签和

标签啊!不同的

-

标签,它们是什么关系啊?显然,兄弟姐妹喽!我们称它们为兄弟结点。

好了,概念明确清楚,接下来,让我们分析一下问题。我们看到每个章节的名字存放在了

标签里面。

标签还有一个href属性。这里就不得不提一下

标签的定义了,

标签定义了一个超链接,用于从一张页面链接到另一张页面。

标签最重要的属性是 href

属性,它指示链接的目标。

我们将之前获得的第一章节的URL和

标签对比看一下:

http://www.biqukan.com/1_1094/5403177.html

第一章 他叫白小纯

不难发现,

标签中href属性存放的属性值/1_1094/5403177.html是章节URLhttp://www.biqukan.com/1_1094/5403177.html的后半部分。其他章节也是如此!那这样,我们就可以根据

标签的href属性值获得每个章节的链接和名称了。

总结一下:小说每章的链接放在了class属性为listmain的

标签下的

标签中。链接具体位置放在html->body->div->dl->dd->a的href属性中。先匹配class属性为listmain的

标签,再匹配

标签。编写代码如下:

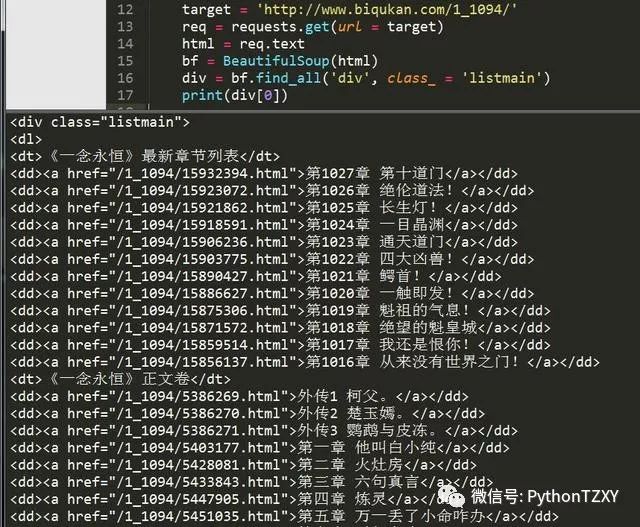

from bs4 import BeautifulSoup

import requests

if __name__ == "__main__":

target = 'http://www.biqukan.com/1_1094/'

req = requests.get(url = target)

html = req.text

div_bf = BeautifulSoup(html)

div = div_bf.find_all('div', class_ = 'listmain')

print(div[0])

还是使用find_all方法,运行结果如下:

很顺利,接下来再匹配每一个

标签,并提取章节名和章节文章。如果我们使用Beautiful Soup匹配到了下面这个

标签,如何提取它的href属性和

标签里存放的章节名呢?

第一章 他叫白小纯

方法很简单,对Beautiful Soup返回的匹配结果a,使用a.get('href')方法就能获取href的属性值,使用a.string就能获取章节名,编写代码如下:

# -*- coding:UTF-8 -*-

from bs4 import BeautifulSoup

import requests

if __name__ == "__main__":

server = 'http://www.biqukan.com/'

target = 'http://www.biqukan.com/1_1094/'

req = requests.get(url = target) html = req.text

div_bf = BeautifulSoup(html)

div = div_bf.find_all('div', class_ = 'listmain')

a_bf = BeautifulSoup(str(div[0]))

a = a_bf.find_all('a')

for each in a:

print(each.string, server + each.get('href'))

因为find_all返回的是一个列表,里边存放了很多的

标签,所以使用for循环遍历每个

标签并打印出来,运行结果如下。

最上面匹配的一千多章的内容是最新更新的12章节的链接。这12章内容会和下面的重复,所以我们要滤除,除此之外,还有那3个外传,我们也不想要。这些都简单地剔除就好。

整合代码

每个章节的链接、章节名、章节内容都有了。接下来就是整合代码,将获得内容写入文本文件存储就好了。编写代码如下:

# -*- coding:UTF-8 -*-

from bs4 import BeautifulSoup

import requests, sys

"""

类说明:下载《笔趣看》网小说《一念永恒》

Parameters:

无

Returns:

无

Modify:

2017-09-13

"""

class downloader(object):

def __init__(self):

self.server = 'http://www.biqukan.com/'

self.target = 'http://www.biqukan.com/1_1094/'

self.names = [] #存放章节名

self.urls = [] #存放章节链接

self.nums = 0 #章节数

"""

函数说明:获取下载链接

Parameters:

无

Returns:

无

Modify:

2017-09-13

"""

def get_download_url(self):

req = requests.get(url = self.target)

html = req.text

div_bf = BeautifulSoup(html)

div = div_bf.find_all('div', class_ = 'listmain')

a_bf = BeautifulSoup(str(div[0]))

a = a_bf.find_all('a')

self.nums = len(a[15:]) #剔除不必要的章节,并统计章节数

for each in a[15:]:

self.names.append(each.string)

self.urls.append(self.server + each.get('href'))

"""

函数说明:获取章节内容

Parameters:

target - 下载连接(string)

Returns:

texts - 章节内容(string)

Modify:

2017-09-13

"""

def get_contents(self, target):

req = requests.get(url = target)

html = req.text

bf = BeautifulSoup(html)

texts = bf.find_all('div', class_ = 'showtxt')

texts = texts[0].text.replace('\xa0'*8,'

')

return texts

"""

函数说明:将爬取的文章内容写入文件

Parameters:

name - 章节名称(string)

path - 当前路径下,小说保存名称(string)

text - 章节内容(string)

Returns:

无

Modify:

2017-09-13

"""

def writer(self, name, path, text):

write_flag = True

with open(path, 'a', encoding='utf-8') as f:

f.write(name + '

')

f.writelines(text)

f.write('

')

if __name__ == "__main__":

dl = downloader()

dl.get_download_url()

print('《一年永恒》开始下载:')

for i in range(dl.nums):

dl.writer(dl.names[i], '一念永恒.txt', dl.get_contents(dl.urls[i]))

sys.stdout.write(" 已下载:%.3f%%" % float(i/dl.nums*100) + '

')

sys.stdout.flush()

print('《一年永恒》下载完成')

很简单的程序,单进程跑,没有开进程池。下载速度略慢,喝杯茶休息休息吧。代码运行效果如下图所示:

长按二维码向我转账

受苹果公司新规定影响,微信 iOS 版的赞赏功能被关闭,可通过二维码转账支持公众号。

![]()

微信扫一扫

关注该公众号